这个端到端项目简化了大型语言模型 (LLM) 应用程序的生命周期,包括开发、生产和部署。该存储库包含作为项目组件的文件夹和文件,例如代理、API、链、聊天机器人、GROQ(查询语言)、Hugging Face 模型、ObjectBox(嵌入式数据库)、OpenAI 模型和检索增强生成(RAG) ))。该项目旨在提供与法学硕士合作的全面解决方案,涵盖数据处理、聊天机器人开发以及与各种工具和框架的集成。

该项目演示了通过 Langchain 和 Ollama 使用付费和开源大规模语言模型 (LLM) 创建聊天机器人。它涵盖了LLM应用程序的整个生命周期,包括开发、生产和部署。

是的。所有 API 都是秘密的,具有受限的用户访问权限和匿名 .gitignore,以及通过 Github 秘密环境提供的另一层安全性(抱歉!您必须使用自己的!)

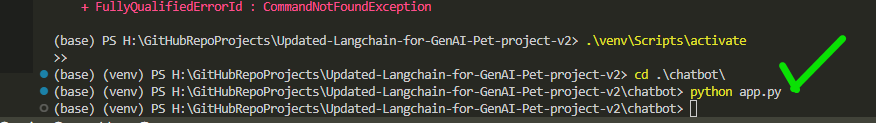

conda create -p venv python==3.10 -y

venv S cripts a ctivate

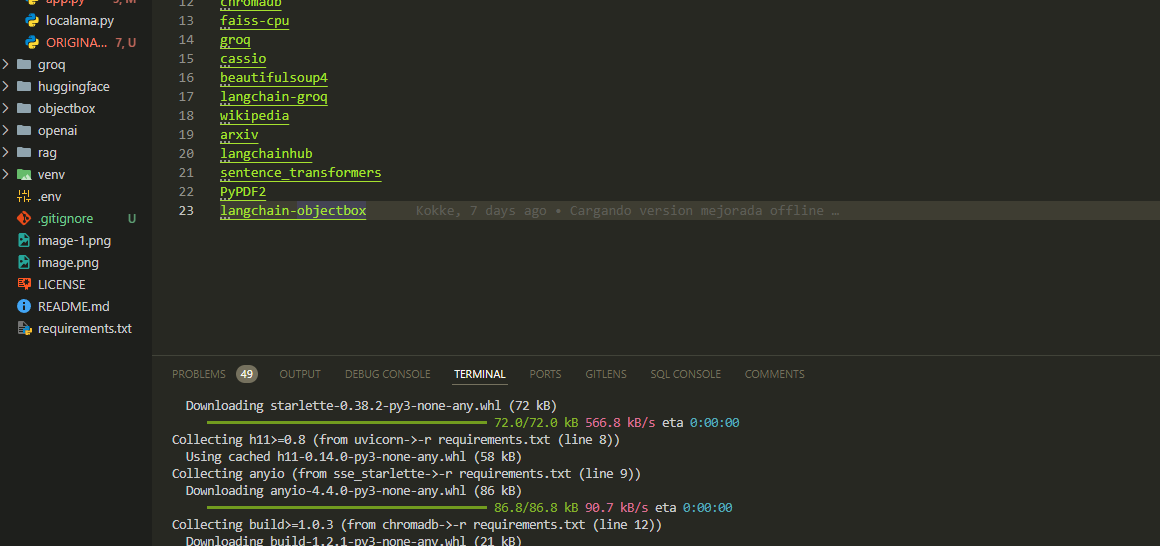

pip install -r requirements.txt在app.py文件中配置必要的 API 密钥和设置。

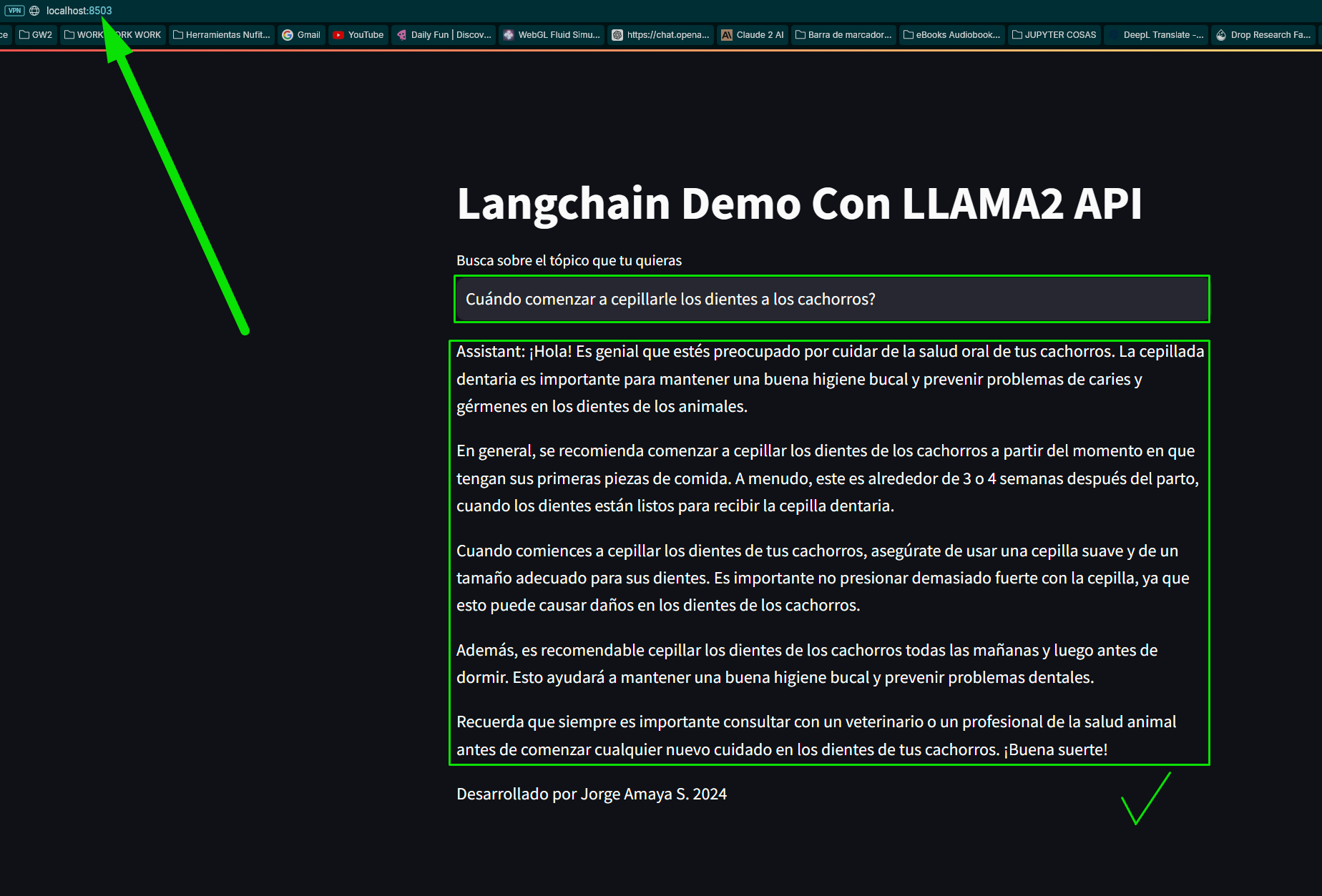

python app.py打开网络浏览器并导航到(或计算机上分配的渐进端口)。我的是:

http://localhost:8502我们通过调用基础聊天机器人的 3 个主要链式函数来创建文件。

我们加载模块和库的需求:

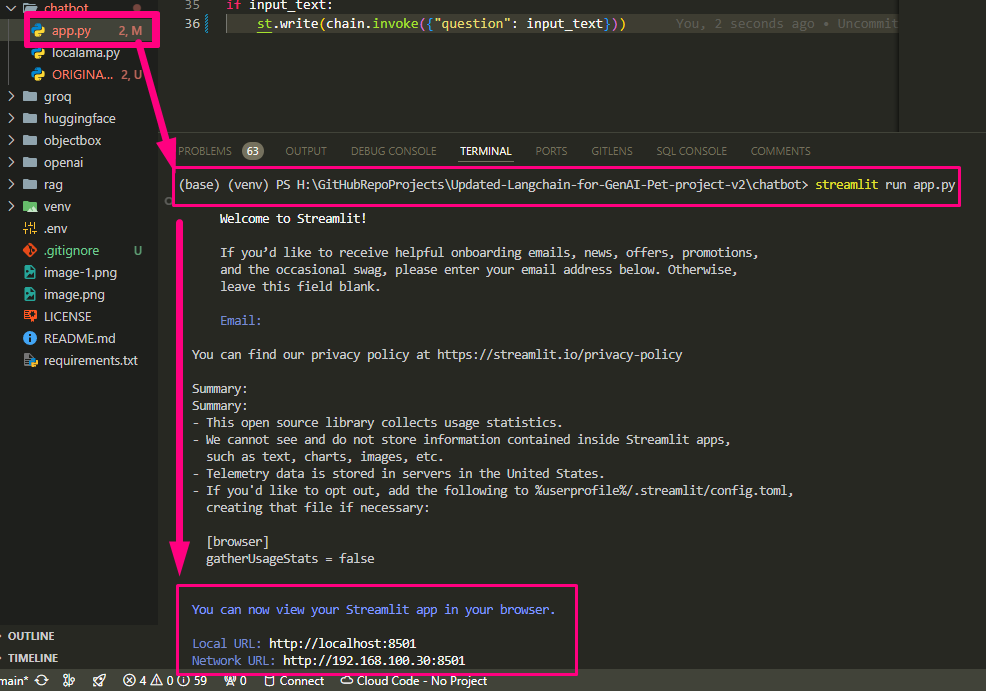

我们运行我们的app.py

我们完成app.py配置并运行

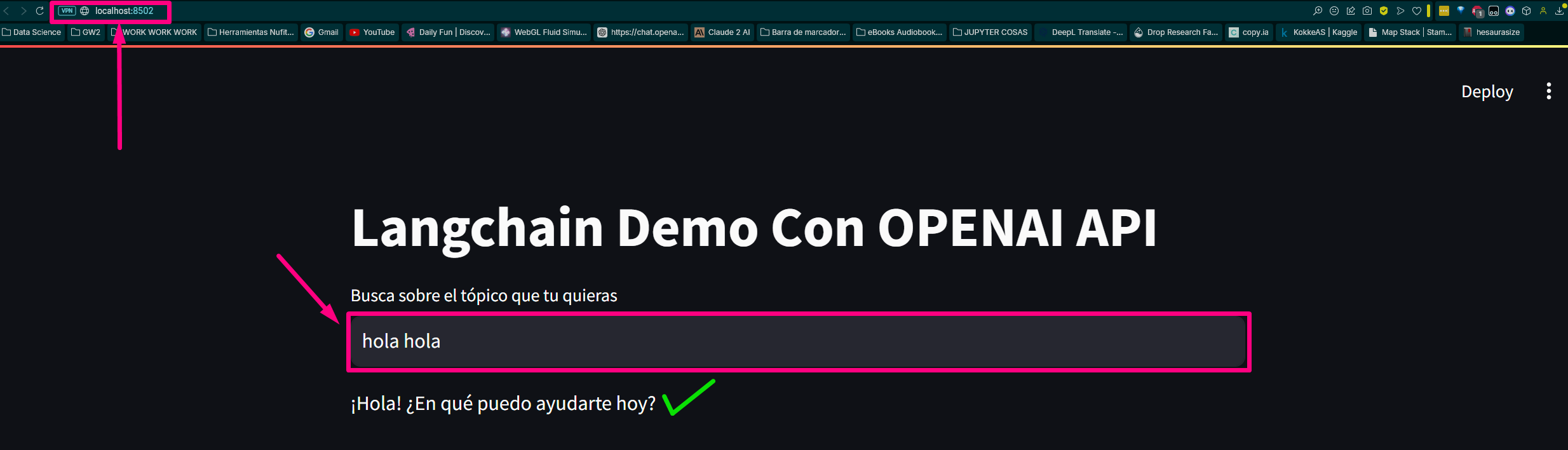

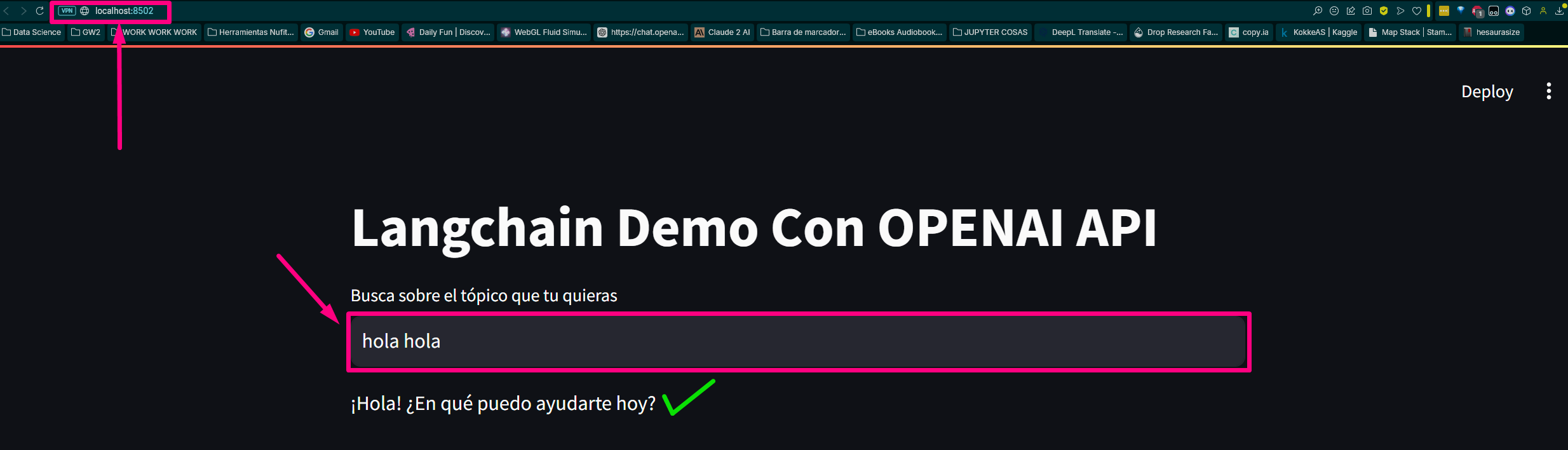

它返回路由并在测试浏览器中打开主机

Local URL: http://localhost:8502

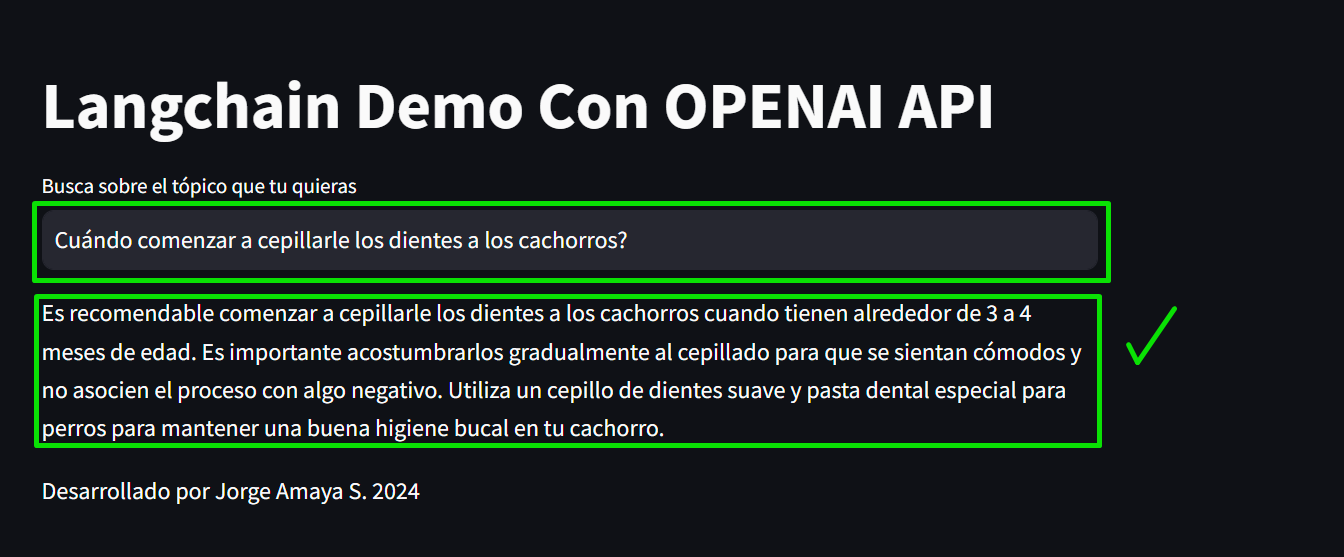

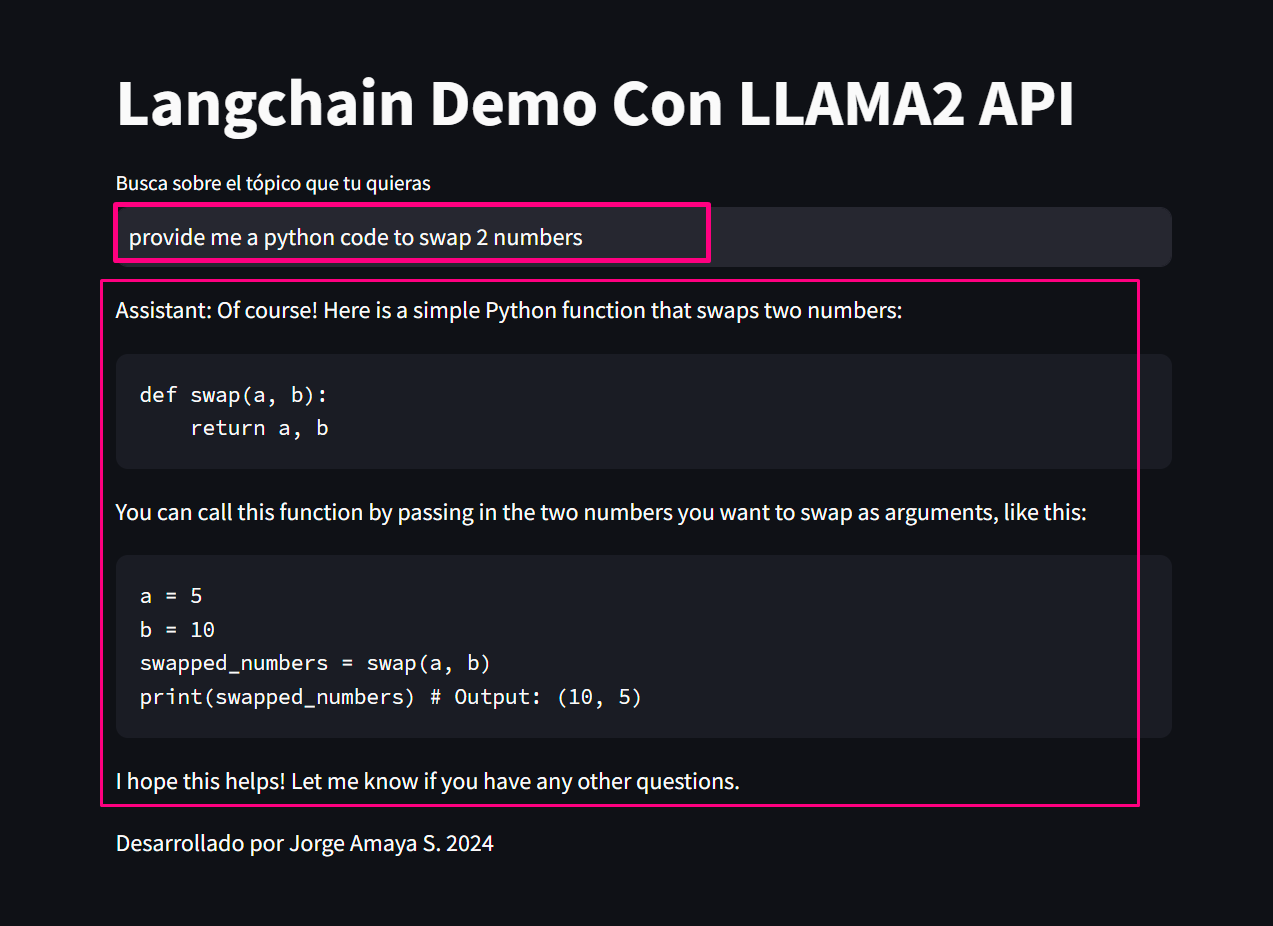

Network URL: http://192.168.100.30:8502我们来检查一下页面:

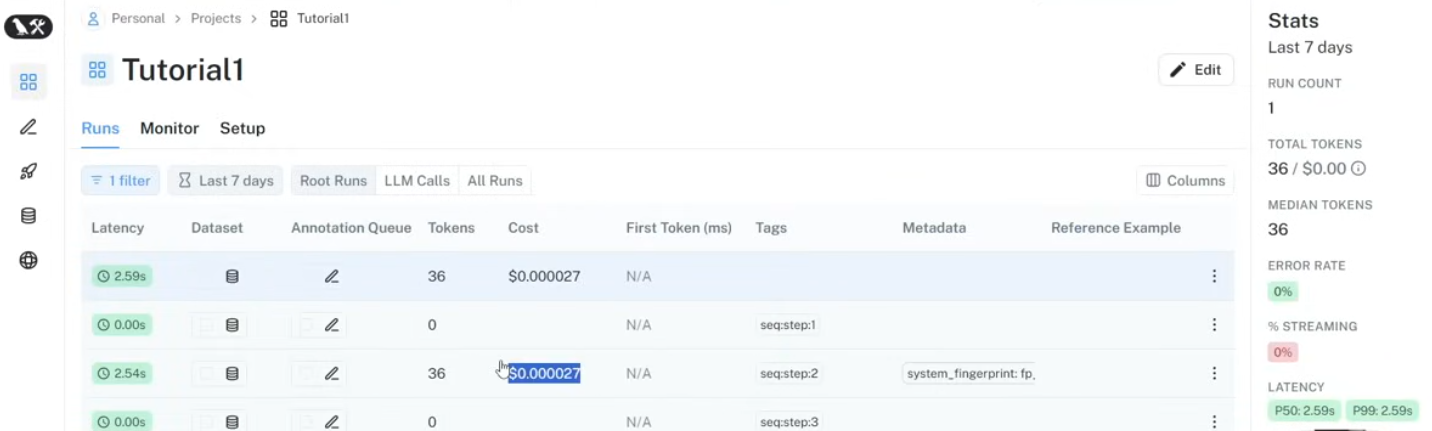

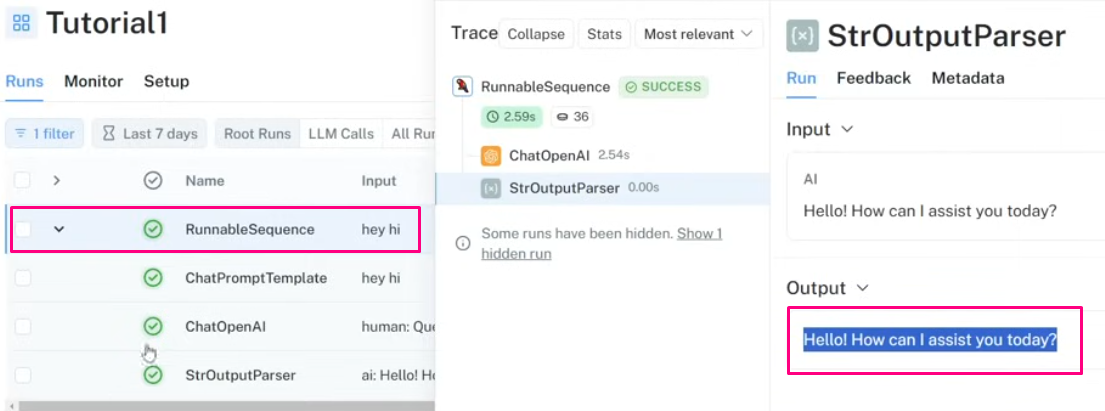

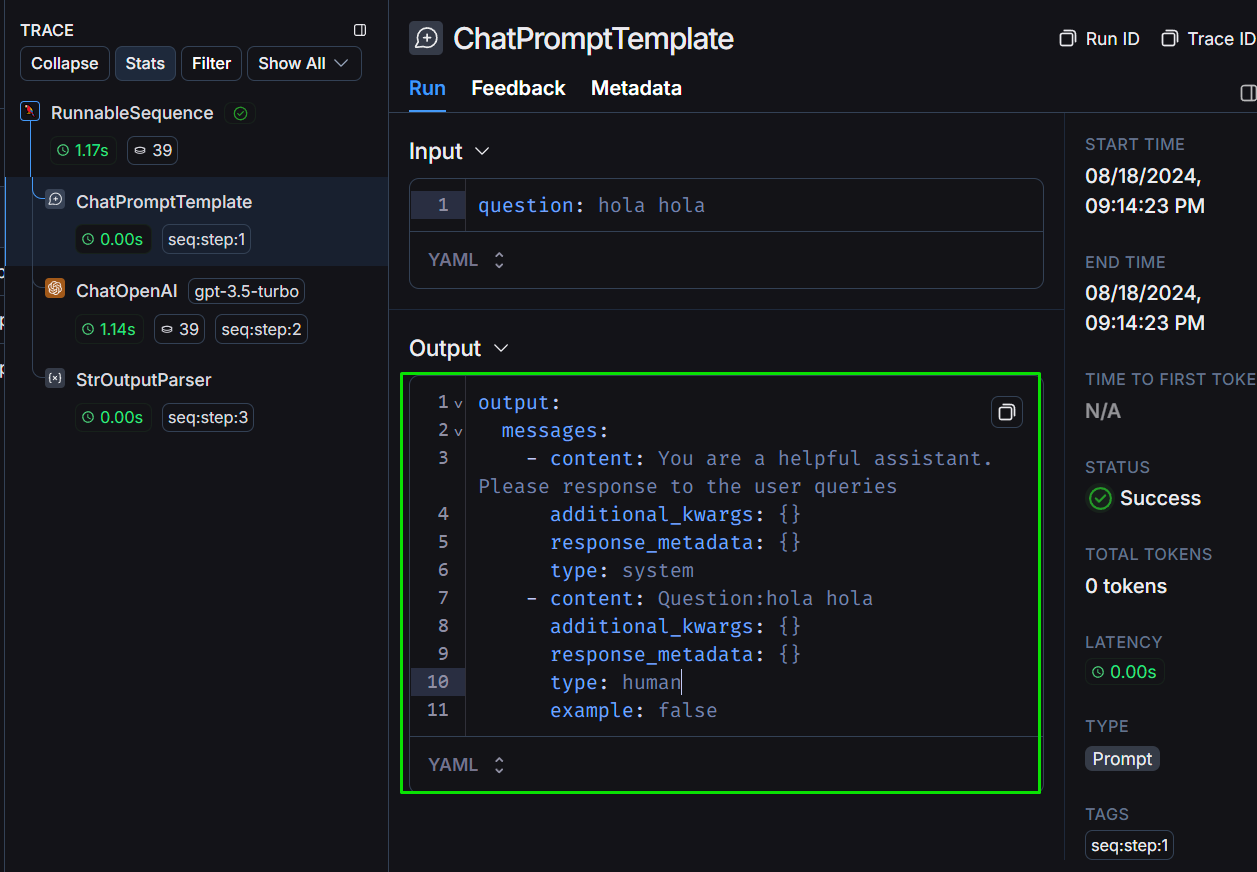

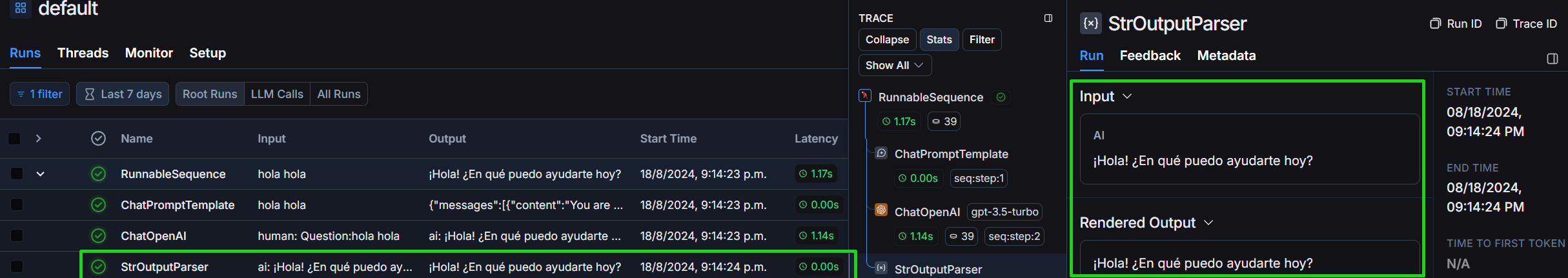

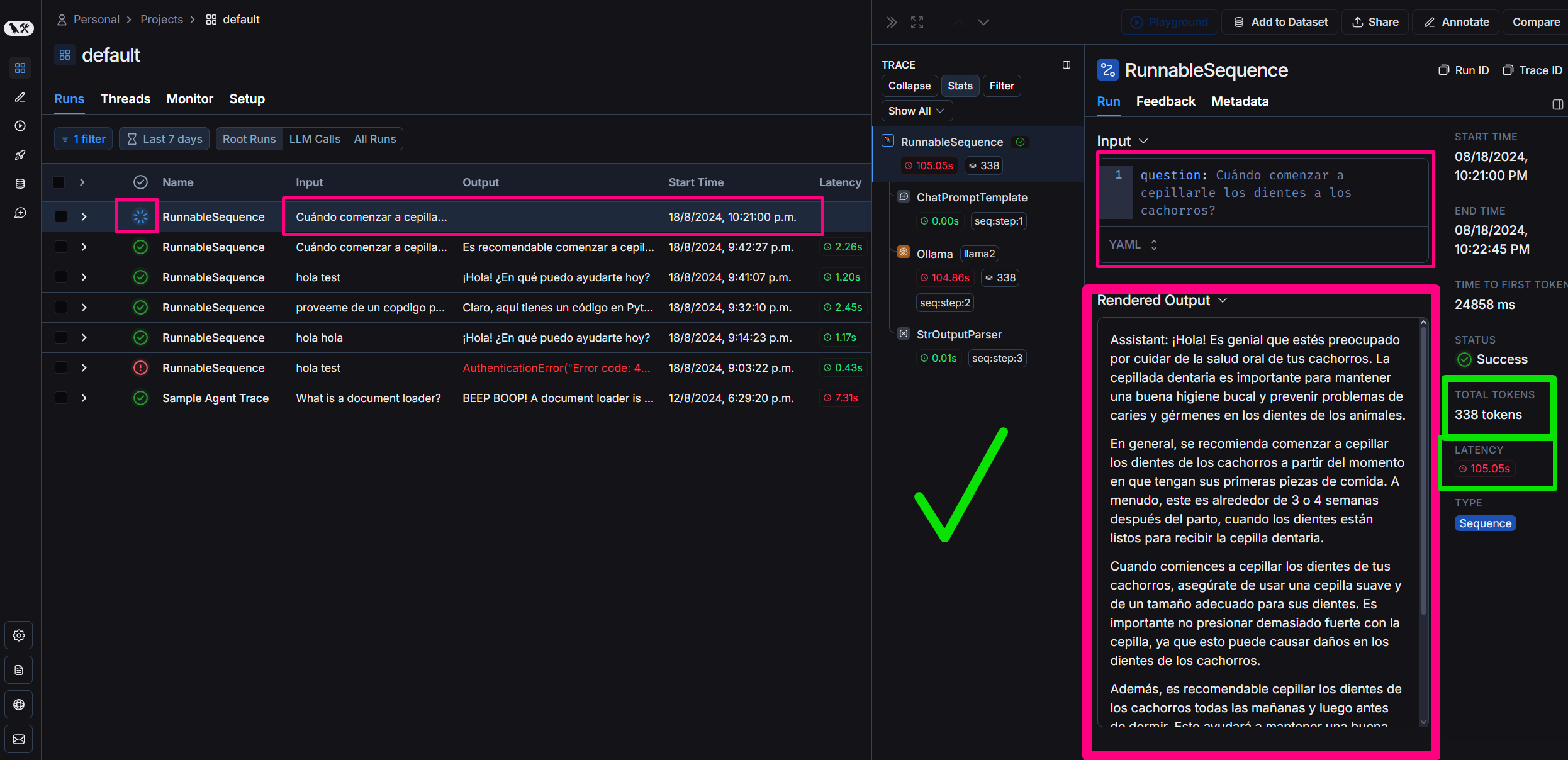

我们回顾一下Langchain框架中的项目:

让我们看看我们定义的输出结构:

我们详细看一下StrOutputParser:

我们将询问您“提供交换两个值的Python代码”来评估成本、标记化和延迟时间来解决问题:

*proveeme de un código python que swapee 2 valores.* :

# Definir los dos valores a intercambiar

a = 5

b = 10

print ( "Valores originales:" )

print ( "a =" , a )

print ( "b =" , b )

# Intercambiar los valores

temp = a

a = b

b = temp

print ( " n Valores intercambiados:" )

print ( "a =" , a )

print ( "b =" , b )最后我们生成一个公共查询:

“问题”:“什么时候开始给小狗刷牙?”

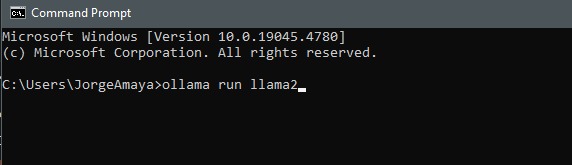

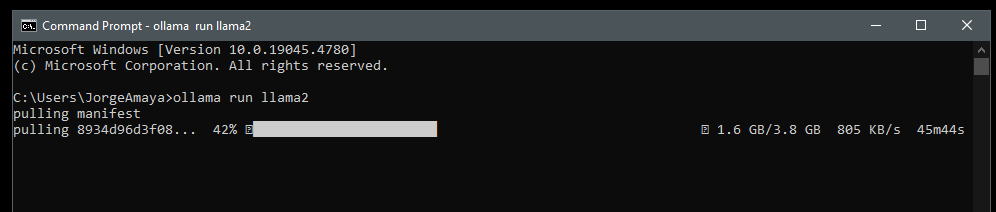

我们将通过将 Llama2 下载到我们的计算机上来从我的本地环境中运行它来专门加载 Llamama

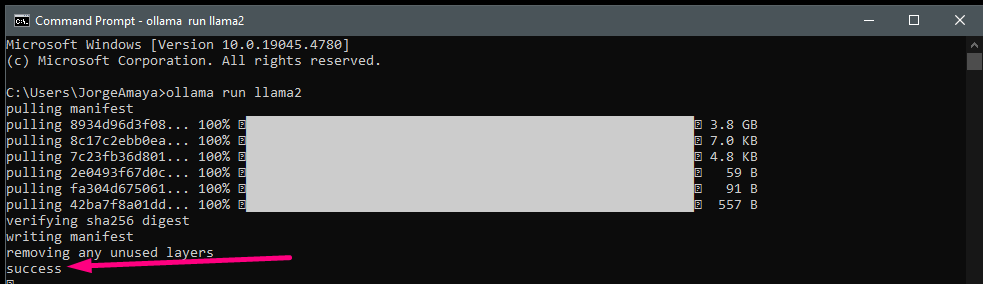

我打开一个cmd

ollama run llama2我们下载llama2

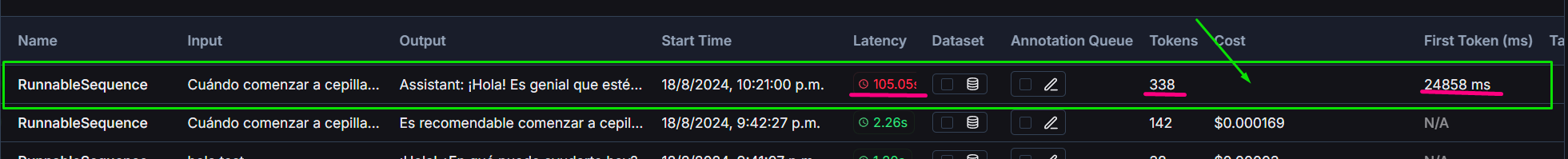

Llama2与gpt3.5 turbo生成的响应水平、连贯性和一致性

该项目包括 OpenAI 的 GPT-3.5-turbo 和本地运行的 Llama2 模型之间的比较:

我们使用Langchain上的Langsmith来监控:

始终欢迎为改进聊天机器人或扩展其功能做出贡献。请提交拉取请求或未解决的问题以进行任何改进。

####你想学吗?给我发一条DM!

该项目是开源的,可根据 MIT 许可证使用。