Study-Bot是由Tecnológico de Monterrey的Edumakers开发的开源项目。它旨在帮助视障学生复习他们的学术课程材料。它是一款由人工智能驱动的学习伴侣,融合了各种技术,包括 Whisper、GPT-3.5-turbo-16k、Elevenlabs 文本转语音和 OpenCV。出于测试目的,示例课程材料是使用 ChatGPT 生成的。

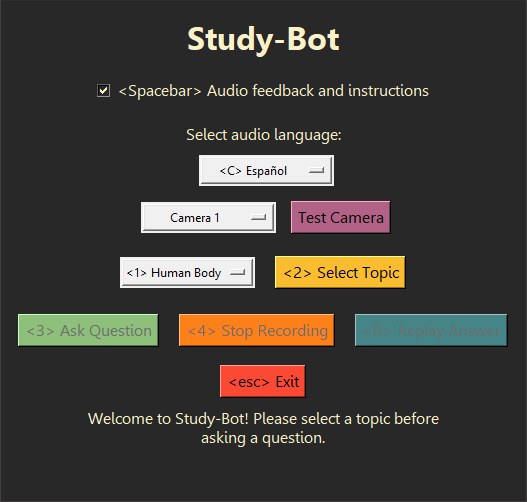

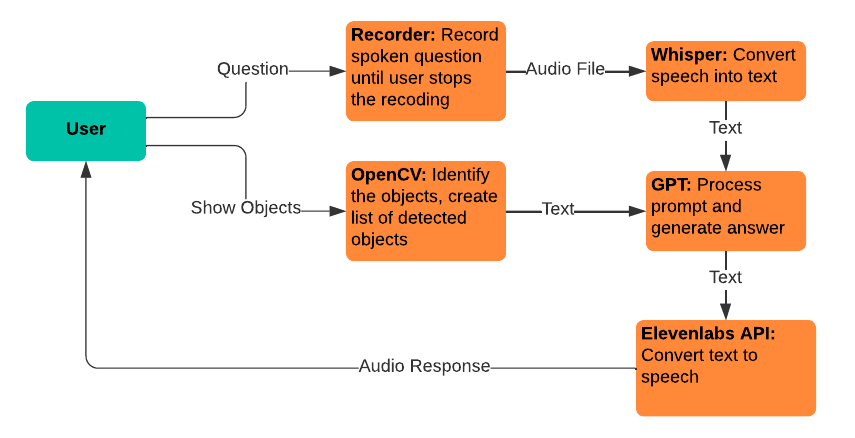

Study-Bot可以:聆听用户的问题,分析他们想要学习的主题的来源材料,通过颜色或 ArUco 标记检测他们持有的体育材料,生成答案,并将其大声朗读给用户用户作为可访问的可执行应用程序。出于开发和测试目的,它可以通过Python解释器作为CLI程序或使用GUI运行。

接下来的一些好的步骤可能是将这个系统嵌入到更高级的用户界面中,以作为桌面应用程序分发,创建一个计算机视觉模型,可以在不依赖颜色或 ArUco 标记的情况下检测体育材料,以及一些性能改进和新的互动功能。

建议使用Python 3.9.9,这样whisper库就可以正常使用。为了避免删除当前的Python安装,您可能需要使用虚拟环境来使用此特定版本的Python 。要安装所需的依赖项,请运行以下命令:

pip install -r requirements.txt在运行该项目之前还需要采取一些额外的步骤,例如为此处使用的 AI 服务获取您自己的 API 密钥。有关更多信息,请参阅Documentation文件夹以获取有关如何使用此项目的综合指南。

Study-Bot依赖于以下现有服务和技术:

Whisper:用于语音到文本的转换,允许用户说出他们的问题以输入 GPT 模型。

gpt-3.5-turbo-16k:用于问题处理和答案生成。选择该模型的 16k 版本是因为其具有 16,385 个令牌上下文窗口大小,这是处理大量源材料所需的。

Elevenlabs 文本转语音:用于文本到语音的转换,让用户能够听到 GPT 模型生成的答案。

OpenCV:用于物理对象识别,以帮助 GPT-3.5-16k 模型回答问题,并添加用户所持物品的上下文。

使用这个项目作为您自己的参考,或者分叉它来做出您自己的贡献。欢迎提出有关功能请求和错误报告的 GitHub 问题,如果其中包含视障用户的反馈,则特别有价值。