零设置即可在计算机上本地与生成语言模型聊天。 LocalChat 是一个简单、易于设置的开源本地 AI 聊天,构建于 llama.cpp 之上。它不需要技术知识,使用户能够在自己的机器上体验类似 ChatGPT 的行为——完全符合 GDPR,并且不用担心意外泄露信息。在此处下载适用于 macOS、Windows 或 Linux 的 LocalChat。

目录

概述 |理由|系统要求 |快速入门 |文档

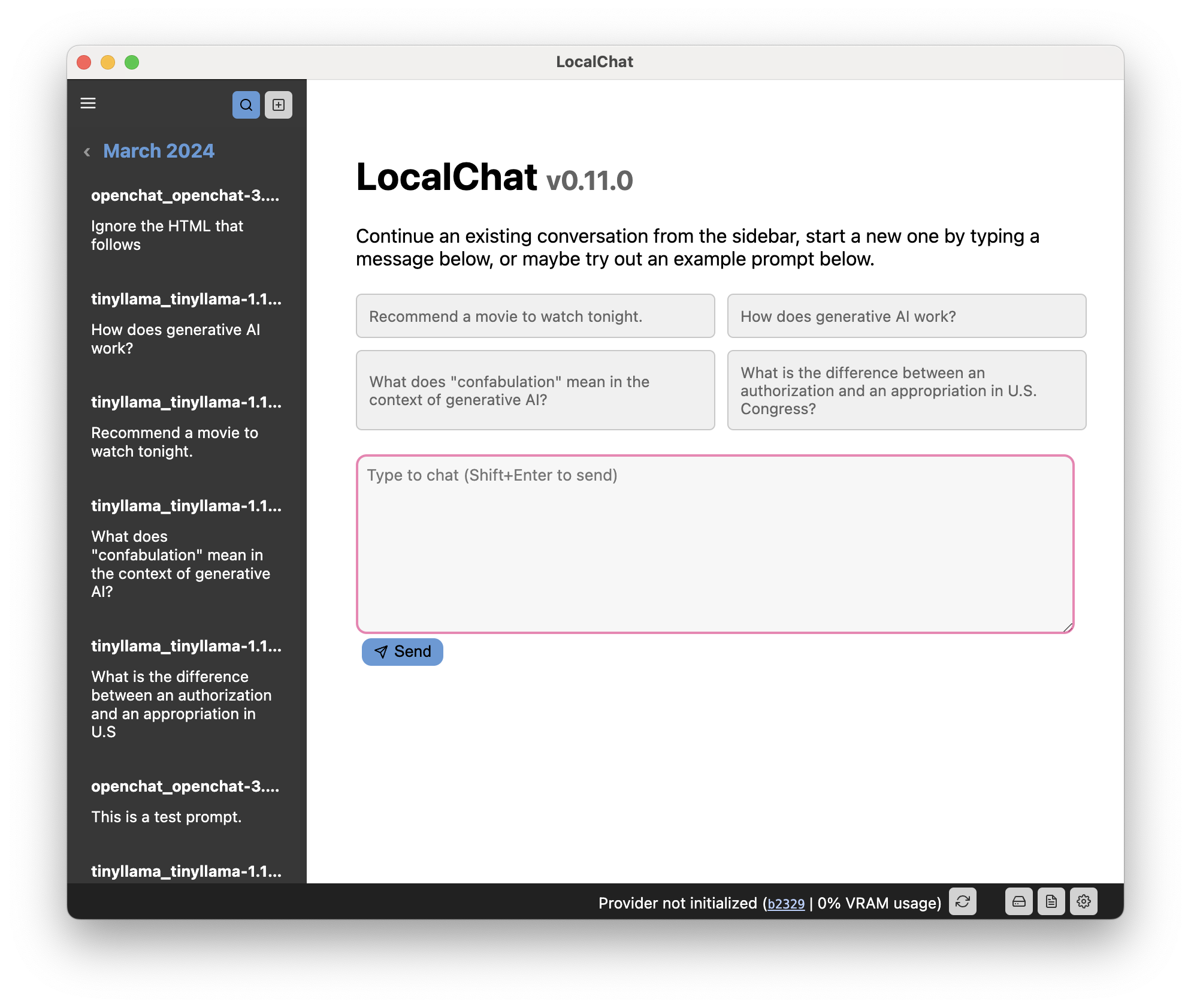

LocalChat 提供了一个类似聊天的界面,用于与生成大型语言模型 (LLM)进行交互。它看起来和感觉就像任何聊天对话,但发生在您的计算机本地。任何数据都不会传输到某些云服务器。

已经有几种功能极其强大的生成语言模型,其外观和感觉几乎与 ChatGPT 相似。主要区别在于这些模型在本地运行并且是开放重量的。

重要的

您可能已经知道,与法学硕士聊天可能感觉非常自然,但模型仍然是概率性的:它们将根据提示中的其他内容生成下一个可能的单词。法学硕士没有时间感、因果关系、上下文以及语言学家所说的语用学。因此,他们倾向于编造从未发生过的事件,混淆完全不同事件的事实,或者直接说谎(称为“幻觉”)。这同样适用于这些模型可以输出的代码或计算。话虽这么说:

请谨慎使用,并自行承担使用此模型的风险。请记住,它只是一个玩具,而不是可靠的东西。

当 ChatGPT 于 2022 年 11 月推出时,我非常兴奋,但同时也很谨慎。虽然 GPT-3 的功能给我留下了深刻的印象,但我痛苦地意识到该模型是专有的,而且即使不是专有的,也不可能在本地运行。作为一名注重隐私的欧洲公民,我不喜欢依赖一家价值数十亿美元的公司,因为该公司可以随时切断访问权限。

因此,我无法真正使用 GPT,并决定等待不可避免的事情:开发更小、更好的工具。到目前为止,有几个模型可以满足所有条件:它们在本地运行,感觉就像 ChatGPT。通过量化(基本上会降低分辨率并造成一些质量损失),它们甚至可以在较旧的硬件上运行。

然而,如果你没有任何法学硕士的经验,就很难经营它们。

这个应用程序存在的原因是(a)我想自己实现这个,看看它如何符合人体工程学地工作,(b)我想提供一个非常简单的层来与这些东西交互,而不必担心设置 PyTorch 和本地变压器。

您只需安装应用程序,下载模型,然后就可以了。

该应用程序需要一台较新的计算机才能运行。然而,这个应用程序依赖于法学硕士,而法学硕士是出了名的耗电。因此,您的计算机硬件将决定您可以运行哪些模型。

“常规”尺寸的型号可能需要具有 6 到 18 GB 视频内存的专用显卡,除非您愿意为每个字等待超过一秒。

如今,许多模型都采用量化形式,这使得较大的模型也可用于较旧或功能较弱的硬件。量化有时会大大降低甚至太大模型的系统要求,而不会造成太多质量损失(但您的里程可能因模型而异)。

重要的

作为一个大型语言模型,生成响应需要一些时间。因此,特别是如果您的计算机中没有专用 GPU,请耐心等待,或者尝试较小的型号。

提示

您可以在应用程序的网站上找到完整的文档。

用户界面分为三个主要组件:

该代码通过 GNU GPL 3.0 获得许可。请阅读许可证文件中的更多信息。