nextjs fastapi your chat

1.0.0

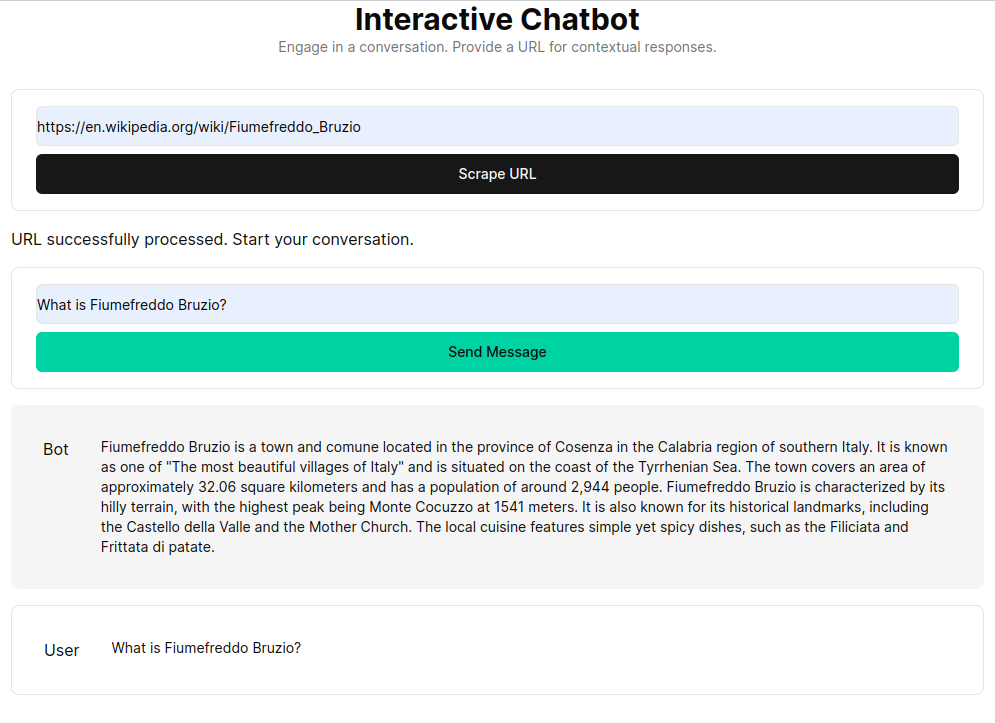

该应用程序利用 Next.js 作为前端,FastAPI 作为后端,利用 LangChain 的功能进行动态 Web 交互,从而促进聊天机器人的发展。

该应用程序将 Python/FastAPI 服务器集成到/api/路径下的 Next.js 应用程序中。这是通过重写next.config.js来实现的,将任何/api/:path*请求定向到位于/api文件夹中的 FastAPI 服务器。在本地,FastAPI 在127.0.0.1:8000上运行,而在生产中,它在 Vercel 上作为无服务器功能运行。

npm install.env文件: OPENAI_API_KEY=[your-openai-api-key]

npm run dev对于仅后端测试:

conda create --name nextjs-fastapi-your-chat python=3.10

conda activate nextjs-fastapi-your-chat

pip install -r requirements.txt

uvicorn api.index:app --reload保留聊天历史记录的选项包括:

RAG(检索增强生成)通过从自定义知识库检索上下文来增强语言模型。该过程包括获取 HTML 文档,将它们分割成块,并使用 OpenAI 等嵌入模型对这些块进行矢量化。这种矢量化数据形成矢量存储,从而实现基于用户查询的语义搜索。然后,检索到的相关块将用作语言模型的上下文,形成对用户查询的全面响应。

get_vectorstore_from_url函数从给定 URL 中提取并处理文本,而get_context_retriever_chain形成一个链,用于检索与整个对话历史记录相关的上下文。这种管道方法可确保响应具有上下文意识且准确。