gpinterface

1.0.0

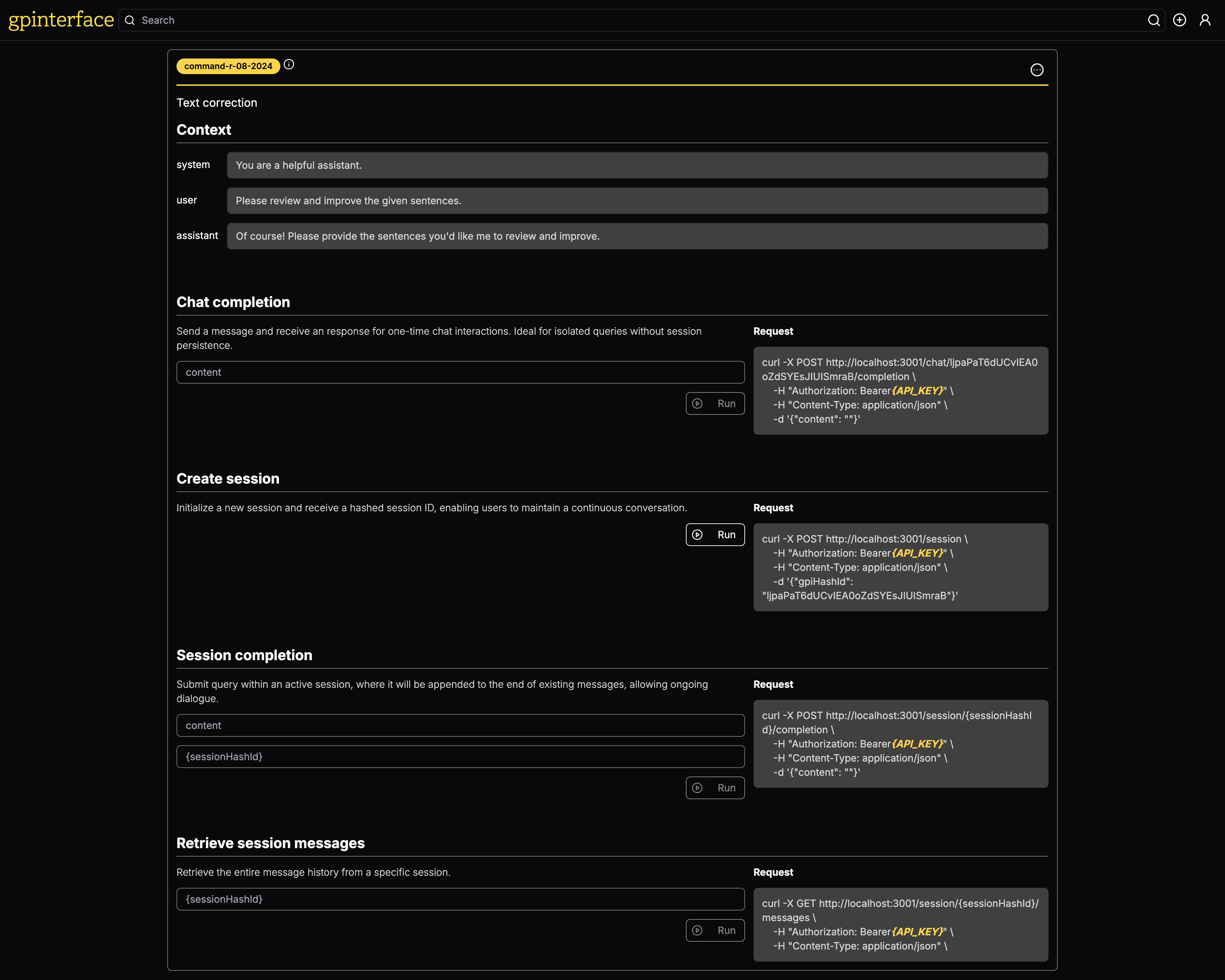

使用gpinterface ,您可以轻松地为提示创建API。

可以在gpinterface.com上获得实时演示。

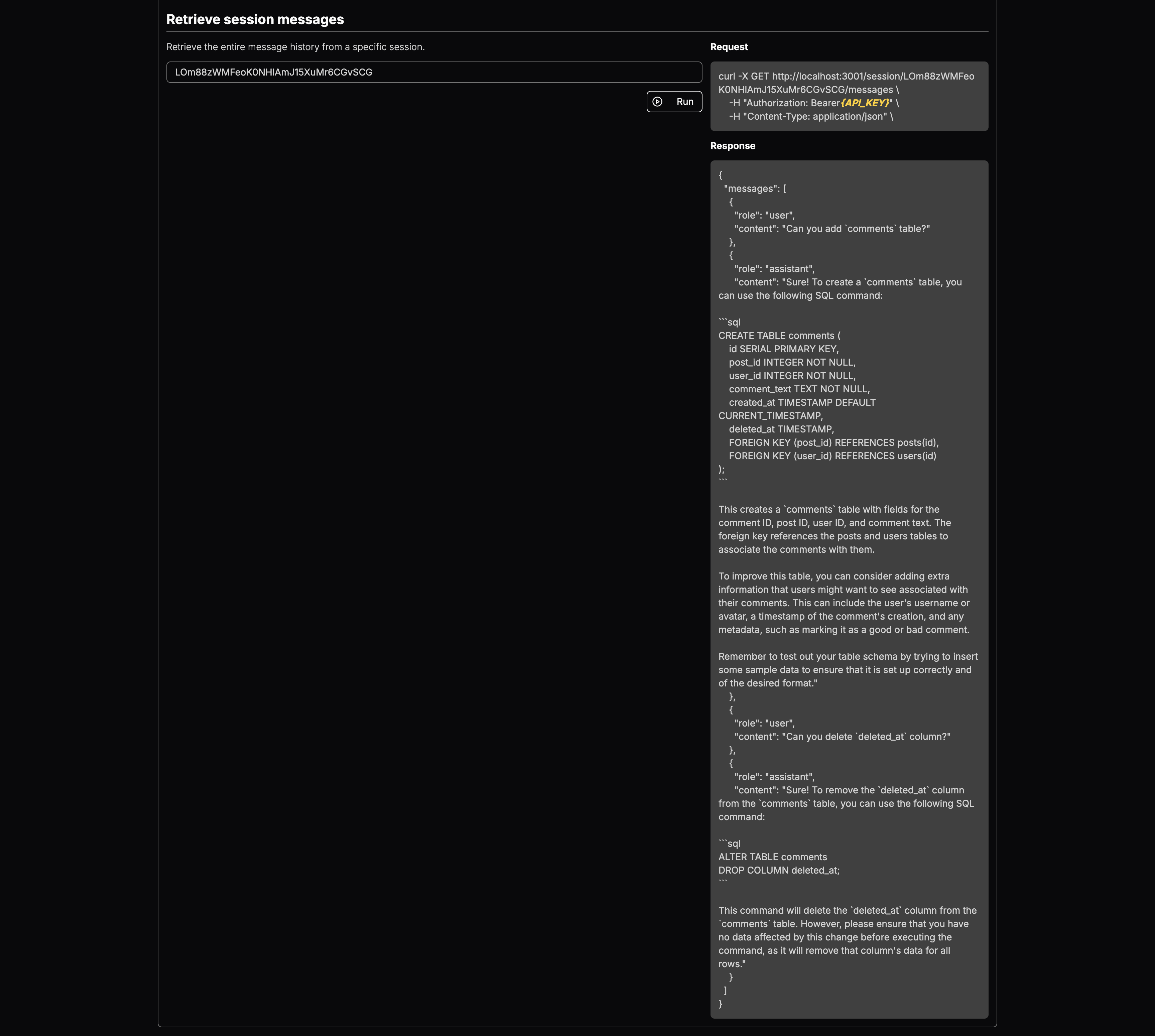

以下是gpinterface可以做什么的一些具体示例:

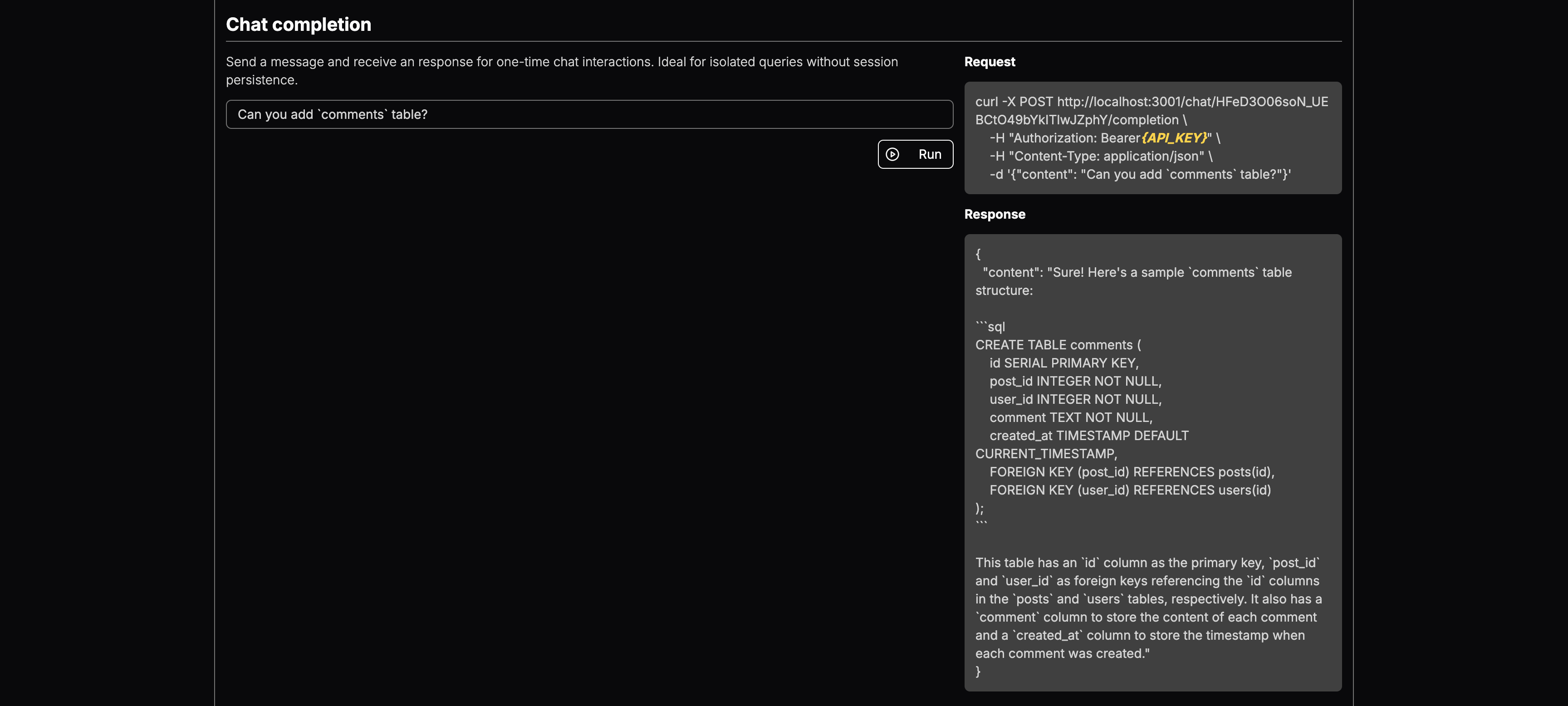

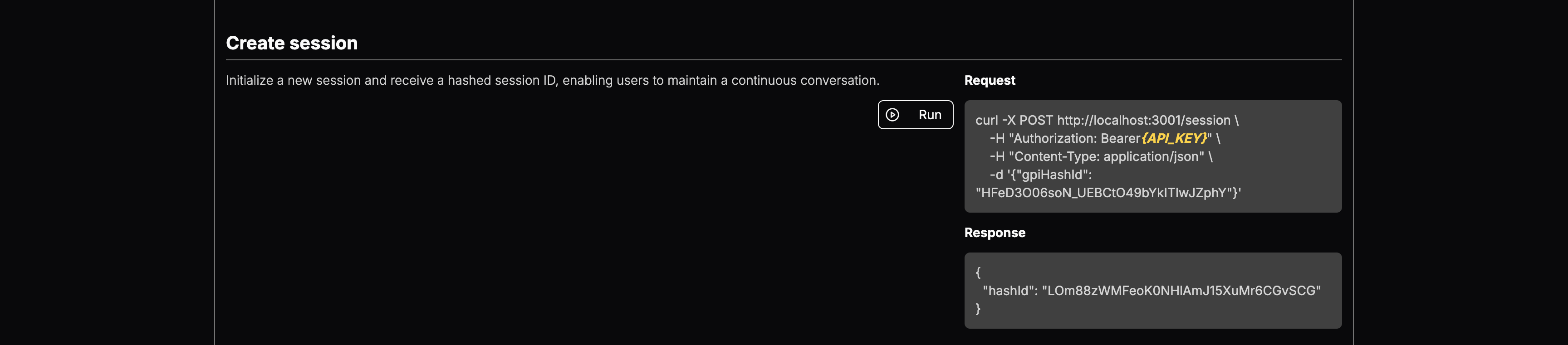

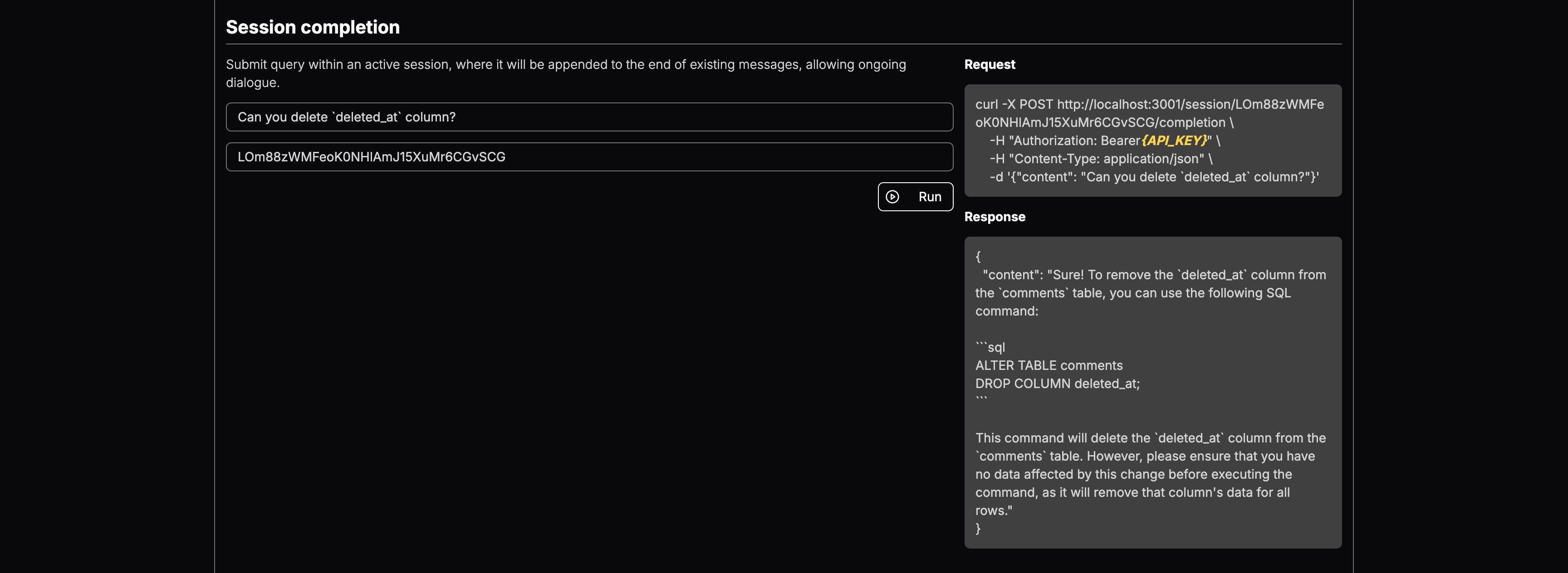

您可以选择LLM模型并添加上下文。部署后,您将获得终点:

它是一种功能强大的工具,旨在简化多个大型语言模型(LLM)的生成提示的测试和部署。使用易于使用的Web界面, gpinterface可以快速配置和实验。

gpinterface当前支持各种领先的大型语言模型,包括:

这种多样化的支持使您可以为您的特定需求和要求选择最佳模型。

没有看到您最喜欢的模型?随时打开PR或与我联系!

该应用程序需要一个PostgreSQL数据库。使用Docker启动数据库:

cd backend

docker-compose up -d后端利用Prisma来管理数据库模式和迁移。在数据库初始化中执行以下命令:

npm run prisma:migrate要用每个支持的大语言模型的初始数据播种数据库,请运行以下命令:

npx ts-node prisma/seed后端

后端需要设置以下环境变量:

CLIENT_URL= " http://localhost:3003 "

DATABASE_URL= " postgresql://postgres:[email protected]:5432/postgres " # can be replaced with your DB endpoint

AI21_API_KEY= " YOUR_AI21_API_KEY "

ANTHROPIC_API_KEY= " YOUR_ANTHROPIC_API_KEY "

COHERE_API_KEY= " YOUR_COHERE_API_KEY "

GOOGLE_API_KEY= " YOUR_GOOGLE_API_KEY "

MISTRAL_API_KEY= " YOUR_MISTRAL_API_KEY "

OPENAI_API_KEY= " YOUR_OPENAI_API_KEY "

AWS_ACCESS_KEY_ID= " AWS_ACCESS_KEY " # you need Llama model access in AWS Bedrock

AWS_SECRET_ACCESS_KEY= " AWS_SECRET_KEY " # you need Llama model access in AWS Bedrock

JWT_SECRET= " SECURE_RANDOM_STRING "

COOKIE_SECRET= " SECURE_RANDOM_STRING "

NODE_ENV= " development " # for development logging在启动应用程序之前,请确保将这些变量设置在后端目录中的.env文件中。

前端

前端应用需要以下环境变量:

NEXT_PUBLIC_API_ENDPOINT= " http://localhost:3000 "

NEXT_PUBLIC_CHAT_ENDPOINT= " http://localhost:3001 "

NEXT_PUBLIC_HOSTNAME= " http://localhost:3003 "

NEXT_PUBLIC_GOOGLE_OAUTH_CLIENT_KEY= " "这些应配置为匹配可用后端服务的端点,以确保前端可以正确与后端通信。

为了开发目的,分别运行应用程序组件:

运行后端

cd backend && npm run dev运行前端

cd frontend && npm run dev要构建用于生产部署的所有组件,请依次遵循以下步骤

cd shared

npm run build

cd ../backend

npm run build

cd ../frontend

npm run build启动服务器

运行后端

cd backend && npm run start运行聊天服务器(API服务器)

cd backend && npm run start:chat运行前端

cd frontend && npm run start