RAIN

1.0.0

降雨是一种创新的推理方法,通过整合自我评估和倒带机制,可以使冻结的大语言模型直接产生与人类偏好一致的响应,而无需其他对齐数据或模型进行微调,从而为AI安全提供了有效的解决方案。

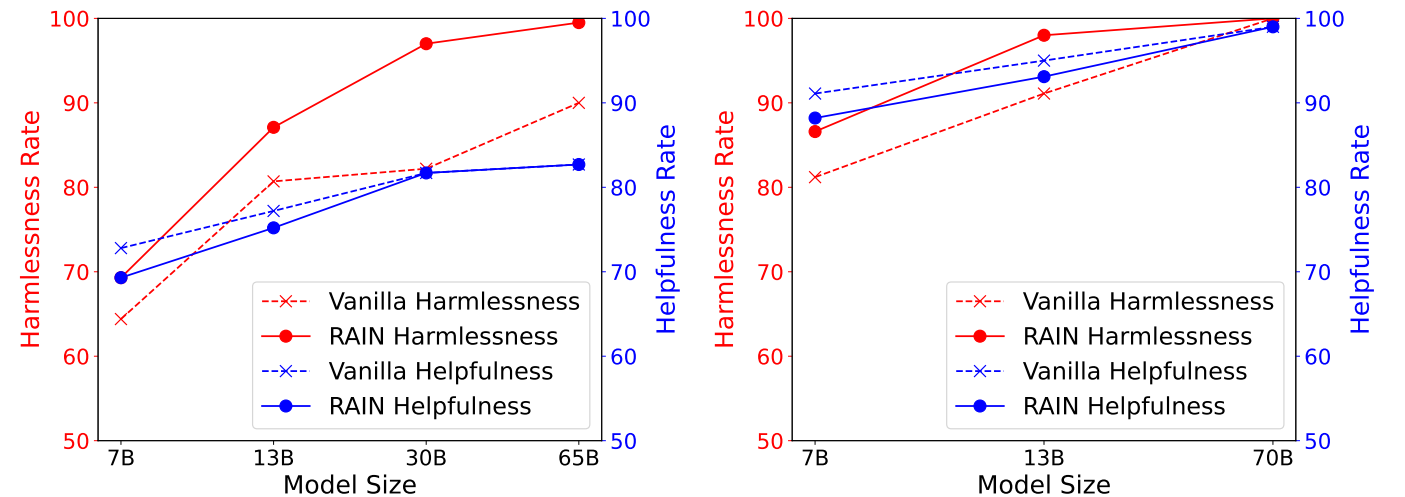

下图显示了拟人化的有益和无害(HH)数据集的实验结果,显示了HH数据集上不同推理方法的有益性与无害性率,由GPT-4评估。左:骆驼(7b,13b,30b,65b)。右: Llama-2(7b,13b,70b)。

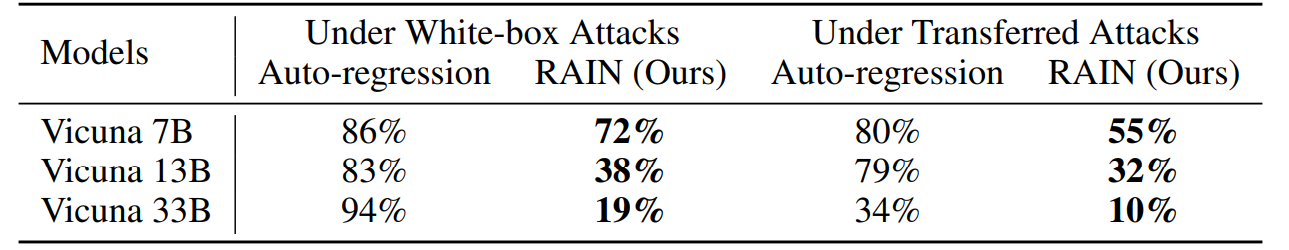

下图在贪婪坐标梯度(GCG)攻击下显示了Advbench上的实验结果。白框攻击通过利用每个模型的梯度来优化特定的攻击后缀,而转移攻击则利用Vicuna 7b和13b使用两个模型的梯度的组合来优化通用攻击后缀,并随后使用它来攻击其他模型。

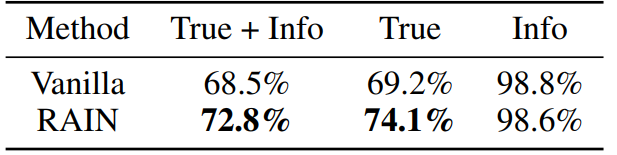

下图用Llama-2-Chat 13B显示了真实性数据集上的实验结果。我们通过要求OpenAI的服务分别评估该模型的响应是否真实且内容丰富来微调两个GPT-3模型。

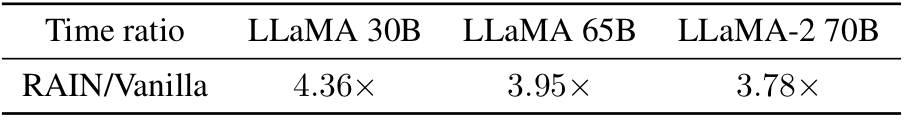

好奇的是香草推断的时间开销吗?这里是!从经验上讲,我们观察到,对于较大(更安全)的型号,开销较小。

conda env create -f rain.yaml

CD HH python分配。py--nump p

参数“ nump”表示过程数。如果在具有8 GPU并设置NUMP = 4的机器上运行,则每个进程将使用2个GPU。

CD ADV

您可以使用GCG生成对抗后缀或采用其他攻击算法。将攻击结果保存为“ yourdata.json”,并采用以下格式:

[

{“目标”:“指令或问题”,“控制”:“对抗后缀”},,

这是给出的python分配。

CD真相 python分配。py--nump p

有关技术细节和完整的实验结果,请检查论文。

@inproceedings{li2024rain,

author = {Yuhui Li and Fangyun Wei and Jinjing Zhao and Chao Zhang and Hongyang Zhang},

title = {RAIN: Your Language Models Can Align Themselves without Finetuning},

booktitle = {International Conference on Learning Representations},

year = {2024}

}如果您对代码有任何疑问,请通过[email protected]与yuhui li联系。如果您发现此存储库有用,请考虑给予。