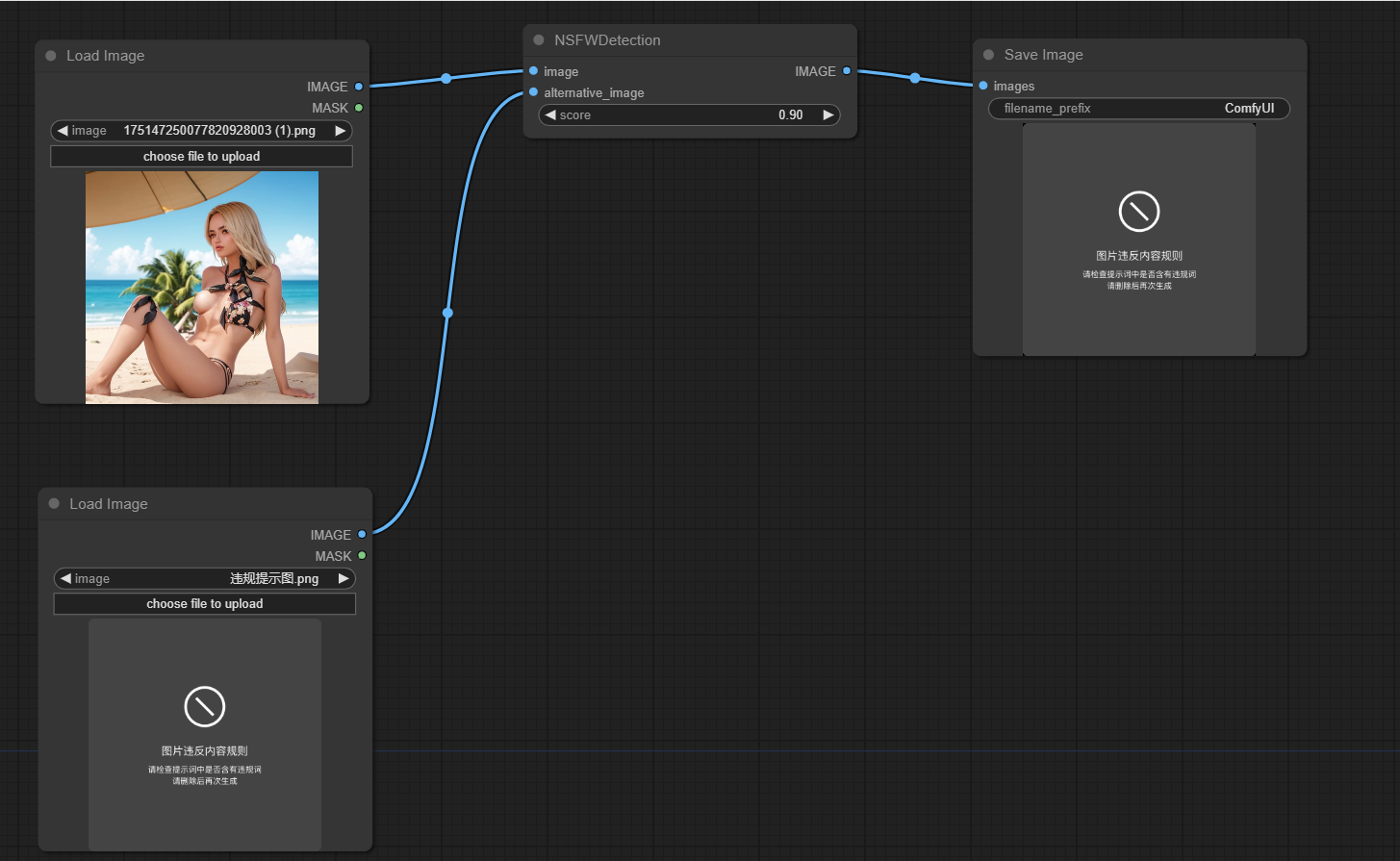

ComfyUI NSFW Detection

1.0.0

该项目旨在检测comfyui生成的图像是否不安全(NSFW)。它使用机器学习模型将图像分类为安全或不安全的工作。如果将图像归类为NSFW,则返回替代图像。

克隆此仓库到custo_nodes comfyui位置的目录

运行PIP安装-R要求

该项目的主要功能封装在node.py文件中的NSFWDetection类中。该类有一个run方法,该方法采用三个参数:

image :要分类的图像。score :将图像分类为NSFW的阈值分数。alternative_image :如果输入图像分类为NSFW,则要返回的图像。

https://github.com/trumanwong/comfyui-nsfw-detection/blob/main/workflow.json

欢迎捐款。如果您有任何改进或错误修复,请提交拉动请求。

该项目是根据MIT许可证的条款获得许可的。