LLCP

1.0.0

该存储库包含ICLR2024论文LLCP的实现:学习基于推理的视频问题答案PDF的潜在因果过程

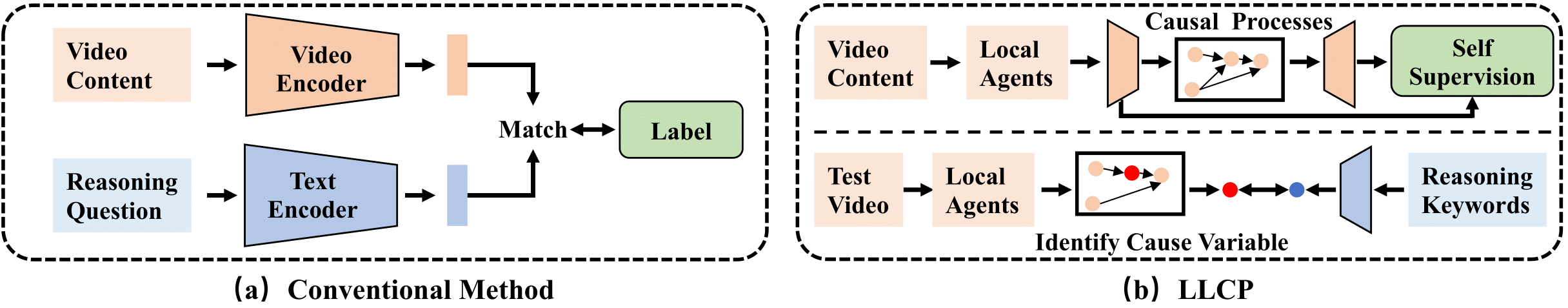

LLCP是一个因果框架,旨在通过关注事件内物体的空间动力学来增强视频推理,而无需进行广泛的数据注释。通过采用自我监督的学习并利用因果机制的模块化,LLCP学习了空间 - 周期动力学的多元生成模型,因此可以实现有效的事故归因和基于推理的视频的反事实预测。

首先,请安装最近版本的Pytorch和Torchvision作为pip install torch torchvision 。然后,您可以通过运行pip install -r requirements.txt安装其他软件包

我们提供实验中使用的处理功能。请在此链接1和此链接中下载数据和模型2。然后,请以./data/和./results/的形式解压缩群,然后替换原始的虫子作为下载的虫。

目录结构应该看起来像

LLCP_VQA/

|–– config.py

|–– configs/

|–– data/

| |–– object_test_feat/

| |–– object_train_feat/

| |–– appearance_feat_rn50.h5

| |–– test_questions.pt

| |–– train_questions.pt

| |–– video_noaccident_train.txt

|–– DataLoader.py

|–– models_cvae.py

|–– requirements.txt

|–– results/

| |–– .../model_cvae49.pt

|–– README.md

|–– train.py

|–– validate.py

要训练CVAE模型,您可以运行此命令:

python train.py --cfg configs/sutd-traffic_transition.yml

要评估受过训练的模型,请参考:

python validate.py --cfg configs/sutd-traffic_transition.yml

参见LLCP仿真。

如果您发现我们的工作对您的研究有用,请考虑引用:

@inproceedings{chen2024llcp,

title={LLCP: Learning Latent Causal Processes for Reasoning-based Video Question Answer},

author={Chen, Guangyi and Li, Yuke and Liu, Xiao and Li, Zijian and Al Surad, Eman and Wei, Donglai and Zhang, Kun}

booktitle={ICLR},

year={2024}

}

我们的实施主要基于Sutd-Trafficqa和Tem-Apapter,我们感谢作者发布其代码。