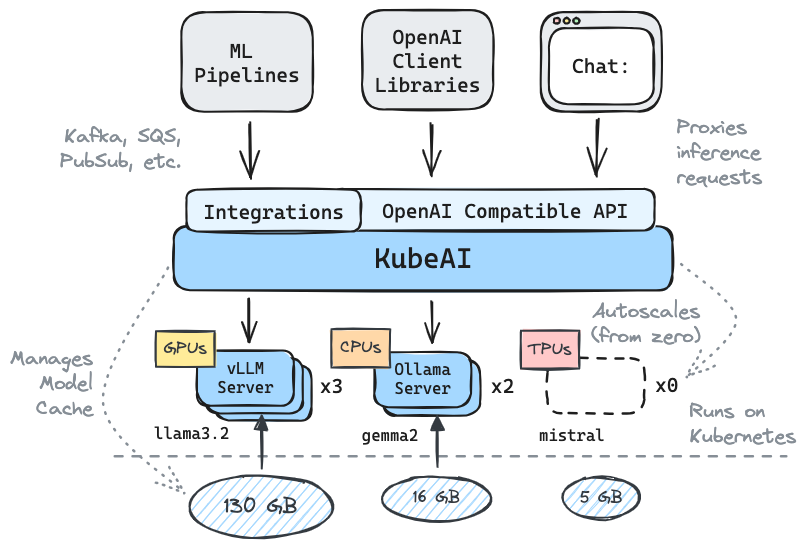

在Kubernetes上进行推断:LLM,嵌入,语音到文本。

✅️与API兼容性进行OpenAI的置换式替换

⚖️从零的尺度,基于负载的AutoScale

?服务文本生成模型(LLM,VLM等)

对文字API的讲话

?嵌入/矢量API

多平台:仅CPU,GPU,TPU

?带有共享文件系统(EFS,FILESTORE等)的模型缓存

零依赖性(不依赖于iStio,knative等)

聊天UI包括(OpenWebui)

?操作OSS模型服务器(VLLM,Ollama,更快的Whisper,Infinity)

✉通过消息集成(Kafka,PubSub等)通过消息/批处理推理

社区的行情:

可重复使用,抽象的解决方案运行LLM -Mike Ensor

Kubeai提供兼容的HTTP API。管理员可以通过kind: Model Kubernetes自定义资源。可以将Kubeai视为管理VLLM和Ollama服务器的模型操作员(请参阅操作员模式)。

使用善良或Minikube创建本地群集。

# You might need to stop and remove the existing machine:

podman machine stop

podman machine rm

# Init and start a new machine:

podman machine init --memory 6144 --disk-size 120

podman machine startkind create cluster # OR: minikube start添加Kubeai Helm存储库。

helm repo add kubeai https://www.kubeai.org

helm repo update安装Kubeai并等待所有组件准备就绪(可能需要一分钟)。

helm install kubeai kubeai/kubeai --wait --timeout 10m安装一些预定义的型号。

cat << EOF > kubeai-models.yaml

catalog:

gemma2-2b-cpu:

enabled: true

minReplicas: 1

qwen2-500m-cpu:

enabled: true

nomic-embed-text-cpu:

enabled: true

EOF

helm install kubeai-models kubeai/models

-f ./kubeai-models.yaml在进行下一步之前,请在独立终端中的豆荚上启动手表,以了解Kubeai如何部署模型。

kubectl get pods --watch因为我们将minReplicas: 1对于Gemma模型,您应该看到已经出现的模型POD。

开始捆绑的聊天UI的本地港口。

kubectl port-forward svc/openwebui 8000:80现在,将浏览器打开到Localhost:8000,然后选择开始与之聊天的Gemma模型。

如果您返回浏览器并与QWEN2聊天,您会注意到首先需要一段时间才能做出响应。这是因为我们设置了minReplicas: 0对于此模型,Kubeai需要旋转一个新的POD(您可以使用kubectl get models -oyaml qwen2-500m-cpu进行验证。

在kubeai.org上查看我们的文档,以查找有关:

已知采用者清单:

| 姓名 | 描述 | 关联 |

|---|---|---|

| 望远镜 | 望远镜使用kubeai进行多区域大规模批处理LLM推理。 | trytelescope.ai |

| Google云分布式边缘 | Kubeai作为参考体系结构包括在边缘推断。 | LinkedIn,Gitlab |

| Lambda | 您可以在Lambda AI开发人员云上尝试Kubeai。请参阅Lambda的教程和视频。 | Lambda |

如果您使用的是kubeai,并且希望被列为采用者,请进行公关。

# Implemented #

/v1/chat/completions

/v1/completions

/v1/embeddings

/v1/models

/v1/audio/transcriptions

# Planned #

# /v1/assistants/*

# /v1/batches/*

# /v1/fine_tuning/*

# /v1/images/*

# /v1/vector_stores/* 注意: Kubeai诞生于一个名为Lingo的项目,该项目是一个简单的Kubernetes LLM代理,具有基本的自动化。我们以Kubeai(2024年8月下旬)重新推出了该项目,并将路线图扩大到了今天的路线图。

?不要忘记在Github上放我们的一颗星星,然后跟随回购保持最新状态!

让我们知道您有兴趣查看或伸出疑问的功能。访问我们的Discord频道参加讨论!

或者,如果您想连接,请在LinkedIn上伸出援手: