开箱即用的AI智能助手API

英语| 简体中文| 日本语

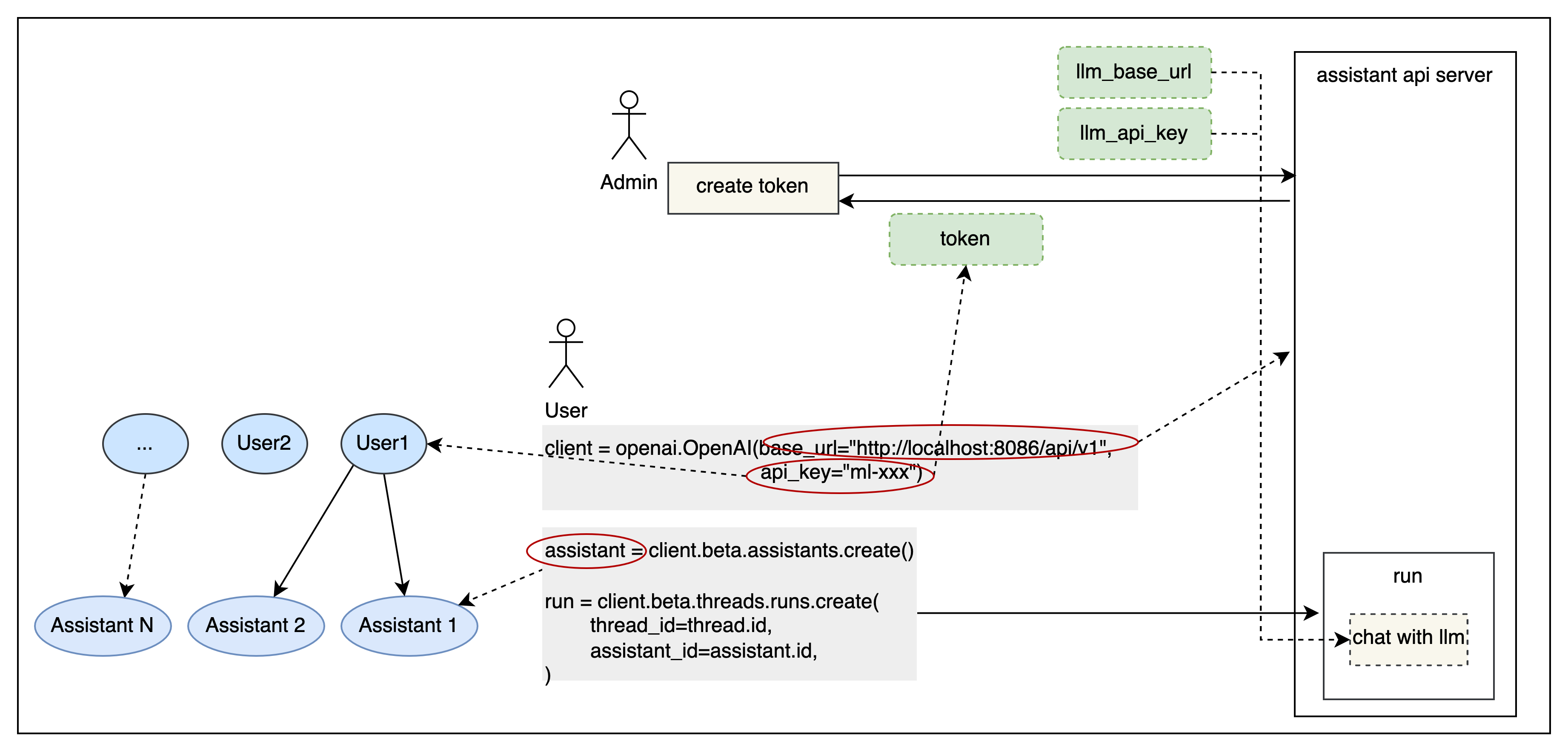

Open Assistant API是一个开源的,自托管的AI智能助理API,与官方的OpenAI界面兼容。它可以直接与官方OpenAI客户端一起构建LLM应用程序。

它支持一个API与更多的商业和私人模型集成。

它支持R2R抹布发动机。

以下是使用官方Openai Python openai图书馆的一个示例:

import openai

client = openai . OpenAI (

base_url = "http://127.0.0.1:8086/api/v1" ,

api_key = "xxx"

)

assistant = client . beta . assistants . create (

name = "demo" ,

instructions = "You are a helpful assistant." ,

model = "gpt-4-1106-preview"

)| 特征 | 公开助理API | Openai Assistant API |

|---|---|---|

| 生态系统策略 | 开源 | 封闭的来源 |

| 抹布引擎 | 支持R2R | 支持 |

| 互联网搜索 | 支持 | 不支持 |

| 自定义功能 | 支持 | 支持 |

| 内置工具 | 可扩展 | 不可扩展 |

| 代码解释器 | 正在开发 | 支持 |

| 多模式 | 支持 | 支持 |

| LLM支持 | 支持更多的LLM | 只有GPT |

| 消息流输出 | 支持 | 支持 |

| 本地部署 | 支持 | 不支持 |

启动开放助手API的最简单方法是运行Docker-compose.yml文件。在运行之前,请确保在计算机上安装Docker和Docker组合。

转到项目根目录,Open docker-compose.yml ,填写OpenAI API_KEY和BING SEARCH键(可选)。

# openai api_key (supports OneAPI api_key)

OPENAI_API_KEY= < openai_api_key >

# bing search key (optional)

BING_SUBSCRIPTION_KEY= < bing_subscription_key >建议配置R2R RAG引擎以替换默认的RAG实现,以提供更好的RAG功能。您可以通过R2R GITHUB存储库来了解并使用R2R。

# RAG config

# FILE_SERVICE_MODULE=app.services.file.impl.oss_file.OSSFileService

FILE_SERVICE_MODULE=app.services.file.impl.r2r_file.R2RFileService

R2R_BASE_URL=http:// < r2r_api_address >

R2R_USERNAME= < r2r_username >

R2R_PASSWORD= < r2r_password >docker compose up -dAPI基础网址:http://127.0.0.1:8086/api/v1

接口文档地址:http://127.0.0.1:8086/docs

在此示例中,使用官方的OpenAI客户端库创建并运行AI助手。如果您需要探索其他用法方法,例如流量输出,工具(Web_search,检索,功能)等,则可以在示例目录中找到相应的代码。在运行之前,您需要运行pip install openai来安装Python openai库。

# !pip install openai

export PYTHONPATH= $( pwd )

python examples/run_assistant.py根据令牌提供简单的用户隔离,以满足SaaS部署要求。可以通过配置APP_AUTH_ENABLE来启用它。

Authorization: Bearer ***以进行身份验证。APP_AUTH_ADMIN_TOKEN ,默认为“ Admin”。根据OpenAPI/Swagger规范,它允许将各种工具集成到助手中,赋予和增强其与外部世界建立联系的能力。

加入Slack频道,查看新的版本,讨论问题并参与社区互动。

加入Discord频道与其他社区成员互动。

加入微信组:

我们主要提到并依靠以下项目:

请阅读我们的贡献文件,以了解如何贡献。

该存储库遵循MIT开源许可证。有关更多信息,请参阅许可证文件。