>>> 點此安裝 Fooocus <<<

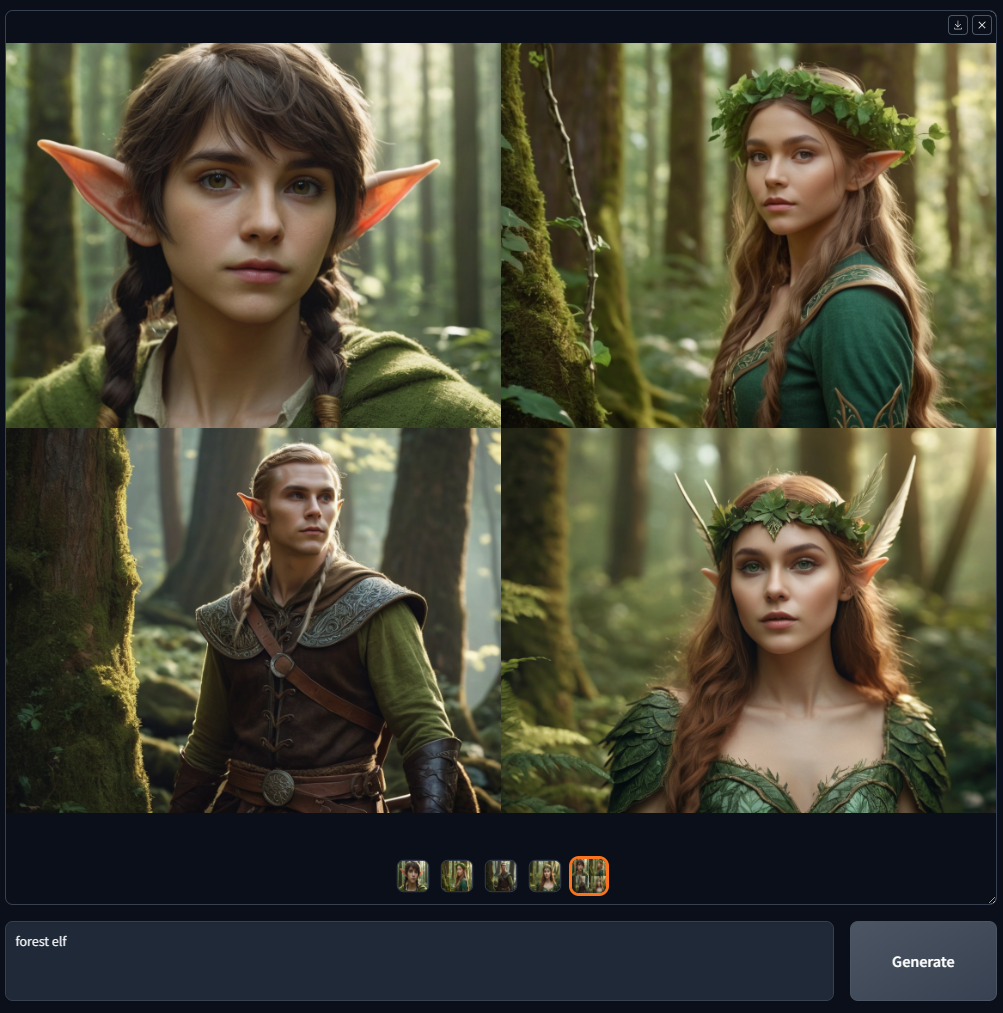

Fooocus 是一款影像產生軟體(基於Gradio)。

Fooocus 提出了對影像產生器設計的重新思考。該軟體是離線、開源、免費的,同時與Midjourney等許多線上圖像生成器類似,不需要手動調整,用戶只需關注提示和圖像即可。 Fooocus 也簡化了安裝:在按下「下載」和產生第一個影像之間,所需的滑鼠點擊次數嚴格限制在 3 次以內。

最近,當你搜尋「fooocus」時,Google上就會出現許多假網站。不要相信那些——這是 Fooocus 的唯一官方來源。

Fooocus 專案完全基於Stable Diffusion XL架構構建,目前處於有限長期支援 (LTS) 狀態,僅修復錯誤。由於現有功能被認為幾乎沒有程序問題(感謝 mashb1t 的巨大努力),未來的更新將專門專注於解決可能出現的任何錯誤。

目前沒有遷移到或合併新模型架構的計劃。然而,隨著開源社群的發展,這種情況可能會改變。例如,如果社群集中在一種主要的圖像生成方法(鑑於目前的狀況,這可能真的會在半年或一年內發生),Fooocus 也可能會遷移到該方法。

對於有興趣利用Flux等新模型的人,我們建議探索替代平台,例如 WebUI Forge(也來自我們)、ComfyUI/SwarmUI。此外,還有幾個優秀的 Fooocus 分叉可供實驗。

同樣,最近當你搜尋“fooocus”時,谷歌上就會出現許多虛假網站。不要從這些網站取得 Fooocus – 此頁面是 Fooocus 的唯一官方來源。我們從來沒有任何像是「fooocus.com」、「fooocus.net」、「fooocus.co」、「fooocus.ai」、「fooocus.org」、「fooocus.pro」、「fooocus.one」這樣的網站。這些網站都是假的。他們與我們絕對沒有任何關係。 Fooocus是一款100%非商業離線開源軟體。

以下是使用 Midjourney 範例的快速清單:

| 中途 | 福庫斯 |

|---|---|

| 高品質的文字到圖像,無需大量即時工程或參數調整。 (未知方法) | 高品質的文字到圖像,無需大量即時工程或參數調整。 (Fooocus 擁有基於 GPT-2 的離線提示處理引擎和大量採樣改進,因此無論您的提示短如“花園中的房子”還是長至 1000 個單詞,結果總是很漂亮) |

| V1 V2 V3 V4 | 輸入影像 -> 高檔或變化 -> 變化(微妙)/變化(強) |

| U1 U2 U3 U4 | 輸入影像 -> 放大或變化 -> 放大 (1.5x) / 放大 (2x) |

| 修復/上/下/左/右(平移) | 輸入影像 -> 修復或修復 -> 修復/上/下/左/右 (Fooocus使用自己的修復演算法和修復模型,因此結果比所有其他使用標準SDXL修復方法/模型的軟體更令人滿意) |

| 圖片提示 | 輸入影像->影像提示 (Fooocus 使用自己的影像提示演算法,因此結果品質和提示理解比使用標準 SDXL 方法(如標準 IP 適配器或修訂版)的所有其他軟體更令人滿意) |

| - 風格 | 高級 -> 風格 |

| --風格化 | 高級 -> 高級 -> 指導 |

| ——尼吉 | 多個啟動器:「run.bat」、「run_anime.bat」和「run_realistic.bat」。 Fooocus 支援 Civitai 上的 SDXL 型號 (不知道的可以穀歌搜尋“Civitai”) |

| --品質 | 高級->質量 |

| - 重複 | 進階 -> 影像編號 |

| 多重提示 (::) | 只需使用多行提示即可 |

| 提示重量 | 你可以使用「我是(快樂:1.5)」。 Fooocus使用A1111的重新加權演算法,因此如果使用者直接從Civitai複製提示,結果會比ComfyUI更好。 (因為如果提示是用ComfyUI的重新加權編寫的,用戶就不太可能複製提示文本,因為他們更喜歡拖曳文件) 要使用嵌入,可以使用“(embedding:file_name:1.1)” |

| - 不 | 進階 -> 否定提示 |

| --ar | 高級 -> 寬高比 |

| 洞察面 | 輸入影像->影像提示->進階->FaceSwap |

| 描述 | 輸入影像 -> 描述 |

以下是使用 LeonardoAI 範例的快速清單:

| 萊昂納多人工智慧 | 福庫斯 |

|---|---|

| 瞬發魔法 | 高級 -> 風格 -> Fooocus V2 |

| 高級採樣器參數(如對比度/銳利度/等) | 進階 -> 進階 -> 取樣清晰度/等等 |

| 使用者友善的 ControlNet | 輸入影像->影像提示->高級 |

另外,請按一下此處瀏覽進階功能。

您可以直接下載Fooocus:

>>>點此下載<<<

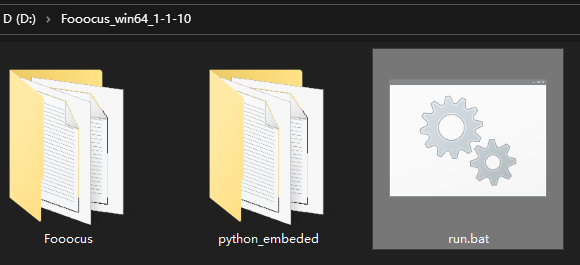

下載檔案後,請將其解壓縮,然後執行「run.bat」。

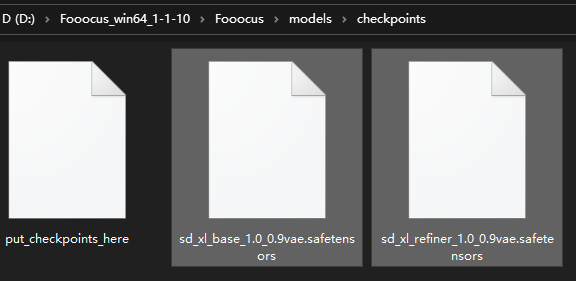

第一次啟動軟體時,它會自動下載模型:

它將根據不同的預設將預設模型下載到資料夾“Fooocusmodelscheckpoints”。如果您不想自動下載,可以提前下載。

注意,如果你使用inpaint,第一次修復圖像時,它會從這裡下載Fooocus自己的inpaint控制模型,文件為“Fooocusmodelsinpaintinpaint_v26.fooocus.patch”(該檔案的大小為1.28GB)。

在 Fooocus 2.1.60 之後,您還將擁有run_anime.bat和run_realistic.bat 。它們是不同的模型預設(並且需要不同的模型,但它們會自動下載)。按此了解更多詳情。

Fooocus 2.3.0之後您也可以直接在瀏覽器中切換預設。如果您想更改預設行為,請記住要新增這些參數:

使用--disable-preset-selection停用瀏覽器中的預設選擇。

使用--always-download-new-model下載預設開關上缺少的模型。預設值是回退到對應預設中定義的previous_default_models ,另請參閱終端輸出。

如果您已有這些文件,可以將它們複製到上述位置以加快安裝速度。

請注意,如果您看到"MetadataIncompleteBuffer" 或 "PytorchStreamReader" ,則您的模型檔案已損壞。請重新下載模型。

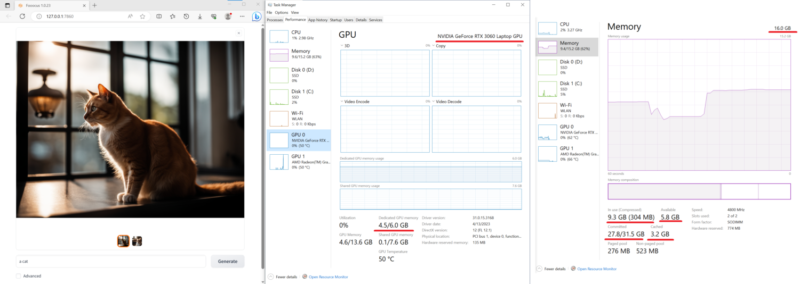

以下是在一台具有16GB 系統 RAM和6GB VRAM的相對低階筆記型電腦(Nvidia 3060 筆記型電腦)上進行的測試。這台機器上的速度約為每次迭代 1.35 秒。相當令人印象深刻——如今配備 3060 的筆記型電腦通常價格非常可接受。

此外,最近許多其他軟體報告稱 Nvidia 532 以上的驅動程式有時比 Nvidia 驅動程式 531 慢 10 倍。

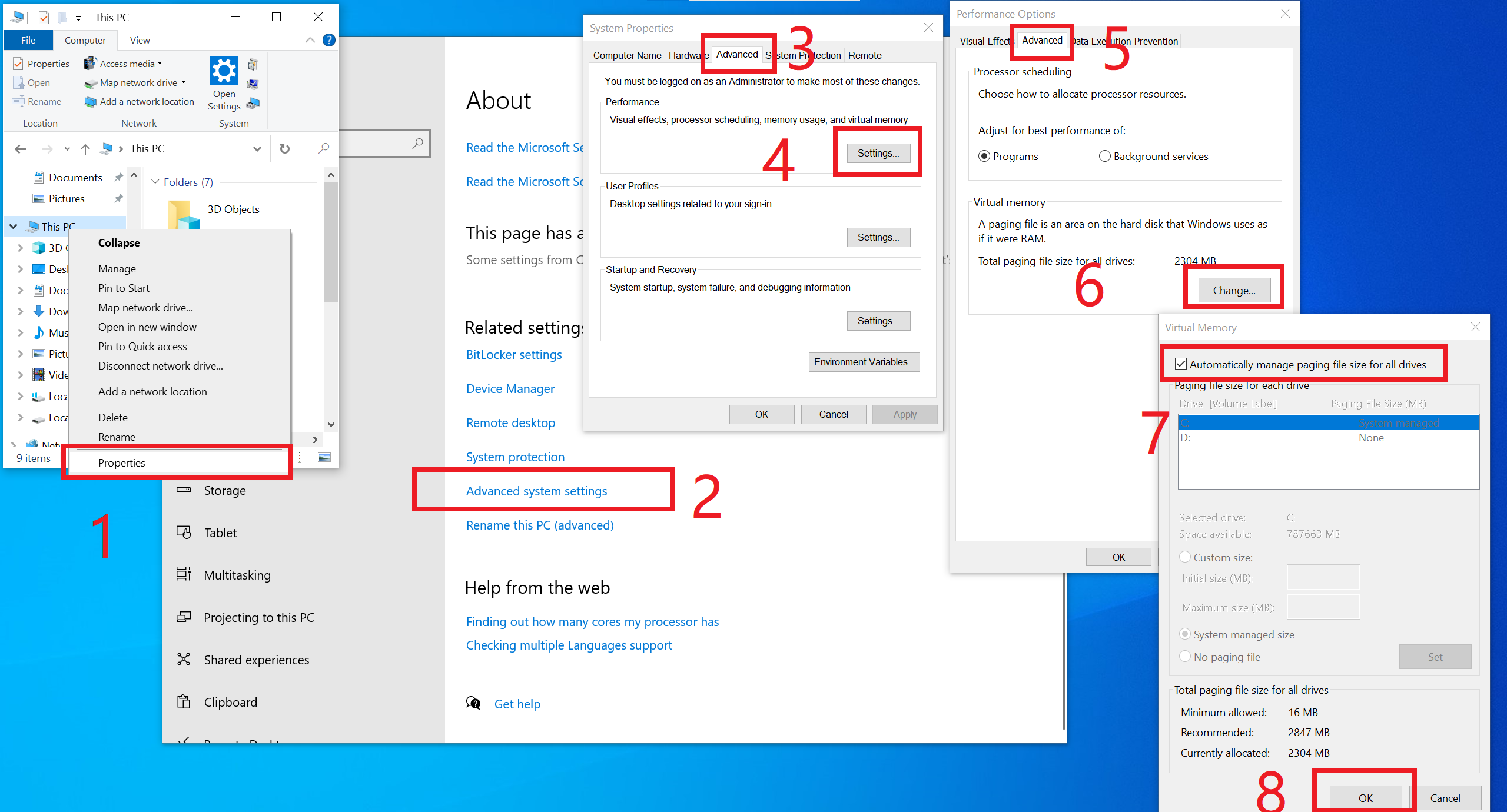

請注意,最低要求是4GB Nvidia GPU 記憶體 (4GB VRAM)和8GB 系統記憶體 (8GB RAM) 。這需要使用 Microsoft 的虛擬交換技術,在大多數情況下,Windows 安裝會自動啟用該技術,因此您通常不需要對此執行任何操作。但是,如果您不確定,或者您手動將其關閉(真的有人會這樣做嗎?),或者如果您看到任何“RuntimeError:CPUAllocator” ,您可以在此處啟用它:

如果您仍然看到“RuntimeError: CPUAllocator”,請確保每個磁碟機上至少有 40GB 可用空間!

如果您使用類似的設備但仍然無法達到可接受的效能,請提出問題。

請注意,不同平台的最低要求是不同的。

另請參閱此處的常見問題和疑難排解。

(最後一次測試 - 2024 年 8 月 12 日,由 mashb1t 進行)

| 科拉布 | 資訊 |

|---|---|

| 福客官方 |

在 Colab 中,您可以將最後一行修改為!python entry_with_update.py --share --always-high-vram或!python entry_with_update.py --share --always-high-vram --preset anime或!python entry_with_update.py --share --always-high-vram --preset realistic for Fooocus 預設/動漫/現實版。

您也可以在 UI 中變更預設。請注意,這可能會導致 60 秒後超時。如果是這種情況,請等待下載完成,將預設變更為初始值,然後返回您選擇的預設,或重新載入頁面。

請注意,此 Colab 將預設為停用 Refiner,因為免費 Colab 的資源相對有限(並且一些「大」功能(如圖片提示)可能會導致免費 Colab 斷開連接)。我們確保基本的文字到圖像始終在免費 Colab 上運行。

使用--always-high-vram將資源分配從 RAM 轉移到 VRAM,並在預設 T4 執行個體上實現效能、靈活性和穩定性之間的整體最佳平衡。請在此處查找更多資訊。

感謝 Camenduru 提供模板!

如果你想使用Anaconda/Miniconda,你可以

git clone https://github.com/lllyasviel/Fooocus.git cd Fooocus conda env create -f environment.yaml conda activate fooocus pip install -r requirements_versions.txt

然後下載模型:將預設模型下載到資料夾「Fooocusmodelscheckpoints」。或讓 Fooocus 使用啟動器自動下載模型:

conda activate fooocus python entry_with_update.py

或者,如果您想打開遠端端口,請使用

conda activate fooocus python entry_with_update.py --listen

對於 Fooocus Anime/Realistic Edition,請使用python entry_with_update.py --preset anime或python entry_with_update.py --preset realistic 。

你的 Linux 需要安裝Python 3.10 ,假設你的 Python 可以在 venv 系統運作的情況下使用指令python3呼叫;你可以

git clone https://github.com/lllyasviel/Fooocus.git cd Fooocus python3 -m venv fooocus_env source fooocus_env/bin/activate pip install -r requirements_versions.txt

有關模型下載,請參閱上述部分。您可以透過以下方式啟動該軟體:

source fooocus_env/bin/activate python entry_with_update.py

或者,如果您想打開遠端端口,請使用

source fooocus_env/bin/activate python entry_with_update.py --listen

對於 Fooocus Anime/Realistic Edition,請使用python entry_with_update.py --preset anime或python entry_with_update.py --preset realistic 。

如果您知道自己在做什麼,並且您的 Linux 已經安裝了Python 3.10 ,並且可以使用命令python3呼叫您的 Python(以及使用pip3的 Pip ),您可以

git clone https://github.com/lllyasviel/Fooocus.git cd Fooocus pip3 install -r requirements_versions.txt

有關模型下載,請參閱上述部分。您可以透過以下方式啟動該軟體:

python3 entry_with_update.py

或者,如果您想打開遠端端口,請使用

python3 entry_with_update.py --listen

對於 Fooocus Anime/Realistic Edition,請使用python entry_with_update.py --preset anime或python entry_with_update.py --preset realistic 。

請注意,不同平台的最低要求是不同的。

與上述說明相同。您需要將手電筒更改為AMD版本

pip uninstall torch torchvision torchaudio torchtext functorch xformers pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/rocm5.6

然而,AMD 並未經過深入測試。 AMD 支援處於測試階段。

對於 Fooocus Anime/Realistic Edition,請使用python entry_with_update.py --preset anime或python entry_with_update.py --preset realistic 。

請注意,不同平台的最低要求是不同的。

與 Windows 相同。下載軟體並編輯run.bat內容為:

.python_embededpython.exe -m pip uninstall torch torchvision torchaudio torchtext functorch xformers -y .python_embededpython.exe -m pip install torch-directml .python_embededpython.exe -s Fooocusentry_with_update.py --directml pause

然後執行run.bat 。

然而,AMD 並未經過深入測試。 AMD 支援處於測試階段。

對於 AMD,對於 Fooocus Anime/Realistic Edition,請使用.python_embededpython.exe entry_with_update.py --directml --preset anime或.python_embededpython.exe entry_with_update.py --directml --preset realistic 。

請注意,不同平台的最低要求是不同的。

Mac 沒有經過深入測試。以下是使用 Mac 的非官方指南。有問題可以在這裡討論。

您可以在具有 macOS“Catalina”或更新版本的 Apple Mac 晶片(M1 或 M2)上安裝 Fooocus。 Fooocus 透過 PyTorch MPS 裝置加速在 Apple 矽電腦上運作。 Mac Silicon 電腦不配備專用顯示卡,因此與配備專用顯示卡的電腦相比,影像處理時間顯著延長。

每晚安裝 conda 套件管理器和 pytorch。請閱讀 Mac Apple 開發人員指南上的 Accelerated PyTorch 培訓以取得說明。確保 pytorch 能夠識別您的 MPS 裝置。

開啟 macOS 終端機應用程式並使用git clone https://github.com/lllyasviel/Fooocus.git複製此儲存庫。

切換到新的 Fooocus 目錄, cd Fooocus 。

建立一個新的 conda 環境conda env create -f environment.yaml 。

啟動新的 conda 環境, conda activate fooocus 。

安裝 Fooocus 所需的軟體包, pip install -r requirements_versions.txt 。

透過執行python entry_with_update.py啟動 Fooocus。 (某些 Mac M2 使用者可能需要python entry_with_update.py --disable-offload-from-vram來加速模型載入/卸載。)第一次執行 Fooocus 時,它會自動下載 Stable Diffusion SDXL 模型,並且會花費大量時間。長短,取決於您的網路連線。

對於 Fooocus Anime/Realistic Edition,請使用python entry_with_update.py --preset anime或python entry_with_update.py --preset realistic 。

參見 docker.md

請參閱此處的指南。

以下是本地運行 Fooocus 的最低要求。如果您的設備能力低於此規格,您可能無法在本地使用 Fooocus。 (無論如何,如果您的設備性能較低但 Fooocus 仍然可以工作,請告訴我們。)

| 作業系統 | 圖形處理器 | 最小 GPU 記憶體 | 最小系統記憶體 | 系統交換 | 筆記 |

|---|---|---|---|---|---|

| 視窗/Linux | 英偉達 RTX 4XXX | 4GB | 8GB | 必需的 | 最快 |

| 視窗/Linux | 英偉達 RTX 3XXX | 4GB | 8GB | 必需的 | 通常比 RTX 2XXX 更快 |

| 視窗/Linux | 英偉達 RTX 2XXX | 4GB | 8GB | 必需的 | 通常比 GTX 1XXX 更快 |

| 視窗/Linux | 英偉達 GTX 1XXX | 8GB(* 6GB 不確定) | 8GB | 必需的 | 僅比 CPU 快點點 |

| 視窗/Linux | 英偉達 GTX 9XX | 8GB | 8GB | 必需的 | 比CPU更快或更慢 |

| 視窗/Linux | Nvidia GTX < 9XX | 不支援 | / | / | / |

| 視窗 | AMD顯示卡 | 8GB(2023 年 12 月 30 日更新) | 8GB | 必需的 | 透過 DirectML(* ROCm 處於保留狀態),比 Nvidia RTX 3XXX 慢約 3 倍 |

| Linux | AMD顯示卡 | 8GB | 8GB | 必需的 | 透過 ROCm,比 Nvidia RTX 3XXX 慢約 1.5 倍 |

| 蘋果 | M1/M2 MPS | 共享 | 共享 | 共享 | 比 Nvidia RTX 3XXX 慢約 9 倍 |

| Windows/Linux/Mac | 只使用CPU | 0GB | 32GB | 必需的 | 比 Nvidia RTX 3XXX 慢約 17 倍 |

* AMD GPU ROCm(暫停):AMD 仍在努力支援 Windows 上的 ROCm。

* Nvidia GTX 1XXX 6GB 不確定:有人報告 6GB 在 GTX 10XX 上成功,但也有人報告失敗案例。

請注意,Fooocus 僅適用於產生極高品質的影像。我們不會支持較小的模型來降低要求並犧牲結果品質。

請參閱此處的常見問題。

考慮到不同的目標,Fooocus的預設模型和配置是不同的:

| 任務 | 視窗 | Linux 參數 | 主要型號 | 精煉師 | 配置 |

|---|---|---|---|---|---|

| 一般的 | 運行.bat | juggernautXL_v8Rundiffusion | 未使用 | 這裡 | |

| 實際的 | 運行現實.bat | --預設現實 | 現實StockPhoto_v20 | 未使用 | 這裡 |

| 日本卡通 | 運行動畫.bat | --預設動畫 | animaPencilXL_v500 | 未使用 | 這裡 |

請注意,下載是自動的- 如果網路連線正常,您無需執行任何操作。但是,如果您(或從其他地方移動它們)有自己的準備,則可以手動下載它們。

除了在本機上運行之外,Fooocus 還可以透過兩種方式公開其 UI:

本機 UI 偵聽器:使用--listen (指定端口,例如使用--port 8888 )。

API 存取:使用--share (在.gradio.live註冊端點)。

預設情況下,這兩種方式的存取都是未經身份驗證的。您可以透過在主目錄中建立名為auth.json的檔案來新增基本驗證,該檔案包含帶有鍵user和pass JSON 物件清單(請參閱 auth-example.json 中的範例)。

基於GPT2的提示擴展為動態風格「Fooocus V2」。 (類似 Midjourney 的隱藏預處理和「原始」模式,或 LeonardoAI 的 Prompt Magic)。

本機精煉器在一個 k 採樣器內進行交換。優點是細化器模型現在可以重複使用從 k 採樣收集的基礎模型的動量(或 ODE 的歷史參數),以實現更一致的採樣。在Automatic1111的高解析度修復和ComfyUI的節點系統中,基礎模型和細化器使用兩個獨立的k採樣器,這意味著動量被大量浪費,並且採樣連續性被破壞。 Fooocus 使用自己先進的 k 擴散採樣,確保精煉機設定中的無縫、原生和連續交換。 (8月13日更新:實際上,幾天前我與Automatic1111討論過這個問題,似乎「單一k-sampler內的本機精煉器交換」已合併到webui的dev分支中。太棒了!)

ADM 負面指導。由於 XL Base 的最高解析度等級沒有交叉注意力,因此 XL 最高解析度等級的正負訊號在 CFG 取樣過程中無法獲得足夠的對比度,導致結果在某些情況下看起來有點塑膠或過於平滑。幸運的是,由於 XL 的最高解析度等級仍然以影像長寬比 (ADM) 為條件,因此我們可以在正/負側修改 ADM,以補償最高解析度等級中 CFG 對比度的不足。 (8月16日更新,IOS應用程式Draw Things將支援Negative ADM Guidance。太棒了!)

我們對「使用自註意力指導提高擴散模型的樣本品質」第 5.1 節進行了精心調整的變體。重量設定得非常低,但這是 Fooocus 的最終保證,以確保 XL 永遠不會產生過於光滑或塑膠的外觀(範例請參見此處)。這幾乎可以消除所有 XL 偶爾仍會產生過於平滑結果的情況,即使在 ADM 指導為負的情況下也是如此。 (2023 年 8 月 18 日更新,SAG 的高斯內核改為各向異性內核,以實現更好的結構保留和更少的偽影。)

我們稍微修改了樣式模板並添加了“電影預設”。

我們測試了“sd_xl_offset_example-lora_1.0.safetensors”,似乎當lora權重低於0.5時,結果總是比沒有lora的XL好。

採樣器的參數經過仔細調整。

由於 XL 使用位置編碼來產生分辨率,因此由多個固定分辨率生成的圖像看起來比任意分辨率生成的圖像要好一些(因為位置編碼不太擅長處理訓練期間看不到的 int 數字)。這表明 UI 中的解析度可能會被硬編碼以獲得最佳結果。

針對兩個不同文字編碼器的單獨提示似乎沒有必要。對基本模型和細化器的單獨提示可能有效,但效果是隨機的,我們不會實現這一點。

DPM 系列似乎非常適合 XL,因為 XL 有時會產生過於平滑的紋理,但 DPM 系列有時會產生過於密集的紋理細節。它們的聯合效應看起來是中性的,並且對人類的感知很有吸引力。

精心設計的系統,用於平衡多種風格並快速擴展。

使用automatic1111的方法規範提示強調。當使用者直接從 civitai 複製提示時,這會顯著改善結果。

精煉機的聯合交換系統現在也無縫支援img2img和upscale。

當 CFG 大於 10 時,CFG 比例和 TSNR 校正(針對 SDXL 進行調整)。

第一次執行 Fooocus 後,將在Fooocusconfig.txt產生一個設定檔。可以編輯此文件以更改模型路徑或預設參數。

例如,編輯後的Fooocusconfig.txt (該檔案將在首次啟動後產生)可能如下所示:

{“path_checkpoints”:“D:Fooocusmodelscheckpoints”,“path_loras”:“D:Fooocusmodelscheckpoints”,“path_loras”:“D:Fooocusmodelsloras”,“path_embeddings”:“D:Fooocusmodelsembeddings”,“path_vae_approx”: "D:Fooocusmodelsvae_approx", "path_upscale_models": "D:Fooocusmodelsupscale_models", "path_inpaint": "D:Fooocusmodelsinpaint", "path_controlnet": "D:Fooocusmodelsinpaint", "path_controlnet": "D:Fooocusmodelsinpaint", "path_controlnet": "D:Fooocusmodelsinpaint", "path_controlnet": "D:Fooocusmodelooocus modelscontrolnet", "path_clip_vision": "D:Fooocusmodelsclip_vision", "path_fooocus_expansion": "D:Fooocusmodelsprompt_expansionfooocus_expansion", "path_outputsmodelsprompt_expansionfooocus_expansion", "path_outputs"modus:D:Focoo" , "default_model": "realisticStockPhoto_v10.safetensors", "default_refiner": "", "default_loras": [["lora_filename_1.safetensors", 0.5], ["lora_filename_2.ssafetensors), 0. "default_sampler": "dpmpp_2m", "default_scheduler": "karras", "default_male_prompt": "低品質", "default_positive_prompt": "", "default_styles": [ "Fooocus V2", "Fooocus Photograph" 」

]

}許多其他金鑰、格式和範例都在Fooocusconfig_modification_tutorial.txt中(該檔案將在首次啟動後產生)。

在真正更改配置之前請三思。如果您發現自己破壞了東西,只需刪除Fooocusconfig.txt即可。 Fooocus 將恢復預設狀態。

更安全的方法是嘗試“run_anime.bat”或“run_realistic.bat” - 它們應該足以勝任不同的任務。

請注意, user_path_config.txt已棄用,並將很快刪除。 (編輯:它已經被刪除了。)

entry_with_update.py [-h] [--listen [IP]] [--port PORT] [--disable-header-check [ORIGIN]] [--web-upload-size WEB_UPLOAD_SIZE] [--hf-mirror HF_MIRROR] [--external-working-path PATH [PATH ...]] [--output-path OUTPUT_PATH] [--temp-path TEMP_PATH] [--cache-path CACHE_PATH] [--in-browser] [--disable-in-browser] [--gpu-device-id DEVICE_ID] [--async-cuda-allocation | --disable-async-cuda-allocation] [--disable-attention-upcast] [--all-in-fp32 | --all-in-fp16] [--unet-in-bf16 | --unet-in-fp16 | --unet-in-fp8-e4m3fn | --unet-in-fp8-e5m2] [--vae-in-fp16 | --vae-in-fp32 | --vae-in-bf16] [--vae-in-cpu] [--clip-in-fp8-e4m3fn | --clip-in-fp8-e5m2 | --clip-in-fp16 | --clip-in-fp32] [--directml [DIRECTML_DEVICE]] [--disable-ipex-hijack] [--preview-option [none,auto,fast,taesd]] [--attention-split | --attention-quad | --attention-pytorch] [--disable-xformers] [--always-gpu | --always-high-vram | --always-normal-vram | --always-low-vram | --always-no-vram | --always-cpu [CPU_NUM_THREADS]] [--always-offload-from-vram] [--pytorch-deterministic] [--disable-server-log] [--debug-mode] [--is-windows-embedded-python] [--disable-server-info] [--multi-user] [--share] [--preset PRESET] [--disable-preset-selection] [--language LANGUAGE] [--disable-offload-from-vram] [--theme THEME] [--disable-image-log] [--disable-analytics] [--disable-metadata] [--disable-preset-download] [--disable-enhance-output-sorting] [--enable-auto-describe-image] [--always-download-new-model] [--rebuild-hash-cache [CPU_NUM_THREADS]]

提示範例: __color__ flower

針對正面和負面提示進行處理。

從預先定義的選項清單中選擇隨機通配符,在本例中wildcards/color.txt檔案。通配符將被替換為隨機顏色(基於種子的隨機性)。您也可以Read wildcards in order複選框來停用隨機性並從上到下處理通配符檔案。

通配符可以嵌套和組合,並且可以在同一提示中使用多個通配符(範例請參閱wildcards/color_flower.txt )。

提示範例: [[red, green, blue]] flower

僅針對積極提示進行處理。

從左到右處理數組,為數組中的每個元素產生單獨的圖像。在這種情況下,將產生 3 個圖像,每種顏色一個。將影像數量增加到 3 以產生所有 3 個變體。

數組不能嵌套,但在同一個提示中可以使用多個數組。支援內聯 LoRA 作為數組元素!

提示範例: flower <lora:sunflowers:1.2>

僅針對積極提示進行處理。

將 LoRA 應用於提示。 LoRA 檔案必須位於models/loras目錄中。

按一下此處瀏覽進階功能。

以下是一些 Fork 到 Fooocus 的內容:

| 福克斯的叉子 |

|---|

| 分內石/Fooocus-Control runew0lf/毀壞的Fooocus MoonRide303/Fooocus-MRE 米特蔡/SimpleSDXL mashb1t/Fooocus 等等 ... |

非常感謝 twri、3Diva 和 Marc K3nt3L 創建了 Fooocus 中提供的其他 SDXL 樣式。

專案從 Stable Diffusion WebUI 和 ComfyUI 程式碼庫的混合開始。

另外,感謝 daswer123 貢獻 Canvas Zoom!

日誌在這裡。

您可以將 json 檔案放在language資料夾中來翻譯使用者介面。

例如,以下是Fooocus/language/example.json的內容:

{ "Generate": "生成", "Input Image": "入力畫像", "Advanced": "고급", "SAI 3D Model": "SAI 3D Modèle"}如果新增--language example arg,Fooocus 將讀取Fooocus/language/example.json來翻譯 UI。

例如,您可以將 Windows run.bat的結束行編輯為

.python_embededpython.exe -s Fooocusentry_with_update.py --language example

或run_anime.bat作為

.python_embededpython.exe -s Fooocusentry_with_update.py --language example --preset anime

或run_realistic.bat作為

.python_embededpython.exe -s Fooocusentry_with_update.py --language example --preset realistic

對於實際翻譯,您可以建立自己的文件,例如Fooocus/language/jp.json或Fooocus/language/cn.json ,然後使用標誌--language jp或--language cn 。顯然,這些文件現在不存在。我們需要您的幫助來創建這些文件!

請注意,如果沒有給出--language且同時Fooocus/language/default.json存在,則 Fooocus 將始終載入Fooocus/language/default.json進行翻譯。預設情況下, Fooocus/language/default.json檔案不存在。