林寧·徐·瓦蘇·阿格拉瓦爾·威廉·萊尼·托尼·加西亞·阿尤什·班薩爾

Changil Kim ·塞繆爾·羅塔·布羅·洛倫佐·波爾齊·彼得·康奇德

阿爾賈茲·博日奇·林大華· 邁克爾·佐爾霍費爾·克里斯蒂安·理查特

ACM SIGGRAPH 亞洲 2023

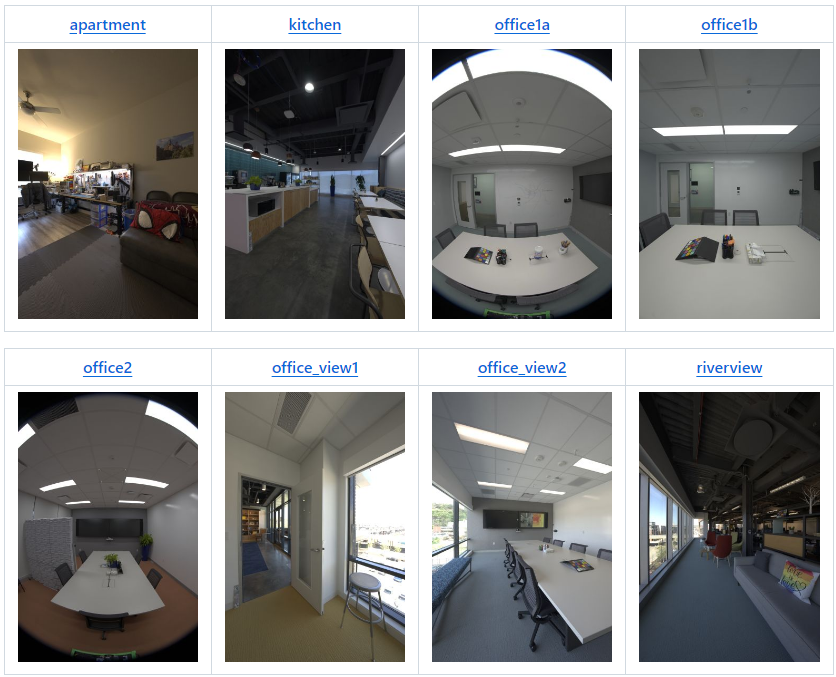

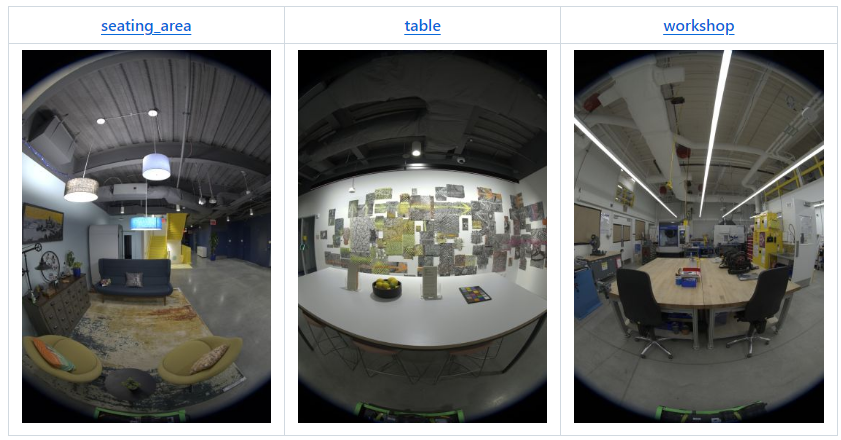

| 場景 | 版本 | 網路攝影機 | 位置 | 影像 | 2K EXR | 1K EXR | 8K+ JPEG | 4K JPEG | 2K JPEG | 1K JPEG |

|---|---|---|---|---|---|---|---|---|---|---|

| 公寓 | v2 | 22 | 180 | 3,960 人 | 123GB | 31GB | 92GB | 20GB | 5GB | 1.2GB |

| 廚房 | v2* | 19 | 318 | 6,024 | 190GB | 48GB | 142GB | 29GB | 8GB | 1.9GB |

| 辦公室1a | v1 | 9 | 85 | 第765章 | 24GB | 6GB | 15GB | 3GB | 1GB | 0.2GB |

| 辦公室1b | v2 | 22 | 71 | 1,562 人 | 49GB | 13GB | 35GB | 7GB | 2GB | 0.4GB |

| 辦公室2 | v1 | 9 | 233 | 2,097 人 | 66GB | 17GB | 46GB | 9GB | 2GB | 0.5GB |

| 辦公室視圖1 | v2 | 22 | 126 | 2,772 | 87GB | 22GB | 63GB | 14GB | 4GB | 0.8GB |

| 辦公室視圖2 | v2 | 22 | 67 | 1,474 | 47GB | 12GB | 34GB | 7GB | 2GB | 0.5GB |

| 河景 | v2 | 22 | 48 | 1,008 | 34GB | 8GB | 24GB | 5GB | 2GB | 0.4GB |

| 座位區 | v1 | 9 | 168 | 1,512 人 | 48GB | 12GB | 36GB | 8GB | 2GB | 0.5GB |

| 桌子 | v1 | 9 | 134 | 1,206 人 | 38GB | 9GB | 26GB | 6GB | 2GB | 0.4GB |

| 工作坊 | v1 | 9 | 700 | 6,300 | 198GB | 50GB | 123GB | 27GB | 8GB | 2.1GB |

| raf_空房間 | v2 | 22 | 365 | 8,030 | 252GB | 63GB | 213GB | 45GB | 12GB | 2.5GB |

| raf_furnishedroom | v2 | 22 | 154 | 3,388 | 106GB | 27GB | 90GB | 19GB | 5GB | 1.1GB |

| 全部的 | 1,262GB | 318GB | 939 GB | 199GB | 54GB | 12.5GB |

* v2比標準配置少了3個攝像頭,即只有19個攝像頭。

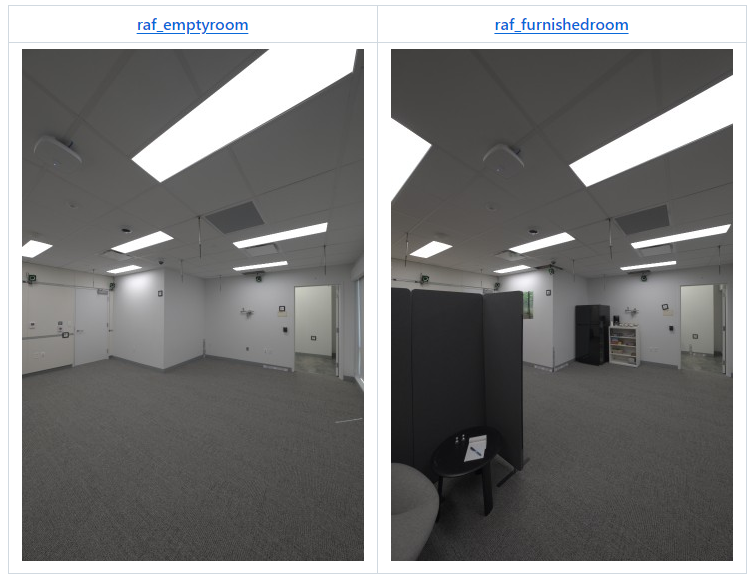

2024 年 4 月:我們的論文「真實聲場」(CVPR 2024) 附帶以下兩個場景:

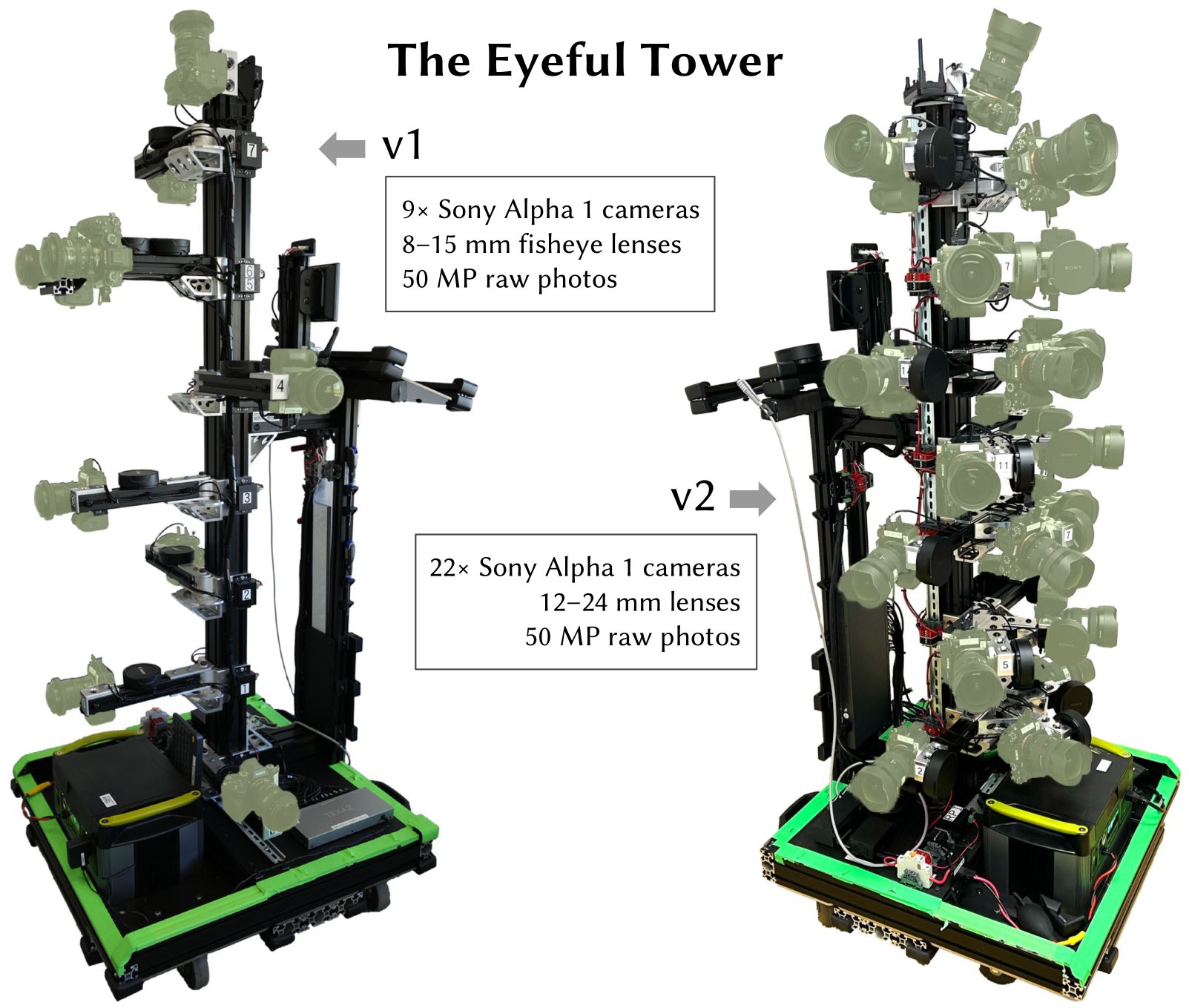

資料集中的所有影像均使用 Eyeful Tower v1 或 v2 拍攝(如概覽表中指定)。 Eyeful Tower v1 由 9 個魚眼攝影機組成,而 Eyeful Tower v2 由 22 個針孔攝影機組成(19 個用於「廚房」)。

Eyeful Tower 資料集託管在 AWS S3 上,可使用任何瀏覽器瀏覽,也可以使用 wget 或 curl 等標準軟體下載。

但是,為了實現最快、最可靠的下載,我們建議使用 AWS 命令列介面 (AWS CLI),請參閱 AWS CLI 安裝說明。

可選:透過將並發下載數量從 10 增加到 100 來加快下載速度:

aws configure set default.s3.max_concurrent_requests 100

aws s3 cp --recursive --no-sign-request s3://fb-baas-f32eacb9-8abb-11eb-b2b8-4857dd089e15/EyefulTower/apartment/images-jpeg-1k/ apartment/images-jpeg-1k/

或者,使用「 sync 」來避免傳輸現有檔案:

aws s3 sync --no-sign-request s3://fb-baas-f32eacb9-8abb-11eb-b2b8-4857dd089e15/EyefulTower/apartment/images-jpeg-1k/ apartment/images-jpeg-1k/

對於有興趣嘗試特定相機的人,我們建議先觀看拼貼影片。這將幫助您確定要使用哪些相機視圖。例如,對於使用 v2 捕捉裝置的公寓場景,您可以考慮將 ID 為 19、20、21 的攝影機放置在相同高度。

對於公寓廚房office1a、office1b、office2、office_view1、office_view2、河景座位區、桌子車間的資料集;做 mkdir -p $dataset/images-jpeg-1k; aws s3 cp --recursive --no-sign-request s3://fb-baas-f32eacb9-8abb-11eb-b2b8-4857dd089e15/EyefulTower/$dataset/images-jpeg-1k/ $dataset/images-jpeg-1k /;完畢

aws s3 sync --no-sign-request s3://fb-baas-f32eacb9-8abb-11eb-b2b8-4857dd089e15/EyefulTower/ .

每個場景都按照以下結構進行組織:

apartment │ ├── apartment-final.pdf # Metashape reconstruction report ├── cameras.json # Camera poses in KRT format (see below) ├── cameras.xml # Camera poses exported from Metashape ├── colmap # COLMAP reconstruction exported from Metashape │ ├── images # Undistorted images (full resolution) │ ├── images_2 # Undistorted images (1/2 resolution) │ ├── images_4 # Undistorted images (1/4 resolution) │ ├── images_8 # Undistorted images (1/8 resolution) │ └── sparse # COLMAP reconstruction (for full-res images) ├── images-1k # HDR images at 1K resolution │ ├── 10 # First camera (bottom-most camera) │ │ ├── 10_DSC0001.exr # First image │ │ ├── 10_DSC0010.exr # Second image │ │ ├── [...] # More images │ │ └── 10_DSC1666.exr # Last image │ ├── 11 # Second camera │ │ ├── 11_DSC0001.exr │ │ ├── 11_DSC0010.exr │ │ ├── [...] │ │ └── 11_DSC1666.exr │ ├── [...] # More cameras │ └── 31 # Last camera (top of tower) │ ├── 31_DSC0001.exr │ ├── 31_DSC0010.exr │ ├── [...] │ └── 31_DSC1666.exr ├── images-2k [...] # HDR images at 2K resolution ├── images-jpeg [...] # Full-resolution JPEG images ├── images-jpeg-1k [...] # JPEG images at 1K resolution ├── images-jpeg-2k # JPEG images at 2K resolution │ ├── [10 ... 31] │ ├── [10 ... 31].mp4 # Camera visualization │ └── collage.mp4 # Collage of all cameras ├── images-jpeg-4k [...] # JPEG images at 4K resolution ├── mesh.jpg # Mesh texture (16K×16K) ├── mesh.mtl # Mesh material file ├── mesh.obj # Mesh in OBJ format └── splits.json # Training/testing splits

images-1k/{camera}/*.exr和images-2k/{camera}/*.exr )由 9 張照片原始曝光包圍合併而成的高動態範圍影像。

下取樣至“1K”(684×1024 像素)或“2K”解析度(1368×2048 像素)。

色彩空間:DCI-P3(線性)

儲存為具有未壓縮的 32 位元浮點數的 EXR 影像。

所有影像檔案名稱均以相機名稱為前綴,例如17_DSC0316.exr 。

檔案名稱以相同數字結尾的影像會同時拍攝。

一些影像可能會遺失,例如由於影像模糊或顯示捕獲操作員的影像被刪除。

import os, cv2, numpy as np# 在 OpenCV 中啟用 OpenEXR 支援 (https://github.com/opencv/opencv/issues/21326)。 # 這個環境變數需要在開啟第一個 EXR 圖片之前定義。 "OPENCV_IO_ENABLE_OPENEXR"] = "1"# 使用OpenCV 讀取EXR 映像.img = cv2.imread("apartment/images-2k/17/17_DSC0316.exr", cv2.IMREAD_UNCHANGED)# 應用白平衡縮放 (cv BGR 顏色).coeffs = np.array([0.726097, 1.0, 1.741252]) # 公寓[RGB]img = np.einsum("ijk,k->ijk", img, coeffs[::-1] )# 使用# sRGB 的色調圖curve.linear_part = 12.92 * imgexp_part = 1.055 * (np.maximum(img, 0.0) ** (1 / 2.4)) - 0.055img = np.where(img <= 0.0031330產生的圖像寫入JPEG.img = np.clip(255 * img, 0.0, 255.0).astype(np.uint8)cv2.imwrite("apartment-17_DSC0316.jpg", img, params=[cv2.IMWRALITY ] )images-jpeg*/{camera}/*.jpg )我們提供四種解析度等級的 JPEG 影像:

images-jpeg/ : 5784 × 8660 = 50. 百萬像素 — 完整的原始影像分辨率

images-jpeg-4k/ :2736 × 4096 = 11.2 百萬像素

images-jpeg-2k/ :1368 × 2048 = 2.8 百萬像素

images-jpeg-1k/ :684 × 1024 = 0.7 百萬像素

JPEG 影像是 HDR 影像的白平衡和色調映射版本。詳細資訊請參閱上面的程式碼。

每個場景都使用源自 ColorChecker 的白平衡設置,它單獨縮放 RGB 通道,如下所示:

| 場景 | RGB 比例因子 |

|---|---|

| 公寓 | 0.726097, 1.0, 1.741252 |

| 廚房 | 0.628143, 1.0, 2.212346 |

| 辦公室1a | 0.740846, 1.0, 1.750224 |

| 辦公室1b | 0.725535, 1.0, 1.839938 |

| 辦公室2 | 0.707729, 1.0, 1.747833 |

| 辦公室視圖1 | 1.029089, 1.0, 1.145235 |

| 辦公室視圖2 | 0.939620, 1.0, 1.273549 |

| 河景 | 1.077719, 1.0, 1.145992 |

| 座位區 | 0.616093, 1.0, 2.426888 |

| 桌子 | 0.653298, 1.0, 2.139514 |

| 工作坊 | 0.709929, 1.0, 1.797705 |

| raf_空房間 | 0.718776, 1.0, 1.787020 |

| raf_furnishedroom | 0.721494, 1.0, 1.793423 |

cameras.json )此 JSON 檔案具有基本結構{"KRT": [<one object per image>]} ,其中每個影像物件具有以下屬性:

width : 影像寬度,以像素為單位(通常為 5784)

height :影像高度,以像素為單位(通常為8660)

cameraId :該圖片的檔案名稱元件(例如"0/0_REN0001" );若要取得完整路徑,請使用"{scene}/{imageFormat}/{cameraId}.{extension}" :

scene :11 個場景名稱中的任一個,

imageFormat : "images-2k" 、 "images-jpeg-2k" 、 "images-jpeg-4k"或"images-jpeg"之一

副檔extension :檔案副檔名,JPEG 為jpg ,EXR 影像 (HDR) 為exr

K :全解析度影像的 3×3 內在相機矩陣(列主)

T :4×4世界到相機的變換矩陣(列主)

distortionModel :使用的鏡頭畸變模型:

魚眼影像的"Fisheye" (Eyeful v1)

針孔影像的"RadialAndTangential" (Eyeful v2)

distortion :與 OpenCV 的cv2.undistort函數一起使用的鏡頭畸變係數

註:投影模型是理想(等距)魚眼模型。

魚眼影像 (Eyeful v1): [k1, k2, k3, _, _, _, p1, p2]

針孔影像(Eyeful v2): [k1, k2, p1, p2, k3] (與cv2.undistort順序相同)

frameId :擷取期間的位置索引(連續整數)

所有同時拍攝的影像共享相同的frameId

sensorId :此影像的 Metashape 感光元件 ID(又稱相機)

同一相機拍攝的所有影像共用相同的sensorId

cameraMasterId (可選):此位置/幀的主相機(在裝備校準中)的 Metashape 相機 ID

所有同時拍攝的影像共享相同的cameraMasterId

sensorMasterId (選購):配備校準中主相機的 Metashape 感光元件 ID

除主相機外的所有相機應具有相同的值(通常對於 Eyeful v1 為"6" ,對於 Eyeful v2 為"13" )。

世界座標系:右手,y向上, y=0為地平面,單位為公尺。

cameras.xml )使用其專有的檔案格式直接從 Metashape 匯出相機校準資料。

mesh.* )OBJ 格式的紋理網格,從 Metashape 匯出並根據全解析度 JPEG 影像建立。

世界座標系:右手,y向上, y=0為地平面,單位為公尺。

colmap/ )這些 COLMAP 重建是使用 Metashape 2.1.3 和預設參數從我們的原始重建中導出的。

colmap/images下的影像從images-jpeg中的影像自動不失真到主點位於影像中心的針孔投影。

請注意,這種不失真會嚴重裁切魚眼影像,並且往往會為不同的相機產生不同的影像尺寸。

colmap/images-*中的影像是全解析度未失真影像的下取樣版本,類似於 Mip-NeRF 360 資料集格式。

splits.json )包含用於訓練( "train" )和測試( "test" )的圖像清單。

保留一台相機的所有影像進行測試:相機5用於 Eyeful v1,相機17用於 Eyeful v2。

2023 年 11 月 3 日– 初始資料集發布

2024 年 1 月 18 日– 新增了「1K」解析度(684×1024 像素)EXR 和 JPEG 用於小規模實驗。

2024 年 4 月 19 日– 從真實聲場 (RAF) 資料集中新增了兩個房間: raf_emptyroom和raf_furnishedroom 。

2024 年 10 月 9 日– 新增了匯出的 COLMAP 重建,其中包含 Mip-NeRF 360 格式的未失真影像,例如與 gsplat 相容。

如果您使用此資料集中的任何資料或此儲存庫中發布的任何程式碼,請引用 VR-NeRF 論文。

@InProceedings{VRNeRF,作者 = {Linning Xu 和 Vasu Agrawal 和 William Laney 和 Tony Garcia 和 Aayush Bansal 和 Changil Kim 和 Rota Bulò、Samuel 和 Lorenzo Porzi 和 Peter Kontschieder 和 Aljaž Božič 和 Dahua Lin 和 Michael Zollhöfer 和 Peter Kontschieder 和 Aljaž Božič 和 Dahua Lin 和 Michael Zollhöfer 和 Peter Kontschieder 和 Aljaž Božič 和 Dahua Lin 和 Michael Zollhöfer 和 Peter Kontschieder 和 Aljaž Božič 和 Dahua Lin 和 Michael Zollhöfer 和 Peter Kontschieder 和 Aljaž Božič 和 Dahua Lin 和 Michael Zollhöfer 和 Peter Kontschieder 和 Aljaž Božič 和 Dahua Lin 和 Michael Zollhöfer 和 Peter Kontschieder 和 Aljaž Božič 和 Dahua Lin 和 Michael Zollhöfer 和 Peter Kontschieder 和 Aljaž Božič 和 Dahua Lin 和 Michael Zollhöfer 和 Peter Kontschieder),標題= {{VR-NeRF}:高保真虛擬化步行空間},書名= {SIGGRAPH 亞洲會議論文集},年份= {2023},doi = {10.1145/3610548.3618139},url = {https://vr -nerf .github.io},

}知識共享署名-非商業性 (CC BY-NC) 4.0,如授權文件所示。

[使用條款] [隱私權政策]