李凱1 , 桑文迪1 , 曾昌2 , 楊潤軒1 , 郭晨1 , 胡曉琳1

1清華大學,中國

2日本國立資訊研究所

紙|示範

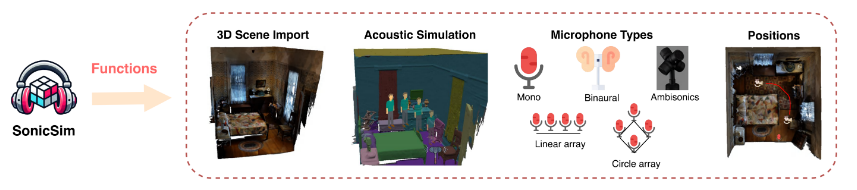

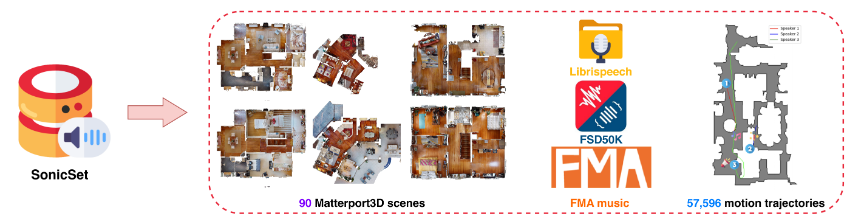

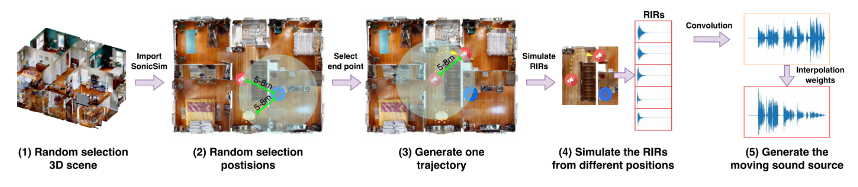

我們推出 SonicSim,這是一個綜合工具包,旨在為行動聲源產生高度可自訂的資料。 SonicSim基於實體AI模擬平台Habitat-sim開發,支援場景級、麥克風級、音源級等多層參數調整,進而產生更多樣化的合成資料。利用 SonicSim,我們使用 LibriSpeech 資料集、Freesound Dataset 50k (FSD50K) 和 Free Music Archive (FMA) 以及 Matterport3D 中的 90 個場景建立了行動聲源基準資料集 SonicSet,以評估語音分離和增強模型。

[2024-10-30] 我們修正了安裝環境的錯誤,並更新了 SonicSet 資料集上語音分離和增強模型的訓練程式碼。

[2024-10-23] 我們發布了 SonicSet 資料集上語音分離和增強模型的training code 。

[2024-10-03] 我們在arxiv上發布了論文

[2024-10-01] 我們發布了真實世界語音分離資料集,旨在評估真實場景中語音分離模型的效能。

[2024-07-31] 我們發布了SonicSim dataset ,其中包括語音分離和增強任務。

[2024-07-24] 我們發布了用於dataset construction的腳本以及用於speech separation and enhancement的預訓練模型。

3D 場景導入:支援從 Matterport3D 等資料集中導入各種 3D 資產,從而能夠高效且可擴展地產生複雜的聲學環境。

聲環境模擬:

使用室內聲學建模和雙向路徑追蹤演算法來模擬房間幾何形狀內的聲音反射。

將 3D 場景的語意標籤對應到材質屬性,設定表面的吸收、散射和透射係數。

根據來源路徑合成移動聲源數據,確保對現實條件的高保真度。

麥克風配置:提供多種麥克風設置,包括單聲道、雙耳和高保真度立體聲響複製,並支援自訂線性和圓形麥克風陣列。

來源和麥克風定位:提供聲音來源和麥克風位置的定製或隨機化。支援移動聲源模擬的運動軌跡,為動態聲學場景增添真實感。

您可以從以下連結下載預先建置的資料集:

| 資料集名稱 | Onedrive | 百度網盤 |

|---|---|---|

| train資料夾(40個分割rar文件,377G) | [下載連結] | [下載連結] |

| val.rar (4.9G) | [下載連結] | [下載連結] |

| 測試.rar(2.2G) | [下載連結] | [下載連結] |

| 9月基準數據(8.57G) | [下載連結] | [下載連結] |

| enh-基準數據(7.70G) | [下載連結] | [下載連結] |

| 資料集名稱 | Onedrive | 百度網盤 |

|---|---|---|

| 真實世界資料集(1.0G) | [下載連結] | [下載連結] |

RealMAN 資料集:RealMAN

若要自行建立資料集,請參閱SonicSim-SonicSet/data-script資料夾中的 README。本文檔提供了有關如何使用提供的腳本產生資料集的詳細說明。

若要設定訓練和推理環境,請使用提供的 YAML 檔案:

conda 創建-n SonicSim-Train python=3.10 conda 啟動 SonicSim-Train pip 安裝 Cython==3.0.10 numpy==1.26.4 pip install torch==2.0.1 torchvision==0.15.2 torchaudio==2.0.2 --index-url https://download.pytorch.org/whl/cu118 pip install -r requests.txt -i https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple

導航至separation目錄並執行以下腳本以產生固定驗證集:

CD分離 pythongenerate_fixed_validation.py --raw_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val --save_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val-sep-2 --is_mono pythongenerate_fixed_test.py --raw_dir=/home/pod/SonicSim/SonicSim/SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/test --is_mono

導航至enhancement目錄並執行以下腳本以產生固定驗證集:

光碟增強 pythongenerate_fixed_validation.py --raw_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val --save_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val-enh-no-val-en pythongenerate_fixed_test.py --raw_dir=/home/pod/SonicSim/SonicSim/SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/test --is_mono

導航至separation目錄並使用指定的設定檔執行訓練腳本:

CD分離 python train.py --conf_dir=configs/afrcnn.yaml

導航至enhancement目錄並使用指定的設定檔執行訓練腳本:

光碟增強 python train.py --conf_dir=config/dccrn.yaml

請檢查sep-checkpoints和enh-checkpoints資料夾中README.md的內容,在Release中下載對應的預訓練模型並將其解壓縮到對應的資料夾中。

導航至separation目錄並使用指定的設定檔執行推理腳本:

CD分離 python inference.py --conf_dir=../sep-checkpoints/TFGNet-Noise/config.yaml

導航至enhancement目錄並使用指定的設定檔運行推理腳本:

光碟增強 python inference.py --conf_dir=../enh-checkpoints/TaylorSENet-Noise/config.yaml

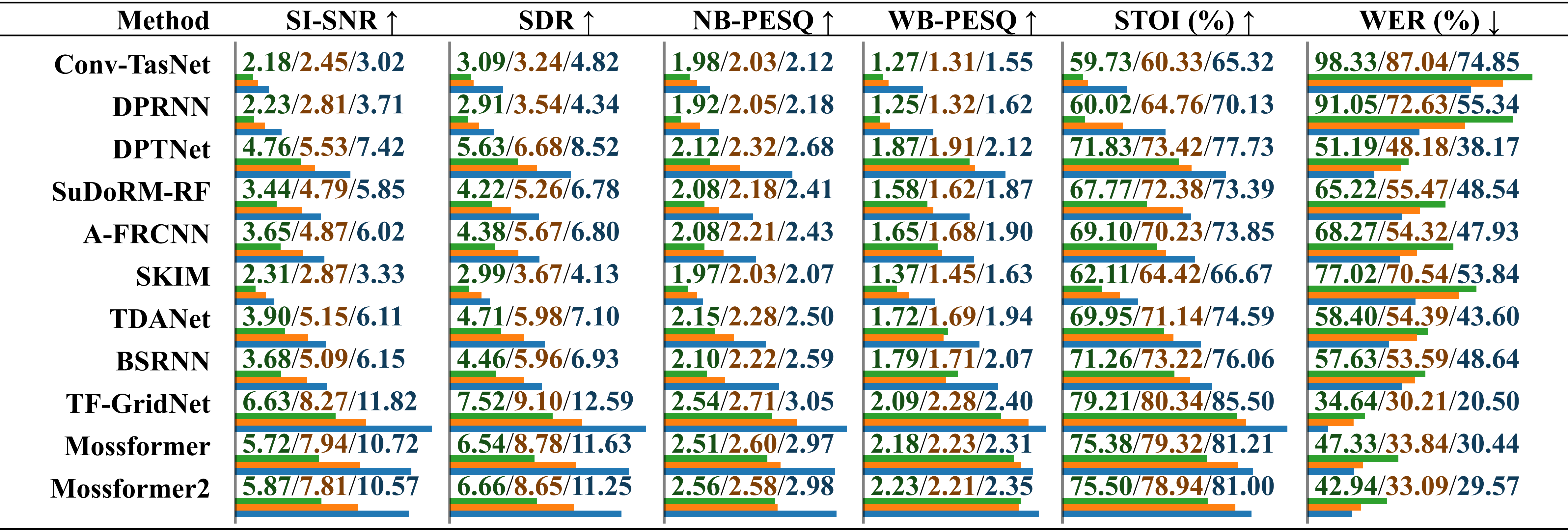

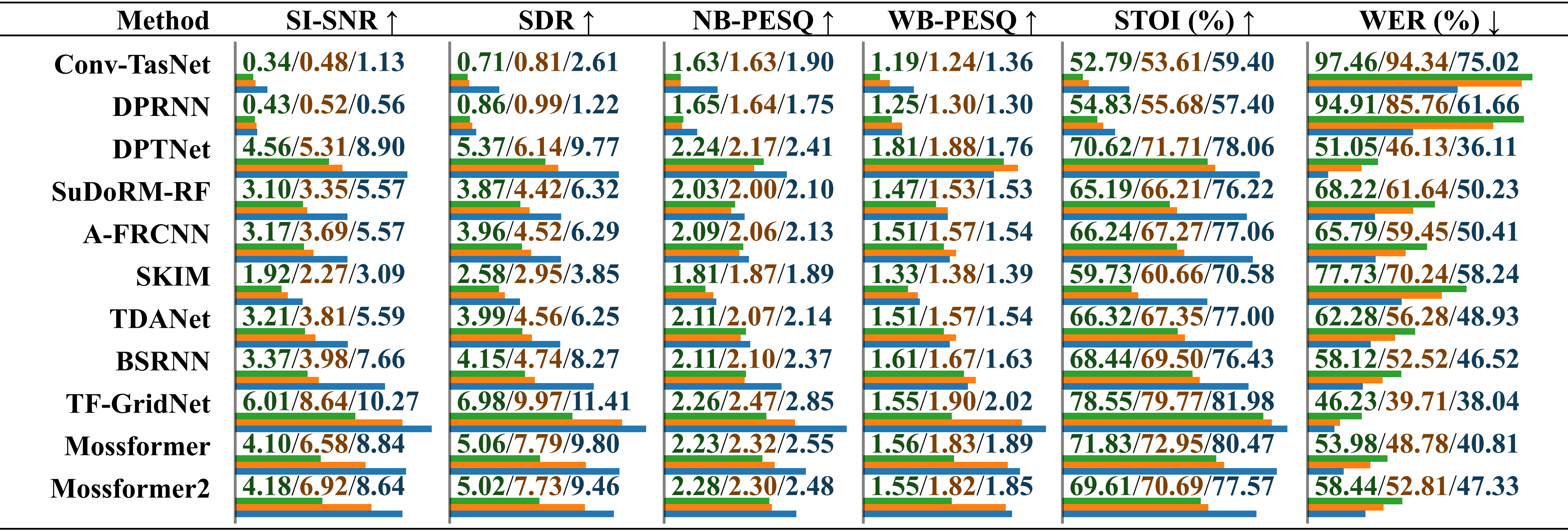

使用真實錄製的音訊和環境雜訊在不同資料集上訓練的模型的比較效能評估。分別報告「在 LRS2-2Mix 上訓練」、「在 Libri2Mix 上訓練」和「在 SonicSet 上訓練」的結果,並以斜線區分。相對長度在數值下方以水平條表示。

使用真實錄製的音訊和音樂雜訊在不同資料集上訓練的模型的比較效能評估。分別報告「在 LRS2-2Mix 上訓練」、「在 Libri2Mix 上訓練」和「在 SonicSet 上訓練」的結果,並以斜線區分。

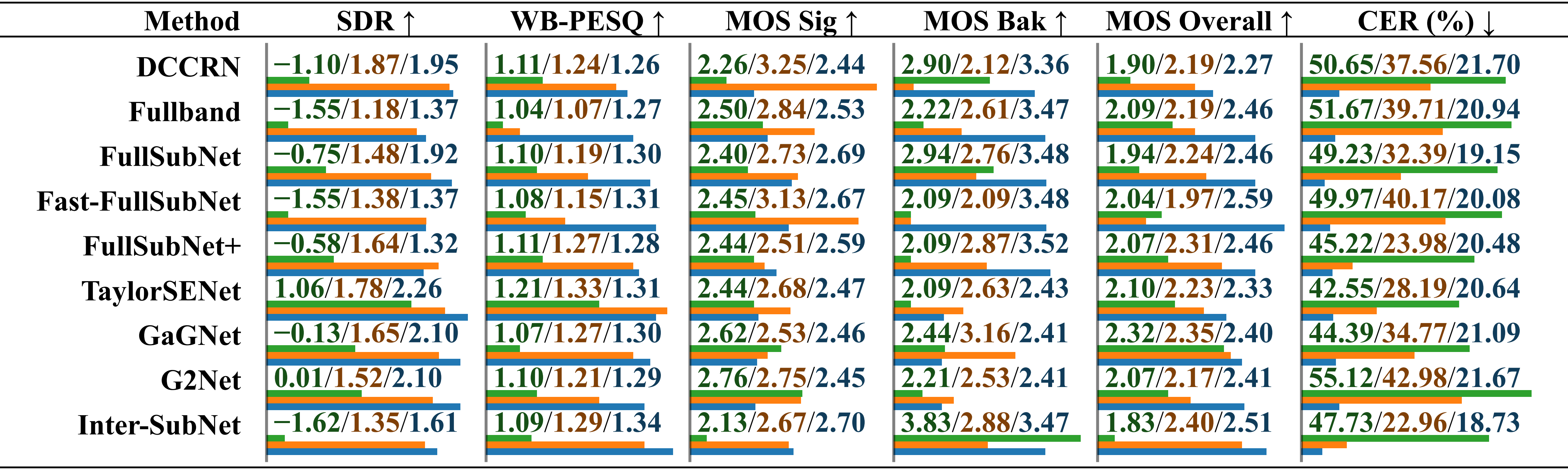

使用 RealMAN 資料集在不同資料集上訓練的模型的比較效能評估。分別報告「在 VoiceBank+DEMAND 上訓練」、「在 DNS Challenge 上訓練」和「在 SonicSet 上訓練」的結果,並以斜線區分。

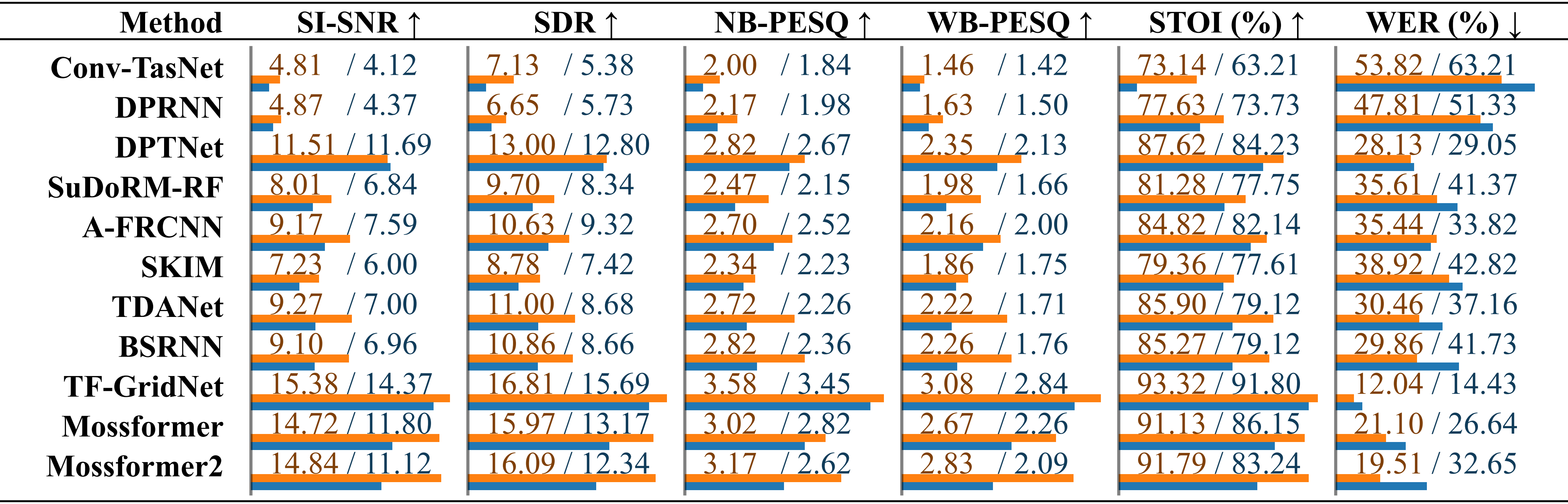

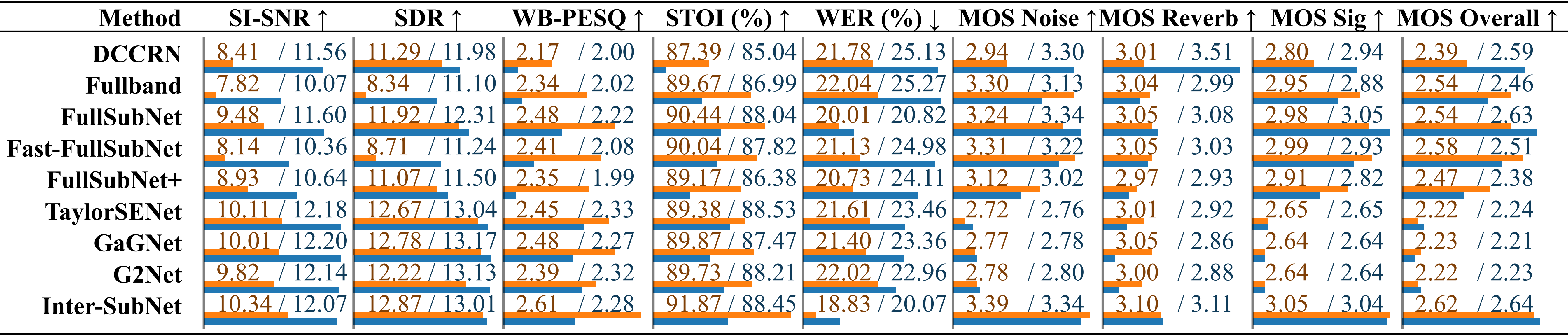

我們在 SonicSet 資料集上訓練了分離和增強模型。結果如下:

SonicSet 資料集上現有語音分離方法的比較。每個模型的表現分別列出在「環境噪音」和「音樂噪音」下的結果,並以斜槓區分。

現有語音增強方法的比較使用SonicSet測試集的語音增強方法的比較。這些指標分別列在「環境噪音」和「音樂噪音」下,並以斜槓區分。

我們謹向以下人士表達感謝:

LibriSpeech 用來提供語音資料。

SoundSpaces 用於模擬環境。

Apple 提供動態音訊合成腳本。

本作品根據 Creative Commons Attribution-ShareAlike 4.0 International License 授權。