ShareGPT4V:透過更好的字幕來改進大型多模態模型

ShareGPT4V:透過更好的字幕來改進大型多模態模型⭐️我們的系列作品: [ MMStar ][ ShareGPT4Video ][ ShareGPT4Omni ]

???在 ECCV 2024 中正式實施ShareGPT4V:透過更好的字幕來改善大型多模態模型。

作者:陳林*、李勁松*、董曉義、張潘、何從輝、王嘉琪、趙峰?、林大華?

院校:中國科技大學;上海人工智慧實驗室

資源:[論文][專案頁][  分享GPT4V數據集]

分享GPT4V數據集]

型號:[ShareGPT4V-7B] [ShareCaptioner]

分享GPT4V-7B 示範[OpenXLab] [?HuggingFace] [Colab]

共享字幕示範[OpenXlab] [?HuggingFace]

?大規模的高度描述性的圖像文字資料集

? 100K GPT4-Vision 產生的字幕, 1.2M高品質字幕

?通用影像字幕產生器,接近 GPT4-Vision 的字幕功能。

?卓越的大型多模式模型, ShareGPT4V-7B

[2024/7/2]很高興地宣布ShareGPT4V被ECCV 2024接受!

[2024/5/8]我們發布了大規模視訊字幕資料集ShareGPT4Video ,其中包含由 GPT4V 標註的40K字幕和由我們的 ShareCaptioner-Video 標註的480 萬字幕。影片總時長分別為300小時和3000小時!

[2024/4/1]我們發布了精英視覺不可或缺的多模態基準測試MMStar。玩得開心!

[2023/12/14]我們發表了ShareGPT4V-13B模型。玩得開心!

[2023/12/13]提供訓練和評估代碼。

[2023/12/13]本地ShareCaptioner現已上線!您可以透過直接執行tools/share-cap_batch_infer.py來利用它透過批次推理為資料集產生高品質的標題。

[2023/11/23]我們發佈了通用Share-Captioner的網頁簡報!

[2023/11/23]我們發布了建立 ShareGPT4V-7B 本地演示的程式碼!

[2023/11/22]網頁示範和檢查點現已可用! ?

[2023/11/21] ShareGPT4V資料集現已可用!

[2023/11/20]論文及專案頁面發佈!

ShareGPT4V-7B 的訓練與評估代碼

本地共享字幕

ShareGPT4V-7B 的網頁演示和本地演示

ShareGPT4V-7B 的檢查點

請參閱 ModelZoo.md 中的更多詳細資訊。

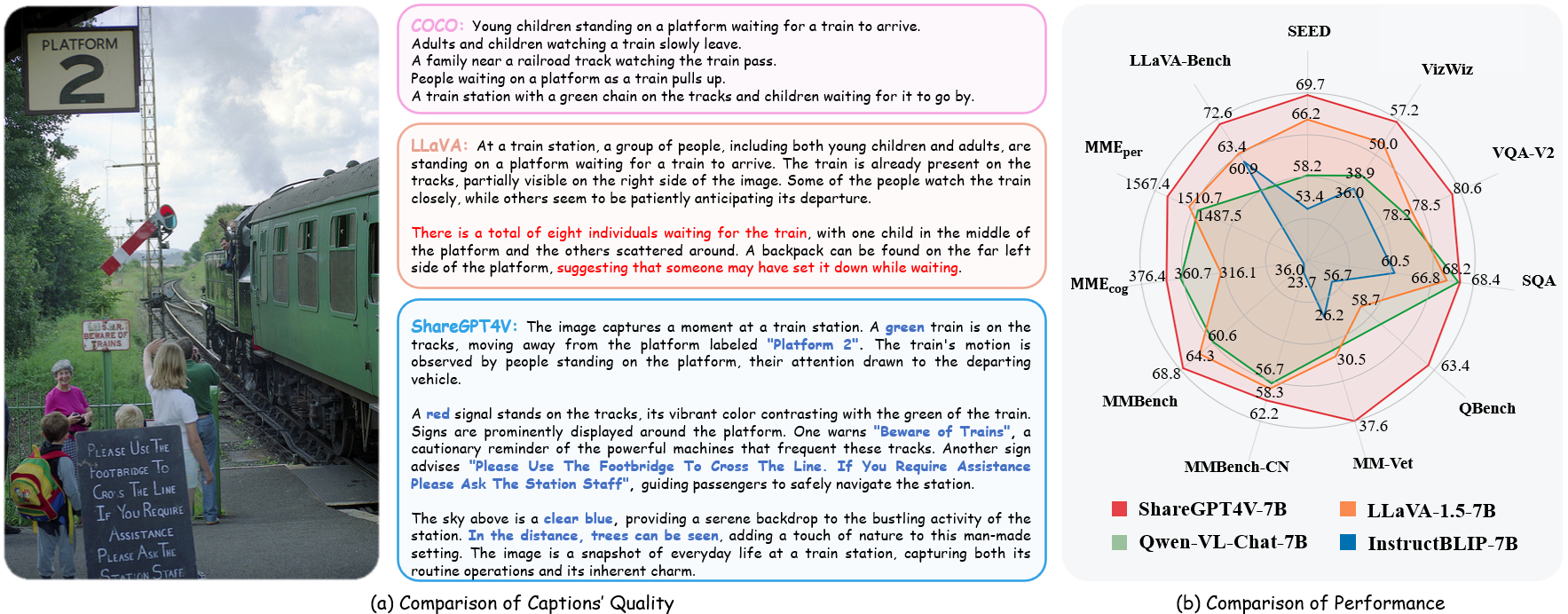

| 姓名 | 法學碩士 | 檢查站 | LLaVA-長凳-狂野 | MME感知 | MME認知 | MMBench | MMBench-CN | 種子影像 | MM-獸醫 | QBench | SQA-影像 | VQA-v2 | 維茲維茲 | 品質保證局 | 文字VQA |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 分享GPT4V-7B | 駱駝毛-7B | 分享GPT4V-7B | 72.6 | 1567.4 | 376.4 | 68.8 | 62.2 | 69.7 | 37.6 | 63.4 | 68.4 | 80.6 | 57.2 | 63.3 | 60.4 |

| 分享GPT4V-13B | 駱駝毛-13B | 分享GPT4V-13B | 79.9 | 1618.7 | 303.2 | 68.5 | 63.7 | 70.8 | 43.1 | 65.2 | 71.2 | 81.0 | 55.6 | 64.8 | 62.2 |

from share4v.model.builder import load_pretrained_modelfrom share4v.mm_utils import get_model_name_from_pathfrom share4v.eval.run_share4v import eval_modelmodel_path = "Linin-Chen/indald d_model( model_path=model_path, model_base=None, model_name=從路徑取得模型名稱(模型路徑) )

查看share4v/model/builder.py中load_pretrained_model函數的詳細資訊。

您也可以使用share4v/eval/run_llava.py中的eval_model函數輕鬆取得輸出。透過這樣做,您可以在下載此儲存庫後直接在 Colab 上使用此程式碼。

model_path = "Lin-Chen/ShareGPT4V-7B"prompt = "右側角色最常見的口號是什麼?"image_file = "examples/breaking_bad.png"args = type('Args', (), { " model_path」: model_path,“model_base”:無,“model_name”:get_model_name_from_path(model_path),“query”:提示,“conv_mode”:無,“image_file”:image_file,“sep”:“,”,“溫度”: 0,“溫度”: 0,“溫度”:“ top_p」:無,「num_beams」:1,「max_new_tokens」:512})()eval_model(args)git克隆 https://github.com/InternLM/InternLM-XComposer --深度=1cd專案/ShareGPT4V conda 創建-n share4v python=3.10 -y conda 啟動 share4v pip 安裝 --升級 pip pip install -e .pip install -e ".[train]"pip install flash-attn --no-build-isolation

您可以透過以下方式建立本機演示:

# run script python tools/app.py

您應該按照 Data.md 的說明來管理資料集。目前,我們提供對網路數據的直接下載存取。然而,為了避免潛在的爭議,我們計劃在不久的將來發布這些資料集的 URL,而不是原始資料。

ShareGPT4V 模型訓練由兩個階段組成:(1) 特徵對齊階段:使用我們的ShareGPT4V-PT 資料集和120 萬個ShareCaptioner 產生的高品質影像文字對來微調視覺編碼器、投影機和LLM,以對齊文本和文本。 (2)視覺指令調整階段:微調投影機和LLM以教導模型遵循多模態指令。

要在更少的 GPU 上進行訓練,您可以減少per_device_train_batch_size並相應地增加gradient_accumulation_steps 。始終保持全域批次大小相同: per_device_train_batch_size x gradient_accumulation_steps x num_gpus 。

我們在微調中使用一組與 ShareGPT4V-7B 類似的超參數。 下面提供了預訓練和微調中使用的兩個超參數。

預訓練

| 超參數 | 全域批量大小 | 學習率 | 紀元 | 最大長度 | 重量衰減 |

|---|---|---|---|---|---|

| 分享GPT4V-7B | 256 | 2e-5 | 1 | 2048 | 0 |

微調

| 超參數 | 全域批量大小 | 學習率 | 紀元 | 最大長度 | 重量衰減 |

|---|---|---|---|---|---|

| 分享GPT4V-7B | 128 | 2e-5 | 1 | 2048 | 0 |

首先,您應該下載 LLaVA-1.5 和 LAION-CC-SBU-558K 預先訓練的 MLP 投影機。因為在使用高品質的詳細標題進行模態對齊之前,粗略的模態對齊過程是有益的。

您可以執行projects/ShareGPT4V/scripts/sharegpt4v/slurm_pretrain_7b.sh來預訓練模型。請記住在腳本中指定投影機路徑。在這個階段,我們對視覺編碼器的後半部、投影機和LLM進行了微調。

在我們的設定中,我們使用了 16 個 A100 (80G) GPU,整個預訓練過程持續了大約 12 個小時。您可以調整梯度累積步數以減少 GPU 數量。

在此階段,我們使用 sharegpt4v_mix665k_cap23k_coco-ap9k_lcs3k_sam9k_div2k.json 微調投影機和 LLM。

您可以執行projects/ShareGPT4V/scripts/sharegpt4v/slurm_finetune_7b.sh來微調模型。

在我們的設定中,我們使用了 16 個 A100 (80G) GPU,整個預訓練過程持續了大約 7 個小時。您可以調整梯度累積步數以減少 GPU 數量。

為了確保可重複性,我們用貪婪解碼來評估模型。我們不評估使用波束搜尋使推理過程與即時輸出的聊天演示一致。

請參閱評估.md。

LLaVA:我們建立的程式碼庫。感謝他們的出色工作。

Vicuna:令人驚嘆的開源大型語言模式!

如果您發現我們的工作對您的研究有幫助,請考慮給予星⭐和引用?

@article{chen2023sharegpt4v,title={ShareGPT4V:用更好的字幕改進大型多模態模型},作者={Chen,Lin和Li,Jisong和Dong,Xiaoyi和Zhang,Pan和He,Conghui和Wang,Jiaqi和Zhao,馮和林,大華},期刊={arXiv預印本arXiv:2311.12793},年份={2023}}@article{chen2024sharegpt4video,標題={ShareGPT4Video:透過更好的字幕提高視頻理解和生成},作者={陳,林和魏、西林和李、勁松和董、小毅和張、潘和臧、餘航和陳、澤輝和段、浩東和林、斌和唐、振宇等},期刊={ arXiv預印本arXiv:2406.04325},年份={2024}}@article{chen2024we, title={我們是否走在評估大型視覺語言模型的正確道路上? 、小毅和張、潘和臧,太空和陳、澤慧和段、浩東和王、佳琪和喬、於和林、大華等},期刊={arXiv預印本arXiv:2403.20330},年份={2024}}使用和許可聲明:數據和檢查點僅供研究使用並獲得許可。它們也僅限於遵循 LLaMA、Vicuna 和 GPT-4 許可協議的使用。此資料集為 CC BY NC 4.0(僅允許非商業用途),使用此資料集訓練的模型不應在研究目的之外使用。