使用 AI 離線與您的文件聊天。沒有數據離開您的系統。只需要連接網路即可安裝工具並下載 AI 模型。它基於 PrivateGPT 但具有更多功能。

內容

chatdocs.yml進行高度配置| 擴大 | 格式 |

|---|---|

.csv | CSV |

.docx , .doc | Word文檔 |

.enex | 印象筆記 |

.eml | 電子郵件 |

.epub | 電子書 |

.html | 超文本標記語言 |

.md | 降價 |

.msg | 展望消息 |

.odt | 開啟文件文字 |

.pdf | 便攜式文件格式 (PDF) |

.pptx , .ppt | PowerPoint 文檔 |

.txt | 文字檔 (UTF-8) |

使用以下命令安裝該工具:

pip install chatdocs使用以下方式下載 AI 模型:

chatdocs download現在它可以在沒有網路連線的情況下離線運作。

新增包含要聊天的文件的目錄,使用:

chatdocs add /path/to/documents處理後的文檔預設存放在

db目錄下。

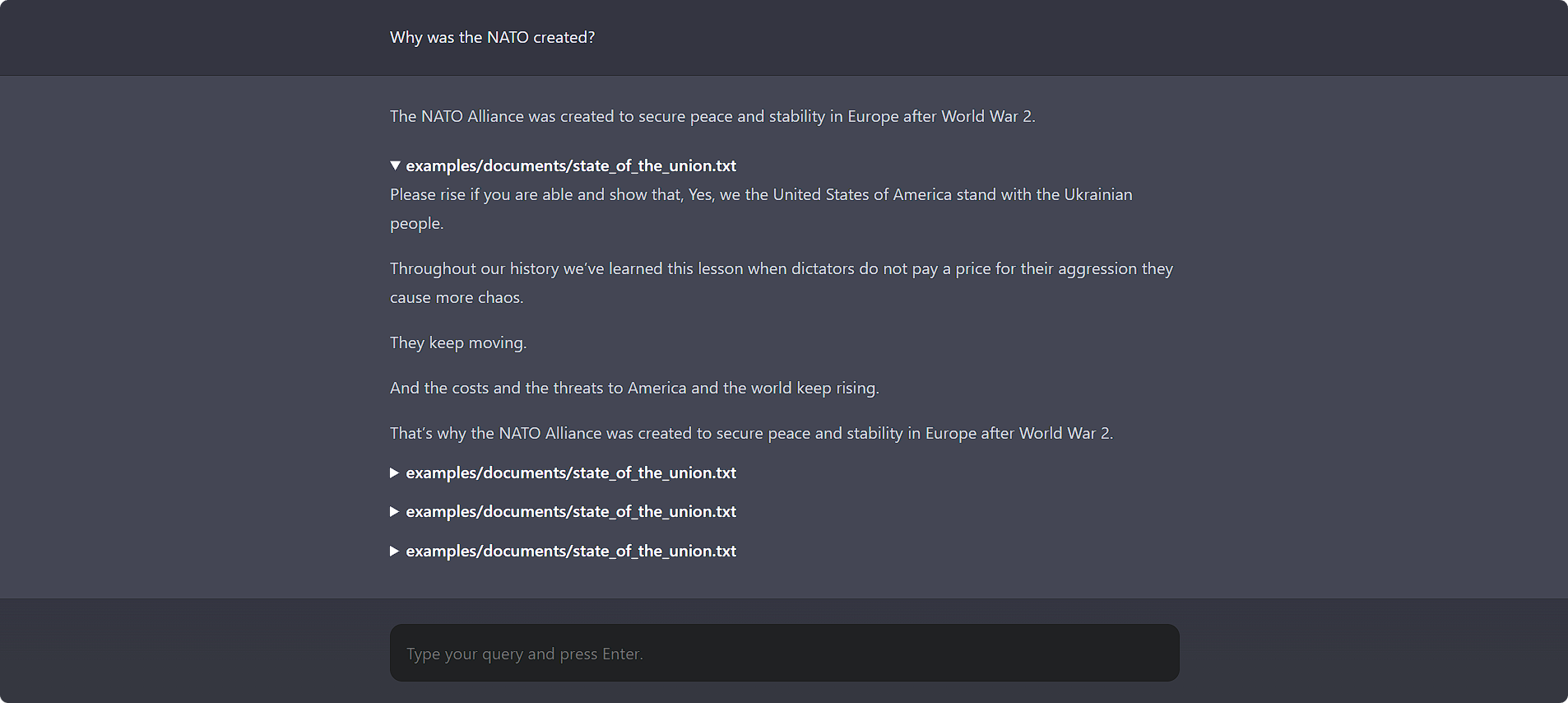

使用以下方式與您的文件聊天:

chatdocs ui在瀏覽器中開啟 http://localhost:5000 以存取 Web UI。

它還有一個漂亮的命令列介面:

chatdocs chat

所有設定選項都可以使用chatdocs.yml設定檔進行變更。在某個目錄中建立chatdocs.yml檔案並執行該目錄中的所有指令。有關參考,請參閱預設的chatdocs.yml檔案。

您不必複製整個文件,只需添加要更改的配置選項,因為它將與預設配置合併。例如,請參閱tests/fixtures/chatdocs.yml ,它僅變更一些設定選項。

若要變更嵌入模型,請在chatdocs.yml中新增並變更以下內容:

embeddings :

model : hkunlp/instructor-large注意:變更嵌入模型時,請刪除

db目錄並重新新增文件。

若要變更 CTransformers (GGML/GGUF) 模型,請在chatdocs.yml中新增並變更以下內容:

ctransformers :

model : TheBloke/Wizard-Vicuna-7B-Uncensored-GGML

model_file : Wizard-Vicuna-7B-Uncensored.ggmlv3.q4_0.bin

model_type : llama注意:首次新增模型時,請先執行

chatdocs download下載模型,然後再使用。

您也可以使用現有的本機模型檔案:

ctransformers :

model : /path/to/ggml-model.bin

model_type : llama使用? Transformers 模型,將以下內容加入您的chatdocs.yml :

llm : huggingface要改變? Transformers 模型,在chatdocs.yml中加入並更改以下內容:

huggingface :

model : TheBloke/Wizard-Vicuna-7B-Uncensored-HF注意:首次新增模型時,請先執行

chatdocs download下載模型,然後再使用。

要將 GPTQ 模型與 ? Transformer,使用以下命令安裝必要的軟體包:

pip install chatdocs[gptq]若要為嵌入模型啟用 GPU (CUDA) 支持,請將以下內容新增至您的chatdocs.yml :

embeddings :

model_kwargs :

device : cuda您可能需要按照此處的說明重新安裝啟用 CUDA 的 PyTorch。

若要啟用對 CTransformers (GGML/GGUF) 模型的 GPU (CUDA) 支持,請將以下內容新增至您的chatdocs.yml :

ctransformers :

config :

gpu_layers : 50您可能必須使用以下命令安裝 CUDA 庫:

pip install ctransformers[cuda]要啟用 GPU (CUDA) 支援? Transformers 模型,將以下內容加入您的chatdocs.yml :

huggingface :

device : 0您可能需要按照此處的說明重新安裝啟用 CUDA 的 PyTorch。

麻省理工學院