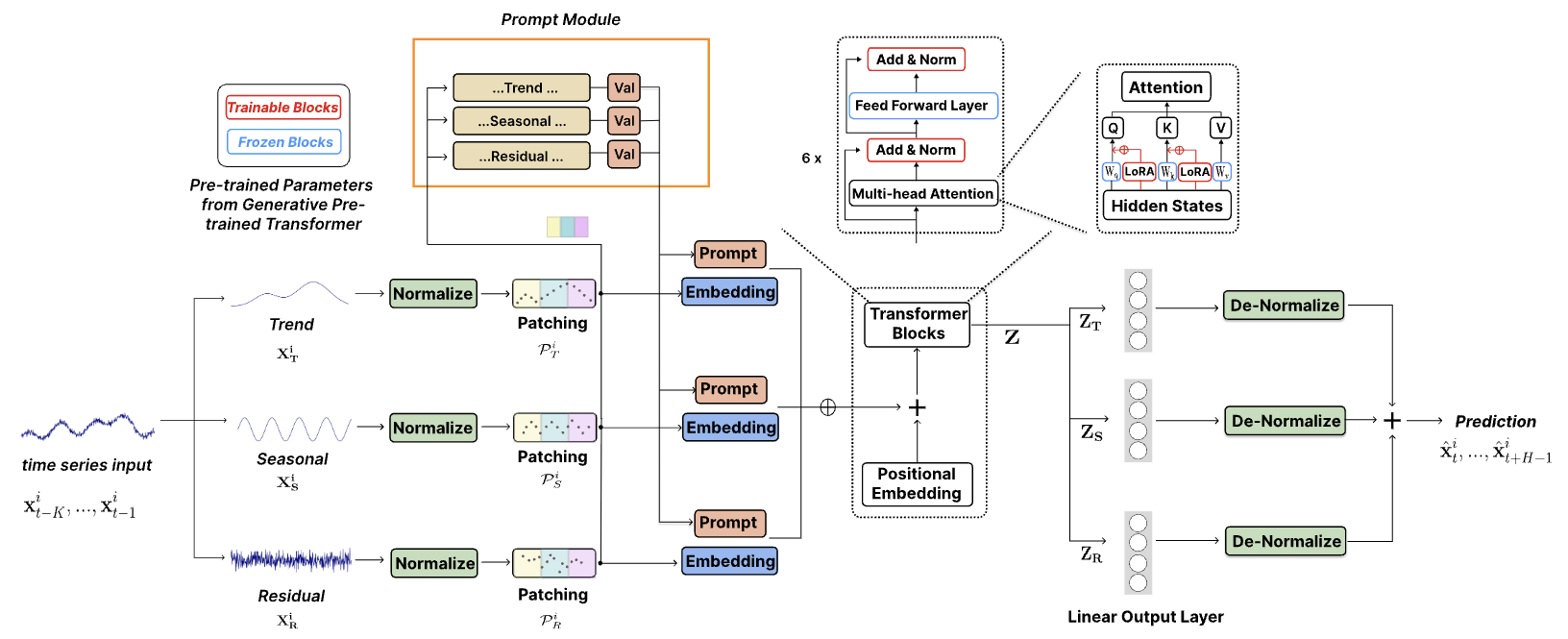

[“TEMPO:用於時間序列預測的基於提示的生成預訓練變壓器(ICLR 2024)”]的官方代碼。

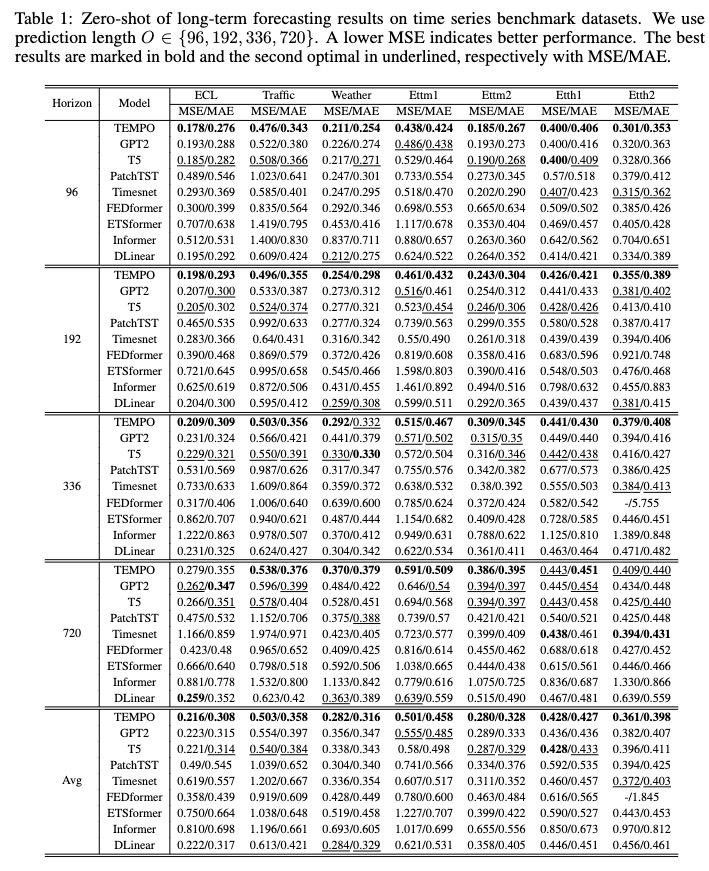

TEMPO 是最早用於預測任務 v1.0 版本的開源時間序列基礎模型之一。

2024 年 10 月:我們簡化了程式碼結構,使用戶能夠下載預先訓練的模型並用一行程式碼執行零樣本推理!查看我們的演示以了解更多詳細資訊。我們的模型在 HuggingFace 上的下載計數現在可以追蹤!

2024 年 6 月:我們新增了在 Colab 中重現零樣本實驗的演示。我們還添加了建立客戶資料集的演示,並透過我們預先訓練的基礎模型直接進行推理:Colab

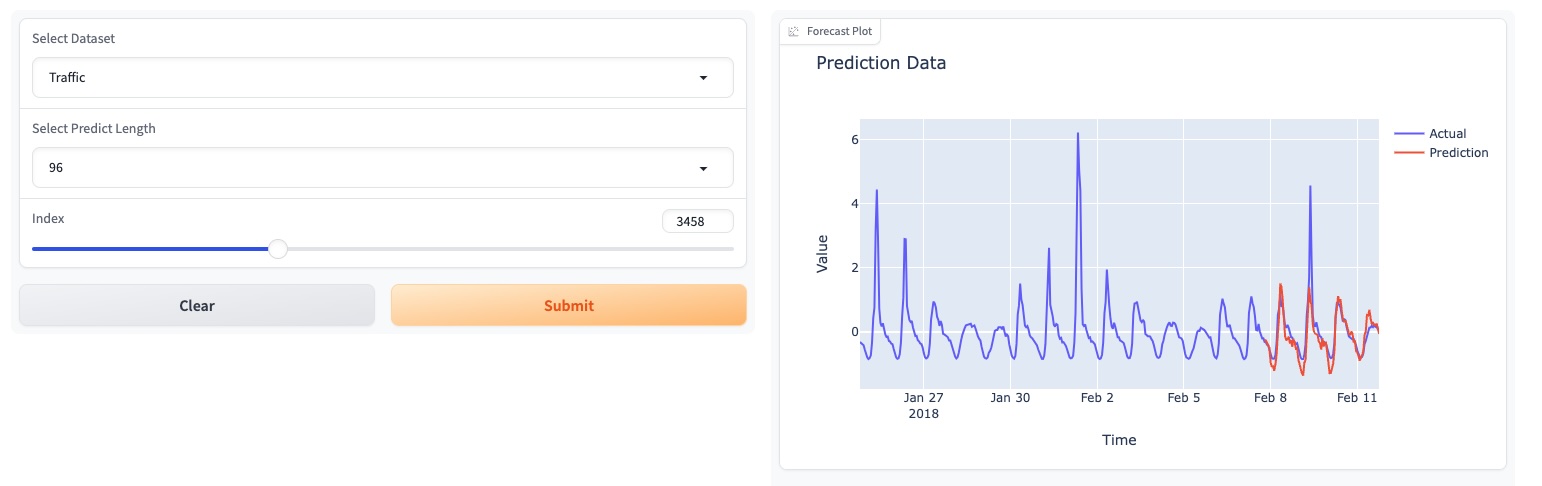

2024年5月:TEMPO推出了基於GUI的線上演示,讓用戶直接與我們的基礎模型互動!

2024年5月:TEMPO在HuggingFace上發布了80M預訓練基礎模型!

2024 年 5 月:?我們添加了預訓練和推理 TEMPO 模型的程式碼。您可以在此資料夾中找到預訓練腳本演示。我們還添加了一個用於推理演示的腳本。

2024 年 3 月:?發布了 S&P 500 的 TETS 資料集,用於 TEMPO 的多模態實驗。

2024 年 3 月:? TEMPO 在線上發布了專案代碼和預訓練檢查點!

2024年1月:TEMPO論文被ICLR接收!

2023 年 10 月:TEMPO 論文在 Arxiv 上發布!

conda create -n tempo python=3.8

conda activate tempo

pip install -r requirements.txt

展示如何使用 TEMPO 執行預測的簡化範例:

# Third-party library imports

import numpy as np

import torch

from numpy . random import choice

# Local imports

from models . TEMPO import TEMPO

model = TEMPO . load_pretrained_model (

device = torch . device ( 'cuda:0' if torch . cuda . is_available () else 'cpu' ),

repo_id = "Melady/TEMPO" ,

filename = "TEMPO-80M_v1.pth" ,

cache_dir = "./checkpoints/TEMPO_checkpoints"

)

input_data = np . random . rand ( 336 ) # Random input data

with torch . no_grad ():

predicted_values = model . predict ( input_data , pred_length = 96 )

print ( "Predicted values:" )

print ( predicted_values )請嘗試在 ETTh2 上重現零樣本實驗 [在 Colab 上]。

我們使用以下 Colab 頁面來展示建立客戶資料集的演示,並透過我們預先訓練的基礎模型直接進行推理:[Colab]

請嘗試我們的基礎模型演示[此處]。

我們也在 HuggingFace 上更新了我們的模型:[Melady/TEMPO]。

從[Google Drive]或[Baidu Drive]下載數據,並將下載的數據放在資料夾./dataset中。您也可以從[Google Drive]下載STL結果,並將下載的資料放在資料夾./stl中。

bash [ecl, etth1, etth2, ettm1, ettm2, traffic, weather].sh

訓練完成後,我們可以在零樣本設定下測試 TEMPO 模型:

bash [ecl, etth1, etth2, ettm1, ettm2, traffic, weather]_test.sh

您可以從[Google Drive]下載預先訓練的模型,然後執行測試腳本以獲得樂趣。

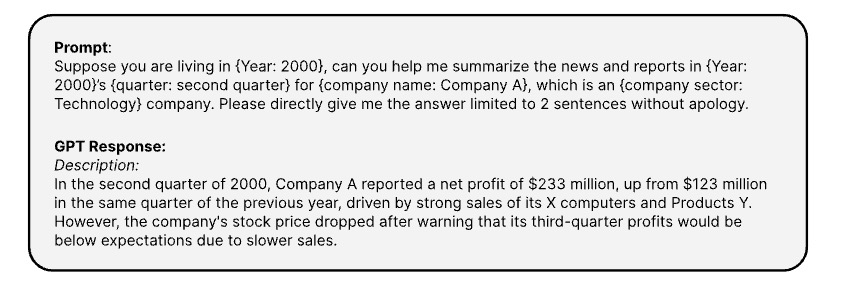

這裡是透過【OPENAI ChatGPT-3.5 API】產生對應的時間序列文字資訊的提示

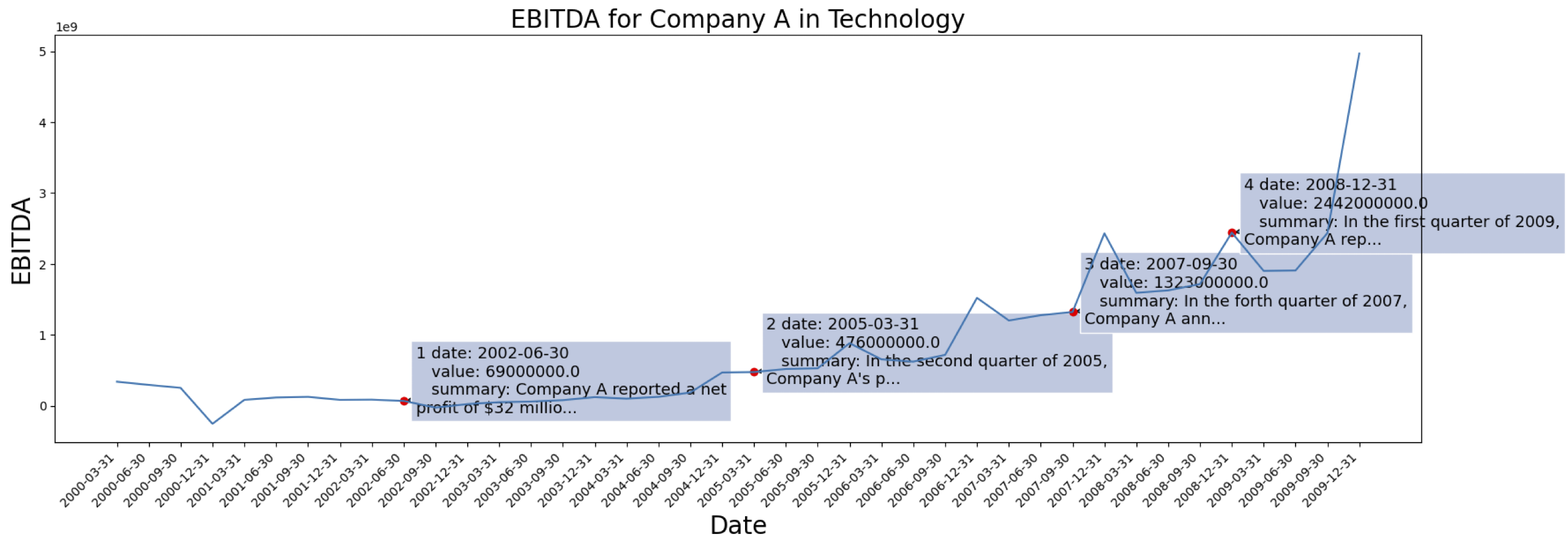

時間序列資料來自[S&P 500]。以下是資料集中一家公司的 EBITDA 案例:

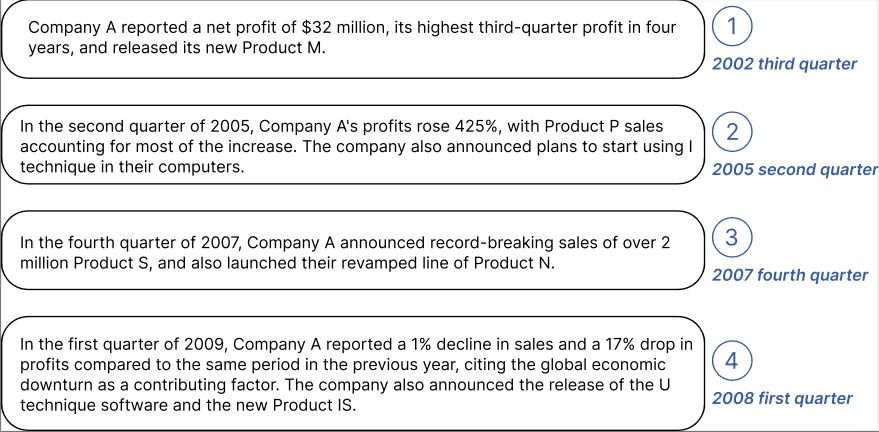

為上面標記的公司產生的上下文資訊範例:

您可以從 GPT2 下載具有文字嵌入的已處理資料:[TETS]。

如果您有興趣將 TEMPO 應用到實際應用中,請隨時聯絡 [email protected] / [email protected]。

@inproceedings{

cao2024tempo,

title={{TEMPO}: Prompt-based Generative Pre-trained Transformer for Time Series Forecasting},

author={Defu Cao and Furong Jia and Sercan O Arik and Tomas Pfister and Yixiang Zheng and Wen Ye and Yan Liu},

booktitle={The Twelfth International Conference on Learning Representations},

year={2024},

url={https://openreview.net/forum?id=YH5w12OUuU}

}

@article{

Jia_Wang_Zheng_Cao_Liu_2024,

title={GPT4MTS: Prompt-based Large Language Model for Multimodal Time-series Forecasting},

volume={38},

url={https://ojs.aaai.org/index.php/AAAI/article/view/30383},

DOI={10.1609/aaai.v38i21.30383},

number={21},

journal={Proceedings of the AAAI Conference on Artificial Intelligence},

author={Jia, Furong and Wang, Kevin and Zheng, Yixiang and Cao, Defu and Liu, Yan},

year={2024}, month={Mar.}, pages={23343-23351}

}