Awesome Attention Heads

vey on LLM attention heads

重要的

關於這個倉庫。這是一個獲取不同類型法學碩士注意力頭最新研究的平台。此外,我們也發布了基於這些精彩作品的調查。

如果您想引用我們的工作,這裡是我們的 bibtex 條目:CITATION.bib。

如果您只想查看相關論文列表,請直接跳至此處。

如果您想為此儲存庫做出貢獻,請參閱此處。

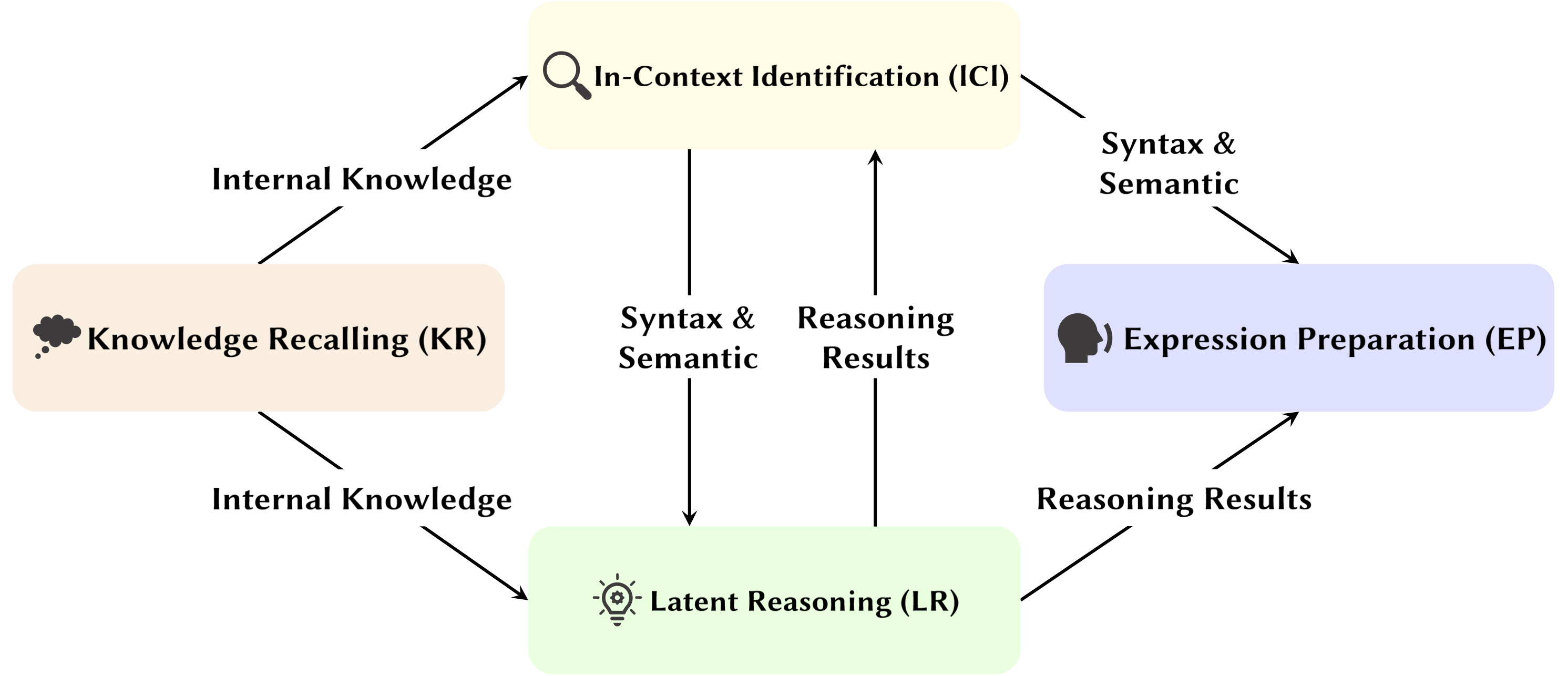

隨著大型語言模式(LLM)的發展,其底層網路結構Transformer正被廣泛研究。研究Transformer結構有助於我們增強對這個「黑盒子」的理解,並提高模型的可解釋性。最近,越來越多的工作表明該模型包含兩個不同的部分:用於行為、推理和分析的注意力機制,以及用於知識儲存的前饋網路(FFN)。前者對於揭示模型的功能能力至關重要,從而引發了一系列探索注意力機制內各種功能的研究,我們稱之為「注意力頭挖掘」 。

在這項調查中,我們深入研究了法學碩士注意力頭如何促進推理過程的潛在機制。

亮點:

以下論文依發表日期排序:

2024年

| 日期 | 論文及摘要 | 標籤 | 連結 |

| 2024-11-15 | SEEKR:選擇性注意引導的知識保留,用於大型語言模型的持續學習 | ||

| • 提出SEEKR,一種用於法學碩士持續學習的選擇性注意力引導知識保留方法,重點關注關鍵注意力頭以實現高效提煉。 • 根據持續學習基準TRACE 和SuperNI 進行評估。 • 與其他方法相比,SEEKR 僅使用 1% 的重播資料即可達到相當或更好的效能。 | |||

| 2024-11-06 | Transformers 如何解決命題邏輯問題:機械分析 | ||

| • 辨識解決命題邏輯問題的變壓器中的特定注意電路,重點在於「規劃」和「推理」機制。 • 分析小型變壓器和Mistral-7B,使用啟動修補來揭示推理路徑。 • 找出專門從事規則定位、事實處理和邏輯推理決策的獨特注意力頭。 | |||

| 2024-11-01 | 注意力追蹤器:偵測法學碩士中的即時注入攻擊 | ||

| • 提議的注意力追蹤器,一種簡單而有效的免訓練防護,可根據已識別的重要頭檢測即時注入攻擊。 • 僅使用一小組LLM 產生的隨機句子並結合天真的忽略攻擊來識別重要的頭部。 • 注意力追蹤器對小型和大型 LM 都有效,解決了先前免訓練偵測方法的重大限制。 | |||

| 2024-10-28 | 沒有演算法的算術:語言模型透過啟發式方法解決數學問題 | ||

| • 確定模型的子集(電路),用於解釋基本算術邏輯的大部分模型行為並檢查其功能。 • 使用阿拉伯數字和四個基本運算子(+、−、×、÷)的雙運算元算術提示分析注意力模式。 • 對於加法、減法和除法,6 個注意力頭可產生高忠實度(平均 97%),而乘法則需要 20 個注意力頭才能超過 90% 的忠實度。 | |||

| 2024-10-21 | 語言模型對論證角色敏感度的心理語言學評估 | ||

| • 在較普遍的環境中觀察主體頭部。 • 分析了交換參數和替換參數條件下的注意力模式。 • 儘管能夠區分角色,但模型可能很難正確使用參數角色訊息,因為問題在於如何將這些資訊編碼為動詞表示,從而導致角色敏感度較弱。 | |||

| 2024-10-17 | 活躍-休眠注意力頭:機械地揭秘法學碩士中的極端令牌現象 | ||

| • 證明極端標記現像是由注意頭中的活躍-休眠機制以及預訓練期間的相互強化機制引起的。 • 使用在Biggram-Backcopy (BB) 任務上訓練的簡單變壓器來分析極端標記現象並將其擴展到預先訓練的LLM。 • BB 任務預測的極端標記現象的許多靜態和動態特性與預先訓練的LLM 中的觀察結果一致。 | |||

| 2024-10-17 | 論注意力頭在大語言模型安全中的作用 | ||

| • 提出了一種專為多頭注意力而設計的新穎指標,即安全頭重要得分(船舶),以評估各個頭對模型安全性的貢獻。 • 對這些安全注意頭的功能進行分析,探索其特徵和機制。 • 某些注意力頭對於安全至關重要,安全頭在經過微調的模型中重疊,並且消除這些頭對幫助的影響最小。 | |||

| 2024-10-14 | DuoAttention:具有檢索和流處理頭的高效長上下文 LLM 推理 | ||

| • 引入了DuoAttention,這是一個基於LLM 中檢索頭和流頭的發現的框架,可減少LLM 的解碼和預填充內存以及延遲,同時又不影響其長上下文能力。 • 測驗框架對LLM 在短上下文和長上下文任務中的表現及其推理效率的影響。 • 透過僅將完整的KV 快取應用於檢索頭,DuoAttention 顯著減少了長上下文應用程式中解碼和預先填充的記憶體使用量和延遲。 | |||

| 2024-10-14 | 鎖定微調法學碩士的安全 | ||

| • 推出了SafetyLock,這是一種新穎且有效的方法,基於LLM 中安全頭的發現,用於在各種風險等級和攻擊場景中維護經過微調的大型語言模型的安全性。 • 評估SafetyLock 在增強模型安全性和推理效率方面的有效性。 • 透過將介入向量應用於安全頭,SafetyLock 可以在推理過程中將模型的內部活化修改為無害,從而實現精確的安全調整,同時將對反應的影響降至最低。 | |||

| 2024-10-11 | 相同但不同:多語言語言建模的結構異同 | ||

| • 對多語言模型在執行需要特定語言形態過程的任務時所依賴的特定組件進行了深入研究。 • 研究執行英文和中文任務時內部模型組件的功能差異。 • 仿形中心詞在兩種語言中都有相似的高激活頻率,而過去式中心詞僅在英語中頻繁激活。 | |||

| 2024-10-08 | 我們一圈又一圈地走!旋轉位置編碼有何用處? | ||

| • 對經過訓練的Gemma 7B 模型的內部結構進行了深入分析,以了解如何在機械層面使用RoPE。 • 了解查詢和鍵中不同頻率的用法。 • 發現Gemma 7B 巧妙地使用RoPE 中的最高頻率來建構特殊的「位置」注意頭(對角線頭、前記號頭),而低頻則由撇號頭使用。 | |||

| 2024-10-06 | 重新檢視大型語言模型中的上下文學習推理電路 | ||

| • 提出了一個全面的三步驟推理電路來表徵ICL 的推理過程。 • 將ICL分為三個階段:Summarize、Semantics Merge、Feature Retrieval and Copy,分析各階段在ICL中的作用及其運作機制。 • 發現在歸納頭之前,先行者令牌頭首先將先行者令牌中的演示文字表示合併到其對應的標籤令牌中,選擇性地基於演示和標籤語義之間的兼容性。 | |||

| 2024-10-01 | 稀疏注意力分解在電路追蹤的應用 | ||

| • 引入稀疏注意力分解,在註意力頭矩陣上使用SVD 來追蹤GPT-2 模型中的通訊路徑。 • 適用於間接物件辨識(IOI) 任務的GPT-2 小電路追蹤。 • 辨識注意力頭之間稀疏的、功能上重要的通訊訊號,提高可解釋性。 | |||

| 2024-09-09 | 揭曉感應頭:變壓器中可證明的訓練動力學和特徵學習 | ||

| • 本文介紹了一種廣義感應頭機制,解釋了變壓器組件如何協作在n-gram 馬可夫鏈上執行上下文學習(ICL)。 • 它分析具有梯度流的兩個注意力層變壓器,以預測馬可夫鏈中的標記。 • 梯度流收斂,透過基於學習特徵的感應頭機制實現 ICL。 | |||

| 2024-08-16 | 自迴歸語言模型中三段論推理的機械解釋 | ||

| • 本研究引入了語言模型中三段論推理的機械解釋,確定了與內容無關的推理電路。 • 用於推理和調查注意力頭中信念偏差污染的電路發現。 • 確定了可跨三段論方案轉移的必要推理電路,但容易受到預先訓練的世界知識的污染。 | |||

| 2024-08-01 | 透過模型編輯增強大型語言模型的語義一致性:一種以可解釋性為導向的方法 | ||

| • 引入一種經濟高效的模型編輯方法,重點關註註意力頭,以增強法學碩士的語義一致性,而無需進行大量參數更改。 • 分析注意力頭、注入偏差,並在 NLU 和 NLG 資料集上進行測試。 • 在語意一致性和任務表現方面取得顯著改進,並具有跨其他任務的強大泛化能力。 | |||

| 2024-07-31 | 透過負注意力分數對齊來修正大型語言模型中的負偏差 | ||

| • 引入負面注意力分數(NAS)來量化和修正語言模型中的負面偏見。 • 辨識出負向偏見的注意力頭,並提出用於微調的負向注意力分數對齊(NASA)。 • NASA 有效地縮小了精確回憶差距,同時保留了二元決策任務的泛化能力。 | |||

| 2024-07-29 | 透過機械可解釋性檢測和理解語言模型中的漏洞 | ||

| • 介紹了一種使用機械可解釋性(MI) 來偵測和理解LLM 中的漏洞,特別是對抗性攻擊的方法。 • 分析GPT-2 Small 在預測3 字母縮寫詞的漏洞。 • 成功辨識並解釋模型中與任務相關的特定漏洞。 | |||

| 2024-07-22 | RazorAttention:透過檢索頭進行高效率的 KV 快取壓縮 | ||

| • 引入了RazorAttention,這是一種免訓練的KV 快取壓縮技術,使用檢索頭和補償令牌來保留關鍵令牌資訊。 • 評估了大型語言模型(LLM) 上的RazorAttention 的效率。 • KV 快取大小減少了 70% 以上,且沒有明顯的效能影響。 | |||

| 2024-07-21 | 答、組裝、王牌:了解變形金剛如何回答多項選擇題 | ||

| • 本文介紹了詞彙投影和啟動修補來定位隱藏狀態,從而預測正確的 MCQA 答案。 • 確定了變壓器中負責答案選擇的關鍵關注頭和層。 • 中層注意力頭對於準確的答案預測至關重要,一組稀疏的注意力頭發揮獨特的作用。 | |||

| 2024-07-09 | 感應頭作為情境學習中模式匹配的基本機制 | ||

| • 文章指出感應頭對於情境學習 (ICL) 中的模式匹配至關重要。 • 評估Llama-3-8B 和InternLM2-20B 的抽像模式辨識和NLP 任務。 • 燒蝕感應頭可將 ICL 性能降低高達約 32%,使其接近隨機模式辨識。 | |||

| 2024-07-02 | 透過比較神經元分析解釋大型語言模型中的算術機制 | ||

| • 引入比較神經元分析(CNA)來繪製大型語言模型注意力頭中的算術機制。 • 分析算術能力、算術任務的模型修剪、模型編輯以減少性別偏差。 • 識別負責算術的特定神經元,透過有針對性的神經元操作來提高表現並減輕偏差。 | |||

| 2024-07-01 | 引導大型語言模型進行跨語言資訊檢索 | ||

| • 引入激活引導多語言檢索 (ASMR),使用引導激活來指導法學碩士改進跨語言資訊檢索。 • 確定法學碩士中影響準確性和語言連貫性的注意力頭,並應用轉向激活。 • ASMR 在 XOR-TyDi QA 和 MKQA 等 CLIR 基準測試中實現了最先進的性能。 | |||

| 2024-06-25 | Transformers 如何透過梯度下降學習因果結構 | ||

| • 解釋了 Transformer 如何透過基於梯度的訓練演算法學習因果結構。 • 分析了兩層變壓器在稱為具有因果結構的隨機序列的任務中的表現。 • 簡化的兩層變壓器上的梯度下降學習透過在第一個注意層中編碼潛在因果圖來解決此任務。作為一種特殊情況,當從上下文中的馬可夫鏈生成序列時,變壓器學會開發感應頭。 | |||

| 2024-06-21 | MoA:用於自動大型語言模型壓縮的稀疏注意力混合 | ||

| • 本文介紹了混合注意力(MoA),它為不同的頭和層定制不同的稀疏注意力配置,優化內存、吞吐量和準確性-延遲權衡。 • MoA 分析模型、探索注意力配置並改善LLM 壓縮。 • MoA 將有效上下文長度增加了 3.9 倍,同時將 GPU 記憶體使用量減少了 1.2-1.4 倍。 | |||

| 2024-06-19 | 論大型語言模型中忠實思考鏈推理的難度 | ||

| • 引入了上下文學習、微調和激活編輯的新穎策略,以提高法學碩士的思想鏈(CoT)推理可信度。 • 透過多個基準測試這些策略以評估其有效性。 • 發現在提高CoT 忠誠度方面只取得了有限的成功,突顯了法學碩士實現真正忠實推理的挑戰。 | |||

| 2024-06-04 | 迭代頭:思想鏈的機制研究 | ||

| • 引入“迭代頭”,這是一種專門的注意力頭,可以在變壓器中針對思想鏈(CoT) 任務進行迭代推理。 • 分析注意力機制、追蹤CoT 出現並測試CoT 技能在任務之間的可轉移性。 • 迭代頭有效支援CoT 推理,提升模型可解釋性和任務表現。 | |||

| 2024-06-03 | LoFiT:LLM 表示的在地化微調 | ||

| • 引入了LLM 表示的本地化微調(LoFiT),這是一個兩步驟框架,用於識別給定任務的重要注意頭並學習特定於任務的偏移向量以乾預已識別頭的表示。 • 確定重要注意力頭的稀疏集合,以提高下游真實性和推理的準確性。 • LoFiT 優於其他表示幹預方法,並在 TruthfulQA、CLUTRR 和 MQuAKE 上取得了與 PEFT 方法相當的性能,儘管僅對法學碩士中總注意力頭的 10% 進行幹預。 | |||

| 2024-05-28 | 預訓練 Transformer 中的知識電路 | ||

| • 在 Transformer 中引入了“知識電路”,揭示如何透過注意力頭、關係頭和 MLP 之間的交互作用來編碼特定知識。 • 分析GPT-2 和TinyLLAMA 以辨識知識迴路;評估知識編輯技術。 • 展示了知識迴路如何促進幻覺和情境學習等模式行為。 | |||

| 2024-05-23 | 將變形金剛中的情境學習與人類情景記憶連結起來 | ||

| • 將Transformer 模型中的情境學習與人類情境記憶連結起來,突顯歸納頭與情境維護與檢索(CMR) 模型之間的相似性。 • 分析基於Transformer 的LLM,以顯示注意力頭中類似CMR 的行為。 • 類似CMR 的頭部出現在中間層,反映了人類的記憶偏差。 | |||

| 2024-05-07 | GPT-2 如何預測首字母縮寫?透過機械解釋提取和理解電路 | ||

| • GPT-2 的首次機械可解釋性研究,用於使用注意力頭預測多標記首字母縮寫。 • 辨識並解釋負責首字母縮寫預測的8 個注意力頭電路。 • 證明這8 個頭(約佔總數的5%)集中了首字母縮寫預測功能。 | |||

| 2024-05-02 | 解釋和改進算術計算中的大型語言模型 | ||

| • 遵循「辨識-分析-微調」流程,透過數學任務詳細研究法學碩士的內部機制。 • 分析模型執行涉及兩個運算元的算術任務的能力,例如加法、減法、乘法和除法。 • 發現法學碩士經常涉及一小部分(< 5%)的注意力頭,這些注意力頭在計算過程中關注操作數和運算符方面發揮著關鍵作用。 | |||

| 2024-05-02 | 感應頭需要什麼?情境學習迴路及其形成的機制研究 | ||

| • 引入了受光遺傳學啟發的因果框架來研究變壓器中感應頭(IH) 的形成。 • 使用綜合資料分析變壓器中 IH 的出現,並確定導致 IH 形成的三個底層子電路。 • 發現這些子電路交互作用以驅動IH 形成,與模型損失的相變相一致。 | |||

| 2024-04-24 | 檢索頭機械地解釋長上下文事實 | ||

| • 確定變壓器模型中的“檢索頭”,負責跨長上下文檢索資訊。 • 對各種模型的檢索頭進行系統性研究,包括分析它們在思想鏈推理中的作用。 • 修剪檢索頭會導致幻覺,而修剪非檢索頭不會影響檢索能力。 | |||

| 2024-03-27 | 非線性推理時間介入:提高LLM的真實性 | ||

| • 引入非線性推理時間幹預(NL-ITI),透過多標記探測和介入增強LLM 真實性,無需微調。 • 在多項選擇資料集(包括TruthfulQA)上評估NL-ITI。 • 與基準ITI 相比,TruthfulQA 的MC1 準確度相對提高了16%。 | |||

| 2024-02-28 | 如何逐步思考:對思考鏈推理的機械理解 | ||

| • 從神經功能成分方面對法學碩士中CoT 介導的推理進行了深入分析。 • 對虛構推理進行基於 CoT 的剖析推理,將其視為由固定數量的子任務組成,需要決策、複製和歸納推理,並分別分析其機制。 • 發現注意力頭在本體相關(或負相關)標記之間執行訊息移動,從而產生這些標記對的明顯可識別的表示。 | |||

| 2024-02-28 | 砍掉頭部結束衝突:解釋和緩解語言模型中知識衝突的機制 | ||

| • 引入PH3 方法來修剪衝突的注意力頭,從而在無需更新參數的情況下減輕語言模型中的知識衝突。 • 應用PH3 來控制LM 對內部記憶體與外部情境的依賴,並測試其在開放域QA 任務中的有效性。 • PH3 將內部記憶體使用率提高了 44.0%,將外部上下文使用率提高了 38.5%。 | |||

| 2024-02-27 | 資訊流路線:大規模自動解釋語言模型 | ||

| • 引入“資訊流路由”,使用歸因來對語言模型進行基於圖形的解釋,從而避免激活修補。 • 使用 Llama 2 進行實驗,辨識不同領域和任務的關鍵注意力頭和行為模式。 • 未發現的專用模型組件;確定了注意力頭的一致角色,例如處理相同詞性的標記。 | |||

| 2024-02-20 | 辨識語意歸納頭以理解情境學習 | ||

| • 辨識並研究大語言模型(LLM)中與情境學習能力相關的「語意歸納頭」。 • 分析注意力頭以編碼句法依賴和知識圖關係。 • 某些注意力頭透過回憶相關標記來增強輸出邏輯,這對於理解法學碩士的情境學習至關重要。 | |||

| 2024-02-16 | 統計歸納頭的演變:上下文學習馬可夫鏈 | ||

| • 引入馬可夫鏈序列建模任務來分析情境學習(ICL) 功能如何在變壓器中出現,形成「統計歸納頭」。 • 變壓器在馬可夫鏈任務上的多階段訓練的實證和理論研究。 • 示範從一元模型到二元模型預測的相變,受變壓器層交互作用的影響。 | |||

| 2024-02-11 | 總結事實:法學碩士事實回憶背後的附加機制 | ||

| • 識別並解釋事實回憶中的“附加主題”,其中法學碩士使用多種獨立機制建設性地干擾事實回憶。 • 擴展直接logit 歸因來分析注意力頭並解開混合頭的行為。 • 證明法學碩士中的事實記憶是由多個獨立的不足貢獻的總和產生的。 | |||

| 2024-02-05 | 大型語言模型如何在脈絡中學習?上下文頭部的查詢矩陣和關鍵矩陣是度量學習的兩座塔 | ||

| • 引入上下文頭中的查詢矩陣和關鍵矩陣作為度量學習的「雙塔」運作的概念,促進標籤特徵之間的相似性計算。 • 分析情境學習機制;確定了對 ICL 至關重要的特定注意力頭。 • 透過僅對這些頭部的 1% 進行幹預,將 ICL 準確度從 87.6% 降低至 24.4%。 | |||

| 2024-01-23 | 情境語言學習:架構與演算法 | ||

| • 引入“n-gram 頭”,即專門的 Transformer 注意力頭,透過輸入條件標記預測增強上下文語言學習 (ICLL)。 • 評估來自隨機有限自動機的常規語言的神經模型。 • 硬連線n-gram 頭在SlimPajama 資料集上將困惑度提高了6.7%。 | |||

| 2024-01-16 | 情境分類任務中資料依賴與突然學習的機制基礎 | ||

| • 論文透過僅注意網路中感應頭的突然形成來模擬情境學習(ICL)的機制基礎。 • 使用簡化的輸入資料和基於注意力的兩層網路模擬ICL 任務。 • 感應頭的形成驅動了向ICL 的突然過渡,透過嵌套非線性進行追蹤。 | |||

| 2024-01-16 | Transformer 語言模型中跨任務的電路元件重複使用 | ||

| • 該論文證明,GPT-2 中的特定電路可以泛化到不同的任務,挑戰了此類電路是特定於任務的概念。 • 它檢查彩色物件任務中間接物件辨識(IOI) 任務中電路的重用。 • 調整四個注意力頭可將彩色物體任務的準確度從 49.6% 提高到 93.7%。 | |||

| 2024-01-16 | 後繼頭:在野外反覆出現、可解釋的注意力頭 | ||

| • 本文介紹了“後繼頭”,即法學碩士中的注意力頭,它以自然順序(如天或數字)增加標記。 • 它分析了各種模型大小和架構(例如GPT-2 和Llama-2)的後繼頭的形成。 • 後繼頭出現在從 31M 到 12B 參數的模型中,揭示了抽象的、重複出現的數字表示。 | |||

| 2024-01-16 | 大型語言模型中的函數向量 | ||

| • 本文介紹了“函數向量 (FV)”,即自回歸變壓器模型中任務的緊湊因果表示。 • FV 在不同的情境學習 (ICL) 任務、模型和層中進行了測試。 • FV 可以相加來建立觸發新的複雜任務的向量,展示內部向量組成。 | |||

| 日期 | 論文及摘要 | 標籤 | 連結 |

| 2023-12-23 | 事實調查:嘗試在神經元層面上對事實回憶進行逆向工程 | ||

| • 研究Pythia 2.8B 中的早期MLP 層如何使用分散式電路對事實回憶進行編碼,重點在於疊加和多標記嵌入。 • 探索MLP 層中的事實查找,測試關於去標記化和雜湊機制的假設。 • 事實回憶功能類似於分散式查找表,但沒有易於解釋的內部機制。 | |||

| 2023-11-07 | 邁向可解釋的序列延續:分析大型語言模型中的共享電路 | ||

| • 證明了用於類似序列延續任務的共享電路的存在。 • 分析和比較類似序列延續任務的電路,其中包括阿拉伯數字、數字詞和月份的遞增序列。 • 語意相關的序列依賴於具有類似角色的共享電路子圖以及在具有類似功能的模型中尋找類似的子電路。 | |||

| 2023-10-23 | 大型語言模型中情緒的線性表示 | ||

| • 該論文確定了激活空間中的線性方向,該方向捕獲大型語言模型(LLM)中的情緒表示。 • 他們隔離了這種情緒方向,並在包括史丹佛情緒樹庫在內的任務上對其進行了測試。 • 消除這種情緒方向會導致分類準確度下降 76%,凸顯了其重要性。 | |||

| 2023-10-06 | 複製抑制:全面理解注意力頭 | ||

| • 本文介紹了GPT-2小型注意力頭(L10H7)中複製抑制的概念,這減少了天真的令牌複製,增強了模型校準。 • 本文研究並解釋了複製抑制的機制及其在自我修復中的作用。 • GPT-2 Small 中L10H7 76.9% 的影響得到了解釋,使其成為對注意力頭角色最全面的描述。 | |||

| 2023-09-22 | 推理時間介入:從語言模型中得出真實答案 | ||

| • 引入推理時間介入(ITI),透過調整選定注意力頭中的模型活化來增強LLM 的真實性。 • 改進了LLaMA 模型在TruthfulQA 基準上的效能。 • ITI 將羊駝模型的真實性從 32.5% 提高到 65.1%。 | |||

| 2023-09-22 | 變形金剛的誕生:記憶觀點 | ||

| • 本文提出了基於記憶的變壓器視角,強調了權重矩陣中的聯想記憶及其梯度驅動的學習。 • 使用合成資料對簡化變壓器模型的訓練動態進行實證分析。 • 發現快速全域二元組學習以及情境二元組「歸納頭」的較慢出現。 | |||

| 2023-09-13 | 損失突然下降:MLM 中的文法習得、相變和簡單性偏差 | ||

| • 確定句法注意結構(SAS) 作為掩碼語言模型(MLM) 中自然出現的屬性及其在句法習得中的作用。 • 在訓練期間分析SAS 並對其進行操作以研究其對語法能力的因果影響。 • SAS 對於語法開發是必要的,但短暫抑制它可以提高模型效能。 | |||

| 2023-07-18 | 電路分析的可解釋性是否可擴展?來自龍貓多項選擇能力的證據 | ||

| • 將可擴展電路分析應用於70B Chinchilla 語言模型,以瞭解多項選擇題的答案。 • Logit 歸因、注意力模式視覺化和激活修補,以識別和分類關鍵注意力頭。 • 在註意頭中確定了「枚舉中的第N 項」功能,儘管這只是部分解釋。 | |||

| 2023-02-02 | 野外可解釋性:GPT-2 Small 中的間接物件辨識電路 | ||

| • 本文詳細介紹了GPT-2小型如何使用涉及分為7類的28個注意力頭的大型電路來執行間接物件辨識(IOI)。 • 他們使用因果幹預和預測對GPT-2小型中的IOI任務進行了逆向工程。 • 研究顯示大型語言模型的機械解釋是可行的。 | |||

| 日期 | 論文及摘要 | 標籤 | 連結 |

| 2022-03-08 | 情境學習與歸納頭 | ||

| • 該論文確定了 Transformer 模型中的“感應頭”,它可以透過識別和複製序列中的模式來實現上下文學習。 • 分析不同Transformer 模型中各層的注意力模式和感應頭。 • 發現歸納頭對於使 Transformer 能夠有效地概括和執行情境學習任務至關重要。 | |||

| 2021-12-22 | 變壓器電路的數學框架 | ||

| • 引入了一個數學框架來對小型僅注意力變壓器進行逆向工程,重點是將注意力頭理解為獨立的附加組件。 • 分析零層、一層和兩層轉換器,以確定注意力頭在資訊移動和構成中的作用。 • 發現了“歸納頭”,這對於兩層變壓器的上下文學習至關重要。 | |||

| 2021-05-18 | Heads 假設:理解 BERT 中多頭注意力的統一統計方法 | ||

| • 本文提出了一種稱為「稀疏注意力」的新方法,透過選擇性地關注重要標記來降低注意力機制的計算複雜性。 • 此方法在機器翻譯和文字分類任務上進行了評估。 • 稀疏注意力模型實現了與密集注意力相當的準確性,同時顯著降低了計算成本。 | |||

| 2021-04-01 | BERT 中的注意力頭學過選區文法嗎? | ||

| • 該研究引入了句法距離方法來分析 BERT 和 RoBERTa 注意力頭中的選區語法。 • 在SMS 和NLI 任務的微調前後擷取和分析選區語法。 • NLI 任務提高了選區語法歸納能力,而 SMS 任務則降低了上層的能力。 | |||

| 2019-11-27 | BERT 中的注意力頭是否追蹤句法依賴性? | ||

| • 本文研究了 BERT 中的各個注意力頭是否捕獲句法依賴關係,使用注意力權重來提取依賴關係。 • 使用最大注意力權重和最大生成樹分析BERT 的注意力頭,並將它們與通用依賴樹進行比較。 • 有些注意力頭比基線更好地追蹤特定的語法依賴關係,但沒有一個頭能夠更好地執行整體解析。 | |||

| 2019-11-01 | 自適應稀疏變壓器 | ||

| • 引入了使用 alpha-entmax 的自適應稀疏 Transformer,以允許注意頭部中靈活的、上下文相關的稀疏性。 • 應用於機器翻譯資料集以評估可解釋性和頭部多樣性。 • 在不影響準確性的情況下實現了多樣化的注意力分佈並提高了可解釋性。 | |||

| 2019-08-01 | BERT 關注什麼? BERT注意力分析 | ||

| • 本文介紹了分析 BERT 注意力機制的方法,揭示了與語法和共指等語言結構一致的模式。 • 分析注意力頭,辨識句法和共指模式,以及發展基於注意力的探測分類器。 • BERT 的注意力頭捕捉了大量的句法訊息,特別是在識別直接物件和共指等任務中。 | |||

| 2019-07-01 | 分析多頭自註意力:專門的頭完成繁重的工作,其餘的可以被修剪 | ||

| • 本文介紹了一種新穎的多頭自註意力剪枝方法,該方法可以選擇性地刪除不太重要的頭,而不會造成重大性能損失。 • 分析個體注意力頭,辨識其專門角色,並在 Transformer 模型上應用剪枝方法。 • 修剪編碼器中 48 個頭中的 38 個僅導致 BLEU 分數下降 0.15。 | |||

| 2018-11-01 | 基於 Transformer 的機器翻譯中的編碼器表示分析 | ||

| • 本文分析了 Transformer 編碼器層的內部表示,重點在於自註意力頭學習的句法和語義資訊。 • 探測任務、依賴關係提取和遷移學習場景。 • 較低層捕獲語法,而較高層編碼更多語意資訊。 | |||

| 2016-03-21 | 將複製機制納入序列到序列學習 | ||

| • 在序列到序列模型中引入複製機制,以允許直接複製輸入標記,從而改善對稀有字詞的處理。 • 應用於機器翻譯和摘要任務。 • 與標準序列到序列模型相比,翻譯準確度顯著提高,尤其是罕見詞翻譯。 | |||

問題模板:

Title: [paper's title]

Head: [head name1] (, [head name2] ...)

Published: [arXiv / ACL / ICLR / NIPS / ...]

Summary:

- Innovation:

- Tasks:

- Significant Result: