mae

1.0.0

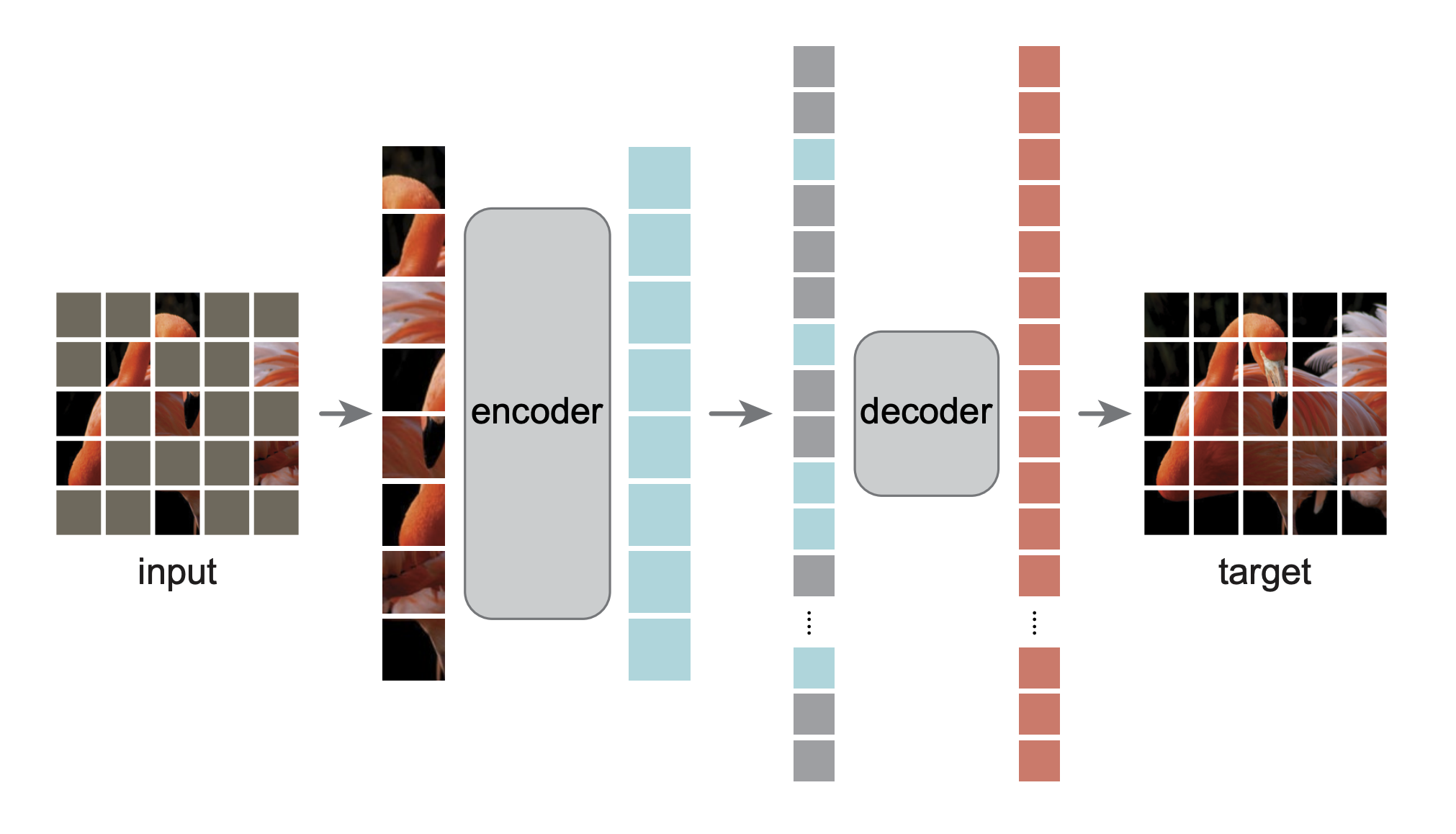

這是論文 Masked Autoencoders Are Scalable Vision Learners 的 PyTorch/GPU 重新實作:

@Article{MaskedAutoencoders2021,

author = {Kaiming He and Xinlei Chen and Saining Xie and Yanghao Li and Piotr Doll{'a}r and Ross Girshick},

journal = {arXiv:2111.06377},

title = {Masked Autoencoders Are Scalable Vision Learners},

year = {2021},

}

最初的實作是在 TensorFlow+TPU 中實現的。這次重新實作是在 PyTorch+GPU 中進行的。

該存儲庫是 DeiT 存儲庫的修改。安裝和準備遵循該存儲庫。

此儲存庫基於timm==0.3.2 ,需要修復才能與 PyTorch 1.8.1+ 一起使用。

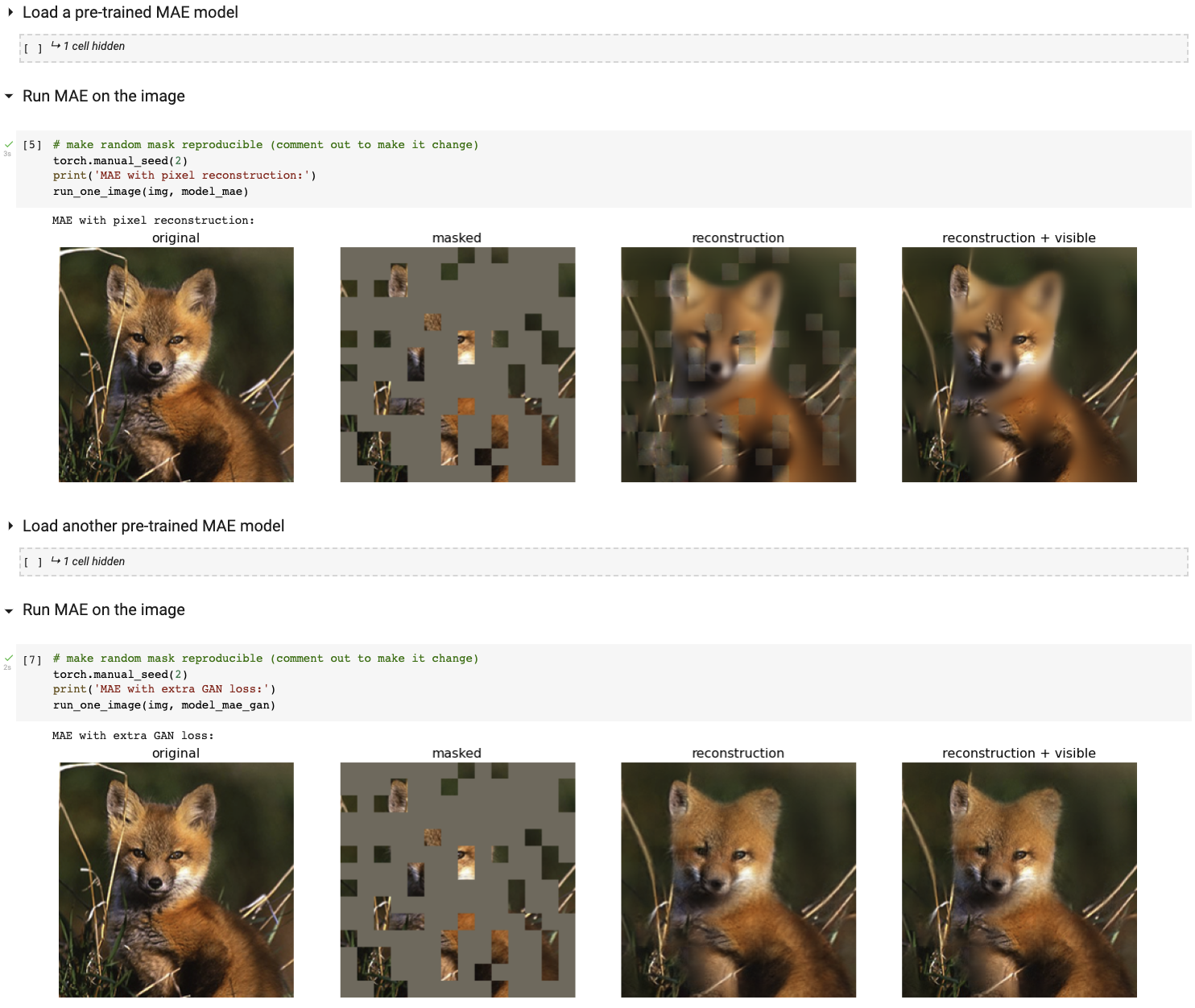

使用 Colab 筆記本運行我們的互動式視覺化演示(不需要 GPU):

下表提供了論文中使用的預訓練檢查點,從 TF/TPU 轉換為 PT/GPU:

| ViT-基礎 | ViT-大號 | ViT-巨大 | |

|---|---|---|---|

| 預訓練檢查點 | 下載 | 下載 | 下載 |

| MD5 | 8cad7c | b8b06e | 9bdbb0 |

微調指令位於 FINETUNE.md 中。

透過微調這些預訓練模型,我們在這些分類任務中排名第一(論文中有詳細介紹):

| 維生素B | 維T-L | 維T-H | 維特-H 448 | 上一個最佳 | |

|---|---|---|---|---|---|

| ImageNet-1K(無外部資料) | 83.6 | 85.9 | 86.9 | 87.8 | 87.1 |

| 以下是相同模型權重的評估(在原始 ImageNet-1K 中進行微調): | |||||

| ImageNet-損壞(錯誤率) | 51.7 | 41.8 | 33.8 | 36.8 | 42.5 |

| ImageNet-對抗性 | 35.9 | 57.1 | 68.2 | 76.7 | 35.8 |

| ImageNet 渲染 | 48.3 | 59.9 | 64.4 | 66.5 | 48.7 |

| ImageNet-Sketch | 34.5 | 45.3 | 49.6 | 50.9 | 36.0 |

| 以下是透過在目標資料集上微調預先訓練的 MAE 進行的遷移學習: | |||||

| i自然主義者 2017 | 70.5 | 75.7 | 79.3 | 83.4 | 75.4 |

| i自然主義者 2018 | 75.4 | 80.1 | 83.0 | 86.8 | 81.2 |

| iNaturalists 2019 | 80.5 | 83.4 | 85.7 | 88.3 | 84.1 |

| 地點205 | 63.9 | 65.8 | 65.9 | 66.8 | 66.0 |

| 地點365 | 57.9 | 59.4 | 59.8 | 60.3 | 58.0 |

預訓練指令位於 PRETRAIN.md 中。

此專案採用 CC-BY-NC 4.0 授權。有關詳細信息,請參閱許可證。