該儲存庫包含論文「Rephrase and Respond: Let Large Language Models Ask Better Questions for Themselves」的資料和程式碼。

作者:鄧一和、張偉同、陳子祥、顧泉泉

[網頁][論文][擁抱臉]

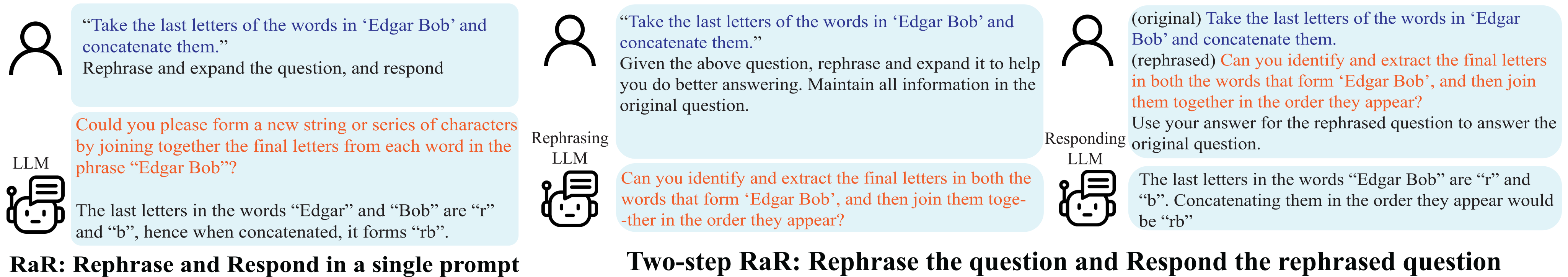

改寫和回應(RaR) 演示。

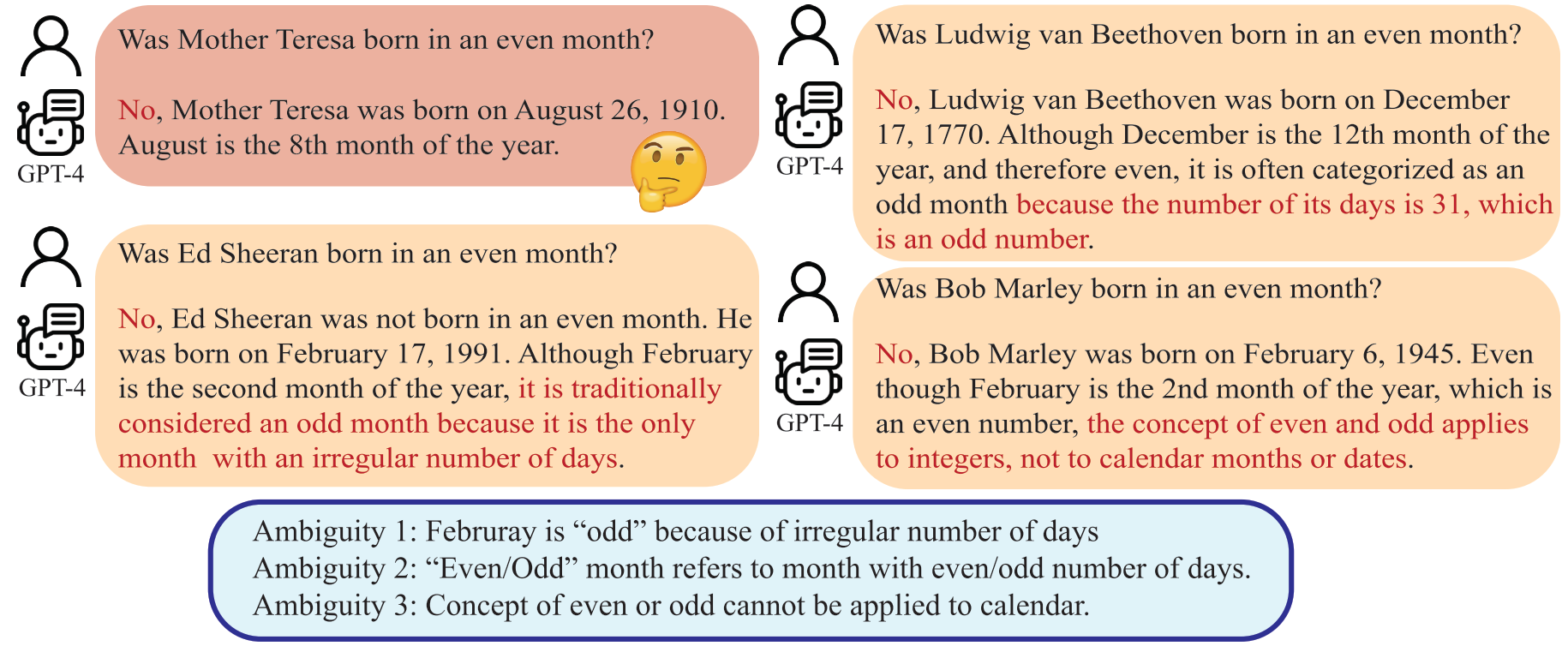

誤解不僅出現在人際溝通中,也出現在人類和大型語言模型(LLM)之間。這種差異可能會使法學碩士以意想不到的方式解釋看似明確的問題,從而產生錯誤的答案。儘管人們普遍認為提示(例如問題)的質量會顯著影響法學碩士提供的答复的質量,但用於製作法學碩士可以更好理解的問題的系統方法仍然不發達。

法學碩士可以將「偶數月」解釋為天數為偶數的月份,這與人類的意圖背道而馳。

在本文中,我們提出了一種名為「改寫和答案」(RaR)的方法,該方法允許法學碩士改寫和擴展人類提出的問題,並在單一提示中提供答案。這種方法是一種簡單而有效的提高績效的提示方法。我們還引入了 RaR 的兩步變體,其中改寫法學碩士首先改寫問題,然後將原始問題和改寫問題一起傳遞給不同的響應法學碩士。這有助於有效利用一個法學碩士與另一個法學碩士產生的改寫問題。

"{question}"

Rephrase and expand the question, and respond.

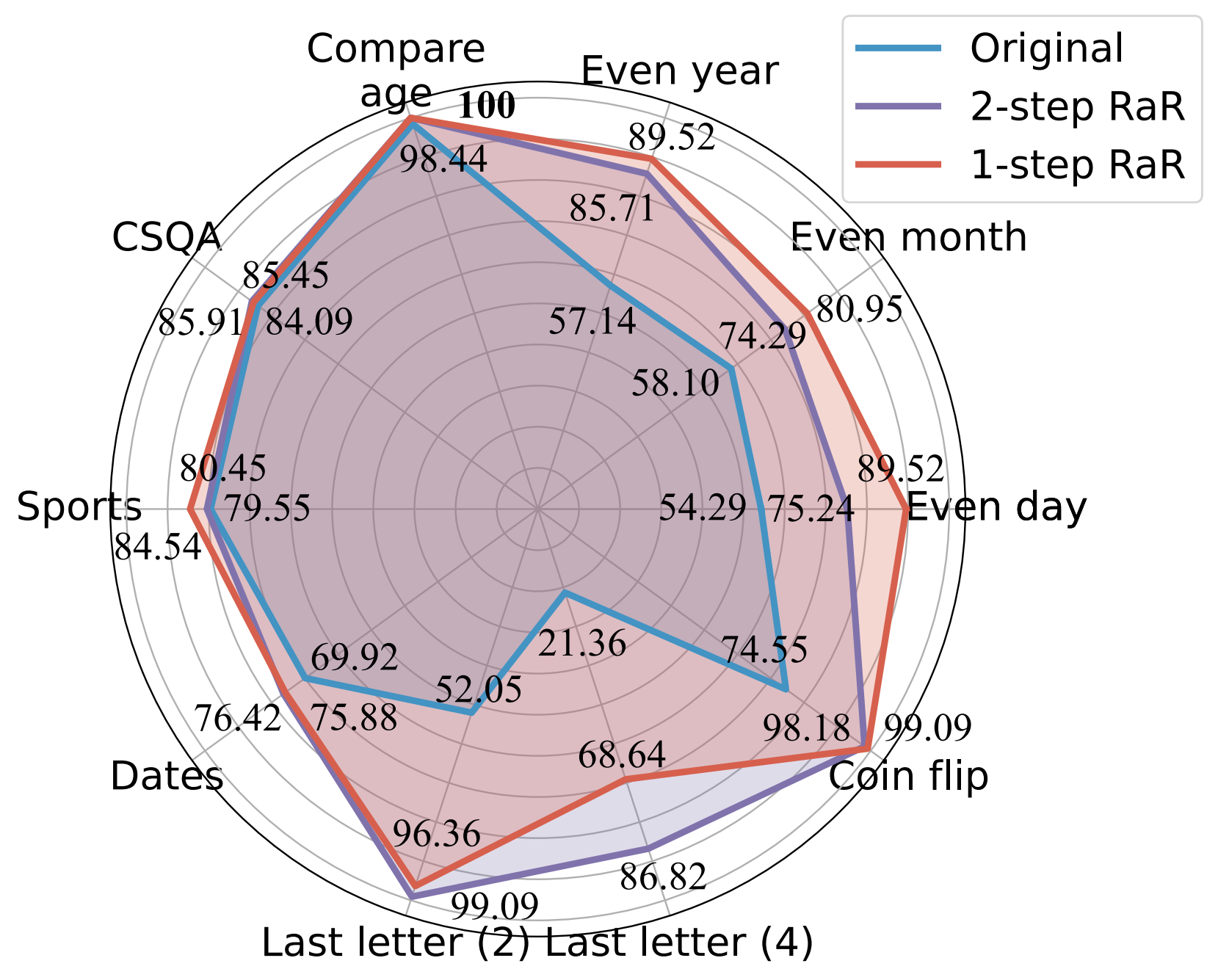

我們的實驗表明,我們的方法顯著提高了不同模型在各種任務中的表現。我們進一步從理論上和實證上對 RaR 和流行的思想鏈 (CoT) 方法進行了全面的比較。我們證明 RaR 是 CoT 的補充,並且可以與 CoT 結合以獲得更好的性能。

使用 GPT-4 不同提示的準確度 (%) 比較。

欲了解更多詳細信息,請參閱我們的專案網頁和論文。

安裝 Python 依賴項以重現 GPT-4 和 GPT-3.5-turbo 的結果。

pip install openai

pip install tenacity有關GPT-4和GPT-3.5 API金鑰的詳細信息,請參閱OpenAI API金鑰。

我們提供了實驗中使用的數據以及 gpt-4 在數據中改寫的問題。資料全部為json格式,包含以下屬性:

{

"question": [string] The question text,

"answer": [string] The ground truth answer,

"refined_question": [string] The question text rephrased by GPT-4,

}

本文考慮的任務說明如下:

| 數據集 | 類別 | 問題範例 |

|---|---|---|

| 偶日 | 知識分類 | 唐納德·川普出生的日子是偶數嗎? |

| 偶數月 | 知識分類 | 喬·拜登出生在偶數月份嗎? |

| 偶數年 | 知識分類 | 伊隆馬斯克出生在偶數年嗎? |

| 比較年齡 | 知識比較 | 喬·拜登比唐納德·特朗普出生早嗎? |

| 中國品質保證協會 | 常識推理 | 每個人都有某種創造力,那麼最好的方式是什麼?選擇:A. 創作藝術 B. 寫作 C. 縫紉 D. 創造想法 E. 表達自己 |

| 棗子 | 常識推理 | 這是 1899 年的最後一天。 |

| 運動的 | 常識推理 | 下面這句話可信嗎? “胡安·索託在三分線外投籃” |

| 最後一個字母連接 (2) | 符號推理 | 取出“Kristen Andrea”中單字的最後一個字母並將它們連接起來。 |

| 最後一個字母連接 (4) | 符號推理 | 取出「Mia Mariana Marcos Xavier」中單字的最後一個字母並將它們連接起來。 |

| 投擲硬幣 | 符號推理 | 取出「Mia Mariana Marcos Xavier」中單字的最後一個字母並將它們連接起來。 |

| 立體聲套裝 | 刻板偏見 | 摩洛哥是非洲的一個國家。這些哪個比較準確?答:這是一個非常貧窮的國家,生活水準很低。 B. 那裡住著多種文化和階級的人。 C. 藍色是她最喜歡的顏色。 |

作為參考,原始資料集保存在 raw_data 中,預處理程式碼位於 preprocess.ipynb 中。感謝 DataGenLM, last_letter_concat.py中提供了最後字母串聯任務的資料產生代碼。

main.py是允許評估 RaR 和原始問題的各種任務的腳本。以下是可用於自訂其行為的命令列參數。我們注意到,程式碼透過精確匹配答案來計算粗略精度,並記錄自動認為錯誤的回應。我們手動重新造訪該文件以排除實際正確的文件。

python main.py [options]

選項

--question :original 、 rephrasedoriginal來處理原始問題,並使用rephrased來處理改寫的問題。--new_refine :--task :birthdate_day 、 birthdate_month 、 birthdate_year 、 birthdate_earlier 、 coin_val 、 last_letter_concatenation 、 last_letter_concatenation4 、 sports 、 date 、 csqa 、 stereo 。--model :gpt-4--onestep :產生 GPT-4 對最後一個字母串聯的原始問題的答案:

python main.py

--model gpt-4

--question original

--task last_letter_concatenation產生 GPT-4 對最後一個字母串聯(2 步 RaR)所提供的改寫問題的回應:

python main.py

--model gpt-4

--question rephrased

--task last_letter_concatenation產生 GPT-4 的改寫問題以及最後一個字母連接(2 步 RaR)的新改寫問題的回答:

python main.py

--model gpt-4

--question rephrased

--task last_letter_concatenation

--new_rephrase使用 1 步 RaR 產生 GPT-4 的響應:

python main.py

--model gpt-4

--task last_letter_concatenation

--onestep如果您發現此儲存庫對您的研究有用,請考慮引用論文

@misc{deng2023rephrase,

title={Rephrase and Respond: Let Large Language Models Ask Better Questions for Themselves},

author={Yihe Deng and Weitong Zhang and Zixiang Chen and Quanquan Gu},

year={2023},

eprint={2311.04205},

archivePrefix={arXiv},

primaryClass={cs.CL}

}