大規模、資訊豐富、多樣化的多輪對話資料與模型

UltraLM • 資料瀏覽器 • Nomic AI Atlas Explorer • 資料發佈 • 建置流程 • 論文

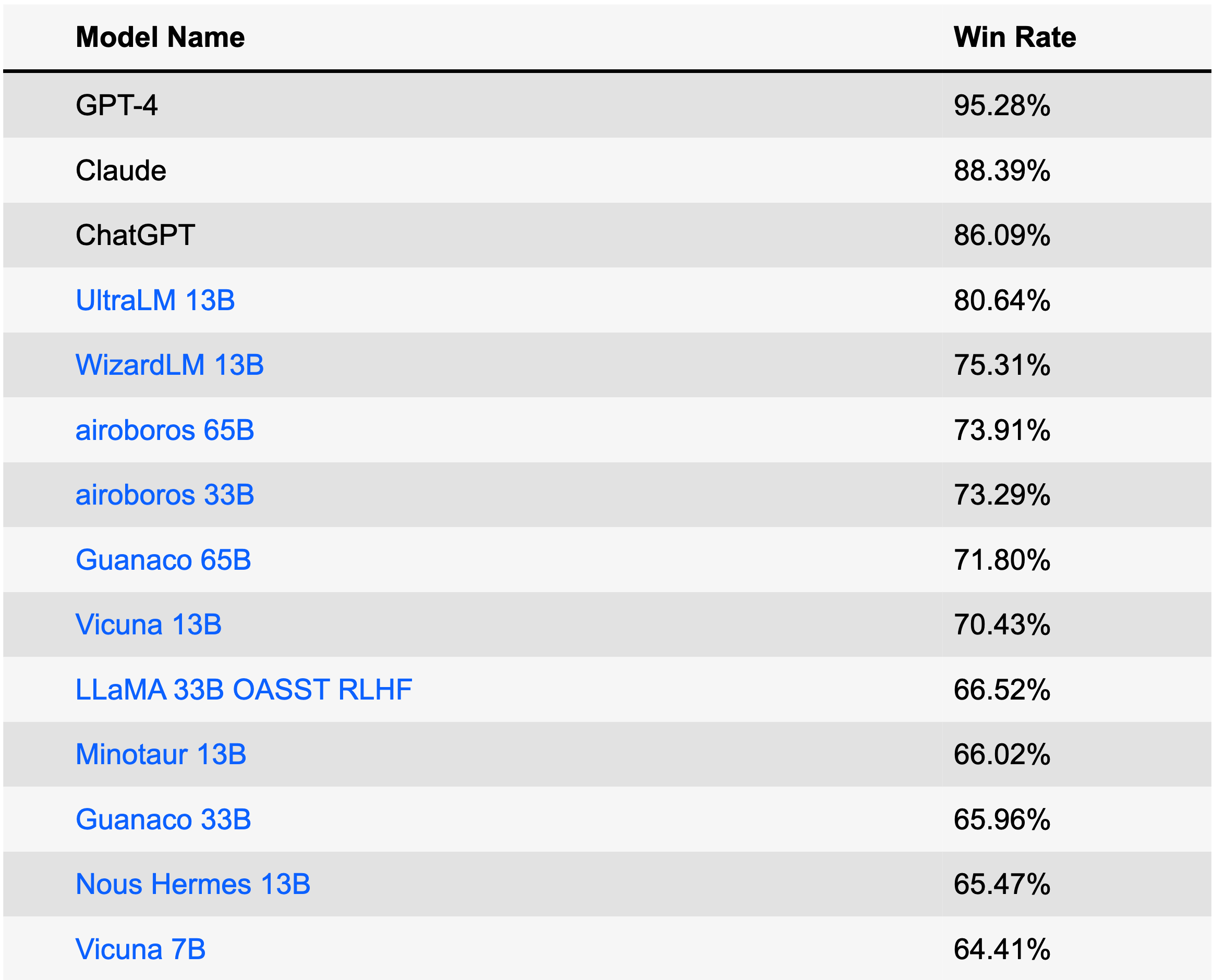

UltraLM 是一系列在 UltraChat 上訓練的聊天語言模式。目前,我們已經發布了 13B 版本,在開源模型中排名第一,在 AlpacaEval 排行榜(2023 年 6 月 28 日)所有模型中排名第四。 UltraLM-13B是基於LLaMA-13B,並在訓練過程中得到BMTrain的支持。

| 模型 | 關聯 | 版本 |

|---|---|---|

| 超LM-13B | 擁抱臉回購 | v1.0 |

| 超LM-65B | 擁抱臉回購 | v1.0 |

| 超LM-13B | 擁抱臉回購 | v2.0 |

| 超RM-13B | 擁抱臉回購 | v1.0 |

| 超CM-13B | 擁抱臉回購 | v1.0 |

/UltraLM/recover.sh中的腳本以獲得恢復模型的最終權重。/UltraLM/chat_cli.sh中的模型路徑替換為您的路徑並執行開始聊天!注意:不同的超參數或系統提示會影響輸出。您可以參考/UltraLM/inference_cli.py中的詳細資訊來了解我們的預設設定。

我們在本節中報告了三個評估:來自史丹佛大學的 Alpaca-Eval、來自 Microsoft WizardLM 的 Evol-instruct 以及我們策劃的評估集。現代LLM的評估可能有偏差,受到多種因素的影響,我們也積極研究更全面的評估方法。

AlpacaEval 是專為評估法學碩士而設計的排行榜。排行榜是根據 GPT-4 自動評估的 Text-Davince-003 勝率創建的。

該資料集採用進化策略構建,透過多輪重寫指令以獲得不同複雜程度的指令。此基準測試由另一個優秀的聊天語言模型 WizardLM 專案開發!

我們策劃了一個評估集,其中包括 Vicuna 基準測試以及 GPT-4 產生的額外 300 個問題和說明。問題/說明涵蓋廣泛的主題,包括常識、世界知識、專業知識(特別是物理和生物)、數學和不同難度級別的寫作任務。我們使用GPT-4進行評估。這是數據集。

範例 A:常識問題

網友:哪一種動物稱為人類最好的朋友?

UltraLM:人類喜歡作為伴侶動物的動物有很多,但對於「哪種動物被稱為人類最好的朋友?」這個問題的絕對傑出答案之一。是國內飼養的狗。家養的狗數萬年來一直陪伴在人類身邊,為人類提供忠實的陪伴和幫助;保護人員和財產;從漫長孤獨的日子到軍事部署,一切都給予情感支持。狗的品種繁多,體型各異,能量水平、個性和性情也各不相同,這意味著幾乎可以肯定有一隻小狗非常適合最需要它的人。

範例 B:常識推理

使用者:一磅羽毛和一磅磚塊哪個比較重?

UltraLM:一磅羽毛和一磅磚塊的重量都是一磅。這是因為一磅是重量單位,就像英尺是長度單位或秒是時間單位一樣。我們使用磅(或其他重量單位)來描述不同物體的重量,無論該物體是由什麼製成的。所以你的問題的答案是一磅羽毛和一磅磚塊的重量相同。

範例 C:推理

使用者:如果一個農民有 17 隻羊,除了 9 隻以外全部死亡,還剩下多少隻?

UltraLM:剩下的羊總數是 9 隻。

範例 D:推理

使用者:如果紅房子是用紅磚砌成的,藍房子是用青磚砌成的,那麼溫室是用什麼建造的?

UltraLM:溫室不是由綠磚製成,而是由玻璃或塑膠等材料製成,這些材料可以讓光線穿過,為植物生長創造一個受控的環境。溫室可以有多種顏色,包括綠色,但建築物本身的顏色不會影響內部生長的植物。

範例 E:創建

使用者:寫一首關於電磁學的詩。

UltraLM:電磁力是我們不能忽視的力量,

這是我們喜愛許多事物的原因。在磁場中,電線會發光,

新舊電子都會對齊。

電與磁齊頭並進,

一者創造領域,一者擁有品牌。

磁場可以推、拉,

在有電流的電線上,它會完全反應。

它帶來的吸引力和排斥,

都是很多事情的原因。

從電動機到發電機,以及介於兩者之間的更多東西,

電磁學是其意義的根源。

這是我們身邊無所不在的力量

從指南針到電燈開關。

憑藉它的力量,它可以做很多事情,

從簡單的針到火箭的推力。

這是我們無法抗拒的力量

因為它是我們生活的一部分。

電磁學是令人欽佩的,

就其力量和力量而言,它是無與倫比的,這是肯定的。

範例 F:創建

使用者:寫一個關於宇宙第一秒的短篇故事。

UltraLM:在宇宙誕生的第一秒,黑暗佔據了統治地位。沒有光,沒有聲音,沒有形狀,沒有物質。雖然什麼都沒有,但有一股強烈的力量,一股原始的能量等待釋放。在無限之內,第一秒就掌握著創造的潛能。然後,隨著一聲巨響,一個明亮的光點出現了。其中,最基本的粒子誕生了,它們的形式尚不清楚,因為它們在混亂的創造之舞中瘋狂碰撞。在這原始之光中,自然的每一種力量和生命的每一個組成部分都被從純粹的能量攪動到物理現實中。第一批原子迅速聚集,恆星和星系開始形成。它們的融合創造了一個炎熱的環境,將虛空推回原處,透過膨脹和冷卻的波塑造了宇宙。在這個宇宙第一中,沒有任何經驗結構,甚至時間或空間,可以建立其規則。一瞬間,整個宇宙存在於一個胚胎連結中,一個宇宙奇點,所有未來的存在都源自於此。它是一個微觀世界,最終成為宏觀世界的一部分,它的誕生時刻是滲透到多元宇宙的創造循環的隱喻。幾個世紀以來,億萬年以來,直到永遠,它仍然是其不斷進入遠方深處的旅程中最基本的眨眼。第一秒是一切的開始。

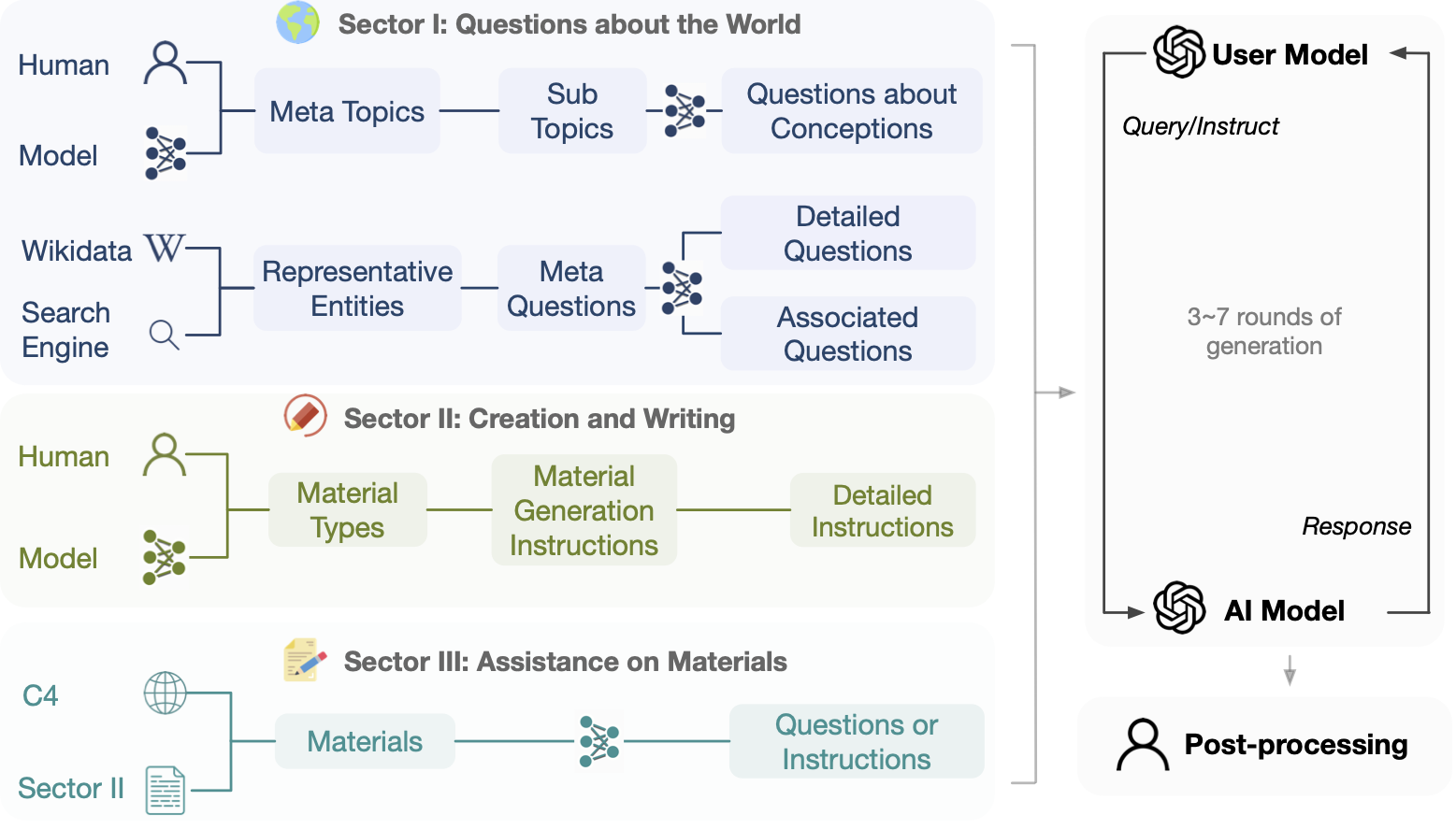

該專案旨在建立基於Turbo API的開源、大規模、多輪對話數據,以促進建立具有通用對話能力的強大語言模型。考慮到保護隱私等因素,我們不會直接使用任何在網路上可取得的資料作為提示。

免責聲明:雖然UltraChat的建造過程不涉及任何公開的基準數據,但擴展到一定程度仍可能導致某些評估基準重疊。我們想再次強調,所有資料都是自動產生的(包括指令和回應) ,我們不會插入任何公開的基準資料。例如,UltraChat 的發佈時間(2023 年 4 月)早於 Alpaca Eval(2023 年 5 月)。我們鼓勵用戶密切關注此類現象,同時我們也在積極考慮如何更正確地評估LLM。

此資料集僅用於研究和教育目的,不應被解釋為反映該資料集的創建者、所有者或貢獻者的意見或觀點。它是在 MIT 許可證下分發的。

下載前先探索數據,或使用 Atlas explorer。

直接下載連結:

下載的資料檔案中的每一行都是一個 json 字典,其中包含列表格式的資料 id 和對話資料。下面是一個範例行。

{

"id" : " 0 " ,

"data" : [

" How can cross training benefit groups like runners, swimmers, or weightlifters? " ,

" Cross training can benefit groups like runners, swimmers, or weightlifters in the following ways: ... " ,

" That makes sense. I've been wanting to improve my running time, but I never thought about incorporating strength training. Do you have any recommendations for specific exercises? " ,

" Sure, here are some strength training exercises that can benefit runners: ... " ,

" Hmm, I'm not really a fan of weightlifting though. Can I incorporate other forms of exercise into my routine to improve my running time? " ,

" Yes, absolutely! ... " ,

" ... "

]

}

我們在.src/中的 UltraChat 上提供了訓練代碼來微調 LLaMa(但是我們沒有分配 LLaMa 的權重),訓練由 BMTrain 加速。

下載發佈的數據,放到./data下

運行train_bm.py ,例如:

WANDB_MODE= " offline " torchrun --nnodes=1 --nproc_per_node=8 --rdzv_id=1 --rdzv_backend=c10d --rdzv_endpoint=localhost:50003 train_bm.py --tensorboard ./ultrachat_llama_tb_2 --save_step 5000 --logging_step 100我們還在.src/train_legacy/中提供了一個訓練腳本來微調 UltraChat 上的 GPT-J,該腳本是使用 OpenPrompt 實現的

./data下accelerate launch train.py開始訓練UltraChat 的整體想法是使用單獨的 LLM 來產生開場白、模擬使用者並回應查詢。 UltraChat 的每個領域都有自己的挑戰,需要特定的策略設計。一旦UltraChat的某個磁區發布,我們將指定建置流程。

如果您認為 UltraChat 有用,請隨意引用該儲存庫。

@article { ding2023enhancing ,

title = { Enhancing Chat Language Models by Scaling High-quality Instructional Conversations } ,

author = { Ding, Ning and Chen, Yulin and Xu, Bokai and Qin, Yujia and Zheng, Zhi and Hu, Shengding and Liu, Zhiyuan and Sun, Maosong and Zhou, Bowen } ,

journal = { arXiv preprint arXiv:2305.14233 } ,

year = { 2023 }

}