Transformer in generating dialogue

1.0.0

該程式碼是 Paper Attention 的實現,是對話生成任務所需的一切,例如:聊天機器人、文字生成等。

感謝每一位提出問題並幫助解決問題的朋友。您的貢獻對於該專案的改進非常重要。由於編碼中對「靜態圖模式」的支援有限,我們決定將功能移至 2.0.0-beta1 版本。不過,如果您擔心 docker 建置和服務建立的版本問題所帶來的問題,我們仍然保留使用 tensorflow 1.12.x 版本透過 eager 模式編寫的舊版本程式碼可供參考。

|-- root/

|-- data/

|-- src-train.csv

|-- src-val.csv

|-- tgt-train.csv

`-- tgt-val.csv

|-- old_version/

|-- data_loader.py

|-- eval.py

|-- make_dic.py

|-- modules.py

|-- params.py

|-- requirements.txt

`-- train.py

|-- tf1.12.0-eager/

|-- bleu.py

|-- main.ipynb

|-- modules.py

|-- params.py

|-- requirements.txt

`-- utils.py

|-- images/

|-- bleu.py

|-- main-v2.ipynb

|-- modules-v2.py

|-- params.py

|-- requirements.txt

`-- utils-v2.py

眾所周知,翻譯系統只需將兩個不同句子的語法替換為問題和答案即可用於實現會話模型。畢竟,名為「序列到序列」的基本會話模型是從翻譯系統發展而來的。那麼,我們為什麼不去提高對話模型生成對話的效率呢?

隨著基於BERT的模式的發展,越來越多的nlp任務不斷刷新。不過,BERT 的開源任務中並不包含該語言模型。毫無疑問,在這條路上我們還有很長的路要走。

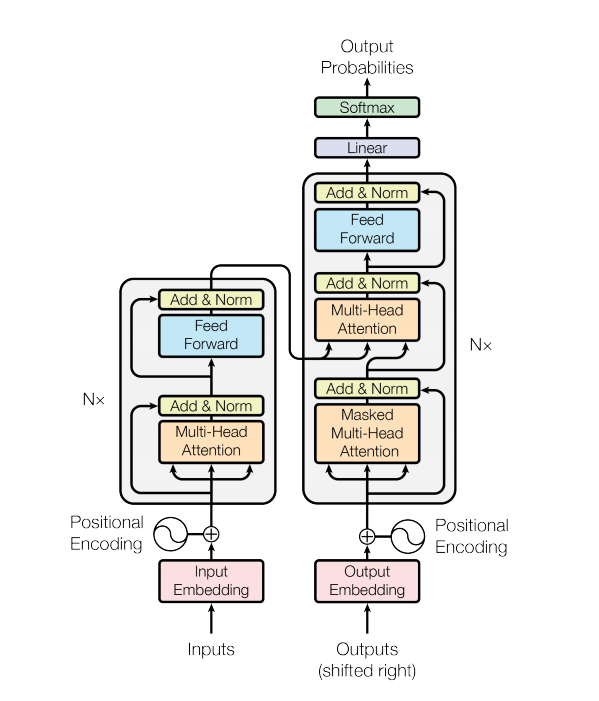

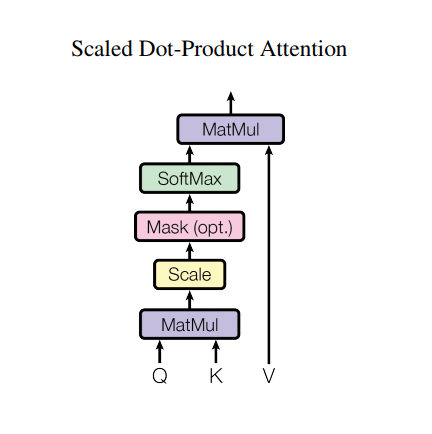

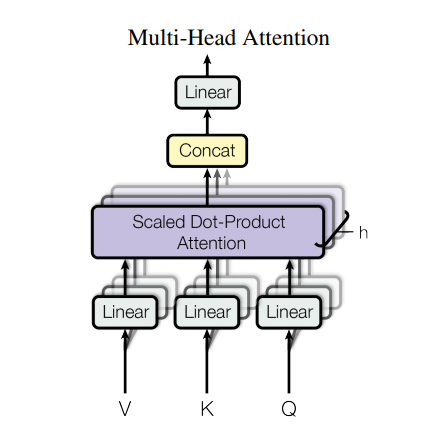

Transformer 模型使用自註意力層堆疊而不是 RNN 或 CNN 來處理可變大小的輸入。這種通用架構有許多優點和特殊之處。現在讓我們把它們拿出來:

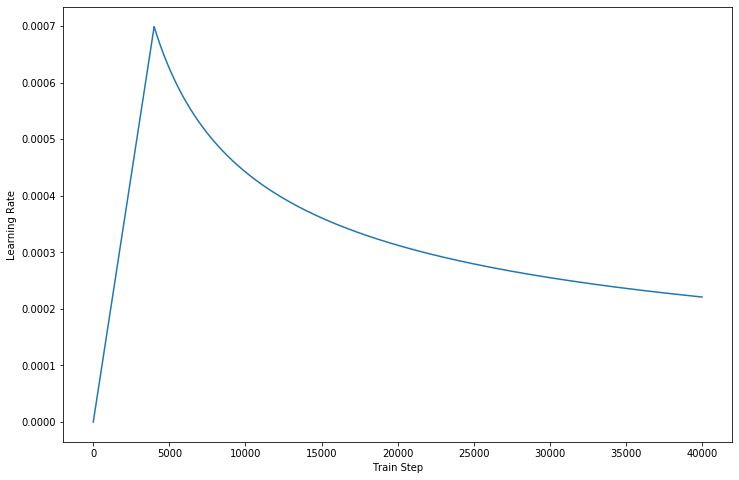

在我們的程式碼的最新版本中,我們完成了論文中描述的細節。

然而,如此強大的架構仍然有一些缺點:

data/資料夾中。params.py中的超參數。make_dic.py將詞彙檔案產生到名為dictionary的新資料夾中。train.py來建立模型。檢查點將儲存在checkpoint資料夾中,而張量流事件檔案可以在logdir中找到。eval.py以使用測試資料評估結果。結果將儲存在Results資料夾中。GPU來加速訓練處理,請在程式碼中設定您的裝置。 - Source: 肥 宅 初 夜 可 以 賣 多 少 `

- Ground Truth: 肥 宅 還 是 去 打 手 槍 吧

- Predict: 肥 宅 還 是 去 打 手 槍 吧

- Source: 兇 的 女 生 484 都 很 胸

- Ground Truth: 我 看 都 是 醜 的 比 較 凶

- Predict: 我 看 都 是 醜 的 比 較 <UNK>

- Source: 留 髮 不 留 頭

- Ground Truth: 還 好 我 早 就 禿 頭 了

- Predict: 還 好 我 早 就 禿 頭 了

- Source: 當 人 好 痛 苦 R 的 八 卦

- Ground Truth: 去 中 國 就 不 用 當 人 了

- Predict: 去 中 國 就 不 會 有 了 -

- Source: 有 沒 有 今 天 捷 運 的 八 卦

- Ground Truth: 有 - 真 的 有 多

- Predict: 有 - 真 的 有 多

- Source: 2016 帶 走 了 什 麼 `

- Ground Truth: HellKitty 麥 當 勞 歡 樂 送 開 門 -

- Predict: <UNK> 麥 當 勞 歡 樂 送 開 門 -

- Source: 有 沒 有 多 益 很 賺 的 八 卦

- Ground Truth: 比 大 型 包 裹 貴

- Predict: 比 大 型 包 <UNK> 貴

- Source: 邊 緣 人 收 到 地 震 警 報 了

- Ground Truth: 都 跑 到 窗 邊 了 才 來

- Predict: 都 跑 到 <UNK> 邊 了 才 來

- Source: 車 震

- Ground Truth: 沒 被 刪 版 主 是 有 眼 睛 der

- Predict: 沒 被 刪 版 主 是 有 眼 睛 der

- Source: 在 家 跌 倒 的 八 卦 `

- Ground Truth: 傷 到 腦 袋 - 可 憐

- Predict: 傷 到 腦 袋 - 可 憐

- Source: 大 家 很 討 厭 核 核 嗎 `

- Ground Truth: 核 核 欠 幹 阿

- Predict: 核 核 欠 幹 阿

- Source: 館 長 跟 黎 明 打 誰 贏 -

- Ground Truth: 我 愛 黎 明 - 我 愛 黎 明 -

- Predict: 我 愛 <UNK> 明 - 我 愛 <UNK> 明 -

- Source: 嘻 嘻 打 打

- Ground Truth: 媽 的 智 障 姆 咪 滾 喇 幹

- Predict: 媽 的 智 障 姆 咪 滾 喇 幹

- Source: 經 典 電 影 台 詞

- Ground Truth: 超 時 空 要 愛 裡 滿 滿 的 梗

- Predict: 超 時 空 要 愛 裡 滿 滿 滿 的

- Source: 2B 守 得 住 街 亭 嗎 `

- Ground Truth: 被 病 毒 滅 亡 真 的 會 -

- Predict: <UNK> 守 得 住

如果您嘗試使用AutoGraph來加快訓練過程,請確保將資料集填入固定長度。由於訓練過程中會啟動圖重建操作,這可能會影響效能。我們的程式碼只保證2.0版本的效能,較低的可以嘗試參考。

感謝 Transformer 和 Tensorflow