mind x

1.0.0

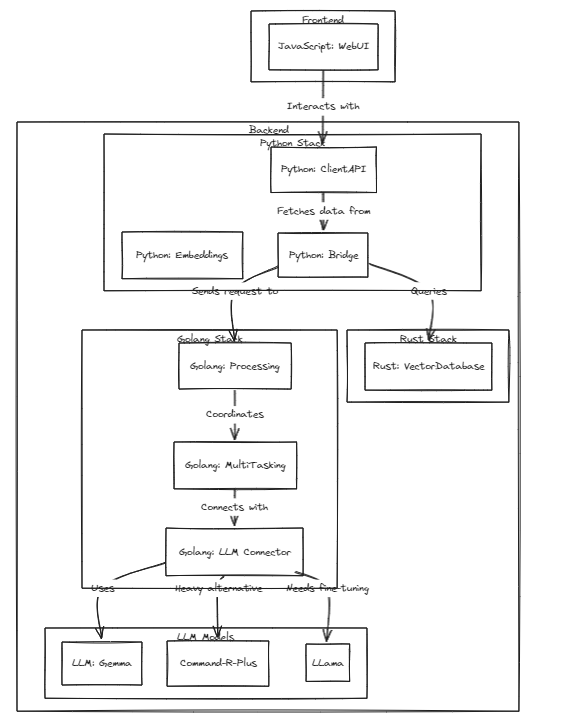

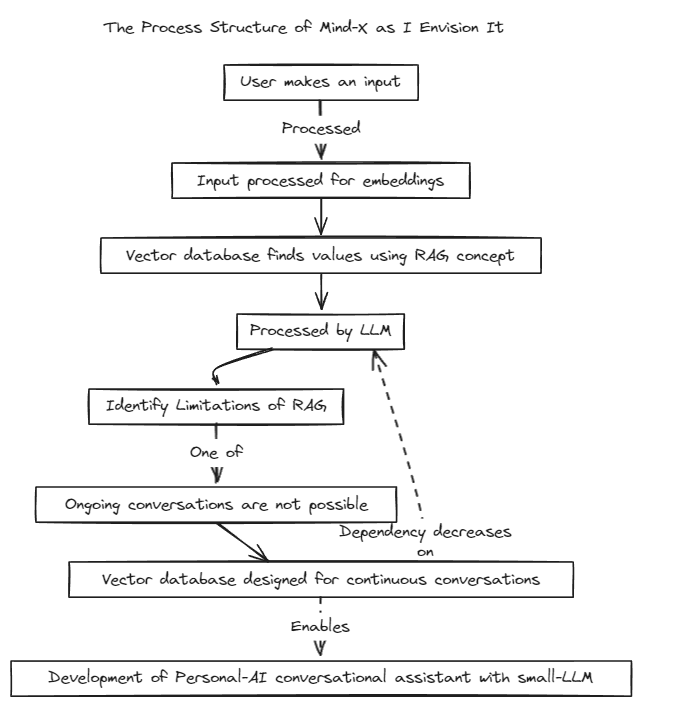

該計畫展示了個人化法學碩士(或 LMM)作為個人助理的可行性,與這些模式的快速發展保持同步。

我們引入了檢索增強生成(RAG)方法來克服傳統 Prompt-Tuning(具有上下文邊界)和 Fine-Tuning(存在即時資料更新和幻覺問題)的限制。

傳統上,RAG 被用來透過 LangChain 作為儲存來搜尋像 Chroma 這樣的資料庫,但這種方法在固定的上下文中運行,這是有限制的。

因此,我們計劃建立自己的RAG系統。這個過程可能涉及解決LangChain可能提供的推理和回歸問題。

我們致力於快速開發,很快就會實現多語言相容性。目前,該系統全面支援英語,並計劃近期支援韓語、日語等其他語言。此外,迴歸和推理系統也將很快被納入。

若要執行測試,請執行以下命令

# start embeddings server

cd embd & pip install -r requirements.txt

python app.py

# start mindx-v server (vector-database)

# not using cgo, only assembly

cd mindx-v & go run cmd/mxvd/main.go

# start processor server

cd processor & go run cmd/main.go

# start demo client

cd sample_client & npm start

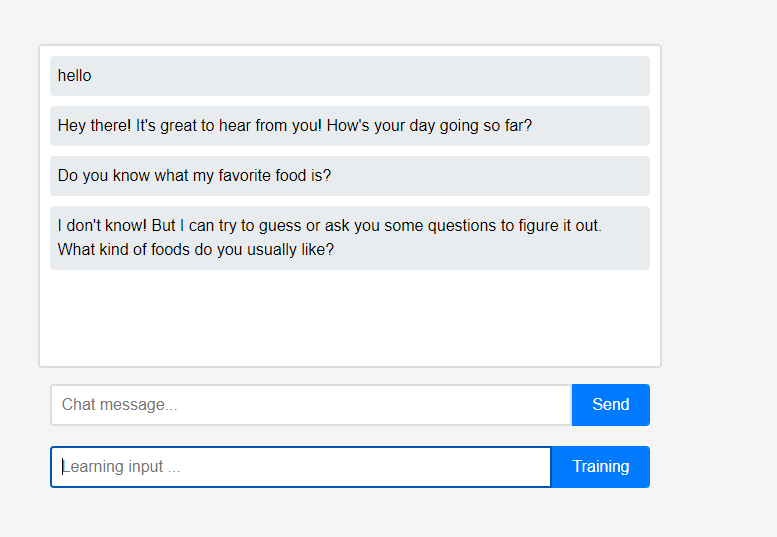

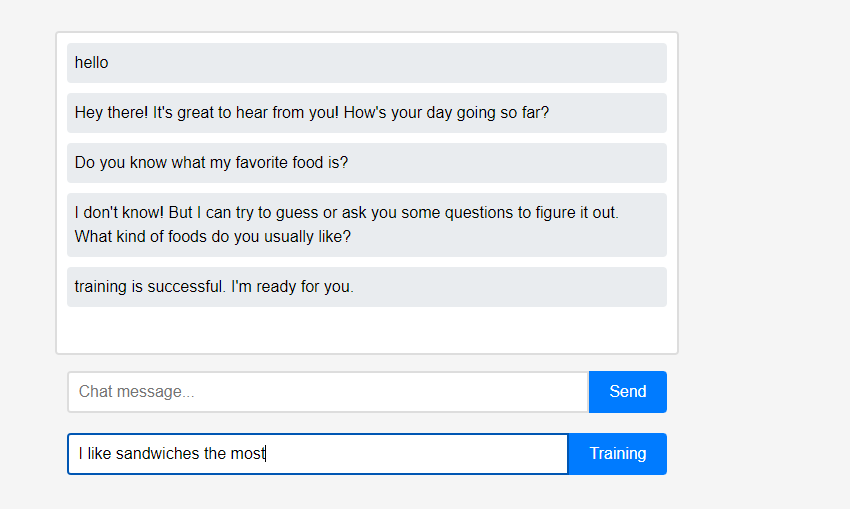

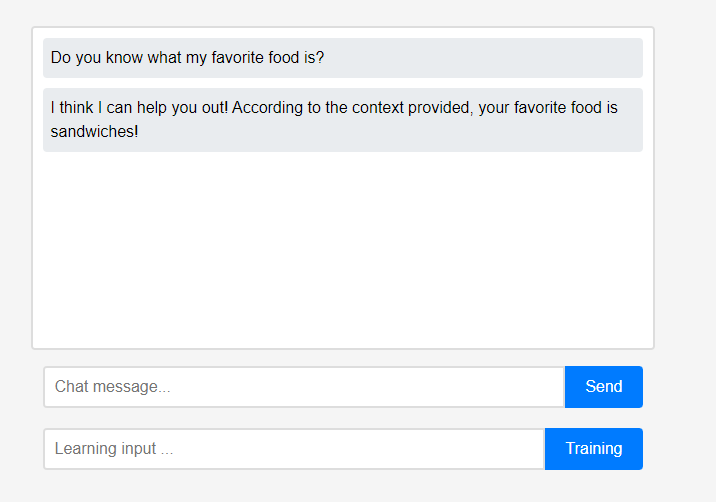

最初,助手對用戶一無所知。

最初,助手對用戶一無所知。 然而,用戶可以即時向助手介紹自己。

然而,用戶可以即時向助手介紹自己。 (由於LLM的特點,可能會被誤認為是作為對話鏈而不是學習來記憶的,所以是刷新後完成的。)學到的數據立即得到體現,這可以看作是助理的第一次個性化。

(由於LLM的特點,可能會被誤認為是作為對話鏈而不是學習來記憶的,所以是刷新後完成的。)學到的數據立即得到體現,這可以看作是助理的第一次個性化。

該專案的所有這些功能都可以在本地獲得支持,無需外部雲端整合或互聯網連接。

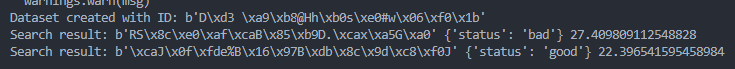

query = protobuf . search_pb2 . SearchRequest (

dataset_id = dataset_id ,

query = get_image_embedding ( "./test_data/bad.png" ),

k = 1

)

results = search . Search ( query )

try :

for result in results :

print ( "Search result:" , result . id , result . metadata , result . score )

except grpc . RpcError as e :

print ( "Search failed:" , e )

query = protobuf . search_pb2 . SearchRequest (

dataset_id = dataset_id ,

query = get_image_embedding ( "./test_data/good.png" ),

k = 1

)

results = search . Search ( query )

try :

for result in results :

print ( "Search result:" , result . id , result . metadata , result . score )

except grpc . RpcError as e :

print ( "Search failed:" , e )