VSA

1.0.0

[專案頁] [?論文] [?擁抱臉部空間] [模型動物園] [簡介] [?影片]

git clone https://github.com/cnzzx/VSA.git

cd VSA

conda create -n vsa python=3.10

conda activate vsa

cd models/LLaVA

pip install -e .

pip install -r requirements.txt

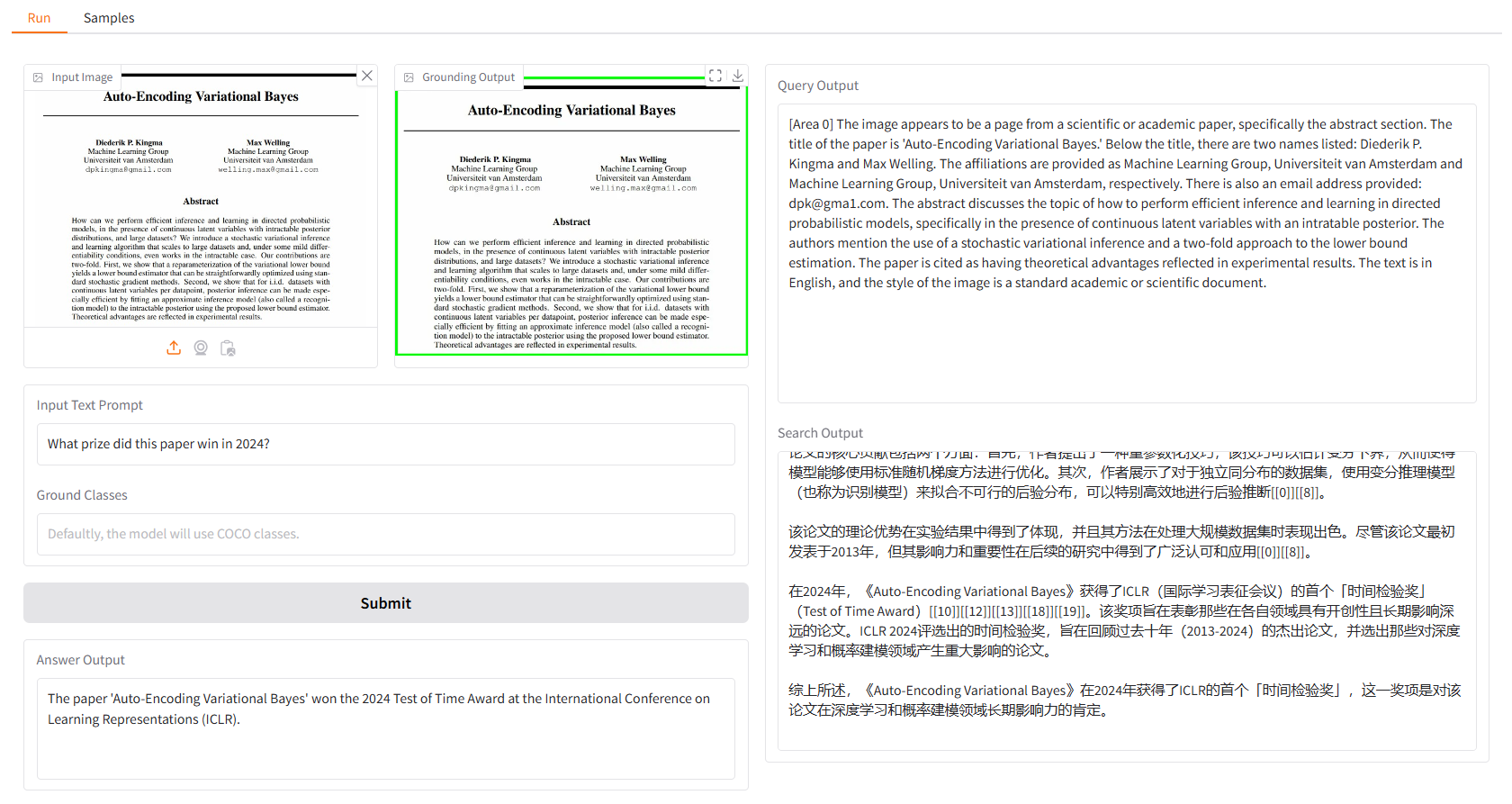

本地演示基於gradio,您可以簡單地運行:

python app.py

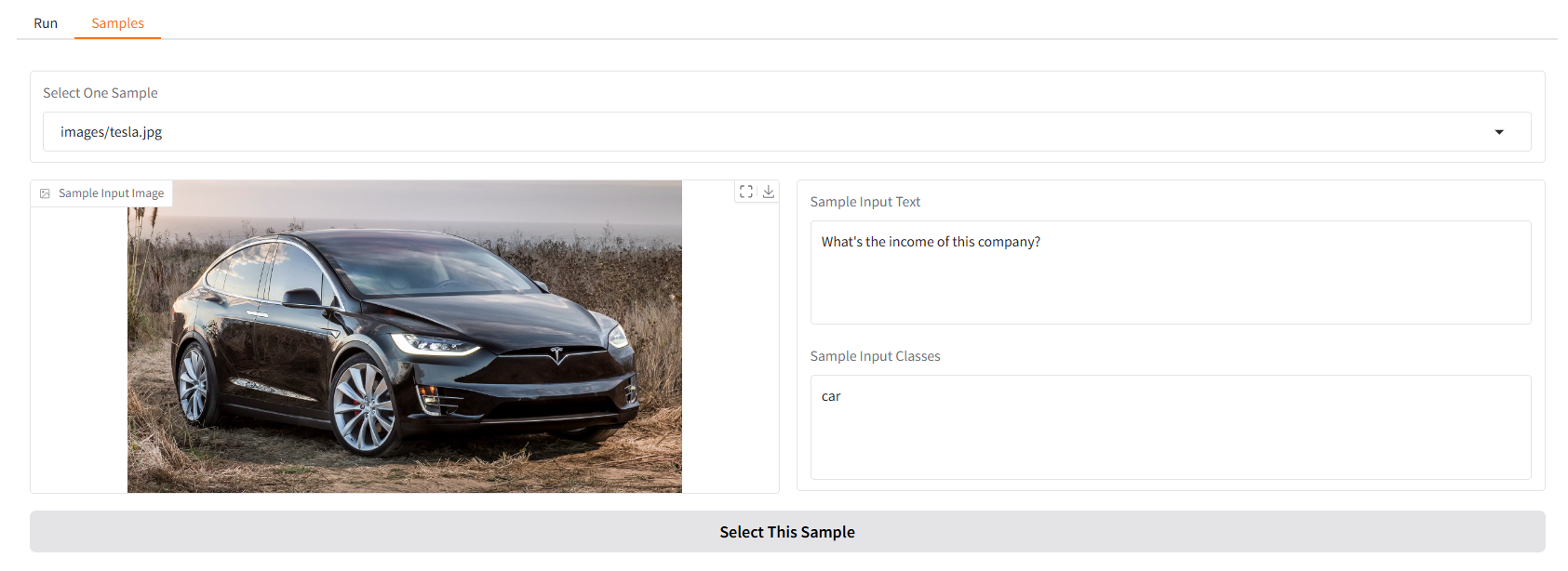

我們提供一些範例供您開始使用。在“Samples”UI 中,您可以在“Samples”面板中選擇一個,點擊“Select This Sample”,您會發現範例輸入已經填入“Run”UI 中。

您也可以透過運行在終端機中與我們的視覺搜尋助手聊天。

python cli.py

--vlm-model "liuhaotian/llava-v1.6-vicuna-7b"

--ground-model "IDEA-Research/grounding-dino-base"

--search-model "internlm/internlm2_5-7b-chat"

--vlm-load-4bit

然後,選擇圖像並輸入您的問題。

該專案是在 Apache 2.0 許可證下發布的。

Vision Search Assistant 深受以下對開源社群的傑出貢獻的啟發:GroundingDINO、LLaVA、MindSearch。

如果您發現該項目對您的研究有用,請考慮引用:

@article{zhang2024visionsearchassistantempower,

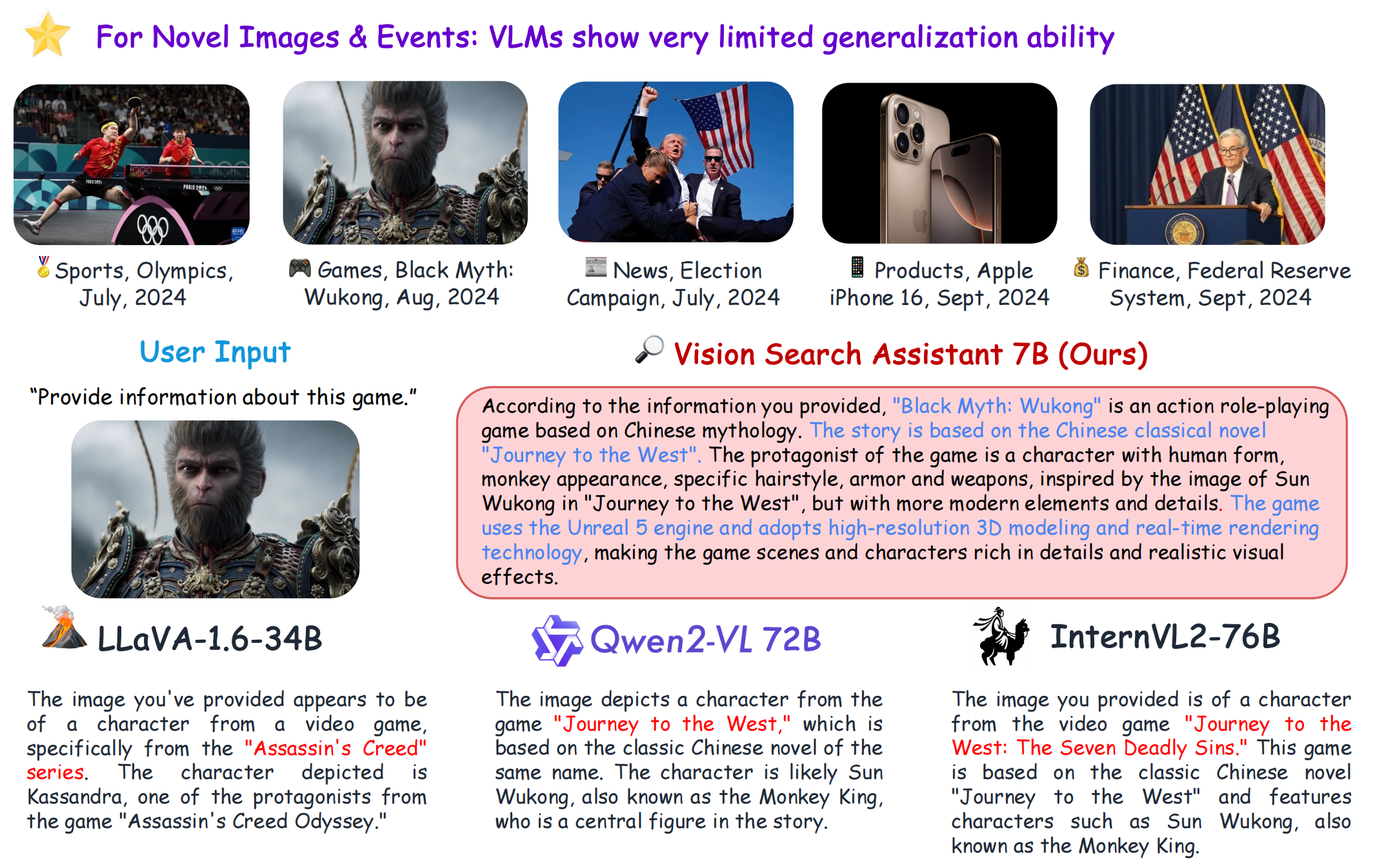

title={Vision Search Assistant: Empower Vision-Language Models as Multimodal Search Engines},

author={Zhang, Zhixin and Zhang, Yiyuan and Ding, Xiaohan and Yue, Xiangyu},

journal={arXiv preprint arXiv:2410.21220},

year={2024}

}