KoGPT2

1.0.0

GPT-2 是一種能夠很好地預測給定文本中下一個單字的語言模型,並且針對句子生成進行了最佳化。 KoGPT2是一種韓語decoder語言模型,使用超過 40GB 的文字進行學習,以克服韓語語言表現不足的問題。

|

使用tokenizers包中的Character BPE tokenizer進行訓練。

字典大小為51,200,透過添加表情符號和表情符號(例如對話中經常使用的表情符號)來提高令牌的識別能力,如下所示。

?, ?, ?, ?, ?, .. ,

:-),:),-),(-:...

此外,還定義了未使用的標記,例如<unused0>至<unused99>以便可以根據所需任務自由定義和使用它們。

> from transformers import PreTrainedTokenizerFast

> tokenizer = PreTrainedTokenizerFast . from_pretrained ( "skt/ KoGPT2 -base-v2" ,

bos_token = '</s>' , eos_token = '</s>' , unk_token = '<unk>' ,

pad_token = '<pad>' , mask_token = '<mask>' )

> tokenizer . tokenize ( "안녕하세요. 한국어 GPT-2 입니다.?:)l^o" )

[ '▁안녕' , '하' , '세' , '요.' , '▁한국어' , '▁G' , 'P' , 'T' , '-2' , '▁입' , '니다.' , '?' , ':)' , 'l^o' ]| 模型 | 參數數量 | 類型 | 層數 | 頭數 | ffn_dim | 隱藏的尺寸 |

|---|---|---|---|---|---|---|

KoGPT2 -base-v2 | 125M | 解碼器 | 12 | 12 | 3072 | 第768章 |

> import torch

> from transformers import GPT2LMHeadModel

> model = GPT2LMHeadModel . from_pretrained ( 'skt/ KoGPT2 -base-v2' )

> text = '근육이 커지기 위해서는'

> input_ids = tokenizer . encode ( text , return_tensors = 'pt' )

> gen_ids = model . generate ( input_ids ,

max_length = 128 ,

repetition_penalty = 2.0 ,

pad_token_id = tokenizer . pad_token_id ,

eos_token_id = tokenizer . eos_token_id ,

bos_token_id = tokenizer . bos_token_id ,

use_cache = True )

> generated = tokenizer . decode ( gen_ids [ 0 ])

> print ( generated )

근육이 커지기 위해서는 무엇보다 규칙적인 생활습관이 중요하다 .

특히 , 아침식사는 단백질과 비타민이 풍부한 과일과 채소를 많이 섭취하는 것이 좋다 .

또한 하루 30 분 이상 충분한 수면을 취하는 것도 도움이 된다 .

아침 식사를 거르지 않고 규칙적으로 운동을 하면 혈액순환에 도움을 줄 뿐만 아니라 신진대사를 촉진해 체내 노폐물을 배출하고 혈압을 낮춰준다 .

운동은 하루에 10 분 정도만 하는 게 좋으며 운동 후에는 반드시 스트레칭을 통해 근육량을 늘리고 유연성을 높여야 한다 .

운동 후 바로 잠자리에 드는 것은 피해야 하며 특히 아침에 일어나면 몸이 피곤해지기 때문에 무리하게 움직이면 오히려 역효과가 날 수도 있다 ...| NSMC(acc) | KorSTS(矛兵) | |

|---|---|---|

| KoGPT2 2.0 | 89.1 | 77.8 |

除了韓文維基百科之外,還使用了新聞、大家語料庫v1.0等各種資料來訓練模型。

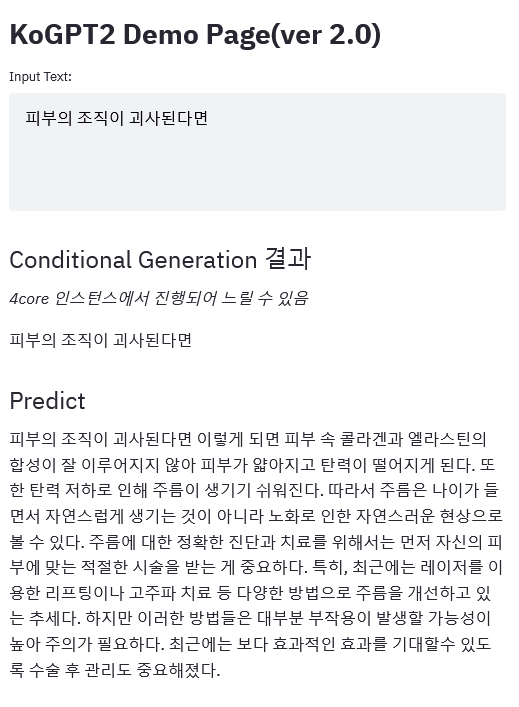

示範連結

|

請在此發布與KoGPT2相關的問題。

KoGPT2根據 CC-BY-NC-SA 4.0 授權發布。使用模型和代碼時請遵守許可條款。完整的許可證可以在 LICENSE 文件中找到。