Study-Bot是由Tecnológico de Monterrey的Edumakers開發的開源專案。它旨在幫助視障學生複習他們的學術課程材料。它是一款由人工智慧驅動的學習伴侶,融合了各種技術,包括 Whisper、GPT-3.5-turbo-16k、Elevenlabs 文字轉語音和 OpenCV。出於測試目的,範例課程材料是使用 ChatGPT 產生的。

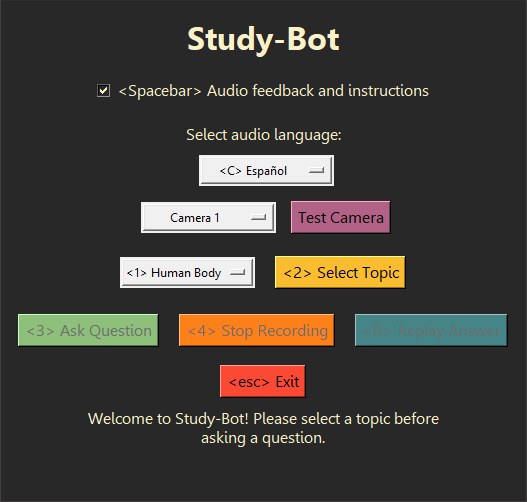

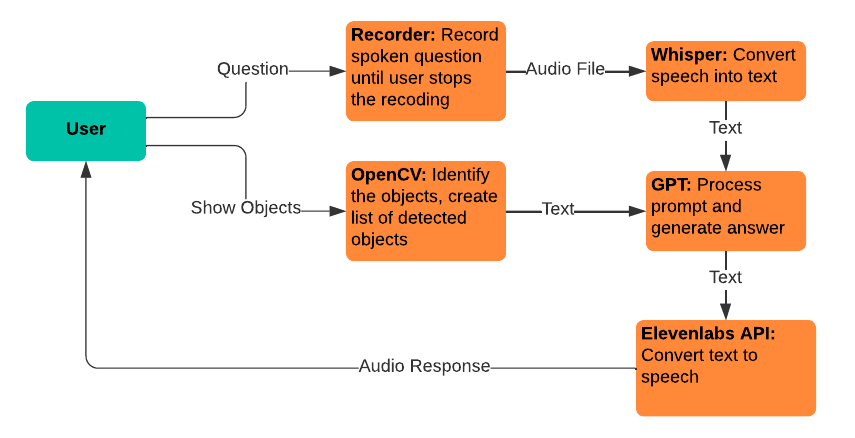

Study-Bot可以:聆聽用戶的問題,分析他們想要學習的主題的來源材料,透過顏色或 ArUco 標記檢測他們持有的體育材料,生成答案,並將其大聲朗讀給用戶用戶作為可訪問的可執行應用程式。出於開發和測試目的,它可以透過Python解釋器作為CLI程式或使用GUI運行。

接下來的一些好的步驟可能是將這個系統嵌入到更高級的用戶界面中,以作為桌面應用程式分發,創建一個電腦視覺模型,可以在不依賴顏色或ArUco 標記的情況下檢測體育材料,以及一些性能改進和新的互動功能。

建議使用Python 3.9.9,這樣whisper函式庫就可以正常使用。為了避免刪除目前的Python安裝,您可能需要使用虛擬環境來使用此特定版本的Python 。若要安裝所需的依賴項,請執行以下命令:

pip install -r requirements.txt在執行專案之前還需要採取一些額外的步驟,例如為此處使用的 AI 服務取得您自己的 API 金鑰。有關更多信息,請參閱Documentation資料夾以獲取有關如何使用此項目的綜合指南。

Study-Bot依賴以下現有服務和技術:

Whisper:用於語音到文字的轉換,允許使用者說出他們的問題以輸入 GPT 模型。

gpt-3.5-turbo-16k:用於問題處理和答案生成。選擇該模型的 16k 版本是因為其具有 16,385 個令牌上下文視窗大小,這是處理大量來源材料所需的。

Elevenlabs 文字轉語音:用於文字轉語音的轉換,讓使用者可以聽到 GPT 模型產生的答案。

OpenCV:用於實體物件識別,以協助 GPT-3.5-16k 模型回答問題,並新增使用者所持物品的上下文。

使用這個項目作為您自己的參考,或分叉它來做出自己的貢獻。歡迎提出有關功能請求和錯誤報告的 GitHub 問題,如果其中包含視障用戶的回饋,則特別有價值。