文檔|安裝| ?模型動物園| ?更新新聞|正在進行的項目|報告問題

介紹

MMDetection是基於Pytorch的開源對象檢測工具箱。它是OpenMMLAB項目的一部分。

主要分支與Pytorch 1.8+一起使用。

主要功能

模塊化設計

我們將檢測框架分解為不同的組件,並且可以通過組合不同的模塊來輕鬆構建自定義的對象檢測框架。

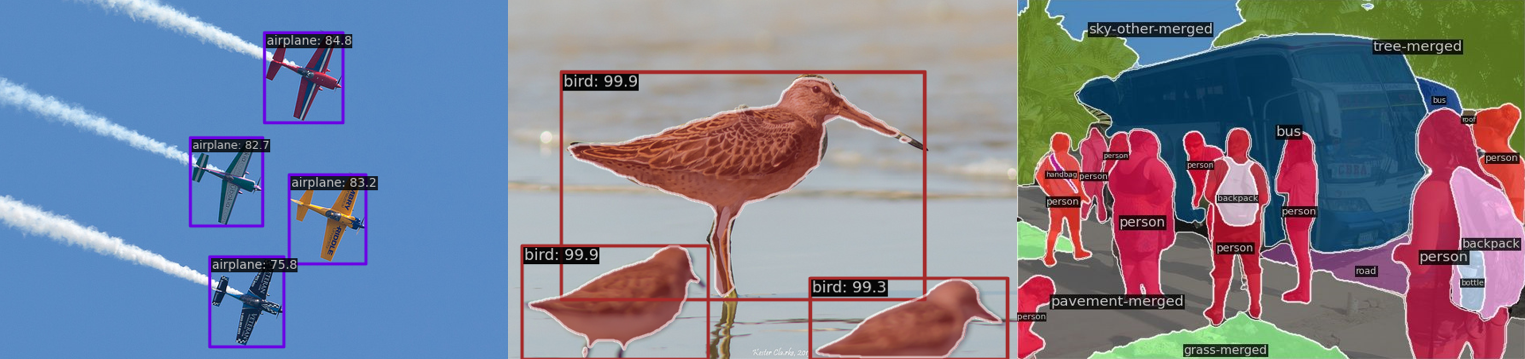

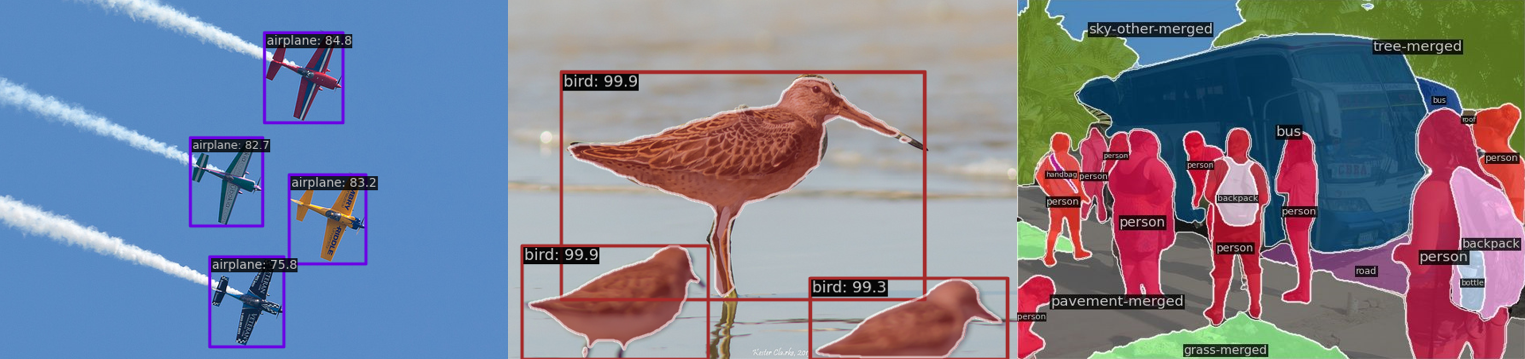

框外的多個任務的支持

該工具箱直接支持多個檢測任務,例如對象檢測,實例分割,全景分割和半監督對象檢測。

高效率

所有基本的Bbox和蒙版操作都在GPU上運行。訓練速度比其他代碼庫(包括detectron2,maskRCNN基準和SimpleDet)快或可比。

最先進的

該工具箱源於MMDET團隊開發的代碼庫,MMDET團隊在2018年贏得了可可檢測挑戰,我們不斷將其推動。新發布的RTMDET還在實時實例細分和旋轉的對象檢測任務以及對象檢測時獲得了最佳參數 - 準確性權衡方面的新最新結果。

除了MMDetection外,我們還發布了用於模型培訓的MMENGINE和用於計算機視覺研究的MMCV,這些工具箱在很大程度上依賴於該工具箱。

什麼是新的

?我們已經發布了用於MM-grounding-Dino Swin-B和Swin-L的預訓練的重量,歡迎嘗試提供反饋。

強調

v3.3.0於5/1/2024發布:

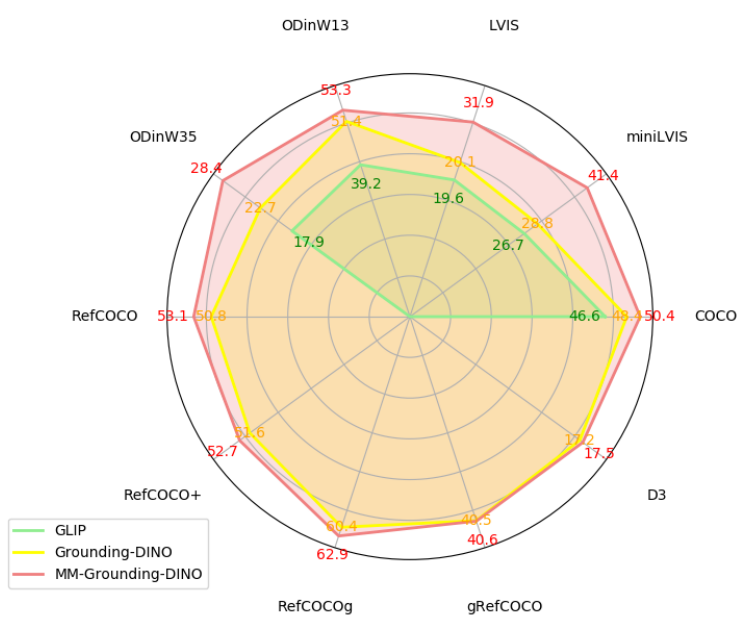

MM-Grounding-Dino:統一對象接地和檢測的開放式綜合管道

接地Dino是一種接地的預訓練模型,可統一2D開放詞彙對象檢測和短語接地,並具有廣泛的應用。但是,其培訓部分尚未開放。因此,我們提出了MM-Grounding-Dino,它不僅是接地Dino的開源複製版本,而且還基於重建的數據類型,探索了不同的數據集組合和初始化策略,可以實現重大的性能改進。此外,我們從多個維度進行評估,包括OOD,REC,短語接地,OVD和微調,以充分發掘基礎預培訓的優勢和缺點,希望為未來的工作提供靈感。

代碼:mm_grounding_dino/readme.md

我們很高興宣布我們關於實時對象識別任務的最新工作RTMDET ,這是一個完全卷積的單階段探測器的家族。 RTMDET不僅在從小到超大型模型大小的對象檢測中實現了最佳的參數準確性權衡取捨,而且還可以在實例細分和旋轉的對象檢測任務上獲得新的最新性能。詳細信息可以在技術報告中找到。預訓練的模型在這裡。

| 任務 | 數據集 | AP | FPS(TRT FP16 BS1 3090) |

|---|

| 對象檢測 | 可可 | 52.8 | 322 |

| 實例細分 | 可可 | 44.6 | 188 |

| 旋轉的對象檢測 | dota | 78.9(單尺度)/81.3(多尺度) | 121 |

安裝

請參閱安裝以獲取安裝說明。

入門

請參閱概述以獲取MMDetection的一般介紹。

有關詳細的用戶指南和高級指南,請參閱我們的文檔:

用戶指南

- 火車和測試

- 了解配置

- 與現有模型的推斷

- 數據集準備

- 在標準數據集上測試現有模型

- 在標準數據集上訓練預定義型號

- 使用自定義數據集進行培訓

- 使用定制模型和標準數據集的訓練

- 鑑定模型

- 測試結果提交

- 重量初始化

- 將單階段檢測器作為RPN

- 半監督對象檢測

- 有用的工具

高級指南

我們還提供對象檢測COLAB教程和實例分段COLAB教程。

要從MMDetection 2.X遷移,請參閱遷移。

基準和模型動物園的概述

模型動物園中可用結果和模型。

體系結構

| 對象檢測 | 實例細分 | 全景分割 | 其他 |

- 快速R-CNN(ICCV'2015)

- 更快的R-CNN(Neurips'2015)

- RPN(Neurips'2015)

- SSD(ECCV'2016)

- 視網膜(ICCV'2017)

- 級聯R-CNN(CVPR'2018)

- Yolov3(Arxiv'2018)

- Cornernet(ECCV'2018)

- 網格R-CNN(CVPR'2019)

- 引導錨定(CVPR'2019)

- FSAF(CVPR'2019)

- Centernet(CVPR'2019)

- 天秤座R-CNN(CVPR'2019)

- Tridentnet(ICCV'2019)

- FCO(ICCV'2019)

- 重新點(ICCV'2019)

- Freeanchor(Neurips'2019)

- Cascaderpn(Neurips'2019)

- Foveabox(Tip'2020)

- 雙頭R-CNN(CVPR'2020)

- ATSS(CVPR'2020)

- NAS-FCO(CVPR'2020)

- Centripetalnet(CVPR'2020)

- 自動分配(Arxiv'2020)

- 副意識邊界本地化(ECCV'2020)

- 動態R-CNN(ECCV'2020)

- DEDR(ECCV'2020)

- PAA(ECCV'2020)

- varifocalnet(CVPR'2021)

- 稀疏R-CNN(CVPR'2021)

- Yolof(CVPR'2021)

- YOLOX(CVPR'2021)

- 可變形的DETR(ICL'2021)

- TOOD(ICCV'2021)

- DDOD(ACM MM'2021)

- RTMDET(ARXIV'2022)

- 有條件的detr(ICCV'2021)

- dab-det(ICL'2022)

- Dino(ICL'2023)

- GLIP(CVPR'2022)

- DDQ(CVPR'2023)

- dibfusionDet(arxiv'2023)

- 有效插圖(CVPR'2020)

- VITDET(ECCV'2022)

- 診斷(ECCV'2022)

- Co-Det(ICCV'2023)

| - Mask R-CNN(ICCV'2017)

- Cascade Mask R-CNN(CVPR'2018)

- MASK評分R-CNN(CVPR'2019)

- 混合任務級聯(CVPR'2019)

- Yolact(ICCV'2019)

- Instaboost(ICCV'2019)

- 獨奏(ECCV'2020)

- Pointrend(CVPR'2020)

- 探測器(Arxiv'2020)

- Solov2(Neurips'2020)

- SCNET(AAAI'2021)

- QueryInst(ICCV'2021)

- mask2former(arxiv'2021)

- Condinst(ECCV'2020)

- 稀疏(CVPR'2022)

- RTMDET(ARXIV'2022)

- BoxInst(CVPR'2021)

- convnext-v2(arxiv'2023)

| - Panoptic FPN(CVPR'2019)

- MaskFormer(Neurips'2021)

- mask2former(arxiv'2021)

- Xdecoder(CVPR'2023)

| 對比度學習- SHAV(Neurips'2020)

- Moco(CVPR'2020)

- Mocov2(Arxiv'2020)

蒸餾- 定位蒸餾(CVPR'2022)

- 標籤分配蒸餾(WACV'2022)

半監督對象檢測 |

成分

| 骨幹 | 脖子 | 損失 | 常見的 |

- VGG(ICL'2015)

- Resnet(CVPR'2016)

- Resnext(CVPR'2017)

- Mobilenetv2(CVPR'2018)

- HRNET(CVPR'2019)

- 普遍注意(ICCV'2019)

- GCNET(ICCVW'2019)

- RES2NET(TPAMI'2020)

- Regnet(CVPR'2020)

- Resnest(Arxiv'2020)

- PVT(ICCV'2021)

- SWIN(CVPR'2021)

- PVTV2(ARXIV'2021)

- 重新擊退(Arxiv'2021)

- EfficityNet(Arxiv'2021)

- Consnext(CVPR'2022)

- Consnextv2(Arxiv'2023)

| - PAFPN(CVPR'2018)

- NAS-FPN(CVPR'2019)

- 汽車(ICCV'2019)

- FPG(arxiv'2020)

- 格羅伊(ICPR'2020)

- Dyhead(CVPR'2021)

| - GHM(AAAI'2019)

- 廣義局灶性損失(Neurips'2020)

- 毛線損失(CVPR'2021)

| - OHEM(CVPR'2016)

- 組歸一化(ECCV'2018)

- DCN(ICCV'2017)

- DCNV2(CVPR'2019)

- 重量標準化(ARXIV'2019)

- 主要樣本注意力(CVPR'2020)

- 強質基線(CVPR'2021)

- 重新擊退(Arxiv'2021)

|

使用MMDetection的項目中還支持了其他一些方法。

常問問題

請參閱常見問題解答以獲取常見問題。

貢獻

我們感謝為改善MMDetection的所有貢獻。正在進行的項目可以在OUT GITHUB項目中找到。歡迎社區用戶參與這些項目。請參閱貢獻指南的貢獻。

致謝

MMDetection是一個開源項目,由來自各學院和公司的研究人員和工程師貢獻。我們感謝所有實施方法或添加新功能的貢獻者以及提供寶貴反饋的用戶。我們希望工具箱和基準可以通過提供靈活的工具包來重新實現現有方法並開發自己的新探測器來為不斷增長的研究社區提供服務。

引用

如果您在研究中使用此工具箱或基準測試,請引用此項目。

@article{mmdetection,

title = {{MMDetection}: Open MMLab Detection Toolbox and Benchmark},

author = {Chen, Kai and Wang, Jiaqi and Pang, Jiangmiao and Cao, Yuhang and

Xiong, Yu and Li, Xiaoxiao and Sun, Shuyang and Feng, Wansen and

Liu, Ziwei and Xu, Jiarui and Zhang, Zheng and Cheng, Dazhi and

Zhu, Chenchen and Cheng, Tianheng and Zhao, Qijie and Li, Buyu and

Lu, Xin and Zhu, Rui and Wu, Yue and Dai, Jifeng and Wang, Jingdong

and Shi, Jianping and Ouyang, Wanli and Loy, Chen Change and Lin, Dahua},

journal= {arXiv preprint arXiv:1906.07155},

year={2019}

}

執照

該項目以Apache 2.0許可發布。

OpenMMLAB的項目

- Mmengine:用於培訓深度學習模型的OpenMMLAB基礎圖書館。

- MMCV:計算機視覺的OpenMMLAB基礎庫。

- MMMPRETRAIN:OpenMMLAB預訓練工具箱和基準測試。

- mmagic:開放MM實驗室A DVANCAND, G ENTIRATIVE和ITELLIPENT C REATION工具箱。

- mmDetection:OpenMMLAB檢測工具箱和基準測試。

- MMDetection3D:OpenMMLAB的一般3D對象檢測的下一代平台。

- mmrotate:OpenMMLAB旋轉對象檢測工具箱和基準測試。

- Myolo:OpenMMLAB YOLO系列工具箱和基準測試。

- MMSementation:OpenMMLAB語義分割工具箱和基準測試。

- MMOCR:OpenMMLAB文本檢測,識別和理解工具箱。

- mmpose:OpenMMLAB姿勢估計工具箱和基準。

- mmhuman3d:OpenMMLAB 3D人類參數模型工具箱和基準測試。

- MMSelfSup:OpenMMLAB自製學習工具箱和基準。

- mmrazor:OpenMMLAB模型壓縮工具箱和基準測試。

- mmfewshot:OpenMMLAB LIGHSHOT LEALLED TOOLBAX和BENCHMARK。

- MMACTION2:OpenMMLAB的下一代動作理解工具箱和基準測試。

- mmmtracking:OpenMMLAB視頻感知工具箱和基準測試。

- MMFlow:OpenMMLAB光流動工具箱和基準測試。

- mediting:OpenMMLAB圖像和視頻編輯工具箱。

- mmgeneration:OpenMMLAB圖像和視頻生成模型工具箱。

- mmdeploy:OpenMMLAB模型部署框架。

- MIM:MIM安裝OpenMMLAB軟件包。

- MMEVAL:用於多個機器學習庫的統一評估庫。

- 遊樂場:一個集中樞紐,用於收集和展示基於OpenMmlab的驚人項目。