RAIN

1.0.0

降雨是一種創新的推理方法,通過整合自我評估和倒帶機制,可以使凍結的大語言模型直接產生與人類偏好一致的響應,而無需其他對齊數據或模型進行微調,從而為AI安全提供了有效的解決方案。

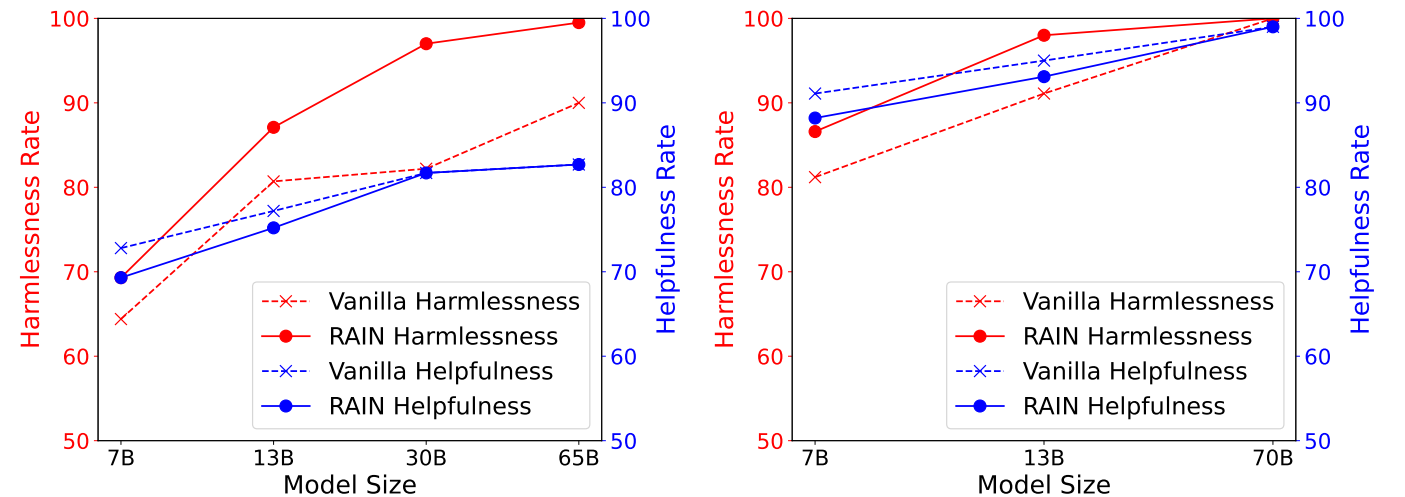

下圖顯示了擬人化的有益和無害(HH)數據集的實驗結果,顯示了HH數據集上不同推理方法的有益性與無害性率,由GPT-4評估。左:駱駝(7b,13b,30b,65b)。右: Llama-2(7b,13b,70b)。

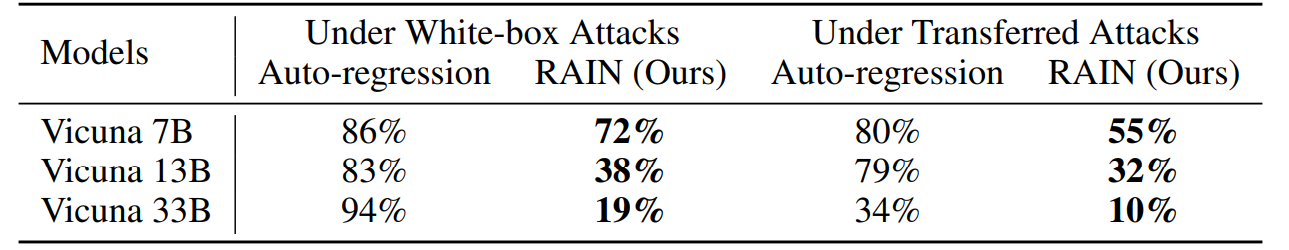

下圖在貪婪坐標梯度(GCG)攻擊下顯示了Advbench上的實驗結果。白框攻擊通過利用每個模型的梯度來優化特定的攻擊後綴,而轉移攻擊則利用Vicuna 7b和13b使用兩個模型的梯度的組合來優化通用攻擊後綴,並隨後使用它來攻擊其他模型。

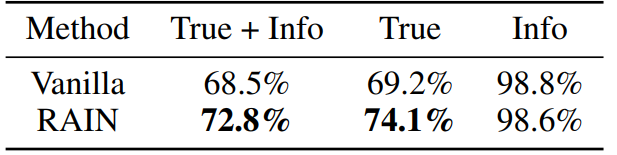

下圖用Llama-2-Chat 13B顯示了真實性數據集上的實驗結果。我們通過要求OpenAI的服務分別評估該模型的響應是否真實且內容豐富來微調兩個GPT-3模型。

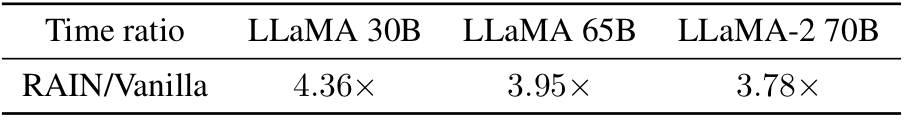

好奇的是香草推斷的時間開銷嗎?這裡是!從經驗上講,我們觀察到,對於較大(更安全)的型號,開銷較小。

conda env create -f rain.yaml

CD HH python分配。py--nump p

參數“ nump”表示過程數。如果在具有8 GPU並設置NUMP = 4的機器上運行,則每個進程將使用2個GPU。

CD ADV

您可以使用GCG生成對抗後綴或採用其他攻擊算法。將攻擊結果保存為“ yourdata.json”,並採用以下格式:

[

{“目標”:“指令或問題”,“控制”:“對抗後綴”},,

這是給出的python分配。

CD真相 python分配。py--nump p

有關技術細節和完整的實驗結果,請檢查論文。

@inproceedings{li2024rain,

author = {Yuhui Li and Fangyun Wei and Jinjing Zhao and Chao Zhang and Hongyang Zhang},

title = {RAIN: Your Language Models Can Align Themselves without Finetuning},

booktitle = {International Conference on Learning Representations},

year = {2024}

}如果您對代碼有任何疑問,請通過[email protected]與yuhui li聯繫。如果您發現此存儲庫有用,請考慮給予。