احصل على المساعدة - مناقشات الأسئلة الشائعة موقع توثيق Discord

نماذج البدء السريع خارطة الطريق؟ تجريبي؟ اكسبلورر؟ أمثلة

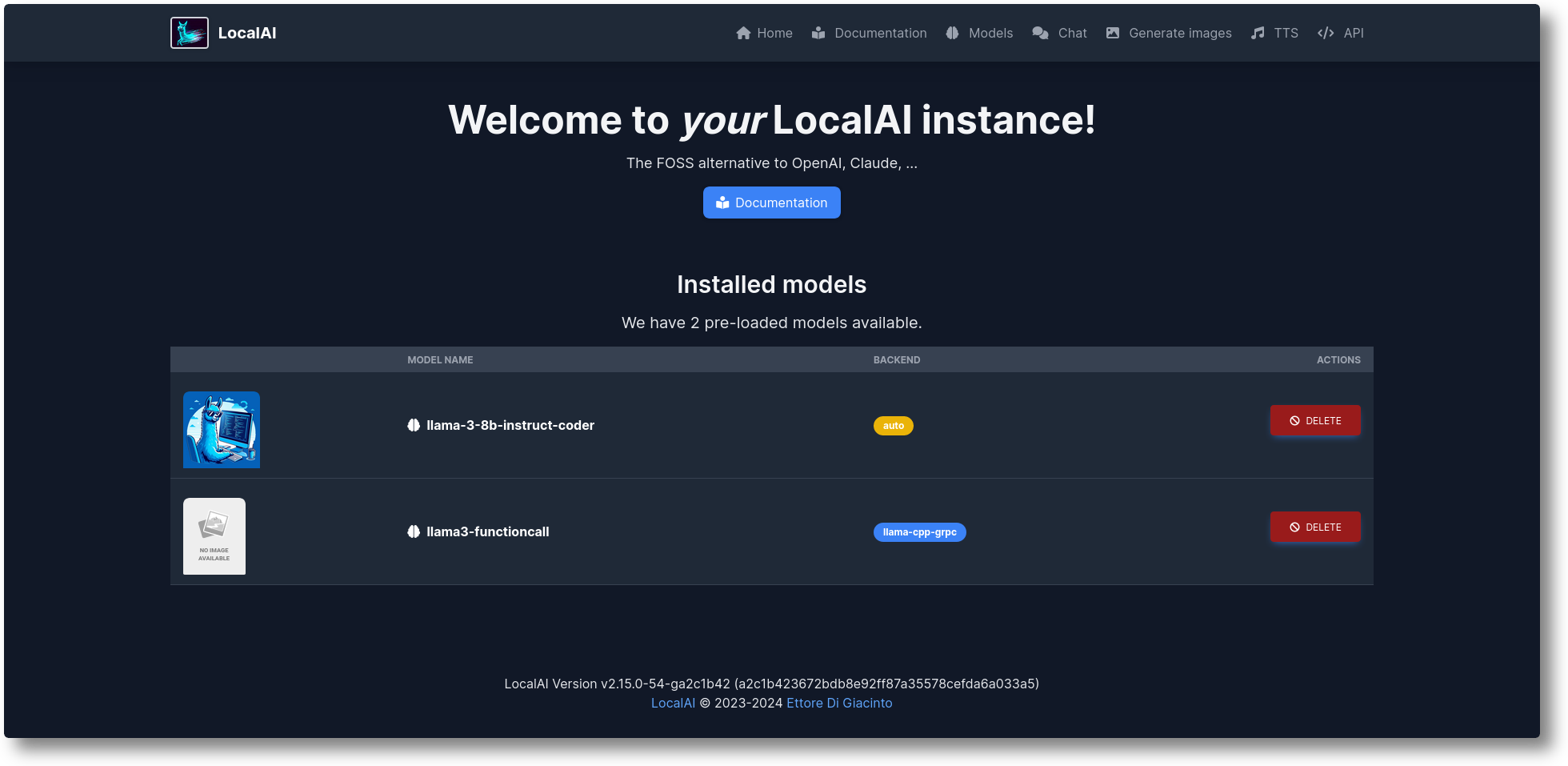

LocalAI هو البديل المجاني المفتوح المصدر لـ OpenAI. تعمل LocalAI بمثابة واجهة برمجة تطبيقات REST بديلة متوافقة مع مواصفات واجهة برمجة التطبيقات OpenAI (Elevenlabs، Anthropic...) لاستدلال الذكاء الاصطناعي المحلي. فهو يسمح لك بتشغيل LLMs، وإنشاء الصور والصوت (وليس فقط) محليًا أو محليًا باستخدام أجهزة من فئة المستهلك، مما يدعم عائلات نماذج متعددة. لا يتطلب GPU. تم إنشاؤه وصيانته بواسطة Ettore Di Giacinto.

قم بتشغيل البرنامج النصي للتثبيت:

حليقة https://localai.io/install.sh | ش

أو تشغيل مع عامل ميناء:

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-aio-cpu# الصور البديلة:# - إذا كان لديك Nvidia GPU:# docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-aio-gpu-nvidia-cuda-12# - بدون نماذج تم تكوينها مسبقًا# docker run -ti --name local-ai -p 8080:8080 localai/localai:latest# - بدون نماذج تم تكوينها مسبقًا لوحدات معالجة الرسومات Nvidia# docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai: أحدث GPU-نفيديا-كودا-12

لتحميل النماذج:

# من معرض النماذج (راجع النماذج المتاحة مع "قائمة نماذج local-ai"، في WebUI من علامة تبويب النموذج، أو قم بزيارة https://models.localai.io)local-ai run llama-3.2-1b-instruct: q4_k_m# ابدأ تشغيل LocalAI باستخدام نموذج phi-2 مباشرةً من تشغيل Huggingfacelocal-ai Huggingface://TheBloke/phi-2-GGUF/phi-2.Q8_0.gguf# تثبيت وتشغيل نموذج من سجل Ollama OCIlocal-ai run ollama://gemma:2b# تشغيل نموذج من ملف تكوينlocal-ai قم بتشغيل https://Gist.githubusercontent.com/.../phi-2.yaml# قم بتثبيت نموذج وتشغيله من سجل OCI القياسي (على سبيل المثال، Docker Hub)local-ai run oci://localai/phi-2:latest

ابدء

أكتوبر 2024: تم نقل الأمثلة إلى أمثلة LocalAI

أغسطس 2024: ؟ فلوكس-1، مستكشف P2P

يوليو 2024: ؟ لوحة تحكم P2P، ووضع LocalAI الموحد، وأسراب الذكاء الاصطناعي: #2723

يونيو 2024: ؟ يمكنك الآن تصفح معرض النماذج بدون LocalAI! تحقق من https://models.localai.io

يونيو 2024: دعم النماذج من سجلات OCI: #2628

مايو 2024: P2P اللامركزي llama.cpp: #2343 (peer2peer llama.cpp!) Docs https://localai.io/features/distribute/

مايو 2024: الصوت المفتوح: #2334

مايو 2024: ؟ استدعاءات الوظائف بدون قواعد نحوية ووضع مختلط: #2328

مايو 2024: الاستدلال الموزع: #2324

مايو 2024: إنشاء الدردشة وتحويل النص إلى كلام والصور في WebUI: #2222

أبريل 2024: Reranker API: رقم 2121

عناصر خريطة الطريق: قائمة القضايا

الوسائط المتعددة مع vLLM وفهم الفيديو: #3729

واجهة برمجة التطبيقات للوقت الحقيقي رقم 3714

تجمعات مجتمع P2P العالمية الموزعة: #3113

تحسينات واجهة الويب: #2156

الواجهات الخلفية الإصدار 2: #1126

تحسين تجربة المستخدم الإصدار 2: #1373

واجهة برمجة التطبيقات المساعدة: #1273

نقطة نهاية الإشراف: #999

فولكان: #1647

واجهة برمجة التطبيقات الإنسانية: #1808

إذا كنت ترغب في المساعدة والمساهمة، فالقضايا متاحة لك: https://github.com/mudler/LocalAI/issues?q=is%3Aissue+is%3Aopen+label%3A%22up+for+grabs%22

إنشاء النص باستخدام GPTs ( llama.cpp , gpt4all.cpp , ... والمزيد)

النص إلى الصوت

الصوت إلى النص (نسخ الصوت باستخدام whisper.cpp )

توليد الصور مع انتشار مستقر

واجهة برمجة التطبيقات للأدوات المشابهة لـ OpenAI

توليد التضمينات لقواعد البيانات المتجهة

القواعد النحوية المقيدة

قم بتنزيل النماذج مباشرة من Huggingface

واجهة برمجة تطبيقات الرؤية

إعادة ترتيب API

الاستدلال P2P

واجهة ويب متكاملة!

راجع قسم "البدء" في وثائقنا.

بناء ونشر حاويات مخصصة:

https://github.com/sozercan/aikit

واجهات مستخدم الويب:

https://github.com/Jirubizu/localai-admin

https://github.com/go-skynet/LocalAI-frontend

QA-Pilot (مشروع دردشة تفاعلي يستفيد من LocalAI LLMs من أجل الفهم السريع والتنقل في مستودع أكواد GitHub) https://github.com/reid41/QA-Pilot

المعارض النموذجية

https://github.com/go-skynet/model-gallery

آخر:

مخطط الدفة https://github.com/go-skynet/helm-charts

ملحق VSCode https://github.com/badgooooor/localai-vscode-plugin

الأداة الطرفية https://github.com/djcopley/ShellOracle

المساعد الذكي المحلي https://github.com/mudler/LocalAGI

مساعد منزلي https://github.com/sammcj/homeassistant-localai / https://github.com/drndos/hass-openai-custom-conversation / https://github.com/valentinfrlch/ha-gpt4vision

بوت الخلاف https://github.com/mudler/LocalAGI/tree/main/examples/discord

بوت سلاك https://github.com/mudler/LocalAGI/tree/main/examples/slack

Shell-Pilot (تفاعل مع LLM باستخدام نماذج LocalAI عبر نصوص برمجية خالصة على نظام Linux أو MacOS) https://github.com/reid41/shell-pilot

بوت تيليجرام https://github.com/mudler/LocalAI/tree/master/examples/telegram-bot

إجراءات جيثب: https://github.com/marketplace/actions/start-localai

أمثلة: https://github.com/mudler/LocalAI/tree/master/examples/

دليل الضبط الدقيق LLM

كيفية البناء محليا

كيفية التثبيت في Kubernetes

مشاريع دمج LocalAI

قسم كيفية تنفيذ المهام (برعاية مجتمعنا)

تشغيل كود Visual studio باستخدام LocalAI (SUSE)

قم بتشغيل LocalAI على Jetson Nano Devkit

قم بتشغيل LocalAI على AWS EKS باستخدام Pulumi

قم بتشغيل LocalAI على AWS

قم بإنشاء slackbot للفرق ومشاريع OSS التي تستجيب للوثائق

LocalAI يلتقي k8sgpt

الإجابة على الأسئلة بشأن المستندات محليًا باستخدام LangChain وLocalAI وChroma وGPT4All

البرنامج التعليمي لاستخدام k8sgpt مع LocalAI

إذا كنت تستخدم هذا المستودع، أو البيانات في مشروع نهائي، فيرجى مراعاة الاستشهاد به مع:

@misc{localai,

author = {Ettore Di Giacinto},

title = {LocalAI: The free, Open source OpenAI alternative},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/go-skynet/LocalAI}},هل تجد LocalAI مفيدًا؟

ادعم المشروع من خلال أن تصبح داعمًا أو راعيًا. سيظهر شعارك هنا مع رابط لموقعك على الويب.

شكرًا جزيلاً لرعاتنا الكرماء الذين يدعمون هذا المشروع بتغطية نفقات CI، وقائمة الرعاة لدينا:

LocalAI هو مشروع موجه نحو المجتمع أنشأه Ettore Di Giacinto.

معهد ماساتشوستس للتكنولوجيا - المؤلف إيتوري دي جياسينتو [email protected]

لم يكن من الممكن إنشاء LocalAI بدون مساعدة البرامج الرائعة المتوفرة بالفعل من المجتمع. شكرًا لك!

llama.cpp

https://github.com/tatsu-lab/stanford_alpaca

https://github.com/cornelk/llama-go للاطلاع على الأفكار الأولية

https://github.com/antimatter15/alpaca.cpp

https://github.com/EdVince/Stable-Diffusion-NCNN

https://github.com/ggerganov/whisper.cpp

https://github.com/saharNooby/rwkv.cpp

https://github.com/rhasspy/piper

هذا مشروع مجتمعي، شكر خاص لمساهمينا! ؟