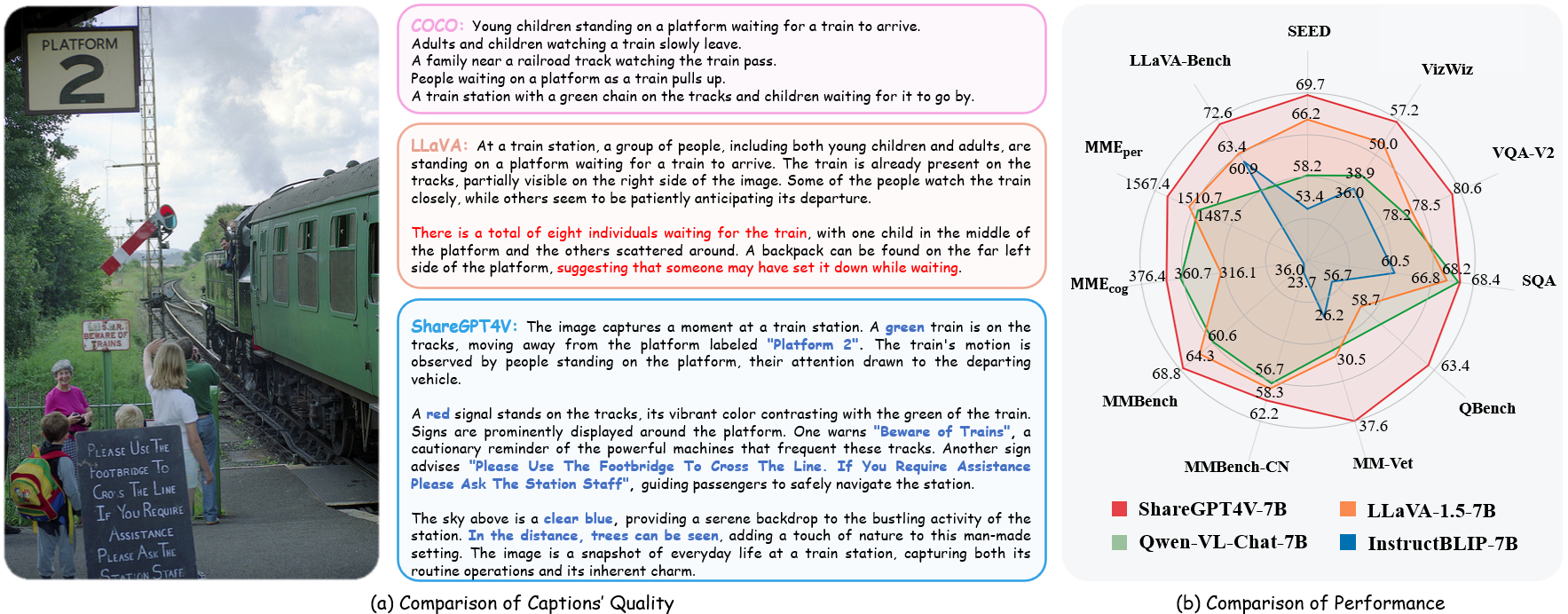

ShareGPT4V: تحسين النماذج الكبيرة متعددة الوسائط بتسميات توضيحية أفضل

ShareGPT4V: تحسين النماذج الكبيرة متعددة الوسائط بتسميات توضيحية أفضل⭐️ أعمال سلسلتنا: [ MMStar ] [ ShareGPT4Video ] [ ShareGPT4Omni ]

؟؟؟؟ التنفيذ الرسمي لـ ShareGPT4V: تحسين النماذج الكبيرة متعددة الوسائط مع تسميات توضيحية أفضل في ECCV 2024.

المؤلفون : لين تشن*، جينسونغ لي*، شياويى دونغ، بان تشانغ، كونغوي هي، جياكي وانغ، فنغ تشاو؟، داهوا لين؟

المعاهد : جامعة العلوم والتكنولوجيا في الصين؛ مختبر شنغهاي للذكاء الاصطناعي

الموارد : [الورقة] [صفحة المشروع] [  مجموعة بيانات ShareGPT4V]

مجموعة بيانات ShareGPT4V]

النماذج : [ShareGPT4V-7B] [ShareCaptioner]

عرض ShareGPT4V-7B [OpenXLab] [؟HuggingFace] [Colab]

عرض توضيحي لـ Share-Captioner [OpenXlab] [؟HuggingFace]

؟ مجموعة بيانات نصية وصورية واسعة النطاق وصفية للغاية

؟ 100 ألف تعليق GPT4-Vision، 1.2 مليون تعليق عالي الجودة

؟ معلق عام للصور ، يقترب من قدرة التعليق الخاصة بـ GPT4-Vision.

؟ نموذج كبير ومتعدد الوسائط، ShareGPT4V-7B

[2024/7/2] يسعدنا أن نعلن عن قبول ShareGPT4V بواسطة ECCV 2024!

[2024/5/8] أصدرنا ShareGPT4Video ، وهي مجموعة بيانات واسعة النطاق للتسميات التوضيحية للفيديو، تحتوي على 40 ألف تعليق توضيحي بواسطة GPT4V و 4.8 مليون تعليق توضيحي بواسطة ShareCaptioner-Video. إجمالي مقاطع الفيديو تدوم 300 ساعة و 3000 ساعة بشكل منفصل!

[2024/4/1] أصدرنا معيارًا متعدد الوسائط لا غنى عنه للرؤية النخبة ، MMStar. استمتع!؟

[2023/12/14] أصدرنا نموذج ShareGPT4V-13B. استمتع!؟

[2023/12/13] كود التدريب والتقييم متاح.

[2023/12/13] ShareCaptioner المحلي متاح الآن! يمكنك استخدامه لإنشاء تسميات توضيحية عالية الجودة لمجموعة البيانات الخاصة بك مع الاستدلال الدفعي عن طريق تشغيل tools/share-cap_batch_infer.py مباشرةً.

[2023/11/23] نصدر العرض التوضيحي على الويب للعبة Share-Captioner العامة!؟

[2023/11/23] نحن نصدر الكود لبناء العرض التوضيحي المحلي الخاص بك لـ ShareGPT4V-7B!؟

[2023/11/22] عرض الويب ونقطة التفتيش متاحان الآن!؟

[2023/11/21] مجموعة بيانات ShareGPT4V متاحة الآن!؟

[2023/11/20] تم إصدار الورقة البحثية وصفحة المشروع!

رمز التدريب والتقييم لـ ShareGPT4V-7B

ShareCaptioner المحلي

العرض التوضيحي على الويب والعرض التوضيحي المحلي لـ ShareGPT4V-7B

نقاط التفتيش في ShareGPT4V-7B

رؤية المزيد من التفاصيل في ModelZoo.md.

| اسم | ماجستير | نقطة تفتيش | LLaVA-مقعد البرية | تصور MME | MME الإدراك | MMBench | MMBench-CN | صورة SEED | مم-طبيب بيطري | كيوبينش | صورة SQA | VQA-v2 | VizWiz | GQA | TextVQA |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| شاركGPT4V-7B | فيكونا-7 ب | شاركGPT4V-7B | 72.6 | 1567.4 | 376.4 | 68.8 | 62.2 | 69.7 | 37.6 | 63.4 | 68.4 | 80.6 | 57.2 | 63.3 | 60.4 |

| شاركGPT4V-13B | فيكونا-13 ب | شاركGPT4V-13B | 79.9 | 1618.7 | 303.2 | 68.5 | 63.7 | 70.8 | 43.1 | 65.2 | 71.2 | 81.0 | 55.6 | 64.8 | 62.2 |

من share4v.model.builder استيراد Load_pretrained_modelfrom share4v.mm_utils استيراد get_model_name_from_pathfrom share4v.eval.run_share4v import eval_model_path = "Lin-Chen/ShareGPT4V-7B" الرمز المميز، النموذج، معالج_الصورة، context_len =load_pretrained_model(model_path=model_path, model_base=None, model_name=get_model_name_from_path(model_path) )

تحقق من التفاصيل مع وظيفة load_pretrained_model في share4v/model/builder.py .

يمكنك أيضًا استخدام وظيفة eval_model في share4v/eval/run_llava.py للحصول على الإخراج بسهولة. ومن خلال القيام بذلك، يمكنك استخدام هذا الرمز على Colab مباشرة بعد تنزيل هذا المستودع.

model_path = "Lin-Chen/ShareGPT4V-7B"prompt = "ما هي العبارة الأكثر شيوعًا للشخصية الموجودة على اليمين؟"image_file = "examples/breaking_bad.png"args = type('Args', (), { " model_path): model_path، "model_base": لا شيء، "model_name": get_model_name_from_path(model_path)، "query": موجه، "conv_mode": لا شيء، "image_file": image_file، "sep": "،"، "درجة الحرارة": 0، "top_p": لا شيء، "num_beams": 1، "max_new_tokens": 512})()eval_model(args )استنساخ بوابة https://github.com/InternLM/InternLM-XComposer --عمق=1cd projects/ShareGPT4V conda create -n share4v python=3.10 -y كوندا تفعيل share4v تثبيت النقطة - ترقية النقطة تثبيت النقطة -e .pip install -e ".[train]"تثبيت النقطة flash-attn --no-build-isolation

يمكنك إنشاء العرض التوضيحي المحلي الخاص بك عن طريق:

# run script python tools/app.py

يجب عليك اتباع هذه التعليمات Data.md لإدارة مجموعات البيانات. حاليًا، نوفر إمكانية الوصول المباشر للتنزيل إلى بيانات الويب. ومع ذلك، لتجنب النزاعات المحتملة، نخطط لإصدار عناوين URL لمجموعات البيانات هذه بدلاً من البيانات الأولية في المستقبل القريب.

يتكون التدريب على نموذج ShareGPT4V من مرحلتين: (1) مرحلة محاذاة الميزات: استخدم مجموعة بيانات ShareGPT4V-PT الخاصة بنا مع 1.2M من أزواج الصور والنصوص عالية الجودة التي تم إنشاؤها بواسطة ShareCaptioner لضبط أداة تشفير الرؤية وجهاز العرض وLLM لمحاذاة النص والنص الطرائق البصرية؛ (2) مرحلة ضبط التعليمات المرئية: ضبط جهاز العرض وماجستير القانون لتعليم النموذج اتباع التعليمات متعددة الوسائط.

للتدريب على عدد أقل من وحدات معالجة الرسومات، يمكنك تقليل حجم مجموعة_تدريب_الجهاز per_device_train_batch_size وزيادة gradient_accumulation_steps وفقًا لذلك. احتفظ دائمًا بنفس حجم الدفعة العامة: per_device_train_batch_size x gradient_accumulation_steps x num_gpus .

نحن نستخدم مجموعة مماثلة من المعلمات الفائقة مثل ShareGPT4V-7B في الضبط الدقيق. يتم توفير كل من المعلمات الفائقة المستخدمة في التدريب المسبق والضبط الدقيق أدناه.

التدريب المسبق

| المعلمة المفرطة | حجم الدفعة العالمية | معدل التعلم | العصور | أقصى طول | اضمحلال الوزن |

|---|---|---|---|---|---|

| شاركGPT4V-7B | 256 | 2ه-5 | 1 | 2048 | 0 |

الكون المثالى

| المعلمة المفرطة | حجم الدفعة العالمية | معدل التعلم | العصور | أقصى طول | اضمحلال الوزن |

|---|---|---|---|---|---|

| شاركGPT4V-7B | 128 | 2ه-5 | 1 | 2048 | 0 |

أولاً، يجب عليك تنزيل جهاز العرض MLP الذي تم تدريبه مسبقًا بواسطة LLaVA-1.5 مع LAION-CC-SBU-558K. نظرًا لأن عملية محاذاة الطريقة التقريبية مفيدة قبل استخدام التسميات التوضيحية التفصيلية عالية الجودة لمحاذاة الطريقة.

يمكنك تشغيل projects/ShareGPT4V/scripts/sharegpt4v/slurm_pretrain_7b.sh للتدريب المسبق للنموذج. تذكر تحديد مسار جهاز العرض في البرنامج النصي. في هذه المرحلة، قمنا بضبط النصف الثاني من كتل جهاز تشفير الرؤية، وجهاز العرض، وLLM.

استخدمنا في الإعداد الخاص بنا 16 وحدة معالجة رسوميات A100 (80G) واستغرقت عملية التدريب المسبق بأكملها حوالي 12 ساعة. يمكنك ضبط عدد خطوات تراكم التدرج لتقليل عدد وحدات معالجة الرسومات.

في هذه المرحلة، نقوم بضبط جهاز العرض وLLM باستخدام sharegpt4v_mix665k_cap23k_coco-ap9k_lcs3k_sam9k_div2k.json.

يمكنك تشغيل projects/ShareGPT4V/scripts/sharegpt4v/slurm_finetune_7b.sh لضبط النموذج.

استخدمنا في الإعداد الخاص بنا 16 وحدة معالجة رسوميات A100 (80G) واستغرقت عملية التدريب المسبق بأكملها حوالي 7 ساعات. يمكنك ضبط عدد خطوات تراكم التدرج لتقليل عدد وحدات معالجة الرسومات.

لضمان إمكانية تكرار نتائج، نقوم بتقييم النماذج مع فك التشفير الجشع. نحن لا نقوم بتقييم استخدام البحث الشعاعي لجعل عملية الاستدلال متوافقة مع العرض التوضيحي للدردشة للمخرجات في الوقت الفعلي.

انظر تقييم.md.

LLaVA: قاعدة التعليمات البرمجية التي بنينا عليها. شكرا لعملهم الرائع.

فيكونا: نموذج اللغة الكبير المذهل والمفتوح المصدر!

إذا وجدت عملنا مفيدًا لبحثك، فيرجى التفكير في منح نجمة ⭐ واقتباس؟

@article{chen2023sharegpt4v, title={ShareGPT4V: تحسين النماذج الكبيرة متعددة الوسائط بتسميات توضيحية أفضل}، المؤلف={Chen, Lin and Li, Jisong and Dong, Xiaoyi and Zhang, Pan and He, Conghui and Wang, Jiaqi and Zhao, فنغ ولين، داهوا}، مجلة = {arXiv preprint arXiv:2311.12793}، year={2023}}@article{chen2024sharegpt4video, title={ShareGPT4Video: تحسين فهم الفيديو وإنشاء تسميات توضيحية أفضل}، المؤلف={Chen, Lin and Wei, Xilin and Li, Jinsong and Dong, Xiaoyi and Zhang, Pan and Zang ، يوهانغ وتشن، زيهوي ودوان، هاودونغ ولين، بن وتانغ، زينيو وآخرون}، مجلة={arXiv طبعة أولية arXiv:2406.04325}, year={2024}}@article{chen2024we, title={هل نحن على الطريق الصحيح لتقييم نماذج لغة الرؤية الكبيرة؟}, المؤلف={Chen, Lin and Li, Jinsong and Dong, Xiaoyi وتشانغ، وبان وزانغ، ويوهانغ وتشن، وزيهوي ودوان، وهاودونغ ووانغ، وجياكي وتشياو، ويو ولين وداهوا وآخرون}، مجلة={arXiv preprint arXiv:2403.20330}, year={2024}}إشعارات الاستخدام والترخيص : البيانات ونقطة التفتيش مخصصة ومرخصة للاستخدام البحثي فقط. كما أنها تقتصر أيضًا على الاستخدامات التي تتبع اتفاقية ترخيص LLaMA وVicuna وGPT-4. مجموعة البيانات هي CC BY NC 4.0 (تسمح فقط بالاستخدام غير التجاري) ولا ينبغي استخدام النماذج التي تم تدريبها باستخدام مجموعة البيانات خارج أغراض البحث.