إن DeveloperGPT عبارة عن أداة سطر أوامر مدعومة من LLM تتيح استخدام اللغة الطبيعية لأوامر المحطة الطرفية والدردشة داخل المحطة الطرفية. يتم تشغيل DeveloperGPT بواسطة Google Gemini 1.5 Flash بشكل افتراضي ولكنه يدعم أيضًا Google Gemini 1.0 Pro وOpenAI GPT-3.5 وGPT-4 وAnthropic Claude 3 Haiku & Sonnet وLLMs المفتوحة (Zephyr وGemma وMistral) المستضافة على Hugging Face والكمية. Mistral-7B-Instruct يعمل دون اتصال بالإنترنت على الجهاز.

اعتبارًا من يونيو 2024، أصبح DeveloperGPT مجانيًا تمامًا للاستخدام عند استخدام Google Gemini 1.5 Pro (المستخدم افتراضيًا) أو Google Gemini 1.0 Pro لما يصل إلى 15 طلبًا في الدقيقة.

قم بالتبديل بين دورات LLM المختلفة باستخدام علامة --model : developergpt --model [llm_name] [cmd, chat]

| النموذج (النماذج) | مصدر | تفاصيل |

|---|---|---|

| جيميني برو ، جيميني فلاش (افتراضي) | جوجل جيميني 1.0 برو، جيميني 1.5 فلاش | مجاني (ما يصل إلى 15 طلبًا/الدقيقة)، مطلوب مفتاح Google AI API |

| جي بي تي 35، جي بي تي 4 | OpenAI | الدفع لكل استخدام، مطلوب مفتاح OpenAI API |

| هايكو، السوناتة | أنثروبي (كلود 3) | الدفع لكل استخدام، مطلوب مفتاح API Anthropic |

| زفير | Zephyr7B-بيتا | مجاني ومفتوح LLM، واجهة برمجة تطبيقات استنتاج الوجه المعانقة |

| جيما، قاعدة جيما | جيما-1.1-7B-إرشاد، قاعدة جيما | مجاني ومفتوح LLM، واجهة برمجة تطبيقات استنتاج الوجه المعانقة |

| ميسترال-Q6، ميسترال-Q4 | الكمية GGUF Mistral-7B-Instruct | مجاني، مفتوح LLM، غير متصل بالإنترنت، على الجهاز |

| ميسترال | ميسترال-7B-إرشاد | مجاني ومفتوح LLM، واجهة برمجة تطبيقات استنتاج الوجه المعانقة |

mistral-q6 و mistral-q4 عبارة عن GGUF Mistral-7B-Instruct LLMs التي تعمل محليًا على الجهاز باستخدام llama.cpp (نماذج Q6_K الكمية وQ4_K على التوالي). يمكن تشغيل برامج LLM هذه على الأجهزة التي لا تحتوي على وحدة معالجة رسومات مخصصة - راجع llama.cpp لمزيد من التفاصيل.لدى DeveloperGPT ميزتان رئيسيتان.

الاستخدام: developergpt cmd [your natural language command request]

# Example

$ developergpt cmd list all git commits that contain the word llm

استخدم developergpt cmd --fast للحصول على الأوامر بشكل أسرع دون أي تفسيرات (حوالي 1.6 ثانية مع --fast مقابل ~3.2 ثانية مع العادي في المتوسط). قد تكون الأوامر المقدمة من DeveloperGPT في الوضع --fast أقل دقة - راجع لغة DeveloperGPT الطبيعية إلى دقة الأوامر الطرفية لمزيد من التفاصيل.

# Fast Mode: Commands are given without explanation for faster response

$ developergpt cmd --fast [your natural language command request] استخدم developergpt --model [model_name] cmd لاستخدام LLM مختلف بدلاً من Gemini Flash (المستخدم افتراضيًا).

# Example: Natural Language to Terminal Commands using the GPT-3.5 instead of Gemini Flash

$ developergpt --model gpt35 cmd [your natural language command request] الاستخدام: developergpt chat

# Chat with DeveloperGPT using Gemini 1.5 Flash (default)

$ developergpt chat

استخدم developergpt --model [model_name] chat لاستخدام LLM مختلف.

# Example

$ developergpt --model mistral chatلم يتم تنفيذ الإشراف على الدردشة - يجب أن تتبع جميع رسائل الدردشة الخاصة بك شروط استخدام LLM المستخدمة.

لا يجوز استخدام DeveloperGPT لأي أغراض محظورة بموجب شروط استخدام LLMs المستخدمة. بالإضافة إلى ذلك، يعد DeveloperGPT نفسه (بصرف النظر عن LLMs) بمثابة دليل على أداة المفهوم وليس المقصود استخدامه في أي عمل جاد أو تجاري.

pip install -U developergpt # see available commands

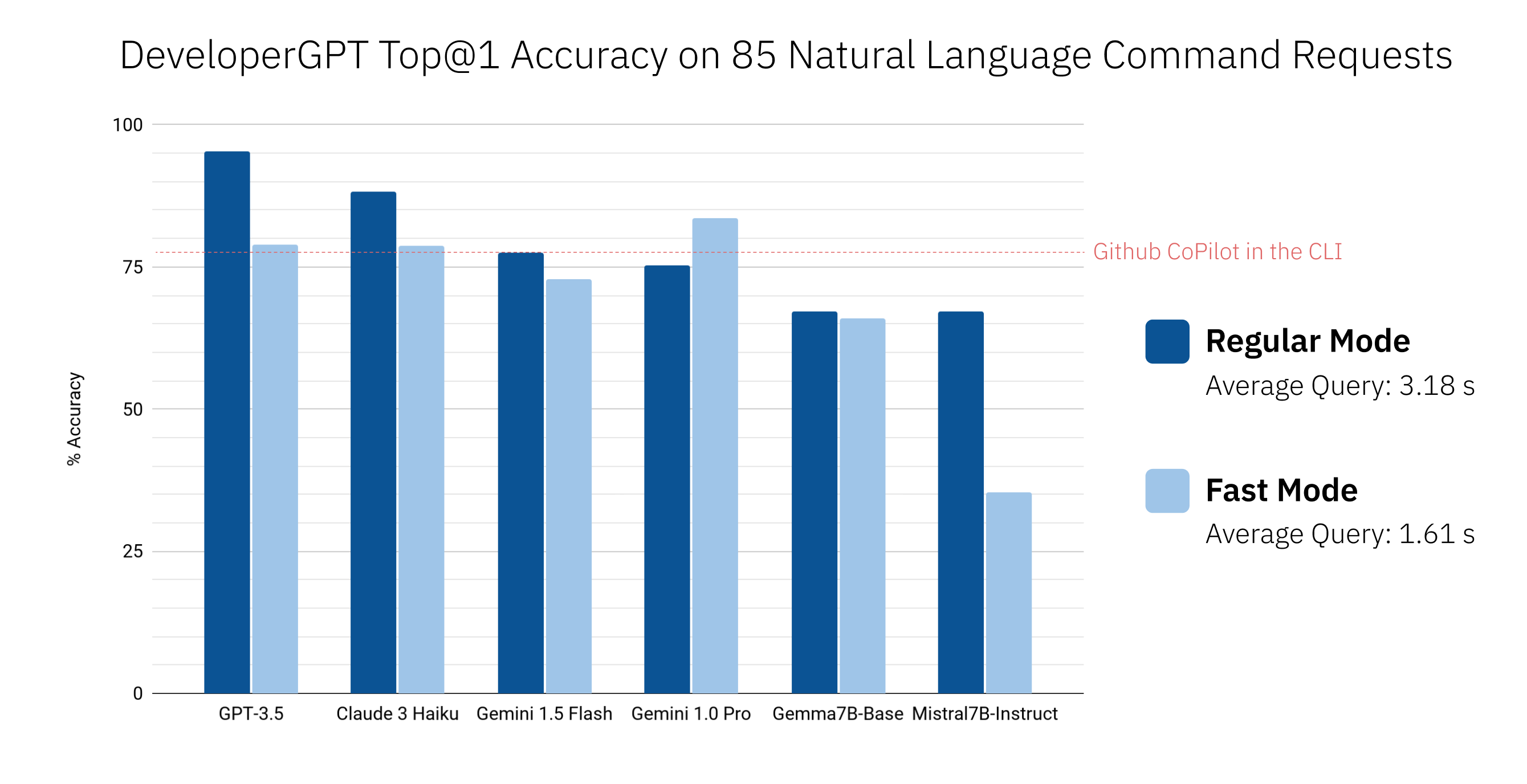

$ developergpt تختلف دقة DeveloperGPT اعتمادًا على LLM المستخدم بالإضافة إلى الوضع ( --fast vs. Regular). يظهر أدناه دقة أعلى @ 1 لمختلف دورات LLM في مجموعة مكونة من 85 طلبًا لأوامر اللغة الطبيعية (هذا ليس تقييمًا صارمًا، ولكنه يعطي إحساسًا تقريبيًا بالدقة). تم أيضًا تضمين Github CoPilot في الإصدار 1.0.1 من واجهة سطر الأوامر (CLI) للمقارنة.

بشكل افتراضي، يستخدم DeveloperGPT Google Gemini 1.5 Flash. لاستخدام Gemini 1.0 Pro أو Gemini 1.5 Flash، ستحتاج إلى مفتاح API (يمكنك استخدام ما يصل إلى 15 استعلامًا مجانًا في الدقيقة).

GOOGLE_API_KEY . ما عليك سوى القيام بذلك مرة واحدة. # set Google API Key (using zsh for example)

$ echo ' export GOOGLE_API_KEY=[your_key_here] ' >> ~ /.zshenv

# reload the environment (or just quit and open a new terminal)

$ source ~ /.zshenv لاستخدام شهادات LLM مفتوحة مثل Gemma أو Mistral المستضافة على Hugging Face، يمكنك اختياريًا إعداد رمز Hugging Face Inference API المميز كمتغير البيئة HUGGING_FACE_API_KEY . راجع https://huggingface.co/docs/api-inference/index لمزيد من التفاصيل.

لاستخدام Mistral-7B-Instruct الكمي، ما عليك سوى تشغيل DeveloperGPT باستخدام علامة --offline . سيؤدي هذا إلى تنزيل النموذج عند التشغيل لأول مرة واستخدامه محليًا في أي عمليات تشغيل مستقبلية (لا يلزم الاتصال بالإنترنت بعد الاستخدام الأول). ليس هناك حاجة إلى إعداد خاص.

developergpt --offline chatلاستخدام GPT-3.5 أو GPT-4، ستحتاج إلى مفتاح OpenAI API.

OPENAI_API_KEY . ما عليك سوى القيام بذلك مرة واحدة. لاستخدام Anthropic Claude 3 Sonnet أو Haiku، ستحتاج إلى مفتاح Anthropic API.

ANTHROPIC_API_KEY . ما عليك سوى القيام بذلك مرة واحدة.اعتبارًا من يونيو 2024، أصبح Google Gemini 1.0 Pro وGemini 1.5 Flash متاحين مجانًا لاستخدام ما يصل إلى 15 استفسارًا في الدقيقة. لمزيد من المعلومات، راجع: https://ai.google.dev/pricing

اعتبارًا من يونيو 2024، أصبح استخدام برامج LLM المستضافة في Hugging Face Inference API مجانيًا ولكن السعر محدود. راجع https://huggingface.co/docs/api-inference/index لمزيد من التفاصيل.

إن Mistral-7B-Instruct مجاني للاستخدام ويتم تشغيله محليًا على الجهاز.

يمكنك مراقبة استخدام OpenAI API الخاص بك هنا: https://platform.openai.com/account/usage. متوسط التكلفة لكل استعلام باستخدام GPT-3.5 هو <0.1 سنت. لا يُنصح باستخدام GPT-4 لأن GPT-3.5 أكثر فعالية من حيث التكلفة ويحقق دقة عالية جدًا لمعظم الأوامر.

يمكنك مراقبة استخدام Anthropic API الخاص بك هنا: https://console.anthropic.com/settings/plans. متوسط التكلفة لكل استعلام باستخدام Claude 3 Haiku هو <0.1 سنت. راجع https://www.anthropic.com/api للحصول على تفاصيل التسعير.

قراءة الملف CONTRIBUTING.md.