الأخبار | التثبيت | بداية سريعة | المجتمع | المشاريع | القائمة النموذجية | مساهم | اقتباس | رخصة

الإنجليزية | 中文

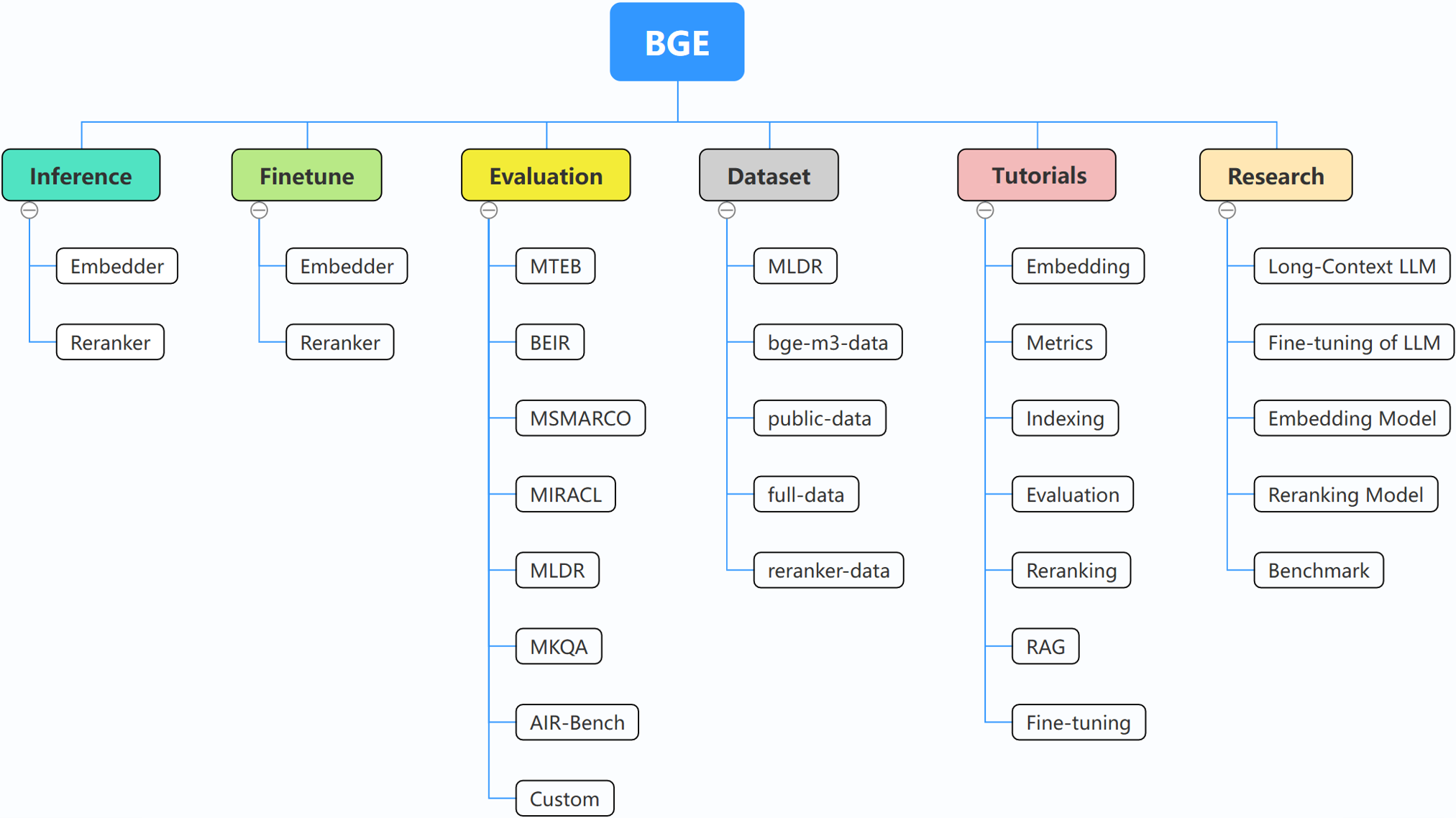

يركز BGE (BAAI General Embedding) على LLMs المعززة للاسترجاع، والتي تتكون من المشاريع التالية حاليًا:

29/10/2024: ؟ لقد أنشأنا مجموعة WeChat لـ BGE. امسح رمز الاستجابة السريعة ضوئيًا للانضمام إلى الدردشة الجماعية! للحصول على الرسالة المباشرة حول تحديثاتنا وإصدارنا الجديد، أو إذا كانت لديك أية أسئلة أو أفكار، انضم إلينا الآن!

22/10/2024: قمنا بإصدار نموذج آخر مثير للاهتمام: OmniGen، وهو نموذج موحد لتوليد الصور يدعم المهام المختلفة. يمكن لـ OmniGen إنجاز مهام إنشاء الصور المعقدة دون الحاجة إلى مكونات إضافية مثل ControlNet أو IP-Adapter أو النماذج المساعدة مثل اكتشاف الوضعية واكتشاف الوجه.

10/9/2024: تقديم MemoRAG ، خطوة للأمام نحو RAG 2.0 بالإضافة إلى اكتشاف المعرفة المستوحاة من الذاكرة (repo: https://github.com/qhjqhj00/MemoRAG، الورقة البحثية: https://arxiv.org/pdf/ 2409.05591v1)

2/9/2024: البدء في صيانة الدروس. سيتم تحديث المحتويات الموجودة بداخلها بشكل نشط وسماعها، ترقبوا ذلك!

26/07/2024: إطلاق نموذج تضمين جديد bge-en-icl، وهو نموذج تضمين يشتمل على إمكانات التعلم في السياق، والتي، من خلال توفير أمثلة استجابة للاستعلام ذات صلة بالمهمة، يمكنها ترميز استعلامات أكثر ثراءً لغويًا، مما يزيد من تعزيز المعرفة الدلالية القدرة على تمثيل التضمينات.

26/07/2024: إطلاق نموذج تضمين جديد bge-multilingual-gemma2، وهو نموذج تضمين متعدد اللغات يعتمد على Gemma-2-9b، والذي يدعم لغات متعددة ومهام فرعية متنوعة، وتحقيق SOTA جديد على معايير متعددة اللغات (MIRACL، MTEB-fr) ، وMTEB-pl).

26/07/2024: إطلاق أداة إعادة ترتيب خفيفة الوزن جديدة bge-reranker-v2.5-gemma2-lightweight، أداة إعادة ترتيب خفيفة الوزن تعتمد على Gemma-2-9b، والتي تدعم ضغط الرمز المميز والعمليات خفيفة الوزن على مستوى الطبقات، ولا يزال بإمكانها ضمان الأداء الجيد مع الحفظ كمية كبيرة من الموارد.

BAAI/bge-reranker-base و BAAI/bge-reranker-large ، وهي أقوى من نموذج التضمين. نوصي باستخدامها/ضبطها لإعادة ترتيب المستندات عالية الجودة التي يتم إرجاعها عن طريق تضمين النماذج.bge-*-v1.5 للتخفيف من مشكلة توزيع التشابه، وتعزيز قدرته على الاسترجاع بدون تعليمات.bge-large-* (اختصار لـ BAAI General Embedding)، المرتبة الأولى في معيار MTEB وC-MTEB! ؟ ؟إذا كنت لا ترغب في ضبط النماذج، فيمكنك تثبيت الحزمة دون تبعية الضبط الدقيق:

pip install -U FlagEmbedding

إذا كنت تريد تحسين النماذج، فيمكنك تثبيت الحزمة باستخدام تبعية Finetune:

pip install -U FlagEmbedding[finetune]

استنساخ المستودع وتثبيته

git clone https://github.com/FlagOpen/FlagEmbedding.git

cd FlagEmbedding

# If you do not want to finetune the models, you can install the package without the finetune dependency:

pip install .

# If you want to finetune the models, you can install the package with the finetune dependency:

# pip install .[finetune]

للتطوير في الوضع القابل للتحرير:

# If you do not want to finetune the models, you can install the package without the finetune dependency:

pip install -e .

# If you want to finetune the models, you can install the package with the finetune dependency:

# pip install -e .[finetune]

أولاً، قم بتحميل أحد نماذج التضمين BGE:

from FlagEmbedding import FlagAutoModel

model = FlagAutoModel.from_finetuned('BAAI/bge-base-en-v1.5',

query_instruction_for_retrieval="Represent this sentence for searching relevant passages:",

use_fp16=True)

بعد ذلك، قم بتغذية النموذج ببعض الجمل واحصل على تضميناتها:

sentences_1 = ["I love NLP", "I love machine learning"]

sentences_2 = ["I love BGE", "I love text retrieval"]

embeddings_1 = model.encode(sentences_1)

embeddings_2 = model.encode(sentences_2)

بمجرد أن نحصل على التضمينات، يمكننا حساب التشابه حسب المنتج الداخلي:

similarity = embeddings_1 @ embeddings_2.T

print(similarity)

لمزيد من التفاصيل، يمكنك الرجوع إلى استنتاج التضمين، استدلال إعادة الترتيب، دقة التضمين، إعادة الترتيب، التقييم.

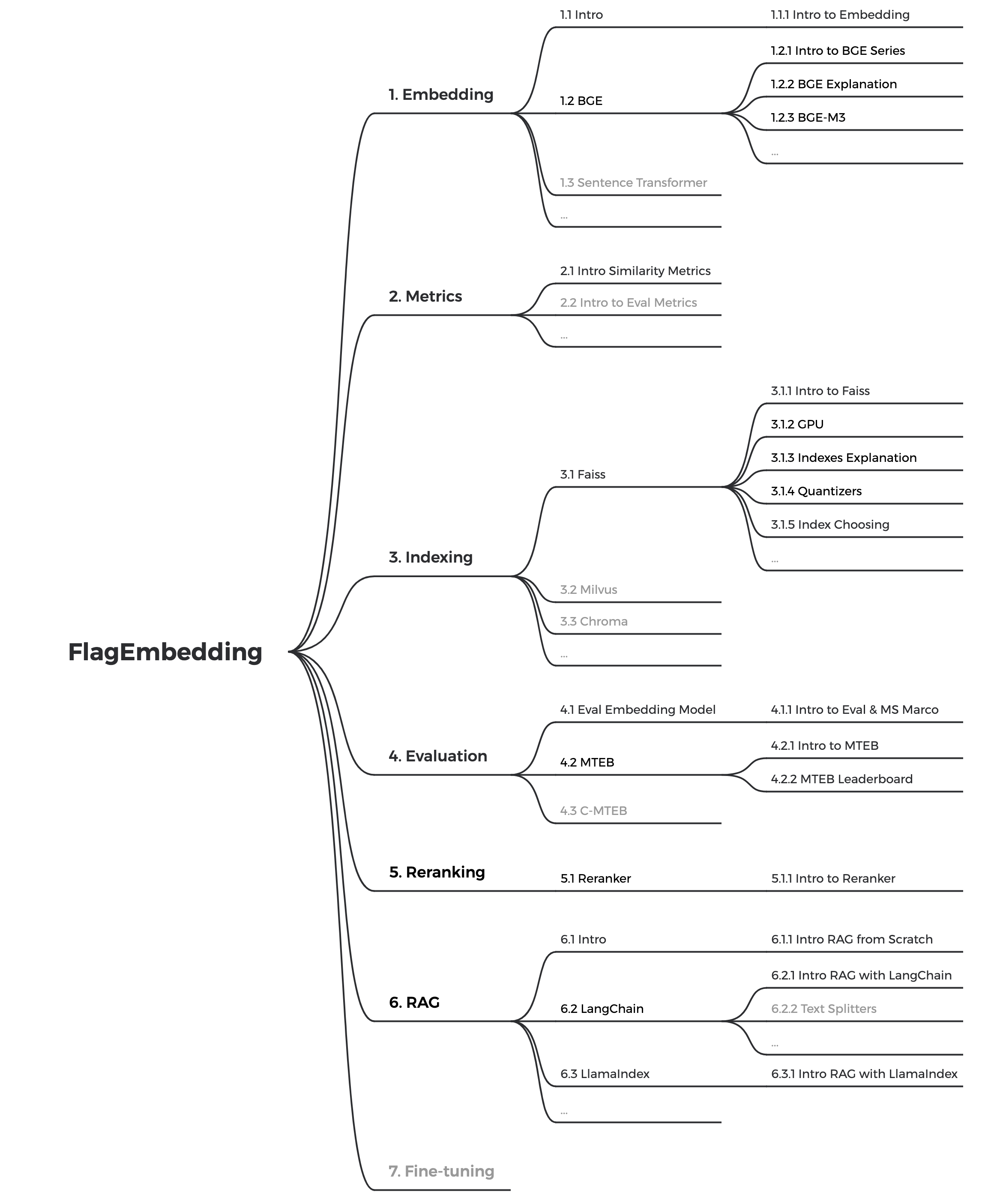

إذا لم تكن على دراية بأي من المفاهيم ذات الصلة، فيرجى مراجعة البرنامج التعليمي. إذا لم يكن هناك، واسمحوا لنا أن نعرف.

لمزيد من المواضيع المثيرة للاهتمام المتعلقة بـ BGE، قم بإلقاء نظرة على الأبحاث.

نحن نحافظ بشكل فعال على مجتمع BGE وFlagEmbedding. أخبرنا إذا كان لديك أي اقتراحات أو أفكار!

نقوم حاليًا بتحديث البرامج التعليمية، ونهدف إلى إنشاء برنامج تعليمي شامل ومفصل للمبتدئين حول استرجاع النص وRAG. ابقوا متابعين!

سيتم إصدار المحتويات التالية في الأسابيع القادمة:

bge هو اختصار BAAI general embedding .

| نموذج | لغة | وصف | تعليمات الاستعلام لاسترجاعها |

|---|---|---|---|

| BAAI/bge-en-icl | إنجليزي | نموذج التضمين القائم على LLM مع إمكانات التعلم في السياق، والتي يمكنها الاستفادة بشكل كامل من إمكانات النموذج بناءً على بعض الأمثلة الملتقطة | قم بتوفير التعليمات والأمثلة القليلة بحرية بناءً على المهمة المحددة. |

| BAAI/bge-متعدد اللغات-gemma2 | متعدد اللغات | نموذج تضمين متعدد اللغات قائم على LLM، تم تدريبه على مجموعة متنوعة من اللغات والمهام. | تقديم التعليمات بناءً على المهمة المحددة. |

| بايي/bge-m3 | متعدد اللغات | متعددة الوظائف (استرجاع كثيف، استرجاع متفرق، متعدد المتجهات (كولبرت)) ومتعدد اللغات ومتعدد التفاصيل (8192 رمزًا) | |

| إل إم-كوكتيل | إنجليزي | نماذج مضبوطة بدقة (Llama وBGE) والتي يمكن استخدامها لإعادة إنتاج نتائج LM-Cocktail | |

| BAAI/llm-embedder | إنجليزي | نموذج تضمين موحد لدعم احتياجات زيادة الاسترجاع المتنوعة لـ LLMs | راجع التمهيدي |

| BAAI/bge-reranker-v2-m3 | متعدد اللغات | نموذج تشفير متقاطع خفيف الوزن، يتمتع بقدرات قوية متعددة اللغات، وسهل النشر، مع استنتاج سريع. | |

| BAAI/bge-reranker-v2-gemma | متعدد اللغات | نموذج التشفير المتقاطع الذي يناسب السياقات متعددة اللغات، يحقق أداءً جيدًا في كل من إتقان اللغة الإنجليزية وقدرات تعدد اللغات. | |

| BAAI/bge-reranker-v2-minicpm-layerwise | متعدد اللغات | نموذج التشفير المتقاطع الذي يناسب السياقات متعددة اللغات، يعمل بشكل جيد في كل من إتقان اللغة الإنجليزية والصينية، ويسمح بحرية اختيار الطبقات للمخرجات، مما يسهل الاستدلال المتسارع. | |

| BAAI/bge-reranker-v2.5-gemma2-lightweight | متعدد اللغات | نموذج التشفير المتقاطع الذي يناسب السياقات متعددة اللغات، يعمل بشكل جيد في كل من إتقان اللغة الإنجليزية والصينية، ويسمح بحرية اختيار الطبقات، وضغط النسبة وضغط الطبقات للإخراج، مما يسهل الاستدلال المتسارع. | |

| BAAI/bge-reranker-large | الصينية والإنجليزية | نموذج تشفير متقاطع أكثر دقة ولكنه أقل كفاءة | |

| BAAI/bge-reranker-base | الصينية والإنجليزية | نموذج تشفير متقاطع أكثر دقة ولكنه أقل كفاءة | |

| BAAI/bge-large-en-v1.5 | إنجليزي | الإصدار 1.5 مع توزيع تشابه أكثر معقولية | Represent this sentence for searching relevant passages: |

| BAAI/bge-base-en-v1.5 | إنجليزي | الإصدار 1.5 مع توزيع تشابه أكثر معقولية | Represent this sentence for searching relevant passages: |

| BAAI/bge-small-en-v1.5 | إنجليزي | الإصدار 1.5 مع توزيع تشابه أكثر معقولية | Represent this sentence for searching relevant passages: |

| BAAI/bge-large-zh-v1.5 | الصينية | الإصدار 1.5 مع توزيع تشابه أكثر معقولية | 为这个句子生成表示以用于检索相关文章: |

| باي/bge-base-zh-v1.5 | الصينية | الإصدار 1.5 مع توزيع تشابه أكثر معقولية | 为这个句子生成表示以用于检索相关文章: |

| باي/bge-small-zh-v1.5 | الصينية | الإصدار 1.5 مع توزيع تشابه أكثر معقولية | 为这个句子生成表示以用于检索相关文章: |

| BAAI/bge-large-en | إنجليزي | نموذج التضمين الذي يعين النص في المتجهات | Represent this sentence for searching relevant passages: |

| BAAI/bge-base-en | إنجليزي | نموذج ذو نطاق أساسي ولكن مع قدرة مماثلة على bge-large-en | Represent this sentence for searching relevant passages: |

| BAAI/bge-small-ar | إنجليزي | نموذج صغير الحجم ولكن بأداء تنافسي | Represent this sentence for searching relevant passages: |

| BAAI/bge-large-zh | الصينية | نموذج التضمين الذي يعين النص في المتجهات | 为这个句子生成表示以用于检索相关文章: |

| باي / bge-base-zh | الصينية | نموذج ذو نطاق أساسي ولكن مع قدرة مماثلة على bge-large-zh | 为这个句子生成表示以用于检索相关文章: |

| BAAI/bge-small-zh | الصينية | نموذج صغير الحجم ولكن بأداء تنافسي | 为这个句子生成表示以用于检索相关文章: |

نشكر جميع المساهمين على جهودهم ونرحب ترحيبًا حارًا بالأعضاء الجدد للانضمام!

إذا وجدت هذا المستودع مفيدًا، فيرجى التفكير في إعطاء نجمة واقتباس

@misc{bge_m3,

title={BGE M3-Embedding: Multi-Lingual, Multi-Functionality, Multi-Granularity Text Embeddings Through Self-Knowledge Distillation},

author={Chen, Jianlv and Xiao, Shitao and Zhang, Peitian and Luo, Kun and Lian, Defu and Liu, Zheng},

year={2023},

eprint={2309.07597},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

@misc{cocktail,

title={LM-Cocktail: Resilient Tuning of Language Models via Model Merging},

author={Shitao Xiao and Zheng Liu and Peitian Zhang and Xingrun Xing},

year={2023},

eprint={2311.13534},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

@misc{llm_embedder,

title={Retrieve Anything To Augment Large Language Models},

author={Peitian Zhang and Shitao Xiao and Zheng Liu and Zhicheng Dou and Jian-Yun Nie},

year={2023},

eprint={2310.07554},

archivePrefix={arXiv},

primaryClass={cs.IR}

}

@misc{bge_embedding,

title={C-Pack: Packaged Resources To Advance General Chinese Embedding},

author={Shitao Xiao and Zheng Liu and Peitian Zhang and Niklas Muennighoff},

year={2023},

eprint={2309.07597},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

تم ترخيص FlagEmbedding بموجب ترخيص MIT.