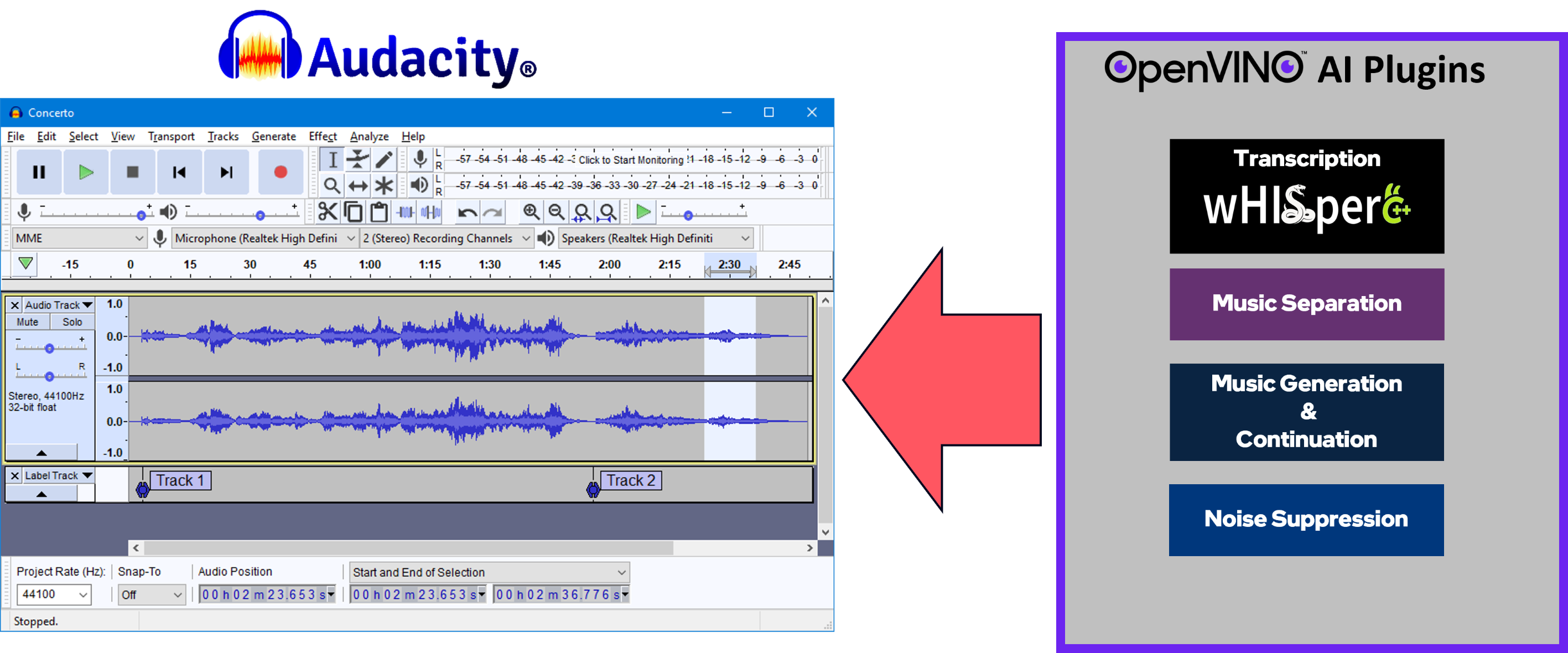

Eine Reihe KI-fähiger Effekte, Generatoren und Analysatoren für Audacity®. Diese KI-Funktionen laufen zu 100 % lokal auf Ihrem PC? -- keine Internetverbindung notwendig! OpenVINO™ wird verwendet, um KI-Modelle auf unterstützten Beschleunigern auszuführen, die auf dem System des Benutzers vorhanden sind, wie z. B. CPU, GPU und NPU.

Musiktrennung – Trennen Sie eine Mono- oder Stereospur in einzelne Stems – Schlagzeug, Bass, Gesang und andere Instrumente.

Rauschunterdrückung – Entfernt Hintergrundgeräusche aus einem Audiobeispiel.

Musikgenerierung und -fortsetzung – Verwendet MusicGen LLM, um Musikausschnitte oder eine Fortsetzung eines vorhandenen Musikausschnitts zu generieren.

Whisper Transcription – Verwendet whisper.cpp, um einen Label-Track zu generieren, der die Transkription oder Übersetzung für eine bestimmte Auswahl an gesprochenem Audio oder Gesang enthält.

Hier finden Sie Installationspakete und Anweisungen für die neueste Windows-Version.

Windows-Build-Anweisungen

Linux-Build-Anweisungen

Wir heißen Sie herzlich willkommen, hier ein Problem einzureichen

Fragen

Fehlerberichte

Funktionsanfragen

Feedback jeglicher Art – wie können wir dieses Projekt verbessern?

Ihre Beiträge sind willkommen und werden geschätzt, egal wie groß oder klein sie sind. Stellen Sie gerne einen Pull-Request!

Audacity®-Entwicklungsteam und Muse Group – Vielen Dank für Ihre Unterstützung!

Audacity® GitHub – https://github.com/audacity/audacity

Der Whisper-Transkriptions- und Übersetzungsanalysator verwendet whisper.cpp (mit OpenVINO™-Backend): https://github.com/ggerganov/whisper.cpp

Musikgenerierung und -fortsetzung verwenden das MusicGen-Modell von Meta.

Wir unterstützen derzeit MusicGen-Small und MusicGen-Small-Stereo

Die TXT-zu-Musik-Pipelines wurden von Python nach C++ portiert und referenzierten die Logik aus dem Hugging Face Transformers-Projekt: https://github.com/huggingface/transformers

Der Music Separation-Effekt verwendet Metas Demucs v4-Modell (https://github.com/facebookresearch/demucs), das für die Verwendung mit OpenVINO™ portiert wurde

Rauschunterdrückung:

Die Modelle und die Pipeline wurden von hier portiert: https://github.com/Rikorose/DeepFilterNet

Wir haben auch @grazders Fork/Branch (https://github.com/grazder/DeepFilterNet/tree/torchDF-changes) genutzt, um die Rust-Implementierung besser zu verstehen, und haben daher auch einige unserer C++-Implementierungen auf torch_df_offline.py basiert hier gefunden.

Zitate:

@inproceedings{schroeter2022deepfilternet2,title = {{DeepFilterNet2}: Towards Real-Time Speech Enhancement on Embedded Devices for Full-Band Audio},author = {Schröter, Hendrik und Escalante-B., Alberto N. und Rosenkranz, Tobias und Maier, Andreas},booktitle={17. Internationaler Workshop zur akustischen Signalverstärkung (IWAENC 2022)},Jahr = {2022},

} @inproceedings{schroeter2023deepfilternet3,title = {{DeepFilterNet}: Perceptually Motivated Real-Time Speech Enhancement},author = {Schröter, Hendrik und Rosenkranz, Tobias und Escalante-B., Alberto N. und Maier, Andreas},booktitle={ INTERSPEECH},Jahr = {2023},

}Noise-suppression-denseunet-ll: aus dem Open Model Zoo von OpenVINO™: https://github.com/openvinotoolkit/open_model_zoo

DeepFilterNet2 und DeepFilterNet3:

OpenVINO™-Notizbücher – Wir haben viel aus diesem fantastischen Satz Python-Notizbücher gelernt und verwenden ihn immer noch, um die neuesten/Best Practices für die Implementierung von KI-Pipelines mit OpenVINO™ zu erlernen!