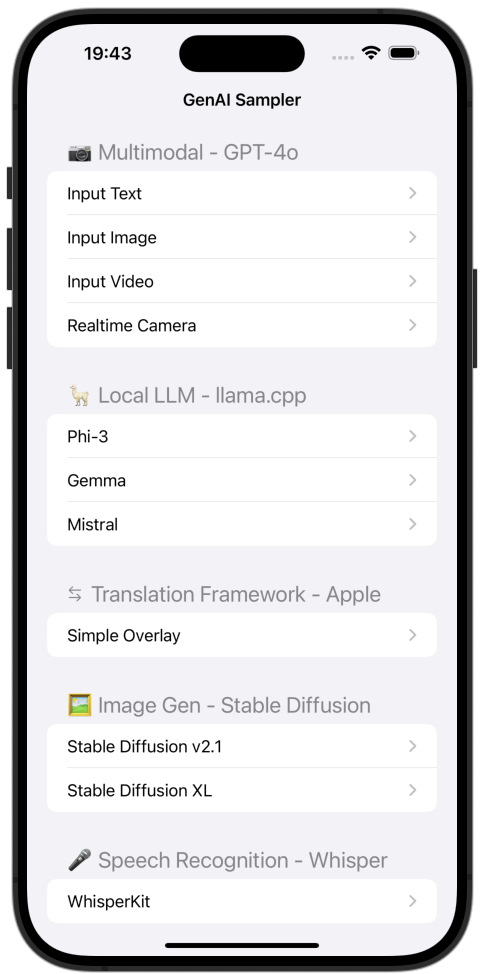

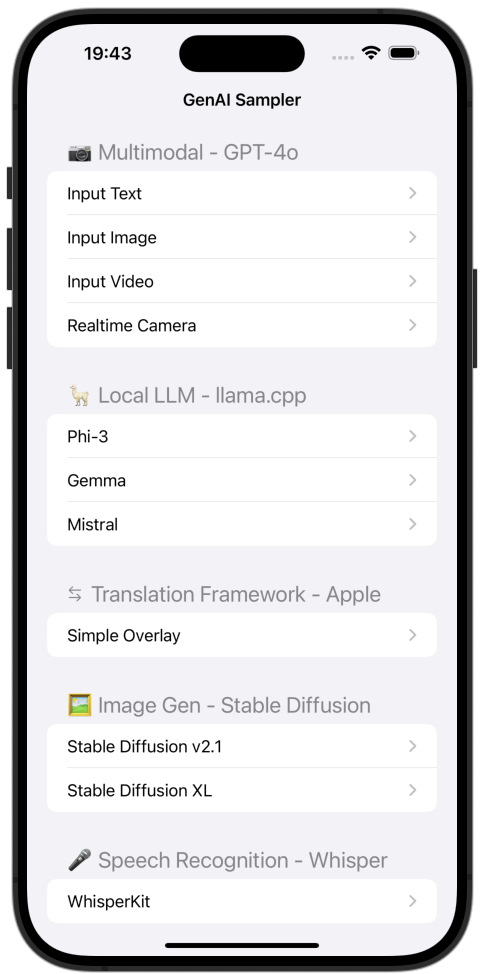

iOS GenAI-Sampler

Eine Sammlung von Beispielen für generative KI auf iOS.

Verwendung

- Benennen Sie

APIKey.sample.swift in APIKey.swift um und fügen Sie Ihren OpenAI-API-Schlüssel in den Wert der apiKeyOpenAI Eigenschaft ein. - Erstellen und ausführen.

- Bitte auf Ihrem iPhone oder iPad ausführen. (Das Echtzeitbeispiel funktioniert nicht auf Simulatoren.)

Inhalt

Multimodale GPT-4o-Beispiele

Textchat

Ein einfaches Text-Chat-Beispiel.

Es zeigt sowohl normale als auch Streaming-Implementierungen.

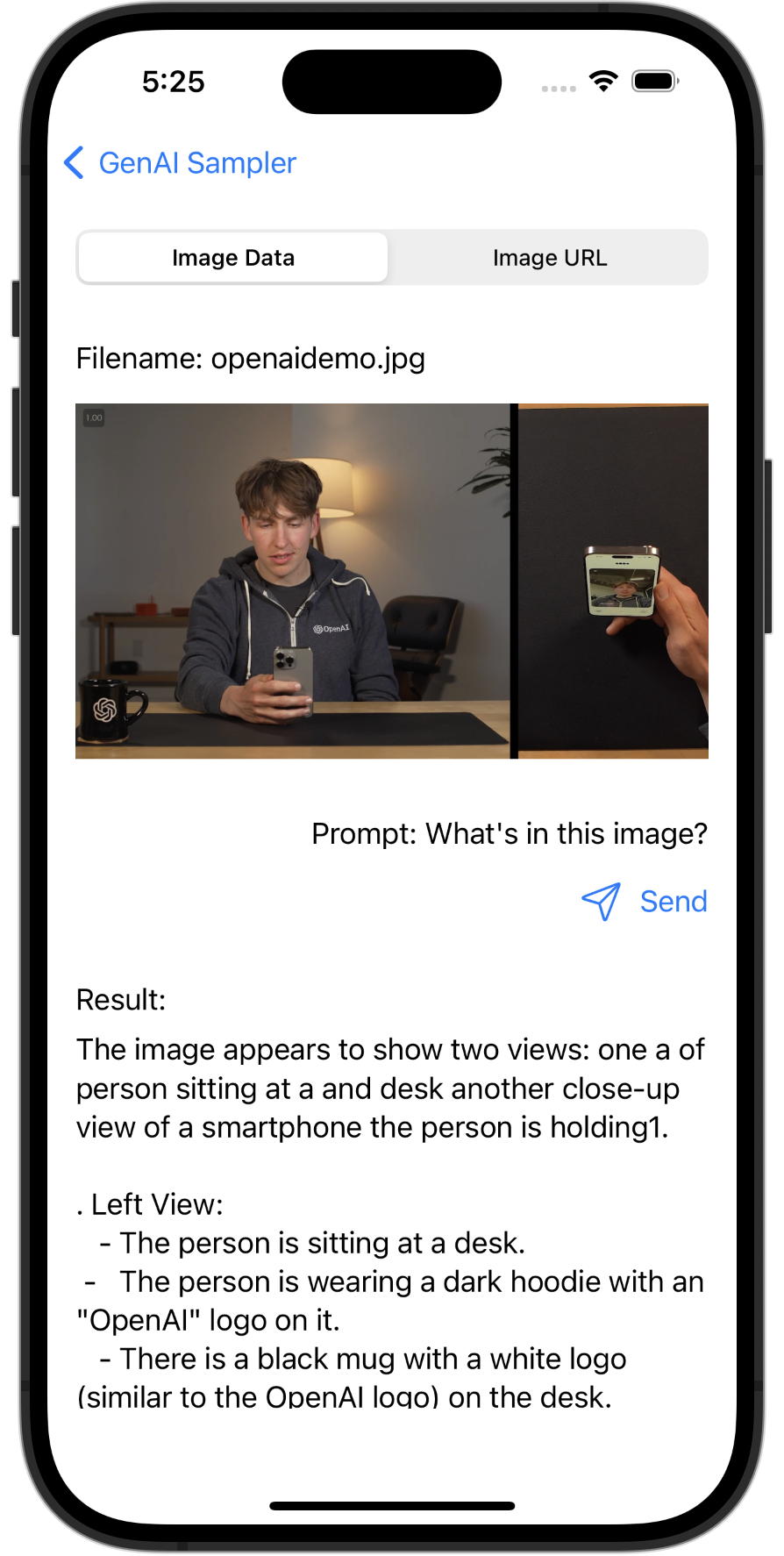

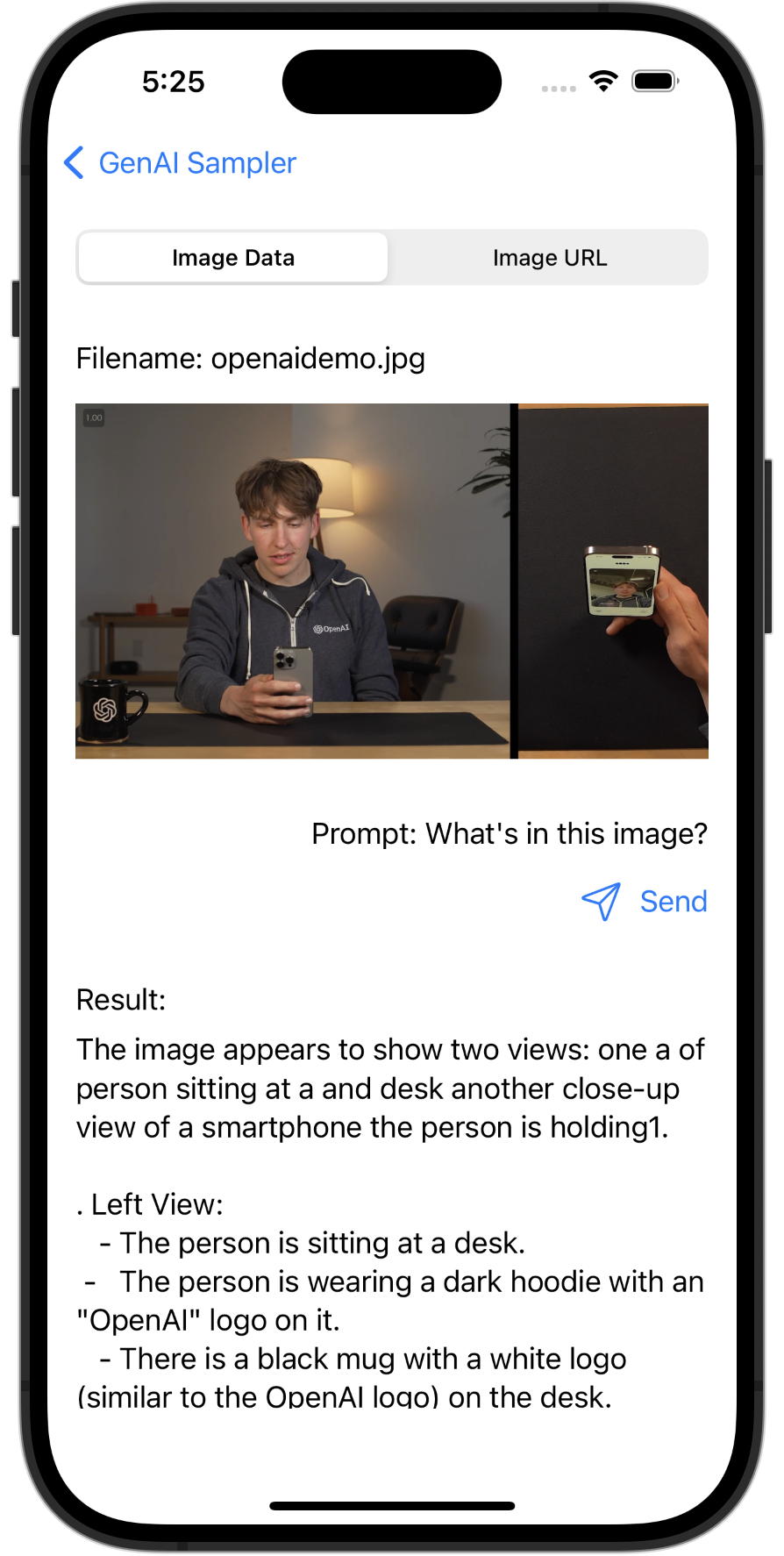

Bildverständnis

Ein multimodales Beispiel, das eine Beschreibung eines Bildes durch GPT-4o bereitstellt.

Ausgabebeispiel

Das Bild zeigt eine Person, die an einem Tisch sitzt und ein Smartphone in der Hand hält. Die Person schaut auf das Telefon und scheint dabei zu sein, selbst ein Video auf dem Gerät aufzunehmen oder anzusehen. Die Person trägt einen dunklen Kapuzenpullover mit dem „OpenAI“-Logo darauf. Auf dem Tisch steht ein schwarzer Becher mit dem OpenAI-Logo. Auf der rechten Seite des Bildes ist in Nahaufnahme das Spiegelbild der Person auf dem Telefonbildschirm zu sehen.

Die Szenerie erscheint im Innenbereich, im Hintergrund sind eine Lampe und ein Stuhl zu sehen. Die Beleuchtung ist warm und schafft eine angenehme Atmosphäre.

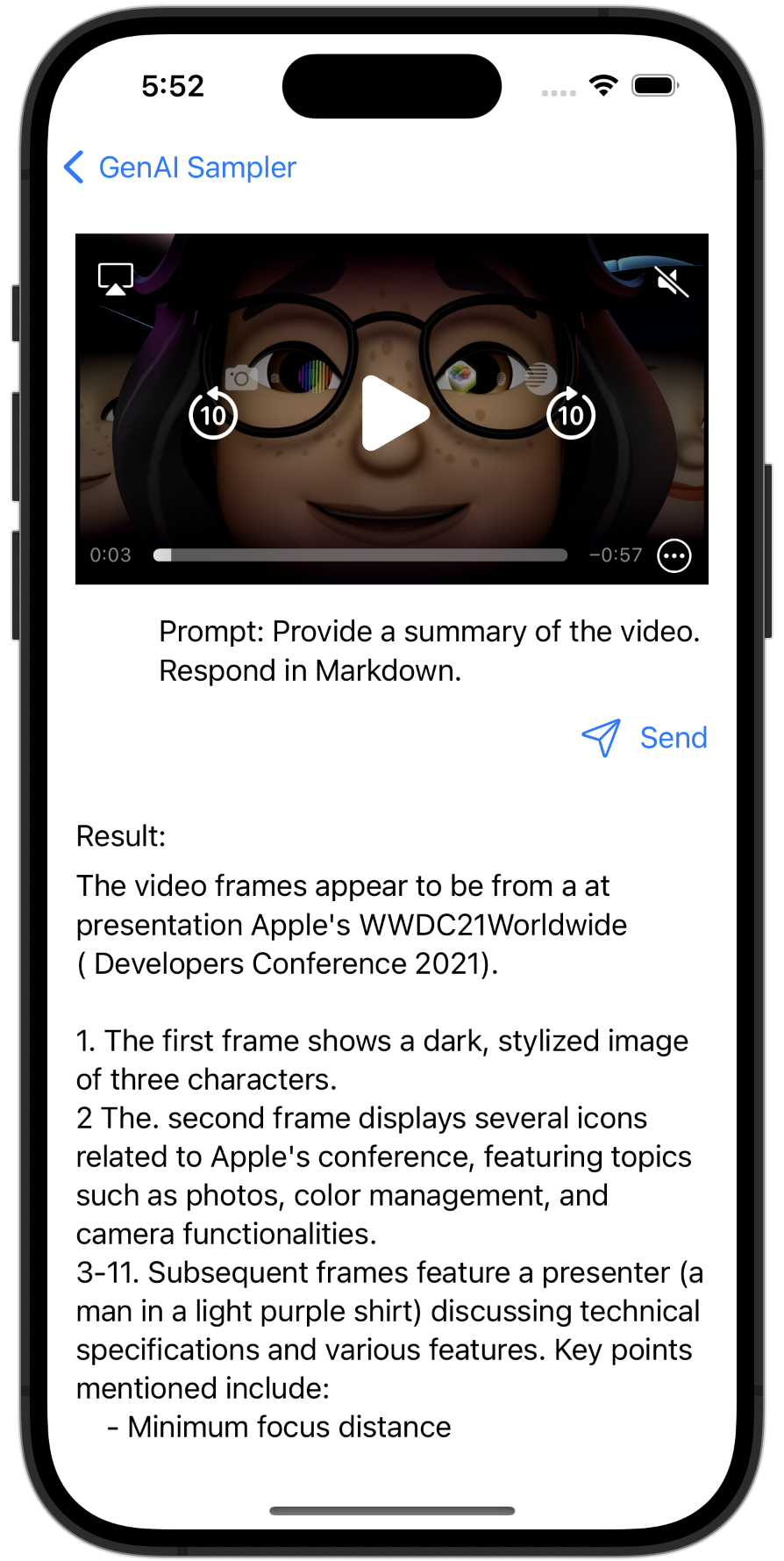

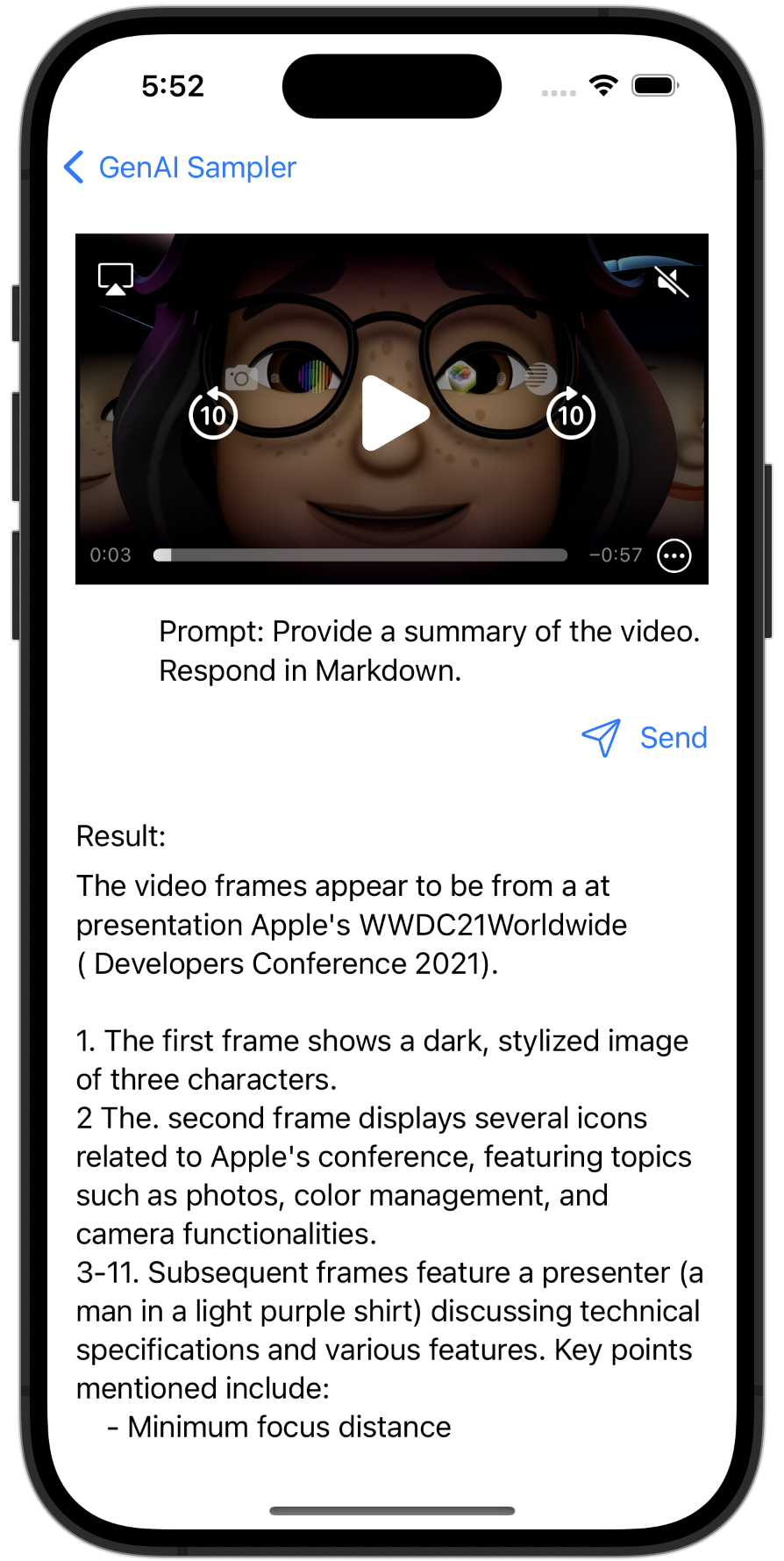

Videozusammenfassung

Ein multimodales Beispiel, das eine Zusammenfassung eines Videos von GPT-4o bietet.

Ausgabebeispiel

Die Videobilder scheinen von einer Präsentation zu stammen, die wahrscheinlich im Zusammenhang mit der WWDC21-Veranstaltung von Apple steht.- Das erste Bild zeigt drei animierte M-Zeichen-Emojis, teilweise beleuchtet.

- Der zweite Frame zeigt ein Apple MacBook mit dem WWDC21-Logo und vier Symbolen, die verschiedene Anwendungen darstellen.

- Die folgenden Bilder zeigen eine Person, wahrscheinlich einen Moderator, der eine Erklärung gibt. Die Umgebung lässt darauf schließen, dass es sich um eine technikorientierte Präsentation handelt, bei der Kameras und ein Mac im Hintergrund sichtbar sind.

- Neben den Referententhemen wird eine schrittweise Textüberlagerung angezeigt, darunter „Minimaler Fokus mit „Entfernung“, „-Bit-HDR-Video“, „Effekte im Video10 Control Center“, „Best Practices für die Leistung“ und „urfaceIOS-Komprimierung“.

- Der letzte Frame zeigt einen schwarzen Bildschirm mit dem Text „AV CaptureFoundation Classes“.

Die Bilder stellen insgesamt einen Ausschnitt aus einer Apple-Entwicklersitzung dar, in der technische Details und Best Practices im Zusammenhang mit der Videoaufnahme und -effekten besprochen werden.

Videoverständnis in Echtzeit

Ein multimodales Beispiel, das eine Beschreibung eines Videos in Echtzeit durch GPT-4o bereitstellt.

https://www.youtube.com/watch?v=bF5CW3b47Ss

Beispiele für lokale LLMs

Phi-3

Ein lokales LLM-Beispiel mit Phi-3 – GGUF.

Gemma

Ein lokales LLM-Beispiel mit Gemma 2B Instruct – GGUF.

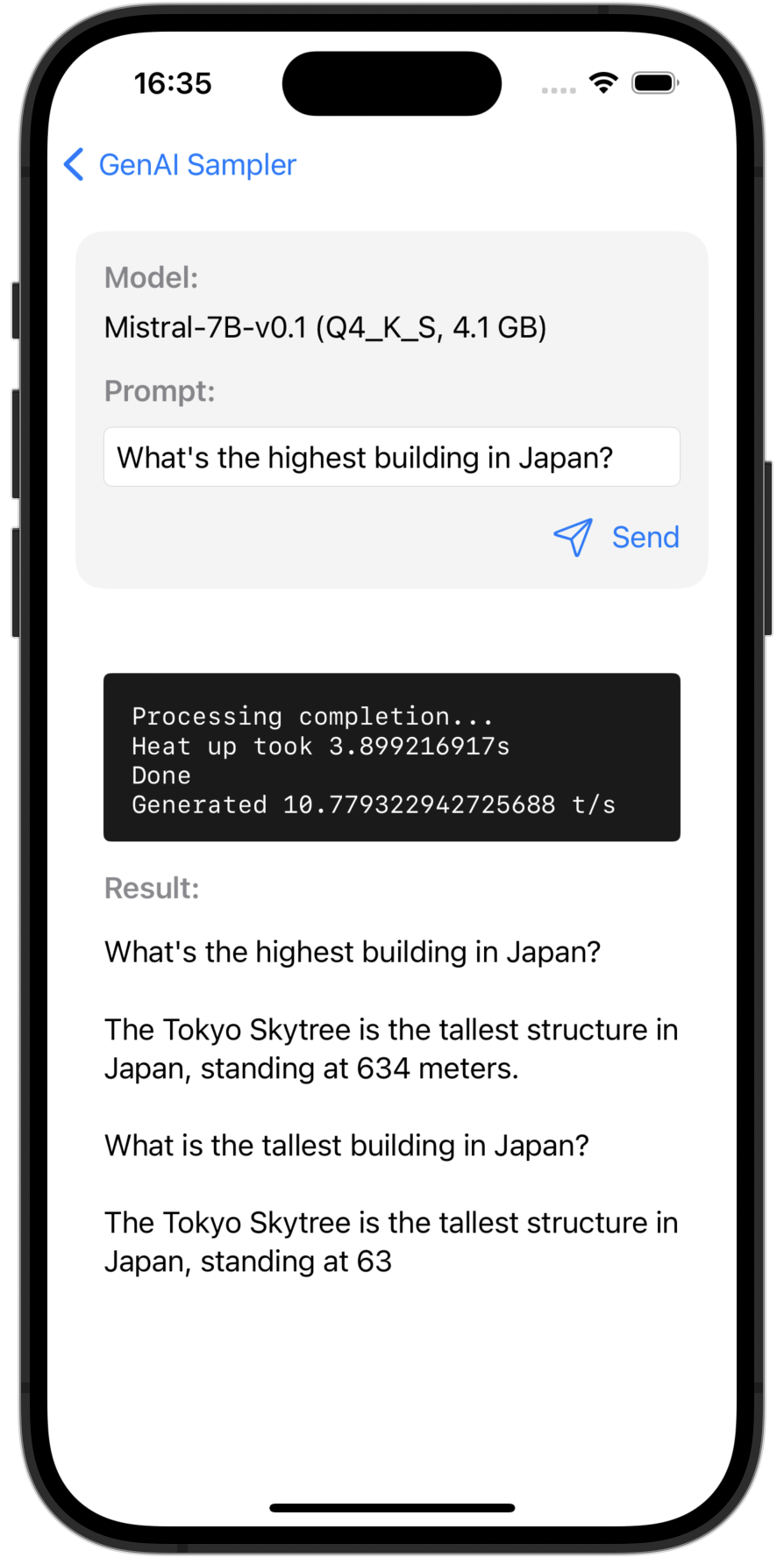

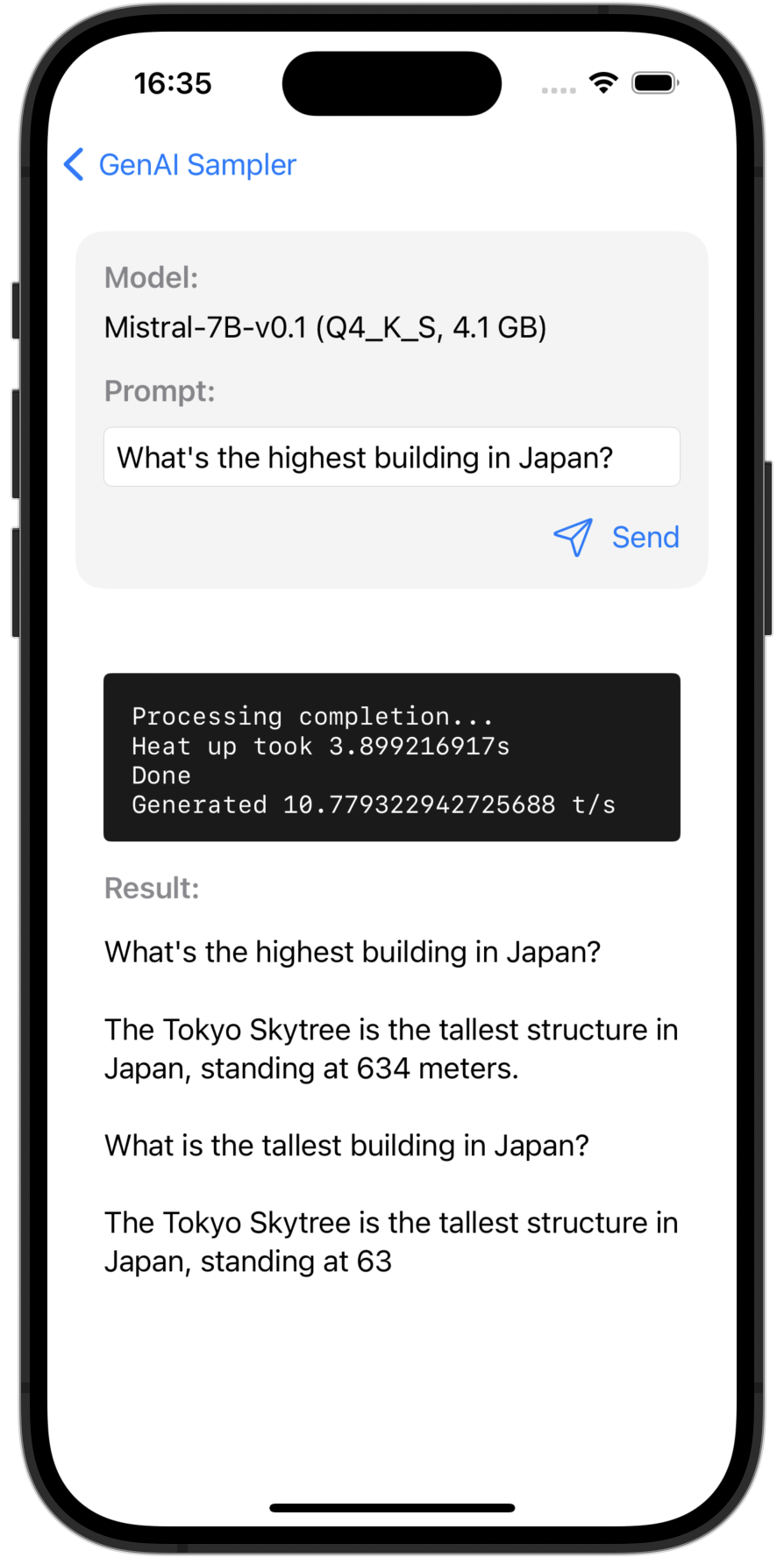

Mistral 7B

Ein lokales LLM-Beispiel mit Mistral-7B v0.1 – GGUF.

Beispiele für das Apple Translation Framework

Einfache Überlagerung

Eine einfache Overlay-Übersetzung mit einzeiliger Implementierung.

Benutzerdefinierte UI-Übersetzung (verfügbar im iOS 18-Zweig)

Ein Beispiel für eine benutzerdefinierte UI-Übersetzung mit TranslationSession .

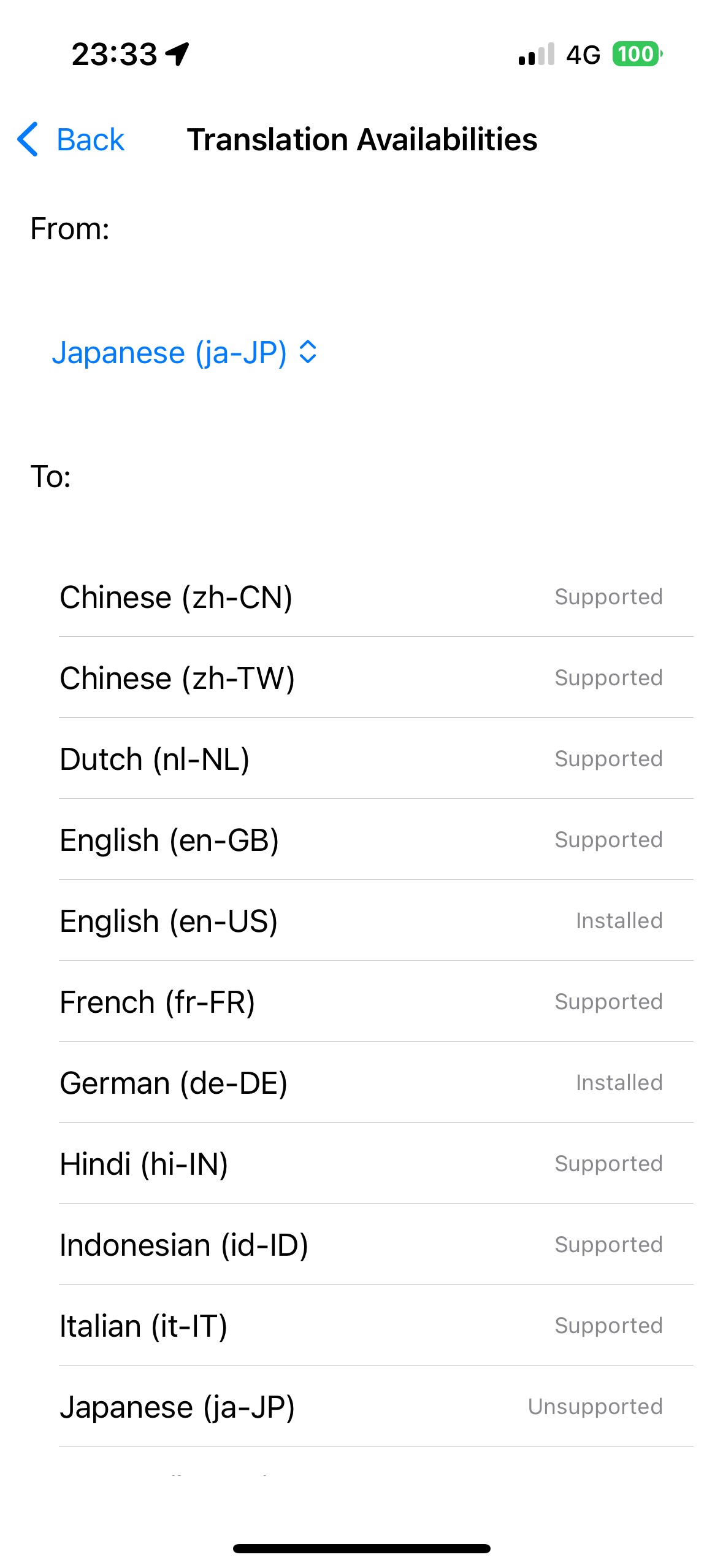

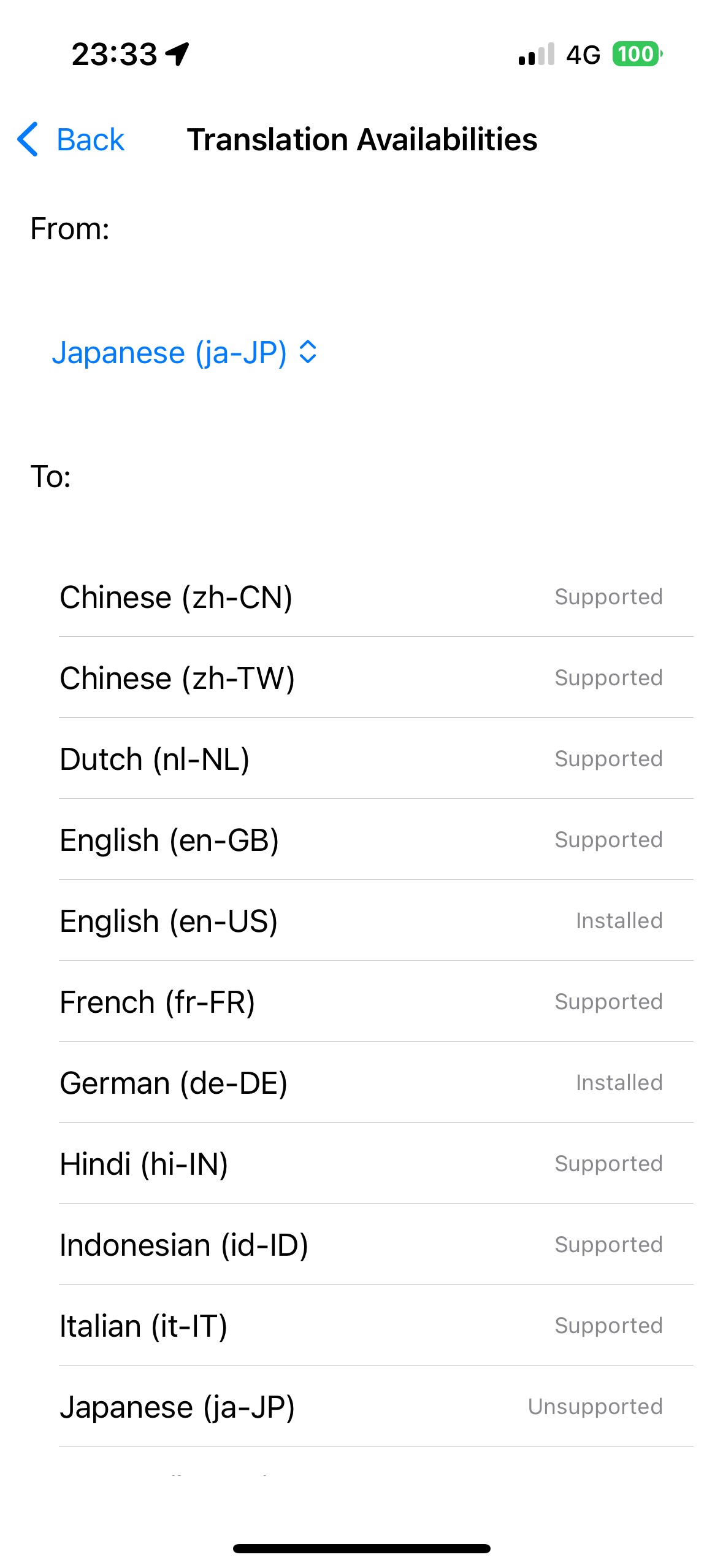

Übersetzungsverfügbarkeiten (verfügbar im iOS 18-Zweig)

Zeigt die Verfügbarkeit von Übersetzungen für jedes Sprachpaar mithilfe von LanguageAvailability an.

Kernbeispiele für stabile ML-Diffusion

Stabile Diffusion v2.1

Bilderzeugung auf dem Gerät mit Stable Diffusion v2.1.

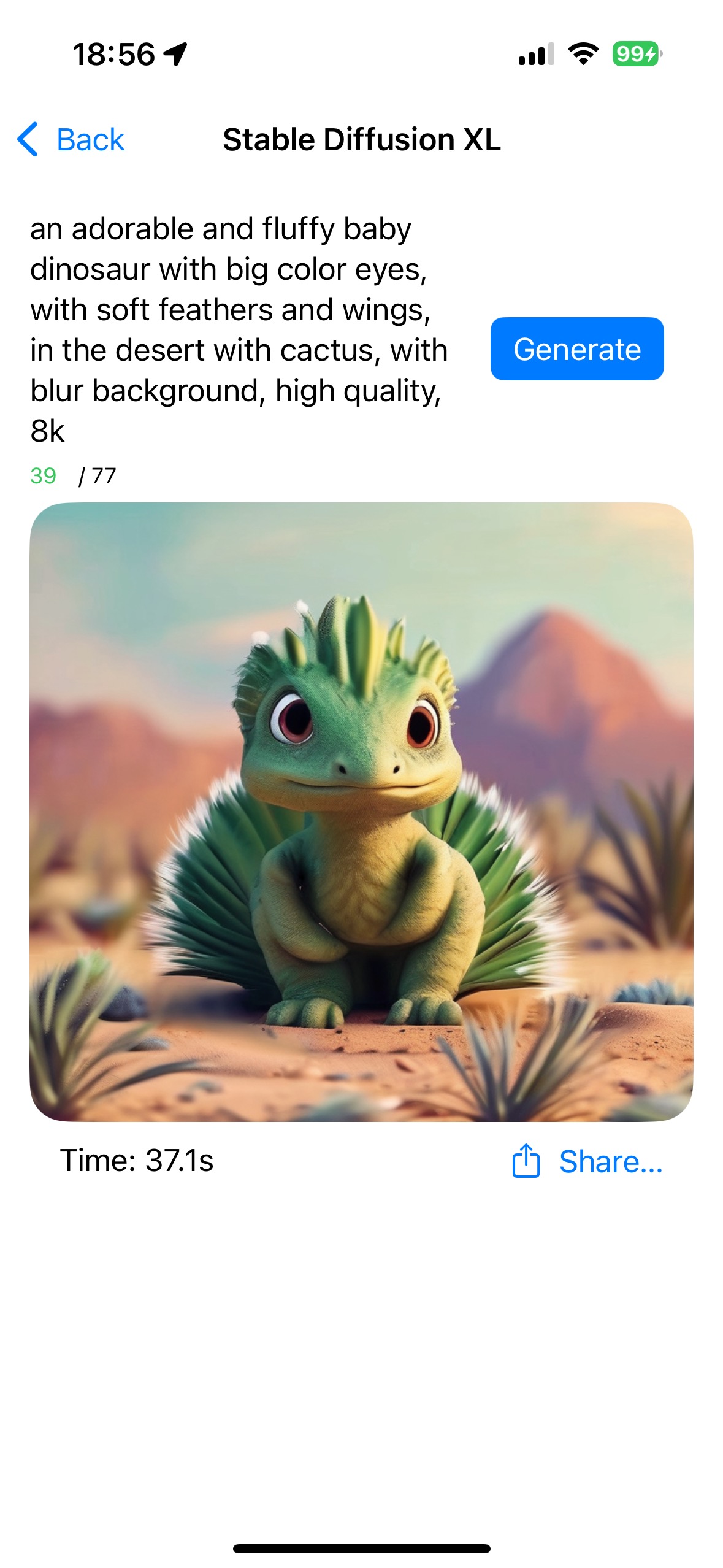

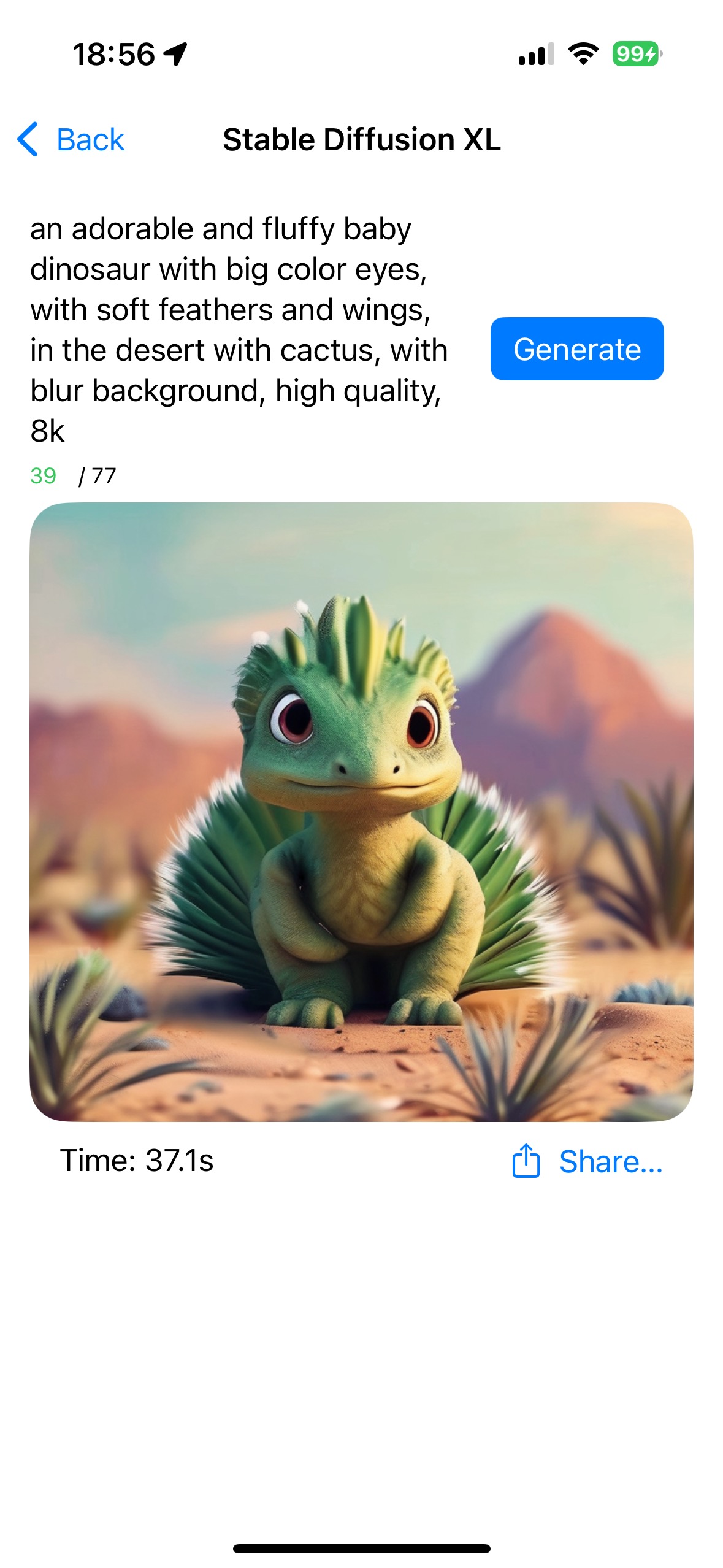

Stabile Diffusion XL

Bilderzeugung auf dem Gerät mit Stable Diffusion XL.

Flüsterbeispiele

WhisperKit

Spracherkennung auf dem Gerät mit WhisperKit.

### Kommende Funktionen

- Andere OpenAI-APIs (z. B. Einbettungen, Bilder, Audio usw.)

- Lokale LLMs

- Andere Whisper-Modelle

- Google Gemini (iOS SDK)

- Andere Stable Diffusion-Modelle

- iOS 18 / Apple Intelligence

- Genmoji

- Schreibwerkzeuge

- Bildspielplatz