Das Alfresco AI Framework ist ein robustes Framework zur Integration von KI-Funktionen in Alfresco unter Nutzung von Java und Spring AI. Es bietet eine Reihe von Tools und Diensten zur Verarbeitung, Analyse und Verbesserung von Dokumentinhalten in Alfresco mithilfe von KI- und maschinellen Lernmodellen.

Hinweis : Dieses Projekt verwendet die Spring AI SNAPSHOT-Version, da eine endgültige VERÖFFENTLICHUNG noch nicht verfügbar ist.

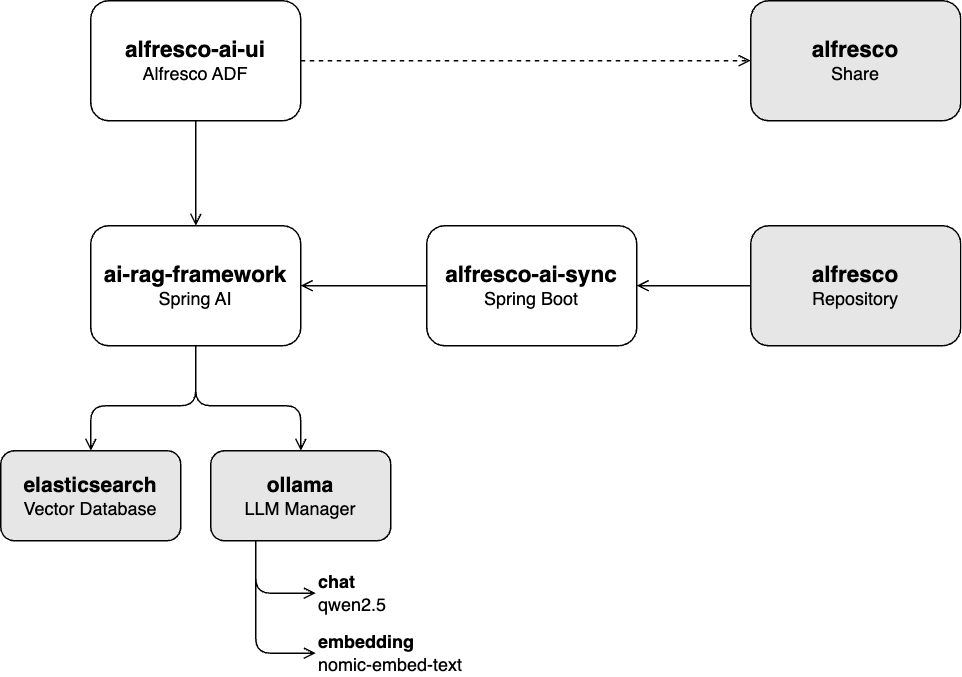

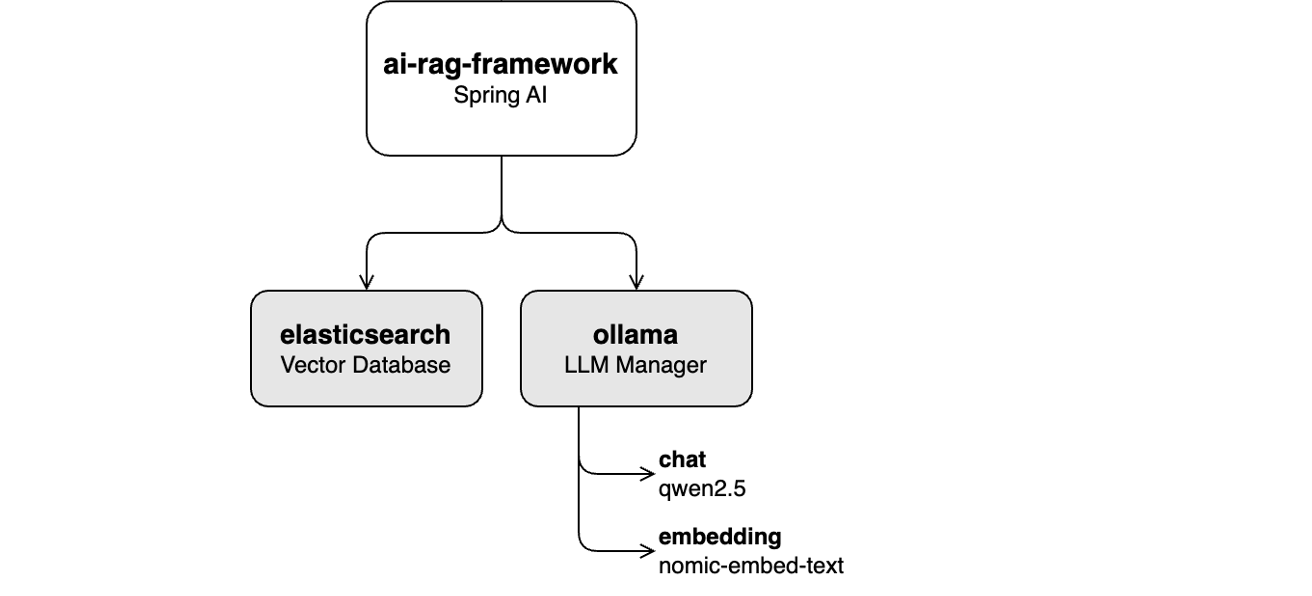

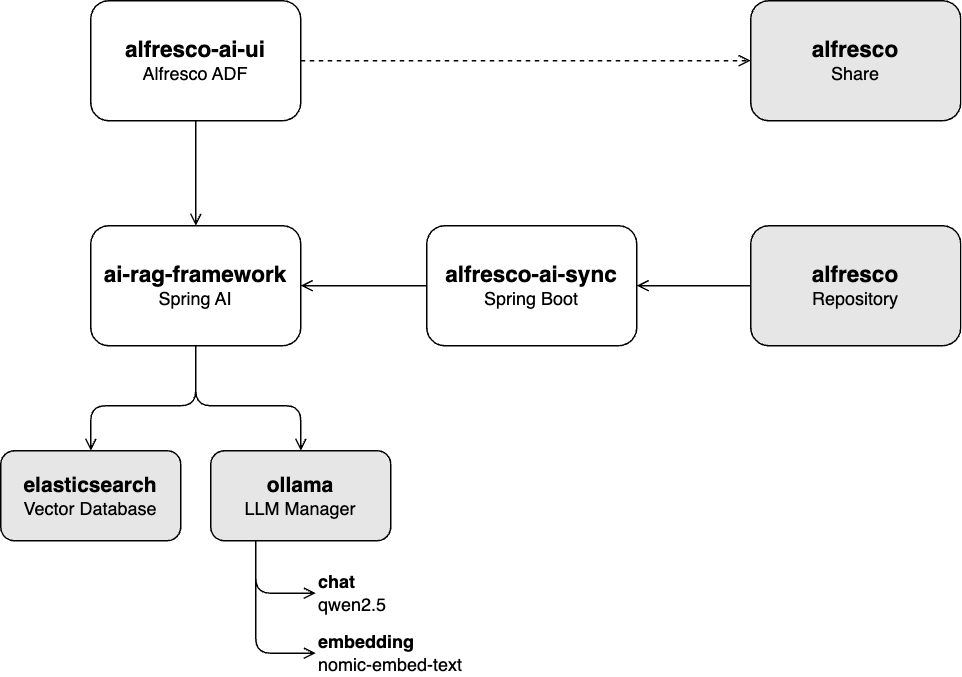

AI-Rag-Framework :

Eine auf Spring AI basierende REST-API zur Aufnahme von Dokumenten in ein GenAI-Modell (Generative AI) und zur Bereitstellung eines RAG-Chat-Dienstes (Retrieval-Augmented Generation).

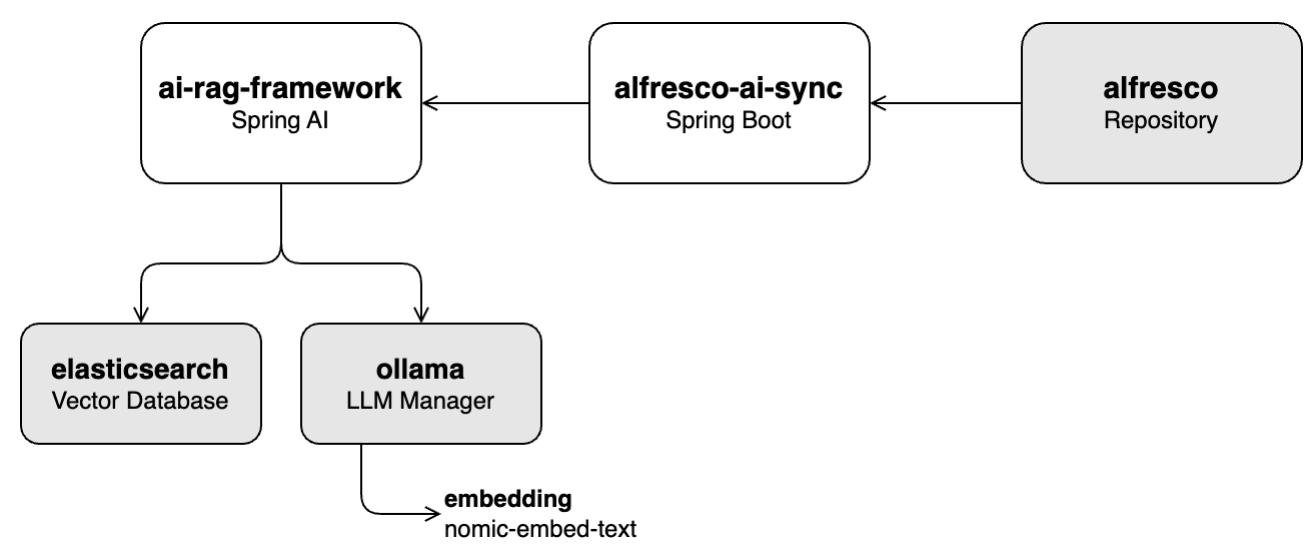

alfresco-ai-sync :

Ein auf dem Alfresco Java SDK aufbauender Dienst, der Dokumente aus dem Alfresco Repository abruft und sie über die ai-rag-framework -API in die Vektordatenbank einspeist.

ai-rag-framework Dienst alfresco-ai-ui :

Eine auf Alfresco ADF basierende Benutzeroberfläche für die Interaktion mit dem RAG-Chat-Dienst, der vom ai-rag-framework bereitgestellt wird.

ai-rag-framework Dienst muss ausgeführt werdenalfresco-docker : Containerorientierte Alfresco Community 23.3-Bereitstellung

Diese Reihe von Tutorials führt Sie durch die wichtigsten Funktionen des Projekts, einschließlich Datenerfassung, Chat-Integration und den Gesamtbetrieb des Systems.

In diesem Labor erfahren Sie, wie Sie die Vektordatenbank (Elasticsearch) mit ausgewählten Inhalten aus der in Alfresco gespeicherten Wissensdatenbank füllen. Dabei werden Vektoren aus Inhalten mithilfe des Einbettungsmoduls nomic-embed-text über Ollama extrahiert.

Beginnen Sie das Lab, indem Sie Lab 1: Ingestion Pipeline befolgen.

Dieses Labor konzentriert sich auf die Aktivierung der Chat-Funktionalität mit dem LLM qwen2.5 über Ollama unter Verwendung von Alfresco-UI-Apps wie Share und ADF. Der Prozess umfasst die Umwandlung der Benutzeraufforderung in Vektoren mithilfe des Einbettungsmoduls nomic-embed-text über Ollama und die anschließende Suche nach relevanten Inhalten in der Vektordatenbank (Elasticsearch). Der abgerufene Text wird verwendet, um dem LLM Kontext bereitzustellen, der dabei hilft, genauere Antworten zu generieren.

Beginnen Sie dieses Lab, indem Sie Lab 2: Chat-Funktionalität befolgen.

In diesem Labor integrieren Sie alle Komponenten (Aufnahme- und Chat-Funktionalität) in ein Live-Alfresco-Repository. Das System aktualisiert die Vector-Datenbank automatisch, wenn es Änderungen im Repository gibt, sodass kein manueller Eingriff erforderlich ist.

Sie können mit dieser Übung beginnen, indem Sie Übung 3: Gemeinsames Ausführen aller Komponenten befolgen.

Dieses Projekt ist unter der Apache-Lizenz 2.0 lizenziert. Einzelheiten finden Sie in der LICENSE-Datei.

Besonderer Dank geht an die Teams von Alfresco und Hyland für ihre kontinuierliche Unterstützung und Beiträge zu Open-Source-Initiativen in den Bereichen Content Management und KI.