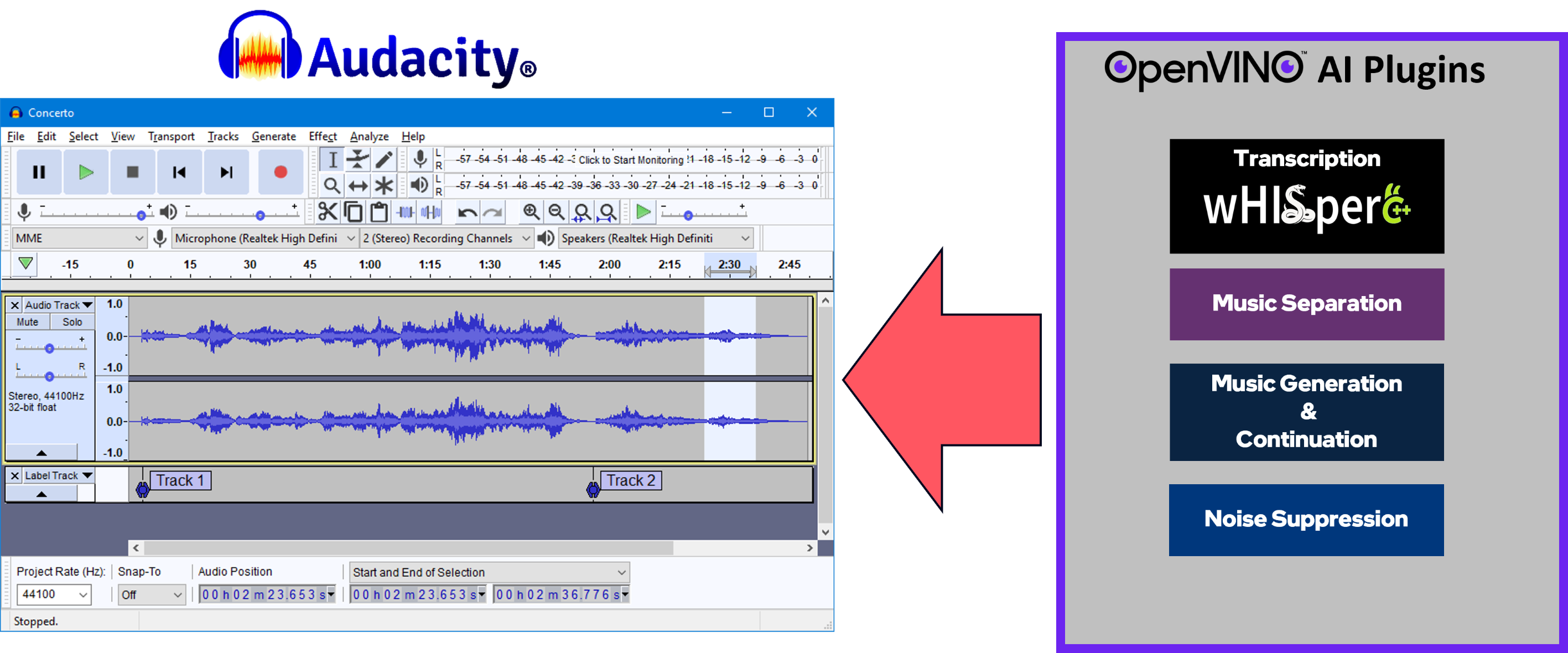

Un conjunto de efectos, generadores y analizadores habilitados para IA para Audacity®. ¿Estas funciones de IA se ejecutan 100% localmente en su PC? - ¡No se necesita conexión a Internet! OpenVINO™ se utiliza para ejecutar modelos de IA en aceleradores compatibles que se encuentran en el sistema del usuario, como CPU, GPU y NPU.

Separación de música : separe una pista mono o estéreo en temas individuales: batería, bajo, voz y otros instrumentos.

Supresión de ruido : elimina el ruido de fondo de una muestra de audio.

Generación y continuación de música : utiliza MusicGen LLM para generar fragmentos de música o para generar una continuación de un fragmento de música existente.

Transcripción Whisper : utiliza Whisper.cpp para generar una pista de etiqueta que contiene la transcripción o traducción de una selección determinada de audio hablado o voces.

Vaya aquí para encontrar paquetes de instalación e instrucciones para la última versión de Windows.

Instrucciones de compilación de Windows

Instrucciones de compilación de Linux

Le invitamos a enviar un problema aquí para

Preguntas

Informes de errores

Solicitudes de funciones

Comentarios de cualquier tipo: ¿cómo podemos mejorar este proyecto?

Sus contribuciones son bienvenidas y valoradas, sin importar cuán grandes o pequeñas sean. ¡No dudes en enviar una solicitud de extracción!

Equipo de desarrollo de Audacity® y Muse Group: ¡Gracias por su apoyo!

Audacity® GitHub - https://github.com/audacity/audacity

El analizador de transcripción y traducción Whisper utiliza Whisper.cpp (con backend OpenVINO™): https://github.com/ggerganov/whisper.cpp

La generación y continuación de música utilizan el modelo MusicGen, de Meta.

Actualmente tenemos soporte para MusicGen-Small y MusicGen-Small-Stereo

Los canales de texto a música se transfirieron de Python a C++, haciendo referencia a la lógica del proyecto de transformadores Hugging Face: https://github.com/huggingface/transformers

El efecto de separación de música utiliza el modelo Demucs v4 de Meta (https://github.com/facebookresearch/demucs), que ha sido adaptado para funcionar con OpenVINO™.

Supresión de ruido:

Porté los modelos y la canalización desde aquí: https://github.com/Rikorose/DeepFilterNet

También utilizamos la bifurcación/rama de @grazder (https://github.com/grazder/DeepFilterNet/tree/torchDF-changes) para comprender mejor la implementación de Rust, por lo que también basamos parte de nuestra implementación de C++ en torch_df_offline.py encontrado aquí.

Citas:

@inproceedings{schroeter2022deepfilternet2,title = {{DeepFilterNet2}: Hacia una mejora del habla en tiempo real en dispositivos integrados para audio de banda completa},autor = {Schröter, Hendrik y Escalante-B., Alberto N. y Rosenkranz, Tobias y Maier, Andreas},booktitle={17º Taller Internacional sobre Mejora de la Señal Acústica (IWAENC 2022)},año = {2022},

} @inproceedings{schroeter2023deepfilternet3,title = {{DeepFilterNet}: mejora del habla en tiempo real motivada por la percepción},autor = {Schröter, Hendrik y Rosenkranz, Tobias y Escalante-B., Alberto N. y Maier, Andreas},booktitle={ INTERSPEECH},año = {2023},

}noise-suppression-denseunet-ll: del Open Model Zoo de OpenVINO™: https://github.com/openvinotoolkit/open_model_zoo

DeepFilterNet2 y DeepFilterNet3:

Cuadernos OpenVINO™: ¡Hemos aprendido mucho de este increíble conjunto de cuadernos de Python y todavía lo estamos usando para aprender las últimas y mejores prácticas para implementar canales de IA usando OpenVINO™!