· Papier · Benchmark · Page d'accueil · Document ·

✅ [2024/07/25] Visual PEFT Benchmark commence à publier un ensemble de données, du code, etc.

✅ [2024/06/20] La page d'accueil de Visual PEFT Benchmark est créée.

✅ [01/06/2024] Le dépôt Visual PEFT Benchmark est créé.

Introduction

Commencer

Structure du code

Démarrage rapide

Résultats et points de contrôle

Communauté et contact

Citation

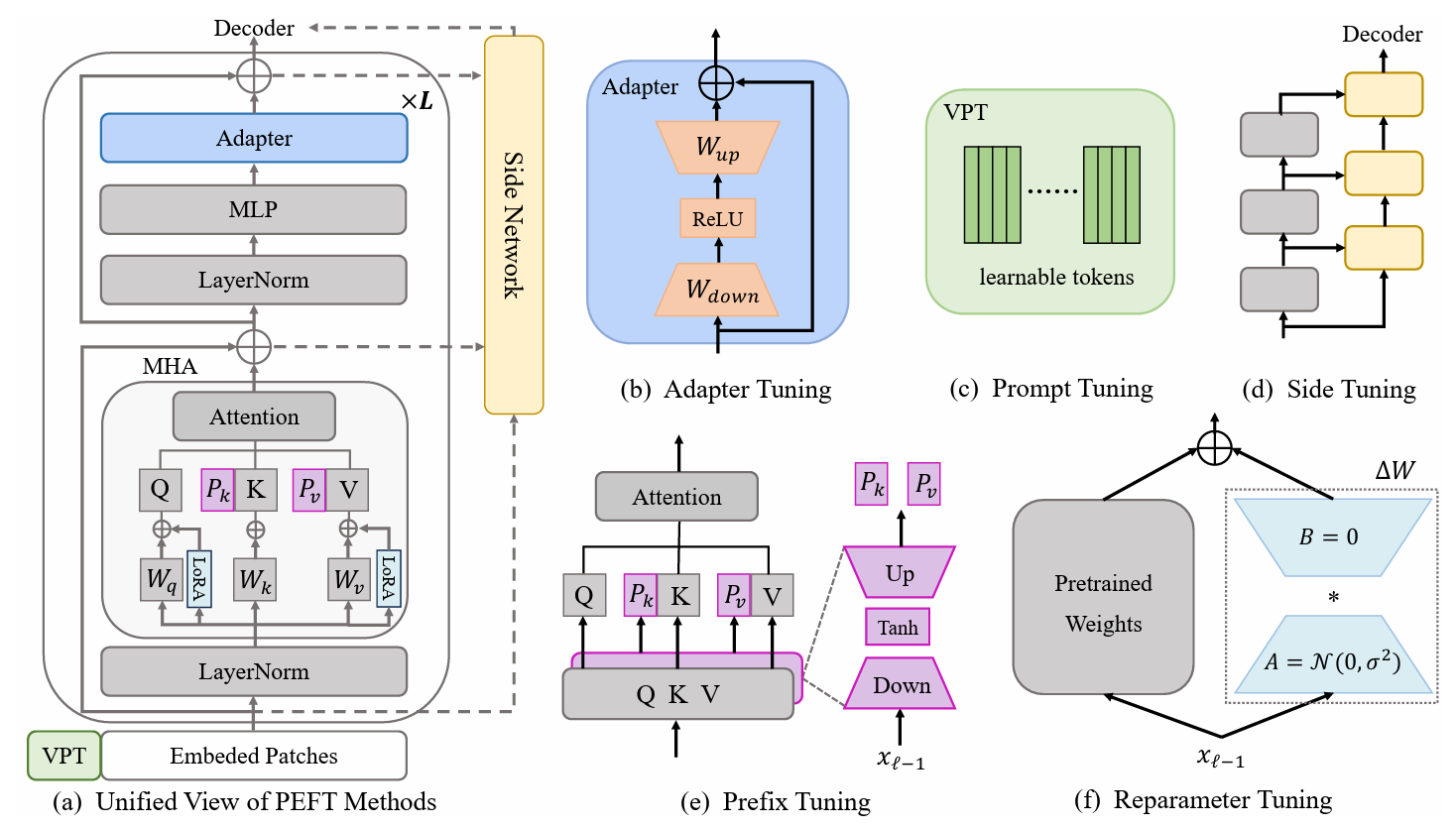

Les méthodes d'apprentissage par transfert efficace des paramètres (PETL) sont prometteuses pour adapter un modèle pré-entraîné à diverses tâches en aval tout en n'entraînant que quelques paramètres. Dans le domaine de la vision par ordinateur (CV), de nombreux algorithmes PETL ont été proposés, mais leur emploi direct ou leur comparaison reste peu pratique. Pour relever ce défi, nous construisons un benchmark visuel unifié PETL (V-PETL Bench) pour le domaine CV en sélectionnant 30 ensembles de données divers, stimulants et complets issus de la reconnaissance d'images, de la reconnaissance d'actions vidéo et des tâches de prédiction denses . Sur ces ensembles de données, nous évaluons systématiquement 25 algorithmes PETL dominants et open-source une base de code modulaire et extensible pour une évaluation équitable de ces algorithmes.

Tâches de classification visuelle à grain fin (FGVC)

FGVC comprend 5 ensembles de données de classification visuelle à grain fin. Les ensembles de données peuvent être téléchargés en suivant les liens officiels. Nous divisons les données de formation si l'ensemble de validation public n'est pas disponible. L'ensemble de données divisé peut être trouvé ici : Lien de téléchargement.

CUB200 2011

NABirds

Fleurs d'Oxford

Chiens de Stanford

Voitures de Stanford

Benchmark visuel d'adaptation aux tâches (VTAB)

VTAB comprend 19 ensembles de données de classification visuelle divers. Nous avons traité tout l'ensemble de données et les données peuvent être téléchargées ici : Lien de téléchargement. Pour des procédures de traitement spécifiques et des conseils, veuillez consulter VTAB_SETUP.

Cinétique-400

Téléchargez l'ensemble de données à partir du lien de téléchargement ou du lien de téléchargement.

Prétraitez l'ensemble de données en redimensionnant le bord court de la vidéo à 320 px . Vous pouvez vous référer à MMAction2 Data Benchmark.

Générez les annotations nécessaires au chargeur de données ("<video_id> <video_class>" dans les annotations). L'annotation inclut généralement train.csv , val.csv et test.csv . Le format du fichier *.csv est le suivant :

video_1.mp4 label_1 video_2.mp4 label_2 video_3.mp4 label_3 ... video_N.mp4 label_N

Quelque chose-Quelque chose V2 (SSv2)

Téléchargez l'ensemble de données à partir du lien de téléchargement.

Prétraitez l'ensemble de données en modifiant l'extension vidéo de webm en .mp4 avec la hauteur d'origine de 240px . Vous pouvez vous référer à MMAction2 Data Benchmark.

Générez les annotations nécessaires au chargeur de données ("<video_id> <video_class>" dans les annotations). L'annotation inclut généralement train.csv , val.csv et test.csv . Le format du fichier *.csv est le suivant :

video_1.mp4 label_1 video_2.mp4 label_2 video_3.mp4 label_3 ... video_N.mp4 label_N

MS-COCO

MS-COCO sont disponibles à partir de ce lien de téléchargement.

ADE20K

L'ensemble de formation et de validation de l'ADE20K peut être téléchargé à partir de ce lien de téléchargement. Nous pouvons également télécharger l'ensemble de tests à partir du lien de téléchargement.

PASCAL COV

Pascal VOC 2012 peut être téléchargé à partir du lien de téléchargement. En outre, les travaux les plus récents sur l'ensemble de données Pascal VOC exploitent généralement des données d'augmentation supplémentaires, qui peuvent être trouvées sur le lien de téléchargement.

Téléchargez et placez le modèle pré-entraîné ViT-B/16 dans /path/to/pretrained_models .

mkdir modèles_pré-entraînés wget https://storage.googleapis.com/vit_models/imagenet21k/ViT-B_16.npz

ou vous pouvez télécharger le modèle pré-entraîné Swin-B. Notez que vous devez également renommer le ckpt Swin-B téléchargé de swin_base_patch4_window7_224_22k.pth en Swin-B_16.pth .

mkdir modèles_pré-entraînés wget https://github.com/SwinTransformer/storage/releases/download/v1.0.0/swin_base_patch4_window7_224_22k.pth mv swin_base_patch4_window7_224_22k.pth Swin_B_16.pth

Une autre façon consiste à télécharger des modèles pré-entraînés à partir du lien ci-dessous et à les placer dans /path/to/pretrained_models .

| Backbone pré-entraîné | Objectif pré-entraîné | Ensemble de données pré-entraîné | Point de contrôle |

|---|---|---|---|

| ViT-B/16 | Supervisé | ImageNet-21K | Lien de téléchargement |

| ViT-L/16 | Supervisé | ImageNet-21K | Lien de téléchargement |

| ViT-H/16 | Supervisé | ImageNet-21K | Lien de téléchargement |

| Swin-B | Supervisé | ImageNet-22K | Lien de téléchargement |

| Swin-L | Supervisé | ImageNet-22K | Lien de téléchargement |

| ViT-B (VidéoMAE) | Auto-supervisé | Cinétique-400 | Lien de téléchargement |

| Vidéo Swin-B | Supervisé | Cinétique-400 | Lien de téléchargement |

ImageClassification/configs : gère les paramètres de configuration pour les expériences.

ImageClassification/config/vtab/cifar100.yaml : principales configurations de configuration pour les expériences et explication pour chacun des ensembles de données.

.....

ImageClassification/dataloader : chargement et configuration des ensembles de données d'entrée.

ImageClassification/dataloader/transforms : Transformations d'images.

ImageClassification/dataloader/loader : Construit le chargeur de données pour l'ensemble de données donné.

ImageClassification/models : gère les arcs et les têtes de la colonne vertébrale pour différents protocoles de réglage fin

ImageClassification/models/vision_transformer_adapter.py : un dossier contient les mêmes backbones dans le dossier vit_backbones , spécifié pour l'adaptateur.

ImageClassification/models/vision_transformer_sct.py : un dossier contient les mêmes backbones dans le dossier vit_backbones , spécifié pour SCT.

.....

ImageClassification/train : un dossier contient le dossier training file ,

ImageClassification/train/train_model_adapter.py : appelez celui-ci pour la formation et évaluez un modèle avec un type de transfert spécifié, spécifié pour l'adaptateur.

ImageClassification/train/train_model_sct.py : appelez celui-ci pour la formation et évaluez un modèle avec un type de transfert spécifié, spécifié pour SCT.

.....

ImageClassification/scripts : un dossier contient le dossier scripts file ,

ImageClassification/scripts/run_vit_adapter.sh : Vous pouvez exécuter la méthode Adapter sur tous les ensembles de données à la fois.

ImageClassification/scripts/run_vit_sct.sh : Vous pouvez exécuter la méthode Adapter sur tous les ensembles de données à la fois.

.....

ImageClassification/Visualize : Outils de visualisation.

ImageClassification/Visualize/AttentionMap.py : Visualisation de la carte d'attention.

ImageClassification/Visualize/TSNE.py : visualisation T-SNE.

ImageClassification/utils : Créer un enregistreur, Définir une graine, etc.

❗️Remarque❗️ : Si vous souhaitez créer votre propre algorithme PETL, faites attention à `ImageClassification/models`.

Ceci est un exemple de la façon de configurer V-PETL Bench localement.

Pour obtenir une copie locale, suivez ces exemples simples d'étapes.

clone git https://github.com/synbol/Parameter-Efficient-Transfer-Learning-Benchmark.git

V-PETL Bench est construit sur pytorch, avec torchvision, torchaudio et timm, etc.

Pour installer les packages requis, vous pouvez créer un environnement conda.

conda create --name v-petl-bench python=3.8

Activez l'environnement conda.

conda active v-petl-bench

Utilisez pip pour installer les packages requis.

cd Paramètre-Efficient-Transfer-Learning-Benchmark pip install -r exigences.txt

Nous proposons une démo de formation et d'évaluation spécifique, en prenant comme exemple LoRA sur VTAB Cifar100.

système d'importation

sys.path.append("Parameter-Efficient-Transfer-Learning-Benchmark")

importer une torche

à partir des utilitaires d'importation ImageClassification

à partir de ImageClassification.dataloader importer vtab

à partir d'ImageClassification.train importer train# obtenir les méthodes loraà partir de timm.scheduler.cosine_lr importer CosineLRScheduler

à partir d'ImageClassification.models, importez vision_transformer_lora

importer timm# chemin pour enregistrer le modèle et logsexp_base_path = '../output'utils.mkdirss(exp_base_path)# create loggerlogger = utils.create_logger(log_path=exp_base_path, log_name='training')# paramètre de configuration de l'ensemble de donnéesconfig = utils.get_config(' model_lora', 'vtab', 'cifar100')# obtenir vtab datasetdata_path = '/home/ma-user/work/haozhe/synbol/vtab-1k'train_dl, test_dl = vtab.get_data(data_path, 'cifar100', logger, évalue=False, train_aug=config['train_aug'], batch_size =config['batch_size'])# obtenir modelmodel pré-entraîné = timm.models.create_model('vit_base_patch16_224_in21k_lora', checkpoint_path='./released_models/ViT-B_16.npz', drop_path_rate=0.1, tuning_mode='lora')

model.reset_classifier(config['class_num'])# paramètres de formationtrainable = []for n, p in model.named_parameters() : si 'linear_a' en n ou 'linear_b' en n ou 'head' en n :

entraînable.append (p)

logger.info(str(n))

autre:

p.requires_grad = Faux

opt = torch.optim.AdamW (entraînable, lr = 1e-4, poids_decay = 5e-2)

planificateur = CosineLRScheduler(opt, t_initial=config['epochs'], warmup_t=config['warmup_epochs'], lr_min=1e-5, warmup_lr_init=1e-6, cycle_decay = 0.1)# crossEntropyLoss functioncriterion = torch.nn.CrossEntropyLoss( )# modèle de formation = train.train(config, modèle, critère, train_dl, opt, planificateur, enregistreur, config['epochs'], 'vtab', 'cifar100')# évaluationeval_acc = train.test(model, test_dl, 'vtab')Vous pouvez vous entraîner avec un algorithme PETL sur un ensemble de données.

python python train/train_model_sct.py --dataset cifar100 --task vtab --lr 0.012 --wd 0.6 --eval True --dpr 0.1 --tuning_mode $tuning_mode --model_type $model_type --model $model --model_checkpoint $ modèle_checkpoint

ou vous pouvez vous entraîner avec un algorithme PETL sur tous les ensembles de données

scripts bash/run_model_sct.sh

Nous évaluons 13 algorithmes PETL sur cinq ensembles de données avec des modèles ViT-B/16 pré-entraînés sur ImageNet-21K.

Pour obtenir le point de contrôle, veuillez le télécharger sur le lien de téléchargement.

| Méthode | CUB-200-2011 | NABirds | Fleurs d'Oxford | Chiens de Stanford | Voitures de Stanford | Signifier | Paramètres. | PPT |

|---|---|---|---|---|---|---|---|---|

| Mise au point complète | 87,3 | 82,7 | 98,8 | 89,4 | 84,5 | 88.54 | 85,8 millions | - |

| Sondage linéaire | 85,3 | 75,9 | 97,9 | 86,2 | 51.3 | 79.32 | 0 M | 0,79 |

| Adaptateur | 87.1 | 84,3 | 98,5 | 89,8 | 68,6 | 85,66 | 0,41M | 0,84 |

| AdaptAncien | 88,4 | 84,7 | 99,2 | 88,2 | 81,9 | 88.48 | 0,46 M | 0,87 |

| Réglage du préfixe | 87,5 | 82,0 | 98,0 | 74.2 | 90,2 | 86.38 | 0,36 M | 0,85 |

| U-Tuning | 89,2 | 85,4 | 99,2 | 84.1 | 92.1 | 90.00 | 0,36 M | 0,89 |

| BitFit | 87,7 | 85,2 | 99,2 | 86,5 | 81,5 | 88.02 | 0,10M | 0,88 |

| VPT-peu profond | 86,7 | 78,8 | 98,4 | 90,7 | 68,7 | 84,66 | 0,25M | 0,84 |

| VPT-Profond | 88,5 | 84,2 | 99,0 | 90,2 | 83,6 | 89.10 | 0,85M | 0,86 |

| FSS | 89,5 | 85,7 | 99,6 | 89,6 | 89,2 | 90,72 | 0,39M | 0,89 |

| LoRA | 85,6 | 79,8 | 98,9 | 87,6 | 72,0 | 84,78 | 0,77M | 0,82 |

| GPS | 89,9 | 86,7 | 99,7 | 92,2 | 90,4 | 91,78 | 0,66 M | 0,90 |

| TVH | 89,2 | 85,8 | 99,6 | 89,5 | 88,2 | 90.46 | 0,78M | 0,88 |

| DERNIER | 88,5 | 84,4 | 99,7 | 86,0 | 88,9 | 89.50 | 0,66 M | 0,87 |

| FNS | 90,2 | 87,4 | 99,7 | 89,5 | 86,9 | 90,74 | 0,25M | 0,90 |

Résultats de référence sur VTAB. Nous évaluons 18 algorithmes PETL sur 19 ensembles de données avec des modèles ViT-B/16 pré-entraînés sur ImageNet-21K.

Pour obtenir le point de contrôle, veuillez le télécharger sur le lien de téléchargement.

| Méthode | CIFAR-100 | Caltech101 | DTD | Fleurs102 | Animaux de compagnie | SVHN | Soleil397 | Patch Camelyon | EuroSAT | Résiste45 | Rétinopathie | Clevr/compte | Intelligence/distance | Laboratoire DM | KITTI/distance | dSprites/loc | dSprites/ori | PetitNORB/azi | PetitNORB/ele | Signifier | Paramètres. | PPT |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Mise au point complète | 68,9 | 87,7 | 64,3 | 97,2 | 86,9 | 87,4 | 38,8 | 79,7 | 95,7 | 84,2 | 73,9 | 56.3 | 58,6 | 41,7 | 65,5 | 57,5 | 46,7 | 25,7 | 29.1 | 65,57 | 85,8 millions | - |

| Sondage linéaire | 63,4 | 85,0 | 63.2 | 97,0 | 86,3 | 36,6 | 51,0 | 78,5 | 87,5 | 68,6 | 74,0 | 34.3 | 30,6 | 33.2 | 55.4 | 12,5 | 20,0 | 9.6 | 19.2 | 52,94 | 0M | 0,53 |

| Adaptateur | 69,2 | 90,1 | 68,0 | 98,8 | 89,9 | 82,8 | 54.3 | 84,0 | 94,9 | 81,9 | 75,5 | 80,9 | 65,3 | 48,6 | 78.3 | 74,8 | 48,5 | 29,9 | 41,6 | 71.44 | 0,16 M | 0,71 |

| VPT-peu profond | 77,7 | 86,9 | 62,6 | 97,5 | 87,3 | 74,5 | 51.2 | 78.2 | 92,0 | 75,6 | 72,9 | 50,5 | 58,6 | 40,5 | 67.1 | 68,7 | 36.1 | 20.2 | 34.1 | 64,85 | 0,08M | 0,65 |

| VPT-Profond | 78,8 | 90,8 | 65,8 | 98,0 | 88,3 | 78.1 | 49,6 | 81,8 | 96.1 | 83,4 | 68,4 | 68,5 | 60,0 | 46,5 | 72,8 | 73,6 | 47,9 | 32,9 | 37,8 | 69.43 | 0,56 M | 0,68 |

| BitFit | 72,8 | 87,0 | 59.2 | 97,5 | 85,3 | 59,9 | 51.4 | 78,7 | 91,6 | 72,9 | 69,8 | 61,5 | 55,6 | 32.4 | 55,9 | 66,6 | 40,0 | 15.7 | 25.1 | 62.05 | 0,10M | 0,61 |

| LoRA | 67.1 | 91,4 | 69,4 | 98,8 | 90,4 | 85,3 | 54,0 | 84,9 | 95,3 | 84,4 | 73,6 | 82,9 | 69,2 | 49,8 | 78,5 | 75,7 | 47.1 | 31,0 | 44,0 | 72.25 | 0,29 M | 0,71 |

| AdaptAncien | 70,8 | 91.2 | 70,5 | 99,1 | 90,9 | 86,6 | 54,8 | 83,0 | 95,8 | 84,4 | 76.3 | 81,9 | 64,3 | 49.3 | 80,3 | 76.3 | 45,7 | 31,7 | 41.1 | 72.32 | 0,16M | 0,72 |

| FSS | 69,0 | 92,6 | 75.1 | 99,4 | 91,8 | 90,2 | 52,9 | 87,4 | 95,9 | 87,4 | 75,5 | 75,9 | 62,3 | 53.3 | 80,6 | 77.3 | 54,9 | 29,5 | 37,9 | 73.10 | 0,21 M | 0,72 |

| NOÉ | 69,6 | 92,7 | 70.2 | 99,1 | 90,4 | 86.1 | 53,7 | 84,4 | 95,4 | 83,9 | 75,8 | 82,8 | 68,9 | 49,9 | 81,7 | 81,8 | 48.3 | 32,8 | 44.2 | 73.25 | 0,43M | 0,72 |

| SCT | 75.3 | 91,6 | 72.2 | 99,2 | 91.1 | 91.2 | 55,0 | 85,0 | 96.1 | 86,3 | 76.2 | 81,5 | 65.1 | 51,7 | 80,2 | 75,4 | 46.2 | 33.2 | 45,7 | 73.59 | 0,11M | 0,73 |

| Fait | 70,6 | 90,6 | 70,8 | 99,1 | 90,7 | 88,6 | 54.1 | 84,8 | 96,2 | 84,5 | 75,7 | 82,6 | 68,2 | 49,8 | 80,7 | 80,8 | 47.4 | 33.2 | 43,0 | 73.23 | 0,07M | 0,73 |

| Adaptateur Rep | 72,4 | 91,6 | 71,0 | 99,2 | 91,4 | 90,7 | 55.1 | 85,3 | 95,9 | 84,6 | 75,9 | 82,3 | 68,0 | 50,4 | 79,9 | 80,4 | 49.2 | 38,6 | 41,0 | 73,84 | 0,22 M | 0,72 |

| Hydre | 72,7 | 91,3 | 72,0 | 99,2 | 91,4 | 90,7 | 55,5 | 85,8 | 96,0 | 86.1 | 75,9 | 83.2 | 68,2 | 50,9 | 82,3 | 80,3 | 50,8 | 34,5 | 43.1 | 74.21 | 0,28 M | 0,73 |

| LST | 59,5 | 91,5 | 69,0 | 99,2 | 89,9 | 79,5 | 54,6 | 86,9 | 95,9 | 85,3 | 74.1 | 81,8 | 61,8 | 52.2 | 81,0 | 71,7 | 49,5 | 33,7 | 45.2 | 71.70 | 2,38 millions | 0,65 |

| DTL | 69,6 | 94,8 | 71.3 | 99,3 | 91,3 | 83,3 | 56.2 | 87.1 | 96,2 | 86.1 | 75,0 | 82,8 | 64.2 | 48,8 | 81,9 | 93,9 | 53,9 | 34.2 | 47.1 | 74.58 | 0,04M | 0,75 |

| TVH | 76,7 | 94.1 | 74,8 | 99,6 | 91.1 | 91.2 | 52.3 | 87.1 | 96,3 | 88,6 | 76,5 | 85,4 | 63,7 | 52,9 | 81,7 | 87,2 | 56,8 | 35,8 | 52.1 | 75,99 | 0,78M | 0,74 |

| GPS | 81.1 | 94,2 | 75,8 | 99,4 | 91,7 | 91,6 | 52,4 | 87,9 | 96,2 | 86,5 | 76,5 | 79,9 | 62,6 | 55,0 | 82,4 | 84,0 | 55.4 | 29,7 | 46.1 | 75.18 | 0,22 M | 0,74 |

| DERNIER | 66,7 | 93,4 | 76.1 | 99,6 | 89,8 | 86.1 | 54.3 | 86,2 | 96,3 | 86,8 | 75,4 | 81,9 | 65,9 | 49.4 | 82,6 | 87,9 | 46,7 | 32.3 | 51,5 | 74.15 | 0,66 M | 0,72 |

| FNS | 84,0 | 94,0 | 72,7 | 99,3 | 91,3 | 90,3 | 54,9 | 87,2 | 97,3 | 85,5 | 74,5 | 82,3 | 63,8 | 49,8 | 82,5 | 75,8 | 49.2 | 31.4 | 42.1 | 74.10 | 0,25M | 0,73 |

Résultats de référence sur SSv2 et HMDB51. Nous évaluons 5 algorithmes PETL avec ViT-B de VideoMAE et Video Swin Transformer.

Pour obtenir le point de contrôle, veuillez le télécharger sur le lien de téléchargement.

| Méthode | Modèle | Pré-formation | Paramètres. | SSv2 (Top1) | SSv2 (PPT) | HMDB51 (Top1) | HMDB51 (PPT) |

|---|---|---|---|---|---|---|---|

| Mise au point complète | ViT-B | Cinétique 400 | 85,97 millions | 53,97% | - | 46,41% | - |

| Congelé | ViT-B | Cinétique 400 | 0 M | 29,23% | 0,29 | 49,84% | 0,50 |

| AdaptAncien | ViT-B | Cinétique 400 | 1,19 millions | 59,02% | 0,56 | 55,69% | 0,53 |

| BAPAT | ViT-B | Cinétique 400 | 2,06 millions | 57,78% | 0,53 | 57,18% | 0,53 |

| Mise au point complète | Vidéo Swin-B | Cinétique 400 | 87,64 millions | 50,99% | - | 68,07% | - |

| Congelé | Vidéo Swin-B | Cinétique 400 | 0 M | 24,13% | 0,24 | 71,28% | 0,71 |

| LoRA | Vidéo Swin-B | Cinétique 400 | 0,75 M | 38,34% | 0,37 | 62,12% | 0,60 |

| BitFit | Vidéo Swin-B | Cinétique 400 | 1,09 M | 45,94% | 0,44 | 68,26% | 0,65 |

| AdaptAncien | Vidéo Swin-B | Cinétique 400 | 1,56 M | 40,80% | 0,38 | 68,66% | 0,64 |

| Réglage du préfixe | Vidéo Swin-B | Cinétique 400 | 6,37 millions | 39,46% | 0,32 | 56,13% | 0,45 |

| BAPAT | Vidéo Swin-B | Cinétique 400 | 6,18 millions | 53,36% | 0,43 | 71,93% | 0,58 |

Résultats de référence sur COCO. Nous évaluons 9 algorithmes PETL avec des modèles Swin-B pré-entraînés sur ImageNet-22K.

Pour obtenir le point de contrôle, veuillez le télécharger sur Coming Soon.

| Swin-B | Paramètres. | Mémoire | COCO ( | COCO (PPT) | COCO ( | COCO (PPT) |

|---|---|---|---|---|---|---|

| Mise au point complète | 86,75 millions | 17061 Mo | 51,9% | - | 45,0% | - |

| Congelé | 0,00 M | 7137 Mo | 43,5% | 0,44 | 38,6% | 0,39 |

| BitFit | 0,20 M | 13657 Mo | 47,9% | 0,47 | 41,9% | 0,42 |

| RÉGLAGE LN | 0,06 M | 12831 Mo | 48,0% | 0,48 | 41,4% | 0,41 |

| Partiel-1 | 12,60 M | 7301 Mo | 49,2% | 0,35 | 42,8% | 0,30 |

| Adaptateur | 3,11 millions | 12557 Mo | 50,9% | 0,45 | 43,8% | 0,39 |

| LoRA | 3,03 millions | 11975 Mo | 51,2% | 0,46 | 44,3% | 0,40 |

| AdaptAncien | 3,11 millions | 13186 Mo | 51,4% | 0,46 | 44,5% | 0,40 |

| LoRand | 1,20 M | 13598 Mo | 51,0% | 0,49 | 43,9% | 0,42 |

| E$^3$VA | 1,20 M | 7639 Mo | 50,5% | 0,48 | 43,8% | 0,42 |

| Mona | 4,16 millions | 13996 Mo | 53,4% | 0,46 | 46,0% | 0,40 |

Résultats de référence sur PASCAL VOC et ADE20K. Nous évaluons 9 algorithmes PETL avec des modèles Swin-L pré-entraînés sur ImageNet-22K.

Pour obtenir le point de contrôle, veuillez le télécharger sur Coming Soon.

| Swin-L | Paramètres. | Mémoire (COV) | Pascal COV ( | Pascal COV (PPT) | ADE20K ( | ADE20K (PPT) |

|---|---|---|---|---|---|---|

| Mise au point complète | 198,58 millions | 15679 Mo | 83,5% | - | 52,10% | - |

| Congelé | 0,00 M | 3967 Mo | 83,6% | 0,84 | 46,84% | 0,47 |

| BitFit | 0,30 M | 10861 Mo | 85,7% | 0,85 | 48,37% | 0,48 |

| RÉGLAGE LN | 0,09 M | 10123 Mo | 85,8% | 0,86 | 47,98% | 0,48 |

| Partiel-1 | 28,34 M | 3943 Mo | 85,4% | 0,48 | 47,44% | 0,27 |

| Adaptateur | 4,66 millions | 10793 Mo | 87,1% | 0,74 | 50,78% | 0,43 |

| LoRA | 4,57 millions | 10127 Mo | 87,5% | 0,74 | 50,34% | 0,43 |

| AdaptAncien | 4,66 millions | 11036 Mo | 87,3% | 0,74 | 50,83% | 0,43 |

| LoRand | 1,31 M | 11572 Mo | 86,8% | 0,82 | 50,76% | 0,48 |

| E$^3$VA | 1,79 M | 4819 Mo | 86,5% | 0,81 | 49,64% | 0,46 |

| Mona | 5,08 millions | 11958 Mo | 87,3% | 0,73 | 51,36% | 0,43 |

La communauté V-PETL Bench est maintenue par :

Yi Xin ([email protected]), Université de Nanjing.

Siqi Luo ([email protected]), Université Jiao Tong de Shanghai.

Si vous trouvez notre enquête et notre référentiel utiles pour votre recherche, veuillez les citer ci-dessous :

@article{xin2024bench, title={Banc V-PETL : une référence d'apprentissage par transfert unifié et efficace avec des paramètres visuels}, author={Yi Xin, Siqi Luo, Xuyang Liu, Haodi Zhou, Xinyu Cheng, Christina Luoluo Lee, Junlong Du, Yuntao Du., Haozhe Wang, MingCai Chen, Ting Liu, Guimin Hu, Zhongwei Wan, Rongchao Zhang, Aoxue Li, Mingyang Yi, Xiaohong Liu}, année={2024}}