TL;DR : image portrait unique ?♂️ + audio ? = vidéo tête parlante ?.

La licence a été mise à jour vers Apache 2.0 et nous avons supprimé la restriction non commerciale

SadTalker est désormais officiellement intégré à Discord, où vous pouvez l'utiliser gratuitement en envoyant des fichiers. Vous pouvez également générer des vidéos de haute qualité à partir d'invites textuelles. Rejoindre:

Nous avons publié une extension stable-diffusion-webui. Découvrez plus de détails ici. Vidéo de démonstration

Le mode image complète est désormais disponible ! Plus de détails...

| toujours + rehausseur dans la v0.0.1 | toujours + rehausseur dans la v0.0.2 | image d'entrée @ bagbag1815 |

|---|---|---|

still_e_n.mp4 | full_body_2.bus_chinese_enhanced.mp4 |  |

Plusieurs nouveaux modes (modes Image fixe, référence et redimensionnement) sont désormais disponibles !

Nous sommes heureux de voir plus de démos communautaires sur bilibili, YouTube et X (#sadtalker).

Le journal des modifications précédent peut être trouvé ici.

[2023.06.12] : Ajout de nouvelles fonctionnalités dans l'extension WebUI, voir la discussion ici.

[2023.06.05] : Sortie d'un nouveau modèle de visage 512x512px (bêta). Correction de quelques bugs et amélioration des performances.

[2023.04.15] : Ajout d'un notebook WebUI Colab par @camenduru :

[2023.04.12] : Ajout d'un document d'installation WebUI plus détaillé et correction d'un problème lors de la réinstallation.

[2023.04.12] : Correction des problèmes de sécurité WebUI dus à des packages tiers et optimisation du chemin de sortie dans sd-webui-extension .

[2023.04.08] : Dans la v0.0.2, nous avons ajouté un logo en filigrane à la vidéo générée pour éviter les abus. Ce filigrane a depuis été supprimé dans une version ultérieure.

[2023.04.08] : Dans la v0.0.2, nous avons ajouté des fonctionnalités pour l'animation d'images complètes et un lien pour télécharger les points de contrôle depuis Baidu. Nous avons également optimisé la logique de l'enhancer.

Nous suivons les nouvelles mises à jour dans le numéro 280.

Si vous rencontrez des problèmes, veuillez lire notre FAQ avant d'ouvrir un problème.

Tutoriels de la communauté : 中文Windows教程 (tutoriel Windows en chinois) | 日本語コース (tutoriel japonais).

Installez Anaconda, Python et git .

Créer l'environnement et installer les exigences.

git clone https://github.com/OpenTalker/SadTalker.git

cd SadTalker

conda create -n sadtalker python=3.8

conda activate sadtalker

pip install torch==1.12.1+cu113 torchvision==0.13.1+cu113 torchaudio==0.12.1 --extra-index-url https://download.pytorch.org/whl/cu113

conda install ffmpeg

pip install -r requirements.txt

# ## Coqui TTS is optional for gradio demo.

# ## pip install TTS

Un tutoriel vidéo en chinois est disponible ici. Vous pouvez également suivre les instructions suivantes :

scoop install git .ffmpeg , en suivant ce tutoriel ou en utilisant scoop : scoop install ffmpeg .git clone https://github.com/Winfredy/SadTalker.git .start.bat à partir de l'Explorateur Windows comme d'habitude, non-administrateur, utilisateur et une démo WebUI basée sur Gradio sera lancée.Un tutoriel sur l'installation de SadTalker sur macOS peut être trouvé ici.

Veuillez consulter des didacticiels supplémentaires ici.

Vous pouvez exécuter le script suivant sous Linux/macOS pour télécharger automatiquement tous les modèles :

bash scripts/download_models.sh Nous fournissons également un patch hors ligne ( gfpgan/ ), donc aucun modèle ne sera téléchargé lors de la génération.

sadt )sadt )Le modèle explique :

| Modèle | Description |

|---|---|

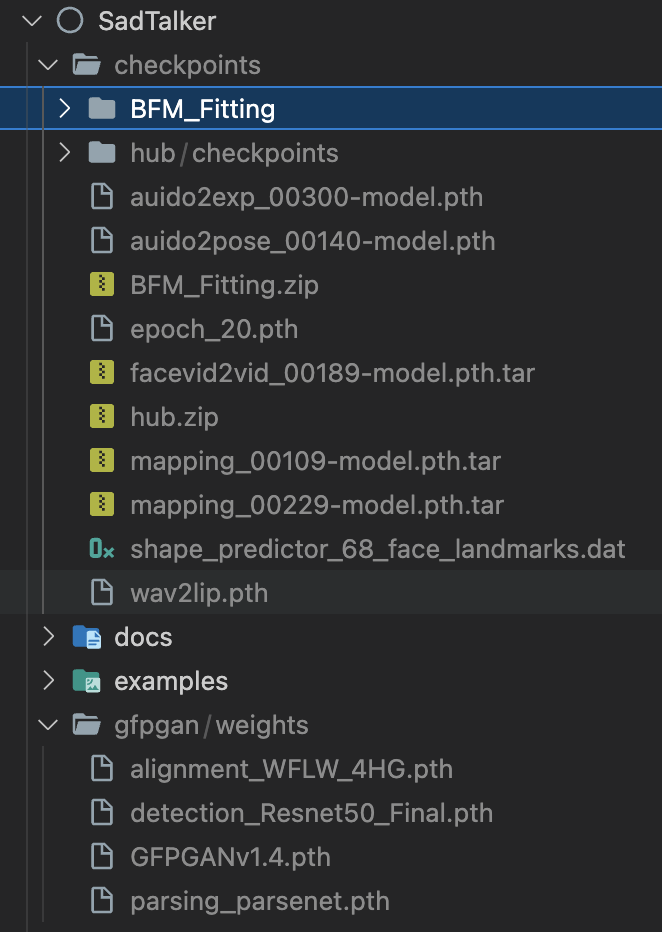

| points de contrôle/mapping_00229-model.pth.tar | MappingNet pré-entraîné dans Sadtalker. |

| points de contrôle/mapping_00109-model.pth.tar | MappingNet pré-entraîné dans Sadtalker. |

| points de contrôle/SadTalker_V0.0.2_256.safetensors | points de contrôle sadtalker packagés de l'ancienne version, rendu 256 visages). |

| points de contrôle/SadTalker_V0.0.2_512.safetensors | points de contrôle sadtalker packagés de l'ancienne version, rendu 512 visages). |

| gfpgan/poids | Détection de visage et modèles améliorés utilisés dans facexlib et gfpgan . |

| Modèle | Description |

|---|---|

| points de contrôle/auido2exp_00300-model.pth | ExpNet pré-entraîné dans Sadtalker. |

| points de contrôle/auido2pose_00140-model.pth | PoseVAE pré-entraîné dans Sadtalker. |

| points de contrôle/mapping_00229-model.pth.tar | MappingNet pré-entraîné dans Sadtalker. |

| points de contrôle/mapping_00109-model.pth.tar | MappingNet pré-entraîné dans Sadtalker. |

| points de contrôle/facevid2vid_00189-model.pth.tar | Modèle face-vid2vid pré-entraîné issu de la réapparition de face-vid2vid. |

| points de contrôle/epoch_20.pth | Extracteur 3DMM pré-entraîné dans Deep3DFaceReconstruction. |

| points de contrôle/wav2lip.pth | Modèle de synchronisation labiale très précis dans Wav2lip. |

| points de contrôle/shape_predictor_68_face_landmarks.dat | Modèle de repère de visage utilisé dans Dilb. |

| points de contrôle/BFM | Fichier de bibliothèque 3DMM. |

| points de contrôle/hub | Modèles de détection de visage utilisés dans l'alignement du visage. |

| gfpgan/poids | Détection de visage et modèles améliorés utilisés dans facexlib et gfpgan . |

Le dossier final sera affiché comme suit :

Veuillez lire notre document sur les bonnes pratiques et les conseils de configuration

Démo en ligne : HuggingFace | SDWebUI-Colab | Colab

Extension WebUI locale : veuillez vous référer à la documentation WebUI.

Démo gradio locale (recommandée) : Une instance Gradio similaire à notre démo Hugging Face peut être exécutée localement :

# # you need manually install TTS(https://github.com/coqui-ai/TTS) via `pip install tts` in advanced.

python app_sadtalker.pyVous pouvez également le démarrer plus facilement :

webui.bat , les exigences seront installées automatiquement.bash webui.sh pour démarrer le webui.python inference.py --driven_audio < audio.wav >

--source_image < video.mp4 or picture.png >

--enhancer gfpgan Les résultats seront enregistrés dans results/$SOME_TIMESTAMP/*.mp4 .

Utiliser --still pour générer une vidéo naturelle du corps entier. Vous pouvez ajouter enhancer pour améliorer la qualité de la vidéo générée.

python inference.py --driven_audio < audio.wav >

--source_image < video.mp4 or picture.png >

--result_dir < a file to store results >

--still

--preprocess full

--enhancer gfpgan D'autres exemples, configurations et conseils peuvent être trouvés dans les >>> documents de bonnes pratiques <<<.

Si vous trouvez notre travail utile dans votre recherche, pensez à citer :

@article { zhang2022sadtalker ,

title = { SadTalker: Learning Realistic 3D Motion Coefficients for Stylized Audio-Driven Single Image Talking Face Animation } ,

author = { Zhang, Wenxuan and Cun, Xiaodong and Wang, Xuan and Zhang, Yong and Shen, Xi and Guo, Yu and Shan, Ying and Wang, Fei } ,

journal = { arXiv preprint arXiv:2211.12194 } ,

year = { 2022 }

}Le code de Facerender emprunte beaucoup à la reproduction de zhanglonghao de face-vid2vid et PIRender. Nous remercions les auteurs d'avoir partagé leur merveilleux code. Dans le processus de formation, nous avons également utilisé le modèle de Deep3DFaceReconstruction et Wav2lip. Nous remercions pour leur merveilleux travail.

Nous utilisons également les bibliothèques tierces suivantes :

Ce n'est pas un produit officiel de Tencent.

1. Please carefully read and comply with the open-source license applicable to this code before using it.

2. Please carefully read and comply with the intellectual property declaration applicable to this code before using it.

3. This open-source code runs completely offline and does not collect any personal information or other data. If you use this code to provide services to end-users and collect related data, please take necessary compliance measures according to applicable laws and regulations (such as publishing privacy policies, adopting necessary data security strategies, etc.). If the collected data involves personal information, user consent must be obtained (if applicable). Any legal liabilities arising from this are unrelated to Tencent.

4. Without Tencent's written permission, you are not authorized to use the names or logos legally owned by Tencent, such as "Tencent." Otherwise, you may be liable for legal responsibilities.

5. This open-source code does not have the ability to directly provide services to end-users. If you need to use this code for further model training or demos, as part of your product to provide services to end-users, or for similar use, please comply with applicable laws and regulations for your product or service. Any legal liabilities arising from this are unrelated to Tencent.

6. It is prohibited to use this open-source code for activities that harm the legitimate rights and interests of others (including but not limited to fraud, deception, infringement of others' portrait rights, reputation rights, etc.), or other behaviors that violate applicable laws and regulations or go against social ethics and good customs (including providing incorrect or false information, spreading pornographic, terrorist, and violent information, etc.). Otherwise, you may be liable for legal responsibilities.

LOGO : suggestion de couleur et de police : ChatGPT, police du logo : Montserrat Alternates.

Tous les droits d'auteur des images et de l'audio de démonstration proviennent d'utilisateurs de la communauté ou de la génération d'une diffusion stable. N'hésitez pas à nous contacter si vous souhaitez les supprimer.