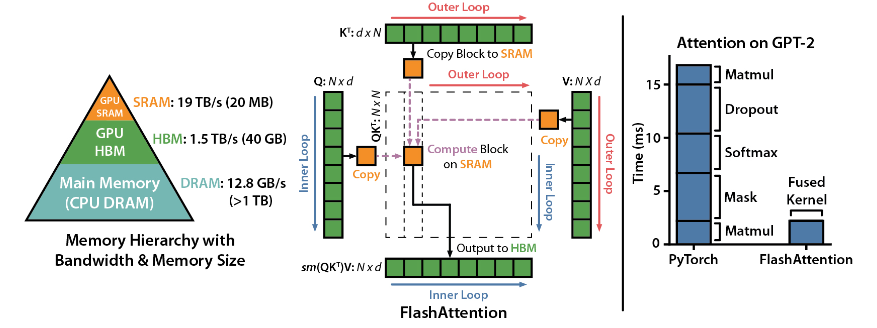

Teknologi akselerasi Transformer baru, FlashAttention-3, biaya rilisnya anjlok

Editor downcode menghadirkan berita besar! FlashAttention-3, teknologi akselerasi Transformer ini, telah sepenuhnya merevolusi metode inferensi model bahasa besar (LLM) dengan peningkatan kecepatan dan pengurangan biaya yang luar biasa! Ini meningkatkan p

2024-12-08