Bergabunglah dengan grup pengguna WeChat atau NPU kami.

[ Bahasa Inggris | 中文 ]

Menyempurnakan model bahasa besar bisa semudah...

Pilih jalur Anda:

Colab : https://colab.research.google.com/drive/1eRTPn37ltBbYsISy9Aw2NuI2Aq5CQrD9?usp=sharing

PAI-DSW : Contoh Llama3 | Contoh Qwen2-VL

Mesin lokal : Silakan lihat penggunaan

Dokumentasi (WIP) : https://llamafactory.readthedocs.io/zh-cn/latest/

Aktivitas terkini:

2024/10/18-2024/11/30 : Buat bot pemandu wisata pribadi menggunakan PAI+LLaMA Factory. [situs web]

Catatan

Kecuali tautan di atas, semua situs web lain adalah situs web pihak ketiga yang tidak sah. Harap hati-hati menggunakannya.

Fitur

Tolok ukur

log perubahan

Model yang Didukung

Pendekatan Pelatihan yang Didukung

Kumpulan Data yang Disediakan

Persyaratan

Memulai

Proyek menggunakan Pabrik LLaMA

Lisensi

Kutipan

Pengakuan

Berbagai model : LLaMA, LLaVA, Mistral, Mixtral-MoE, Qwen, Qwen2-VL, Yi, Gemma, Baichuan, ChatGLM, Phi, dll.

Metode terpadu : Pra-pelatihan (berkelanjutan), penyesuaian yang diawasi (multimodal), pemodelan penghargaan, PPO, DPO, KTO, ORPO, dll.

Sumber daya yang dapat diskalakan : penyetelan penuh 16-bit, penyetelan beku, LoRA, dan QLoRA 2/3/4/5/6/8-bit melalui AQLM/AWQ/GPTQ/LLM.int8/HQQ/EETQ.

Algoritme tingkat lanjut : GaLore, BAdam, Adam-mini, DoRA, LongLoRA, LLaMA Pro, Mixture-of-Depths, LoRA+, LoftQ, PiSSA, dan penyetelan Agen.

Trik praktis : FlashAttention-2, Unsloth, Liger Kernel, RoPE scaling, NEFTune dan rsLoRA.

Pemantau eksperimen : LlamaBoard, TensorBoard, Wandb, MLflow, dll.

Inferensi lebih cepat : API bergaya OpenAI, Gradio UI, dan CLI dengan pekerja vLLM.

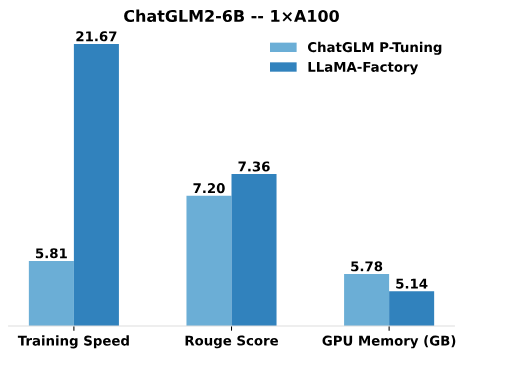

Dibandingkan dengan P-Tuning ChatGLM, penyetelan LoRA Pabrik LLaMA menawarkan kecepatan pelatihan hingga 3,7 kali lebih cepat dengan skor Rouge yang lebih baik pada tugas pembuatan teks iklan. Dengan memanfaatkan teknik kuantisasi 4-bit, QLoRA Pabrik LLaMA semakin meningkatkan efisiensi terkait memori GPU.

Kecepatan Pelatihan : jumlah sampel pelatihan yang diproses per detik selama pelatihan. (bs=4, cutoff_len=1024)

Skor Rouge : Skor Rouge-2 pada set pengembangan tugas pembuatan teks iklan. (bs=4, cutoff_len=1024)

Memori GPU : Penggunaan memori GPU puncak dalam pelatihan terkuantisasi 4-bit. (bs=1, cutoff_len=1024)

Kami mengadopsi pre_seq_len=128 untuk P-Tuning ChatGLM dan lora_rank=32 untuk tuning LoRA Pabrik LLaMA.

[24/10/09] Kami mendukung pengunduhan model dan kumpulan data terlatih dari Modelers Hub . Lihat tutorial ini untuk penggunaan.

[24/09/19] Kami mendukung penyempurnaan model Qwen2.5 .

[24/08/30] Kami mendukung penyempurnaan model Qwen2-VL . Terima kasih PR @simonJJJ.

[24/08/27] Kami mendukung Kernel Liger . Coba enable_liger_kernel: true untuk pelatihan yang efisien.

[24/08/09] Kami mendukung pengoptimal Adam-mini . Lihat contoh penggunaan. Terima kasih PR @ relic-yuexi.

[24/07/04] Kami mendukung pelatihan dikemas bebas kontaminasi. Gunakan neat_packing: true untuk mengaktifkannya. Terima kasih PR @ chuan298.

[24/06/16] Kami mendukung algoritma PiSSA . Lihat contoh penggunaan.

[24/06/07] Kami mendukung penyempurnaan model Qwen2 dan GLM-4 .

[24/05/26] Kami mendukung algoritma SimPO untuk pembelajaran preferensi. Lihat contoh penggunaan.

[24/05/20] Kami mendukung penyempurnaan model seri PaliGemma . Perhatikan bahwa model PaliGemma adalah model yang telah dilatih sebelumnya, Anda perlu menyempurnakannya dengan template paligemma untuk penyelesaian obrolan.

[24/05/18] Kami mendukung algoritma KTO untuk pembelajaran preferensi. Lihat contoh penggunaan.

[24/05/14] Kami mendukung pelatihan dan inferensi pada perangkat Ascend NPU. Periksa bagian instalasi untuk detailnya.

[24/04/26] Kami mendukung penyempurnaan LLM multimodal LLaVA-1.5 . Lihat contoh penggunaan.

[24/04/22] Kami menyediakan notebook Colab untuk menyempurnakan model Llama-3 pada GPU T4 gratis. Dua model turunan Llama-3 yang disempurnakan menggunakan LLaMA Factory tersedia di Hugging Face, periksa Llama3-8B-Chinese-Chat dan Llama3-Chinese untuk detailnya.

[24/04/21] Kami mendukung Mixture-of-Depths sesuai implementasi AstraMindAI. Lihat contoh penggunaan.

[24/04/16] Kami mendukung pengoptimal BAdam . Lihat contoh penggunaan.

[24/04/16] Kami mendukung pelatihan jangka panjang unsloth (Llama-2-7B-56k dalam 24GB). Ini mencapai kecepatan 117% dan memori 50% dibandingkan dengan FlashAttention-2, lebih banyak tolok ukur dapat ditemukan di halaman ini.

[24/03/31] Kami mendukung ORPO . Lihat contoh penggunaan.

[24/03/21] Makalah kami "LlamaFactory: Penyempurnaan Efisien Terpadu untuk 100+ Model Bahasa" tersedia di arXiv!

[24/03/20] Kami mendukung FSDP+QLoRA yang menyempurnakan model 70B pada GPU 2x24GB. Lihat contoh penggunaan.

[24/03/13] Kami mendukung LoRA+ . Lihat contoh penggunaan.

[24/03/07] Kami mendukung pengoptimal GaLore . Lihat contoh penggunaan.

[24/03/07] Kami mengintegrasikan vLLM untuk inferensi yang lebih cepat dan bersamaan. Coba infer_backend: vllm untuk menikmati kecepatan inferensi 270% .

[24/02/28] Kami mendukung LoRA ( DoRA ) yang terurai berat badan. Coba use_dora: true untuk mengaktifkan pelatihan DoRA.

[24/02/15] Kami mendukung perluasan blok yang diusulkan oleh LLaMA Pro. Lihat contoh penggunaan.

[24/02/05] Model seri Qwen1.5 (versi beta Qwen2) didukung di LLaMA-Factory. Periksa posting blog ini untuk detailnya.

[24/01/18] Kami mendukung penyetelan agen untuk sebagian besar model, melengkapi model dengan alat yang menggunakan kemampuan dengan menyempurnakan dataset: glaive_toolcall_en .

[23/12/23] Kami mendukung penerapan unsloth untuk meningkatkan penyetelan LoRA untuk model LLaMA, Mistral, dan Yi. Coba use_unsloth: true untuk mengaktifkan patch unsloth. Ini mencapai kecepatan 170% dalam benchmark kami, periksa halaman ini untuk detailnya.

[23/12/12] Kami mendukung penyempurnaan model MoE terbaru Mixtral 8x7B dalam kerangka kerja kami. Lihat persyaratan perangkat keras di sini.

[23/12/01] Kami mendukung pengunduhan model dan kumpulan data terlatih dari ModelScope Hub . Lihat tutorial ini untuk penggunaan.

[23/10/21] Kami mendukung trik NEFTune untuk penyesuaian. Coba argumen neftune_noise_alpha: 5 untuk mengaktifkan NEFTune.

[23/09/27] Kami mendukung shift_attn: true untuk mengaktifkan perhatian singkat.

[23/09/23] Kami mengintegrasikan benchmark MMLU, C-Eval dan CMMLU dalam repo ini. Lihat contoh penggunaan.

[23/09/10] Kami mendukung FlashAttention-2 . Coba argumen flash_attn: fa2 untuk mengaktifkan FlashAttention-2 jika Anda menggunakan GPU RTX4090, A100, atau H100.

[23/08/12] Kami mendukung penskalaan RoPE untuk memperluas konteks model LLaMA. Coba rope_scaling: linear dalam Pelatihan dan rope_scaling: dynamic pada Inferensi untuk mengekstrapolasi posisi embeddings.

[23/08/11] Kami mendukung pelatihan DPO untuk model yang disesuaikan dengan instruksi. Lihat contoh penggunaan.

[23/07/31] Kami mendukung streaming kumpulan data . Coba argumen streaming: true dan max_steps: 10000 untuk memuat kumpulan data Anda dalam mode streaming.

[23/07/29] Kami merilis dua model 13B yang disesuaikan dengan instruksi di Hugging Face. Lihat Repo Wajah Memeluk (LLaMA-2 / Baichuan) ini untuk detailnya.

[23/07/18] Kami mengembangkan UI Web lengkap untuk pelatihan, evaluasi, dan inferensi. Coba train_web.py untuk menyempurnakan model di browser Web Anda. Terima kasih @KanadeSiina dan @codemayq atas upaya mereka dalam pengembangan.

[23/07/09] Kami merilis FastEdit ⚡?, paket yang mudah digunakan untuk mengedit pengetahuan faktual model bahasa besar secara efisien. Silakan ikuti FastEdit jika Anda tertarik.

[23/06/29] Kami memberikan contoh pelatihan model obrolan yang dapat direproduksi menggunakan kumpulan data yang mengikuti instruksi, lihat Baichuan-7B-sft untuk detailnya.

[23/06/22] Kami menyelaraskan API demo dengan format OpenAI tempat Anda dapat menyisipkan model yang telah disesuaikan ke dalam aplikasi berbasis ChatGPT sembarang .

[23/06/03] Kami mendukung pelatihan dan inferensi terkuantisasi (alias QLoRA ). Lihat contoh penggunaan.

| Model | Ukuran model | Templat |

|---|---|---|

| Baichuan 2 | 7B/13B | baichuan2 |

| MEKAR/MEKAR | 560M/1.1B/1.7B/3B/7.1B/176B | - |

| ObrolanGLM3 | 6B | obrolanglm3 |

| Perintah R | 35B/104B | berpadu |

| DeepSeek (Kode/MoE) | 7B/16B/67B/236B | mencari lebih dalam |

| Elang | 7B/11B/40B/180B | elang |

| Permata/Permata 2/KodeGemma | 2B/7B/9B/27B | permata |

| GLM-4 | 9B | glm4 |

| MagangLM2/MagangLM2.5 | 7B/20B | magang2 |

| lama | 7B/13B/33B/65B | - |

| Lama 2 | 7B/13B/70B | llama2 |

| Lama 3-3.2 | 1B/3B/8B/70B | llama3 |

| LLaVA-1.5 | 7B/13B | llava |

| LLaVA-Berikutnya | 7B/8B/13B/34B/72B/110B | llava_berikutnya |

| LLaVA-NeXT-Video | 7B/34B | llava_next_video |

| BPS Mini | 1B/2B/4B | cpm/cpm3 |

| Mistral/Mixtral | 7B/8x7B/8x22B | mistral |

| OLMo | 1B/7B | - |

| PaliGemma | 3B | paligemma |

| Phi-1.5/Phi-2 | 1.3B/2.7B | - |

| Fi-3 | 4B/7B/14B | phi |

| piksel | 12B | piksel |

| Qwen (1-2.5) (Kode/Matematika/MoE) | 0,5B/1,5B/3B/7B/14B/32B/72B/110B | qwen |

| Qwen2-VL | 2B/7B/72B | qwen2_vl |

| Kode Bintang 2 | 3B/7B/15B | - |

| XVERSE | 7B/13B/65B | xverse |

| Yi/Yi-1.5 (Kode) | 1,5B/6B/9B/34B | ya |

| Yi-VL | 6B/34B | yi_vl |

| Yuan 2 | 2B/51B/102B | yuan |

Catatan

Untuk model "dasar", argumen template dapat dipilih dari default , alpaca , vicuna dll. Namun pastikan untuk menggunakan templat yang sesuai untuk model "instruct/chat".

Ingatlah untuk menggunakan template yang SAMA dalam pelatihan dan inferensi.

Silakan merujuk ke konstanta.py untuk daftar lengkap model yang kami dukung.

Anda juga dapat menambahkan templat obrolan khusus ke template.py.

| Mendekati | Penyetelan penuh | Penyetelan beku | LoRA | QLoRA |

|---|---|---|---|---|

| Pra-Pelatihan | ✅ | ✅ | ✅ | ✅ |

| Penyempurnaan yang Diawasi | ✅ | ✅ | ✅ | ✅ |

| Pemodelan Hadiah | ✅ | ✅ | ✅ | ✅ |

| Pelatihan PPO | ✅ | ✅ | ✅ | ✅ |

| Pelatihan DPO | ✅ | ✅ | ✅ | ✅ |

| Pelatihan KTO | ✅ | ✅ | ✅ | ✅ |

| Pelatihan ORPO | ✅ | ✅ | ✅ | ✅ |

| Pelatihan SimPO | ✅ | ✅ | ✅ | ✅ |

Tip

Detail implementasi PPO dapat ditemukan di blog ini.

Demo Wiki (en)

Web Sempurna (en)

RedPajama V2 (id)

Wikipedia (id)

Wikipedia (zh)

Tumpukan (en)

SkyPile (zh)

FineWeb (en)

FineWeb-Edu (en)

Tumpukan (en)

StarCoder (en)

Identitas (en&zh)

Stanford Alpaka (en)

Stanford Alpaka (zh)

Alpaka GPT4 (en&zh)

Panggilan Fungsi Glaive V2 (en&zh)

LIMA (en)

Kumpulan Data Guanaco (multibahasa)

BELLE 2M (zh)

BELLE 1M (zh)

BELLE 0,5M (zh)

Dialog BELLE 0,4M (zh)

Matematika Sekolah BELLE 0,25M (zh)

BELLE Obrolan Multiturn 0,8M (zh)

UltraChat (id)

OpenPlatipus (id)

CodeAlpaca 20k (en)

Alpaka CoT (multibahasa)

OpenOrca (id)

SlimOrca (id)

Instruksi Matematika (en)

Kunang-kunang 1,1M (zh)

Wiki QA (id)

QA Web (zh)

WebNovel (zh)

Nektar (en)

ctrl dalam (en&zh)

Pembuatan Iklan (zh)

ShareGPT Hiperfilter (en)

BagikanGPT4 (en&zh)

UltraChat 200k (id)

AgenInstruksi (en)

Obrolan LMSYS 1M (id)

Evol Instruksi V2 (en)

Kosmopedia (en)

BATANG (zh)

Ruozhiba (zh)

Neo-sft (zh)

WebInstructSub (en)

Magpie-Pro-300K-Difilter (id)

Magpie-ultra-v0.1 (id)

Campuran LLaVA (en&zh)

Keterangan-pokémon-gpt4o (en&zh)

Buka Asisten (de)

Dolly 15rb (de)

Alpaka GPT4 (de)

OpenSchnabeltier (de)

Instruksi Evol (de)

Lumba-lumba (de)

Jumlah Buku (de)

Airoboro (de)

Ultrachat (de)

Campuran DPO (en&zh)

UltraUmpan Balik (en)

RLHF-V (en)

VLFumpan Balik (en)

Pasangan DPO Orca (en)

HH-RLHF (en)

Nektar (en)

DPO Orca (de)

Campuran KTO (en)

Beberapa kumpulan data memerlukan konfirmasi sebelum menggunakannya, jadi kami menyarankan Anda masuk dengan akun Hugging Face Anda menggunakan perintah ini.

instalasi pip --upgrade pelukanface_hub login pelukan wajah-cli

| Wajib | Minimum | Menyarankan |

|---|---|---|

| ular piton | 3.8 | 3.11 |

| obor | 1.13.1 | 2.4.0 |

| transformator | 4.41.2 | 4.43.4 |

| kumpulan data | 2.16.0 | 2.20.0 |

| mempercepat | 0.30.1 | 0.32.0 |

| peft | 0.11.1 | 0.12.0 |

| trl | 0.8.6 | 0.9.6 |

| Opsional | Minimum | Menyarankan |

|---|---|---|

| CUDA | 11.6 | 12.2 |

| kecepatan dalam | 0.10.0 | 0.14.0 |

| bitsandbytes | 0.39.0 | 0.43.1 |

| vllm | 0.4.3 | 0.5.0 |

| flash-attn | 2.3.0 | 2.6.3 |

* perkiraan

| Metode | sedikit | 7B | 13B | 30B | 70B | 110B | 8x7B | 8x22B |

|---|---|---|---|---|---|---|---|---|

| Penuh | AMP | 120GB | 240GB | 600GB | 1200GB | 2000GB | 900GB | 2400GB |

| Penuh | 16 | 60GB | 120GB | 300GB | 600GB | 900GB | 400GB | 1200GB |

| Membekukan | 16 | 20GB | 40GB | 80GB | 200GB | 360GB | 160GB | 400GB |

| LoRA/GaLore/BAdam | 16 | 16GB | 32GB | 64GB | 160GB | 240GB | 120GB | 320GB |

| QLoRA | 8 | 10GB | 20GB | 40GB | 80GB | 140GB | 60GB | 160GB |

| QLoRA | 4 | 6GB | 12GB | 24GB | 48GB | 72GB | 30GB | 96GB |

| QLoRA | 2 | 4GB | 8GB | 16GB | 24GB | 48GB | 18GB | 48GB |

Penting

Instalasi adalah wajib.

git clone --kedalaman 1 https://github.com/hiyouga/LLaMA-Factory.gitcd LLaMA-Factory pip install -e ".[obor,metrik]"

Dependensi tambahan tersedia: torch, torch-npu, metrics, deepspeed, liger-kernel, bitsandbytes, hqq, eetq, gptq, awq, aqlm, vllm, galore, badam, adam-mini, qwen, modelscope, openmind, quality

Tip

Gunakan pip install --no-deps -e . untuk menyelesaikan konflik paket.

Jika Anda ingin mengaktifkan LoRA terkuantisasi (QLoRA) pada platform Windows, Anda perlu menginstal versi pustaka bitsandbytes yang telah dibuat sebelumnya, yang mendukung CUDA 11.1 hingga 12.2, silakan pilih versi rilis yang sesuai berdasarkan versi CUDA Anda.

pemasangan pip https://github.com/jllllll/bitsandbytes-windows-webui/releases/download/wheels/bitsandbytes-0.41.2.post2-py3-none-win_amd64.whl

Untuk mengaktifkan FlashAttention-2 pada platform Windows, Anda perlu menginstal pustaka flash-attn yang telah dikompilasi sebelumnya, yang mendukung CUDA 12.1 hingga 12.2. Silakan unduh versi yang sesuai dari flash-attention berdasarkan kebutuhan Anda.

Untuk menginstal LLaMA Factory pada perangkat Ascend NPU, harap tentukan dependensi tambahan: pip install -e ".[torch-npu,metrics]" . Selain itu, Anda perlu menginstal Ascend CANN Toolkit dan Kernel . Silakan ikuti tutorial instalasi atau gunakan perintah berikut:

# ganti url sesuai dengan versi dan perangkat CANN Anda# instal CANN Toolkitwget https://ascend-repo.obs.cn-east-2.myhuaweicloud.com/Milan-ASL/Milan-ASL%20V100R001C17SPC701/Ascend-cann-toolkit_8 .0.RC1.alpha001_linux-"$(uname -i)".jalankan bash Ascend-cann-toolkit_8.0.RC1.alpha001_linux-"$(uname -i)".run --install# install CANN Kernelswget https://ascend-repo.obs.cn-east-2.myhuaweicloud.com/Milan-ASL/Milan-ASL%20V100R001C17SPC701/Ascend-cann-kernels-910b_8.0.RC1.alpha001_linux.run bash Ascend-cann-kernels-910b_8.0.RC1.alpha001_linux.run --install# setel env variabelsumber /usr/local/Ascend/ascend-toolkit/set_env.sh

| Persyaratan | Minimum | Menyarankan |

|---|---|---|

| MENGENDARAI KAPAL | 8.0.RC1 | 8.0.RC1 |

| obor | 2.1.0 | 2.1.0 |

| obor-npu | 2.1.0 | 2.1.0.post3 |

| kecepatan dalam | 0.13.2 | 0.13.2 |

Ingatlah untuk menggunakan ASCEND_RT_VISIBLE_DEVICES alih-alih CUDA_VISIBLE_DEVICES untuk menentukan perangkat yang akan digunakan.

Jika Anda tidak dapat menyimpulkan model pada perangkat NPU, coba atur do_sample: false di konfigurasi.

Unduh image Docker bawaan: 32GB | 64GB

Silakan merujuk ke data/README.md untuk memeriksa detail tentang format file kumpulan data. Anda dapat menggunakan kumpulan data di hub HuggingFace/ModelScope/Pemodel atau memuat kumpulan data di disk lokal.

Catatan

Harap perbarui data/dataset_info.json untuk menggunakan kumpulan data khusus Anda.

Gunakan 3 perintah berikut untuk menjalankan penyempurnaan LoRA, inferensi , dan penggabungan model Llama3-8B-Instruct.

contoh kereta llamafactory-cli/train_lora/llama3_lora_sft.yaml contoh obrolan llamafactory-cli/inferensi/llama3_lora_sft.yaml contoh ekspor llamafactory-cli/merge_lora/llama3_lora_sft.yaml

Lihat contoh/README.md untuk penggunaan tingkat lanjut (termasuk pelatihan terdistribusi).

Tip

Gunakan llamafactory-cli help untuk menampilkan informasi bantuan.

llamafactory-cli webui

Untuk pengguna CUDA:

cd buruh pelabuhan/buruh pelabuhan-cuda/ buruh pelabuhan menyusun -d buruh pelabuhan menulis exec llamafactory bash

Untuk pengguna Ascend NPU:

cd buruh pelabuhan/buruh pelabuhan-npu/ buruh pelabuhan menyusun -d buruh pelabuhan menulis exec llamafactory bash

Untuk pengguna AMD ROCm:

cd buruh pelabuhan/buruh pelabuhan-rocm/ buruh pelabuhan menyusun -d buruh pelabuhan menulis exec llamafactory bash

Untuk pengguna CUDA:

docker build -f ./docker/docker-cuda/Dockerfile

--build-arg INSTALL_BNB=salah

--build-arg INSTALL_VLLM=salah

--build-arg INSTALL_DEEPSPEED=salah

--build-arg INSTALL_FLASHATTN=salah

--build-arg PIP_INDEX=https://pypi.org/simple

-t llamafactory: menjalankan .docker terbaru -dit --gpus=all

-v ./hf_cache:/root/.cache/huggingface

-v ./ms_cache:/root/.cache/modelscope

-v ./om_cache:/root/.cache/openmind

-v ./data:/aplikasi/data

-v ./output:/app/output

-hal 7860:7860

-p 8000:8000

--shm-ukuran 16G

--nama pabrik llama

llamafactory: terbaru

docker exec -itu pesta pabrik llamaUntuk pengguna Ascend NPU:

# Pilih gambar buruh pelabuhan pada lingkungan Andadocker build -f ./docker/docker-npu/Dockerfile

--build-arg INSTALL_DEEPSPEED=salah

--build-arg PIP_INDEX=https://pypi.org/simple

-t llamafactory:latest .# Ubah `perangkat` saat resourcedocker Anda dijalankan -dit

-v ./hf_cache:/root/.cache/huggingface

-v ./ms_cache:/root/.cache/modelscope

-v ./om_cache:/root/.cache/openmind

-v ./data:/aplikasi/data

-v ./output:/app/output

-v /usr/local/dcmi:/usr/local/dcmi

-v /usr/local/bin/npu-smi:/usr/local/bin/npu-smi

-v /usr/local/Ascend/driver:/usr/local/Ascend/driver

-v /etc/ascend_install.info:/etc/ascend_install.info

-hal 7860:7860

-p 8000:8000

--perangkat /dev/davinci0

--perangkat /dev/davinci_manager

--perangkat /dev/devmm_svm

--perangkat /dev/hisi_hdc

--shm-ukuran 16G

--nama pabrik llama

llamafactory: terbaru

docker exec -itu pesta pabrik llamaUntuk pengguna AMD ROCm:

docker build -f ./docker/docker-rocm/Dockerfile

--build-arg INSTALL_BNB=salah

--build-arg INSTALL_VLLM=salah

--build-arg INSTALL_DEEPSPEED=salah

--build-arg INSTALL_FLASHATTN=salah

--build-arg PIP_INDEX=https://pypi.org/simple

-t llamafactory: menjalankan .docker terbaru -dit

-v ./hf_cache:/root/.cache/huggingface

-v ./ms_cache:/root/.cache/modelscope

-v ./om_cache:/root/.cache/openmind

-v ./data:/aplikasi/data

-v ./output:/app/output

-v ./simpan:/aplikasi/simpan

-hal 7860:7860

-p 8000:8000

--perangkat /dev/kfd

--perangkat /dev/dri

--shm-ukuran 16G

--nama pabrik llama

llamafactory: terbaru

docker exec -itu pesta pabrik llama hf_cache : Memanfaatkan cache Hugging Face di mesin host. Dapat ditetapkan kembali jika cache sudah ada di direktori lain.

ms_cache : Mirip dengan cache Hugging Face tetapi untuk pengguna ModelScope.

om_cache : Mirip dengan cache Hugging Face tetapi untuk pengguna Pemodel.

data : Tempatkan kumpulan data pada direktori mesin host ini sehingga dapat dipilih di GUI LLaMA Board.

output : Atur direktori ekspor ke lokasi ini sehingga hasil penggabungan dapat diakses langsung di mesin host.

API_PORT=8000 contoh api llamafactory-cli/inferensi/llama3_vllm.yaml

Tip

Kunjungi halaman ini untuk dokumen API.

Contoh: Pemahaman Gambar | Pemanggilan fungsi

Jika Anda kesulitan mendownload model dan dataset dari Hugging Face, Anda dapat menggunakan ModelScope.

ekspor USE_MODELSCOPE_HUB=1 # `set USE_MODELSCOPE_HUB=1` untuk Windows

Latih model dengan menentukan ID model ModelScope Hub sebagai model_name_or_path . Anda dapat menemukan daftar lengkap ID model di ModelScope Hub, misalnya LLM-Research/Meta-Llama-3-8B-Instruct .

Anda juga dapat menggunakan Modelers Hub untuk mengunduh model dan kumpulan data.

ekspor USE_OPENMIND_HUB=1 # `set USE_OPENMIND_HUB=1` untuk Windows

Latih model dengan menentukan ID model dari Modelers Hub sebagai model_name_or_path . Anda dapat menemukan daftar lengkap ID model di Modelers Hub, misalnya TeleAI/TeleChat-7B-pt .

Untuk menggunakan Bobot & Bias dalam mencatat hasil eksperimen, Anda perlu menambahkan argumen berikut ke file yaml.

laporan_ke: nama_wandbrun: tes_jalan # opsional

Setel WANDB_API_KEY ke kunci Anda saat meluncurkan tugas pelatihan untuk masuk dengan akun W&B Anda.

Jika Anda memiliki proyek yang harus digabungkan, silakan hubungi melalui email atau buat permintaan tarik.

Wang dkk. ESRL: Pembelajaran Penguatan Berbasis Pengambilan Sampel yang Efisien untuk Pembuatan Urutan. 2023. [arxiv]

Yu dkk. Model Bahasa Terbuka, Tertutup, atau Kecil untuk Klasifikasi Teks? 2023. [arxiv]

Wang dkk. UbiPhysio: Mendukung Fungsi Sehari-hari, Kebugaran, dan Rehabilitasi dengan Pemahaman Tindakan dan Umpan Balik dalam Bahasa Alami. 2023. [arxiv]

Luseri dkk. Memanfaatkan Model Bahasa Besar untuk Mendeteksi Kampanye Pengaruh di Media Sosial. 2023. [arxiv]

Zhang dkk. Mengurangi Halusinasi Model Bahasa Besar melalui Halusinasi yang Diinduksi. 2023. [arxiv]

Wang dkk. Ketahui Kebutuhan Anda Lebih Baik: Menuju Pemahaman Terstruktur tentang Permintaan Pemasar dengan LLM yang Ditambah Penalaran Analogis. KDD 2024. [arxiv]

Wang dkk. CANDLE: Konseptualisasi Iteratif dan Distilasi Instansiasi dari Model Bahasa Besar untuk Penalaran Akal Sehat. ACL 2024. [arxiv]

Choi dkk. FACT-GPT: Augmentasi Pengecekan Fakta melalui Pencocokan Klaim dengan LLM. 2024. [arxiv]

Zhang dkk. AutoMathText: Pemilihan Data Otonom dengan Model Bahasa untuk Teks Matematika. 2024. [arxiv]

Lyu dkk. KnowTuning: Penyempurnaan Sadar Pengetahuan untuk Model Bahasa Besar. 2024. [arxiv]

Yang dkk. LaCo: Pemangkasan Model Bahasa Besar melalui Runtuhnya Lapisan. 2024. [arxiv]

Bhardwaj dkk. Model Bahasa adalah Homer Simpson! Penyelarasan Kembali Keamanan Model Bahasa yang Diselaraskan melalui Aritmatika Tugas. 2024. [arxiv]

Yang dkk. Meningkatkan Generasi Respons Empati dengan Menambah LLM dengan Model Empati Skala Kecil. 2024. [arxiv]

Yi dkk. Verifikasi Pertemuan Generasi: Mempercepat Inferensi Model Bahasa Besar dengan Dekode Koreksi Otomatis Paralel Cerdas. Temuan ACL 2024. [arxiv]

Cao dkk. Perhatian yang Dapat Dibagikan secara Kepala untuk Model Bahasa Besar. 2024. [arxiv]

Zhang dkk. Meningkatkan Kemampuan Multibahasa Model Bahasa Besar melalui Penyulingan Mandiri dari Bahasa yang Kaya Sumber Daya. 2024. [arxiv]

Kim dkk. Perluasan Kosakata yang Efisien dan Efektif Menuju Model Bahasa Besar Multibahasa. 2024. [arxiv]

Yu dkk. KIEval: Kerangka Evaluasi Interaktif Berbasis Pengetahuan untuk Model Bahasa Besar. ACL 2024. [arxiv]

Huang dkk. Sintesis Data Berbasis Titik Kunci dengan Peningkatan Penalaran Matematis. 2024. [arxiv]

Duan dkk. Meniadakan Negatif: Penyelarasan tanpa Sampel Positif Manusia melalui Optimasi Dispreferensi Distribusi. 2024. [arxiv]

Xie dan Schwertfeger. Memberdayakan Robotika dengan Model Bahasa Besar: Pemahaman Peta osmAG dengan LLM. 2024. [arxiv]

Wu dkk. Model Bahasa Besar adalah Pembelajar Multibahasa Paralel. 2024. [arxiv]

Zhang dkk. EDT: Meningkatkan Pembuatan Model Bahasa Besar dengan Pengambilan Sampel Suhu Dinamis berbasis Entropi. 2024. [arxiv]

Weller dkk. FollowIR: Mengevaluasi dan Mengajarkan Model Pengambilan Informasi untuk Mengikuti Instruksi. 2024. [arxiv]

Hongbin Na. CBT-LLM: Model Bahasa Besar Tiongkok untuk Jawaban Pertanyaan Kesehatan Mental Berbasis Terapi Perilaku Kognitif. COLING 2024. [arxiv]

Zan dkk. CodeS: Bahasa Alami ke Repositori Kode melalui Sketsa Multi-Lapisan. 2024. [arxiv]

Liu dkk. Kontras Diri yang Luas Memungkinkan Penyelarasan Model Bahasa Bebas Umpan Balik. 2024. [arxiv]

Luo dkk. BAdam: Metode Pelatihan Parameter Penuh yang Efisien Memori untuk Model Bahasa Besar. 2024. [arxiv]

Du dkk. LLM Kecil Tiongkok: Melatih Model Bahasa Besar Berpusat pada Tiongkok. 2024. [arxiv]

Ma dkk. Penyempurnaan Kuasi-Ortogonal yang Efisien Parameter melalui Rotasi yang Diberikan. ICML 2024. [arxiv]

Liu dkk. Generasi Kepribadian Dinamis dengan Model Bahasa Besar. 2024. [arxiv]

Shang dkk. Seberapa Jauh Kita Telah Mencapai Pemahaman Kode Biner yang Dilucuti Menggunakan Model Bahasa Besar. 2024. [arxiv]

Huang dkk. LLMTune: Mempercepat Penyetelan Tombol Basis Data dengan Model Bahasa Besar. 2024. [arxiv]

Deng dkk. Text-Tuple-Table: Menuju Integrasi Informasi dalam Pembuatan Text-to-Table melalui Ekstraksi Tuple Global. 2024. [arxiv]

Acikgoz dkk. Hippocrates: Kerangka Kerja Sumber Terbuka untuk Memajukan Model Bahasa Besar dalam Pelayanan Kesehatan. 2024. [arxiv]

Zhang dkk. Model Bahasa Kecil Membutuhkan Penguji yang Kuat untuk Mengoreksi Penalaran Diri. Temuan ACL 2024. [arxiv]

Zhou dkk. FREB-TQA: Tolok Ukur Evaluasi Kekokohan yang Sangat Baik untuk Menjawab Pertanyaan Tabel. NAACL 2024. [arxiv]

Xu dkk. Model Bahasa Besar untuk Keamanan Cyber: Tinjauan Literatur yang Sistematis. 2024. [arxiv]

Dammu dkk. "Mereka tidak berbudaya": Mengungkap Bahaya Terselubung dan Ancaman Sosial dalam Percakapan yang Dihasilkan LLM. 2024. [arxiv]

Yi dkk. Kerangka kerja penataan kembali keselamatan melalui fusi model berorientasi subruang untuk model bahasa besar. 2024. [arxiv]

Lou dkk. SPO: Penyelarasan Urutan Preferensi Multi-Dimensi Dengan Pemodelan Imbalan Implisit. 2024. [arxiv]

Zhang dkk. Mendapatkan Lebih Banyak dari Lebih Sedikit: Model Bahasa Besar adalah Pembelajar Multibahasa Spontan yang Baik. 2024. [arxiv]

Zhang dkk. TS-Align: Kerangka Kerja Kolaboratif Guru-Siswa untuk Penyempurnaan Iteratif yang Dapat Diskalakan pada Model Bahasa Besar. 2024. [arxiv]

Zihong Chen. Segmentasi Kalimat dan Tanda Baca Kalimat Berdasarkan XunziALLM. 2024. [kertas]

Gao dkk. Yang Terbaik dari Kedua Dunia: Menuju Model Bahasa Besar yang Jujur dan Bermanfaat. 2024. [arxiv]

Wang dan Lagu. MARS: Membandingkan Kemampuan Penalaran Metafisik Model Bahasa dengan Kumpulan Data Evaluasi Multitugas. 2024. [arxiv]

Hu dkk. Batas Komputasi Adaptasi Tingkat Rendah (LoRA) untuk Model Berbasis Transformator. 2024. [arxiv]

Ge dkk. Pengeditan Pengetahuan Sensitif Waktu melalui Penyempurnaan yang Efisien. ACL 2024. [arxiv]

Tan dkk. Tinjauan Sejawat sebagai Dialog Multi-Putaran dan Konteks Panjang dengan Interaksi Berbasis Peran. 2024. [arxiv]

Lagu dkk. Turbo Sparse: Mencapai Kinerja LLM SOTA dengan Parameter Aktif Minimal. 2024. [arxiv]

Gu dkk. RWKV-CLIP: Pembelajar Representasi Visi-Bahasa yang Kuat. 2024. [arxiv]

Chen dkk. Memajukan Model Bahasa Besar yang Ditambah Alat: Mengintegrasikan Wawasan dari Kesalahan di Pohon Inferensi. 2024. [arxiv]

Zhu dkk. Apakah Model Bahasa Besar Ahli Statistik yang Baik?. 2024. [arxiv]

Li dkk. Ketahui Yang Tidak Diketahui: Metode Sensitif Ketidakpastian untuk Penyetelan Instruksi LLM. 2024. [arxiv]

Ding dkk. IntentionQA: Tolok Ukur untuk Mengevaluasi Kemampuan Pemahaman Niat Membeli Model Bahasa di E-commerce. 2024. [arxiv]

Dia dkk. INSTRUKSI LINTAS KOMUNITAS: Pembuatan Instruksi Tanpa Pengawasan untuk Menyelaraskan Model Bahasa Besar ke Komunitas Online. 2024. [arxiv]

Lin dkk. FVEL: Lingkungan Verifikasi Formal Interaktif dengan Model Bahasa Besar melalui Pembuktian Teorema. 2024. [arxiv]

Treutlein dkk. Menghubungkan Titik-Titik: LLM dapat Menyimpulkan dan Mengungkapkan Struktur Laten dari Data Pelatihan yang Berbeda. 2024. [arxiv]

Feng dkk. SS-Bench: Tolok Ukur Pembuatan dan Evaluasi Cerita Sosial. 2024. [arxiv]

Feng dkk. Dekompilasi Konteks yang Dibangun Sendiri dengan Peningkatan Penyelarasan Berbutir Halus. 2024. [arxiv]

Liu dkk. Model Bahasa Besar untuk Pengukuran Tekanan Darah Tanpa Manset Dari Biosignal yang Dapat Dipakai. 2024. [arxiv]

Iyer dkk. Menjelajahi Terjemahan dengan Sumber Daya Sangat Rendah dengan LLM: Pengajuan Tugas Penerjemahan NLP 2024 dari Universitas Edinburgh ke Amerika. AmericasNLP 2024. [kertas]

Li dkk. Mengkalibrasi LLM dengan Optimasi Preferensi pada Pohon Pemikiran untuk Menghasilkan Dasar Pemikiran dalam Penilaian Pertanyaan Sains. 2024. [arxiv]

Yang dkk. Model Bahasa Besar Pengetahuan Keuangan. 2024. [arxiv]

Lin dkk. DogeRM: Melengkapi Model Hadiah dengan Pengetahuan Domain melalui Penggabungan Model. 2024. [arxiv]

Bako dkk. Mengevaluasi Kemampuan Profil Semantik LLM untuk Ucapan Bahasa Alami dalam Visualisasi Data. 2024. [arxiv]

Huang dkk. RoLoRA: Menyempurnakan LLM Berputar Bebas Outlier untuk Kuantisasi Aktivasi Bobot yang Efektif. 2024. [arxiv]

Jiang dkk. LLM-Kolaborasi Jurnalisme Sains Otomatis untuk Khalayak Umum. 2024. [arxiv]

Inouye dkk. Menerapkan Penyetelan Otomatis pada Hyperparameter LoRA. 2024. [kertas]

Qi dkk. Penelitian tentang sistem pembuatan informasi Sudut Pandang Pariwisata Tibet berdasarkan LLM. 2024. [arxiv]

Xu dkk. Koreksi Jalur: Penyelarasan Keamanan Menggunakan Preferensi Sintetis. 2024. [arxiv]

Matahari dkk. LAMBDA: Agen Data Berbasis Model Besar. 2024. [arxiv]

Zhu dkk. CollectiveSFT: Menskalakan Model Bahasa Besar untuk Tolok Ukur Medis Tiongkok dengan Instruksi Kolektif dalam Layanan Kesehatan. 2024. [arxiv]

Yu dkk. Mengoreksi Bias Negatif dalam Model Bahasa Besar melalui Penyelarasan Skor Perhatian Negatif. 2024. [arxiv]

Xie dkk. Kekuatan Kumpulan Data yang Dipersonalisasi: Memajukan Penulisan Komposisi Bahasa Mandarin untuk Sekolah Dasar melalui Penyempurnaan Model yang Bertarget. IALP 2024. [makalah]

Liu dkk. Instruct-Code-Llama: Meningkatkan Kemampuan Model Bahasa dalam Pembuatan Kode Tingkat Kompetisi melalui Umpan Balik Juri Online. ICIC 2024. [makalah]

Wang dkk. Penjaga Sibernetik: Mengungkap Dampak Pemilihan Data Keselamatan pada Keamanan Model dalam Penyempurnaan yang Diawasi. ICIC 2024. [makalah]

Xia dkk. Memahami Kinerja dan Memperkirakan Biaya Penyempurnaan LLM. 2024. [arxiv]

Zeng dkk. Persepsi, Renungkan, dan Rencanakan: Merancang Agen LLM untuk Navigasi Kota yang Terarah pada Tujuan tanpa Instruksi. 2024. [arxiv]

Xia dkk. Menggunakan Model Bahasa Terlatih untuk Prediksi ESG yang Akurat. FinNLP 2024. [kertas]

Liang dkk. I-SHEEP: Penyelarasan Diri LLM dari Awal melalui Paradigma Peningkatan Diri Berulang. 2024. [arxiv]

StarWhisper : Model bahasa besar untuk Astronomi, berdasarkan ChatGLM2-6B dan Qwen-14B.

DISC-LawLLM : Model bahasa besar yang berspesialisasi dalam domain hukum Tiongkok, berdasarkan Baichuan-13B, mampu mengambil dan menalar pengetahuan hukum.

Sunsimiao : Model bahasa besar yang berspesialisasi dalam domain medis Tiongkok, berdasarkan Baichuan-7B dan ChatGLM-6B.

CareGPT : Serangkaian model bahasa besar untuk domain medis Tiongkok, berdasarkan LLaMA2-7B dan Baichuan-13B.

MachineMindset : Serangkaian model bahasa besar Kepribadian MBTI, yang mampu memberikan 16 tipe kepribadian berbeda kepada LLM mana pun berdasarkan kumpulan data dan metode pelatihan yang berbeda.

Luminia-13B-v3 : Model bahasa besar yang khusus menghasilkan metadata untuk difusi yang stabil. [demo]

Chinese-LLaVA-Med : Model bahasa besar multimodal yang berspesialisasi dalam domain medis Tiongkok, berdasarkan LLaVA-1.5-7B.

AutoRE : Sistem ekstraksi relasi tingkat dokumen berdasarkan model bahasa besar.

NVIDIA RTX AI Toolkit : SDK untuk menyempurnakan LLM pada PC Windows untuk NVIDIA RTX.

LazyLLM : Cara mudah dan malas untuk membangun aplikasi LLM multi-agen dan mendukung penyempurnaan model melalui Pabrik LLaMA.

RAG-Retrieval : Saluran lengkap untuk penyempurnaan, inferensi, dan distilasi model pengambilan RAG. [blog]

Repositori ini dilisensikan di bawah Lisensi Apache-2.0.

Silakan ikuti lisensi model untuk menggunakan bobot model yang sesuai: Baichuan 2 / BLOOM / ChatGLM3 / Command R / DeepSeek / Falcon / Gemma / GLM-4 / InternLM2 / Llama / Llama 2 (LLaVA-1.5) / Llama 3 / MiniCPM / Mistral /Mixtral/Pixtral / OLMo / Phi-1.5/Phi-2 / Phi-3 / Qwen / StarCoder 2 / XVERSE / Yi / Yi-1.5 / Yuan 2

Jika karya ini bermanfaat, silakan kutip sebagai:

@inproceedings{zheng2024llamafactory, title={LlamaFactory: Penyempurnaan Efisien Terpadu untuk 100+ Model Bahasa}, author={Yaowei Zheng dan Richong Zhang dan Junhao Zhang dan Yanhan Ye dan Zheyan Luo dan Zhangchi Feng dan Yongqiang Ma}, booktitle={ Prosiding Pertemuan Tahunan ke-62 Asosiasi Linguistik Komputasi (Volume 3: Sistem Demonstrasi)}, alamat={Bangkok, Thailand}, penerbit={Asosiasi Linguistik Komputasi}, tahun={2024}, url={http://arxiv.org/abs/2403.13372}}Repo ini mendapat manfaat dari PEFT, TRL, QLoRA dan FastChat. Terima kasih atas karya luar biasa mereka.