Kai Li 1 , Wendi Sang 1 , Chang Zeng 2 , Runxuan Yang 1 , Guo Chen 1 , Xiaolin Hu 1

1 Universitas Tsinghua, Cina

2 Institut Informatika Nasional, Jepang

Kertas | Demo

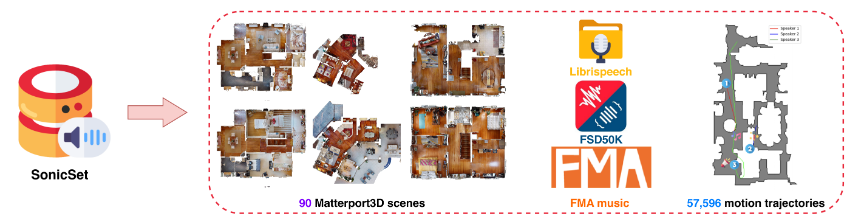

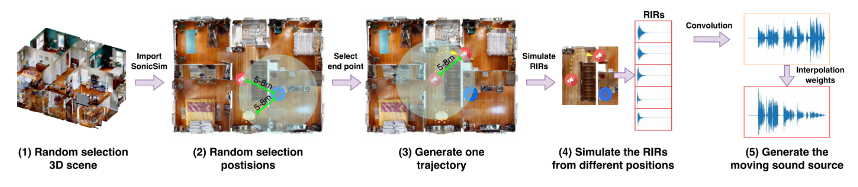

Kami memperkenalkan SonicSim, perangkat sintetis yang dirancang untuk menghasilkan data yang sangat dapat disesuaikan untuk memindahkan sumber suara. SonicSim dikembangkan berdasarkan platform simulasi AI yang diwujudkan, Habitat-sim, mendukung penyesuaian parameter multi-level, termasuk level adegan, level mikrofon, dan level sumber, sehingga menghasilkan data sintetis yang lebih beragam. Memanfaatkan SonicSim, kami membuat kumpulan data benchmark sumber suara bergerak, SonicSet, menggunakan kumpulan data LibriSpeech, Kumpulan Data Freesound 50k (FSD50K) dan Arsip Musik Gratis (FMA), dan 90 adegan dari Matterport3D untuk mengevaluasi model pemisahan dan peningkatan ucapan.

[30-10-2024] Kami memperbaiki bug untuk pemasangan lingkungan dan memperbarui kode pelatihan untuk model pemisahan dan peningkatan ucapan pada kumpulan data SonicSet.

[23-10-2024] Kami merilis training code untuk model pemisahan dan peningkatan ucapan pada kumpulan data SonicSet.

[2024-10-03] Kami merilis makalah tentang arxiv

[01-10-2024] Kami merilis kumpulan data pemisahan ucapan di dunia nyata, yang bertujuan untuk mengevaluasi performa model pemisahan ucapan dalam skenario dunia nyata.

[31-07-2024] Kami merilis SonicSim dataset , yang mencakup tugas pemisahan dan peningkatan ucapan.

[24-07-2024] Kami merilis skrip untuk dataset construction dan model terlatih untuk speech separation and enhancement .

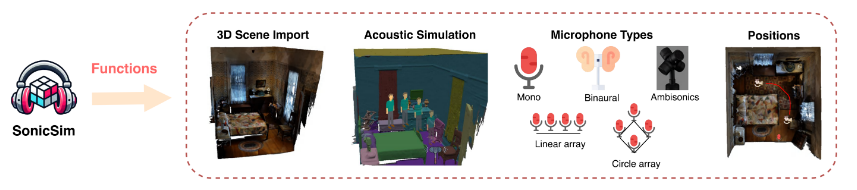

Impor Pemandangan 3D: Mendukung impor berbagai aset 3D dari kumpulan data seperti Matterport3D, memungkinkan pembuatan lingkungan akustik kompleks yang efisien dan terukur.

Simulasi Lingkungan Akustik:

Mensimulasikan pantulan suara dalam geometri ruangan menggunakan pemodelan akustik dalam ruangan dan algoritma penelusuran jalur dua arah.

Memetakan label semantik pemandangan 3D ke properti material, mengatur koefisien penyerapan, hamburan, dan transmisi permukaan.

Mensintesis data sumber suara bergerak berdasarkan jalur sumber, memastikan fidelitas tinggi terhadap kondisi dunia nyata.

Konfigurasi Mikrofon: Menawarkan beragam pengaturan mikrofon, termasuk mono, binaural, dan Ambisonics, serta dukungan untuk susunan mikrofon linier dan melingkar khusus.

Pemosisian Sumber dan Mikrofon: Menyediakan penyesuaian atau pengacakan posisi sumber suara dan mikrofon. Mendukung lintasan gerak untuk simulasi sumber suara bergerak, menambahkan realisme pada skenario akustik dinamis.

Anda dapat mengunduh kumpulan data yang telah dibuat sebelumnya dari tautan berikut:

| Nama Kumpulan Data | satu drive | Disk Baidu |

|---|---|---|

| folder kereta (40 file rar terpisah, 377G) | [Tautan Unduhan] | [Tautan Unduhan] |

| val.rar (4.9G) | [Tautan Unduhan] | [Tautan Unduhan] |

| tes.rar (2.2G) | [Tautan Unduhan] | [Tautan Unduhan] |

| data tolok ukur sep (8.57G) | [Tautan Unduhan] | [Tautan Unduhan] |

| tingkatkan data tolok ukur (7,70G) | [Tautan Unduhan] | [Tautan Unduhan] |

| Nama Kumpulan Data | satu drive | Disk Baidu |

|---|---|---|

| Kumpulan data dunia nyata (1.0G) | [Tautan Unduhan] | [Tautan Unduhan] |

Kumpulan data RealMAN: RealMAN

Untuk membuat kumpulan data sendiri, silakan merujuk ke README di folder SonicSim-SonicSet/data-script . Dokumen ini memberikan petunjuk rinci tentang cara menggunakan skrip yang disediakan untuk menghasilkan kumpulan data.

Untuk menyiapkan lingkungan pelatihan dan inferensi, gunakan file YAML yang disediakan:

conda buat -n SonicSim-Train python=3.10 conda mengaktifkan SonicSim-Train pip instal Cython==3.0.10 numpy==1.26.4 pip install torch==2.0.1 torchvision==0.15.2 torchaudio==2.0.2 --index-url https://download.pytorch.org/whl/cu118 pip install -r persyaratan.txt -i https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple

Navigasikan ke direktori separation dan jalankan skrip berikut untuk menghasilkan set validasi tetap:

pemisahan cd python generate_fixed_validation.py --raw_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val --save_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val-sep-2 --is_mono python generate_fixed_test.py --raw_dir=/home/pod/SonicSim/SonicSim/SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/test --is_mono

Navigasikan ke direktori enhancement dan jalankan skrip berikut untuk menghasilkan set validasi tetap:

peningkatan cd python generate_fixed_validation.py --raw_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val --save_dir=../SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/val-enh-noise --is_mono python generate_fixed_test.py --raw_dir=/home/pod/SonicSim/SonicSim/SonicSim-SonicSet/SonicSet/scene_datasets/mp3d/test --is_mono

Arahkan ke direktori separation dan jalankan skrip pelatihan dengan file konfigurasi yang ditentukan:

pemisahan cd python kereta.py --conf_dir=configs/afrcnn.yaml

Navigasikan ke direktori enhancement dan jalankan skrip pelatihan dengan file konfigurasi yang ditentukan:

peningkatan cd python kereta.py --conf_dir=config/dccrn.yaml

Silakan periksa konten README.md di folder sep-checkpoints dan enh-checkpoints, unduh model terlatih yang sesuai di Rilis dan unzip ke folder yang sesuai.

Navigasikan ke direktori separation dan jalankan skrip inferensi dengan file konfigurasi yang ditentukan:

pemisahan cd python inference.py --conf_dir=../sep-checkpoints/TFGNet-Noise/config.yaml

Navigasikan ke direktori enhancement dan jalankan skrip inferensi dengan file konfigurasi yang ditentukan:

peningkatan cd python inference.py --conf_dir=../enh-checkpoints/TaylorSENet-Noise/config.yaml

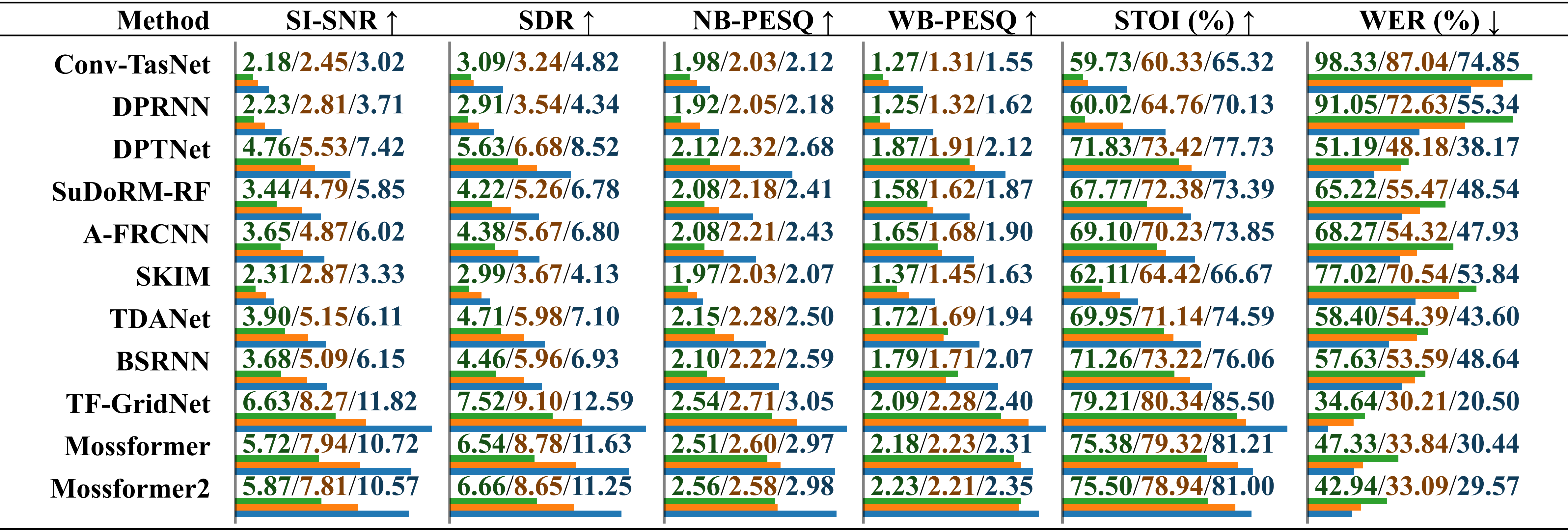

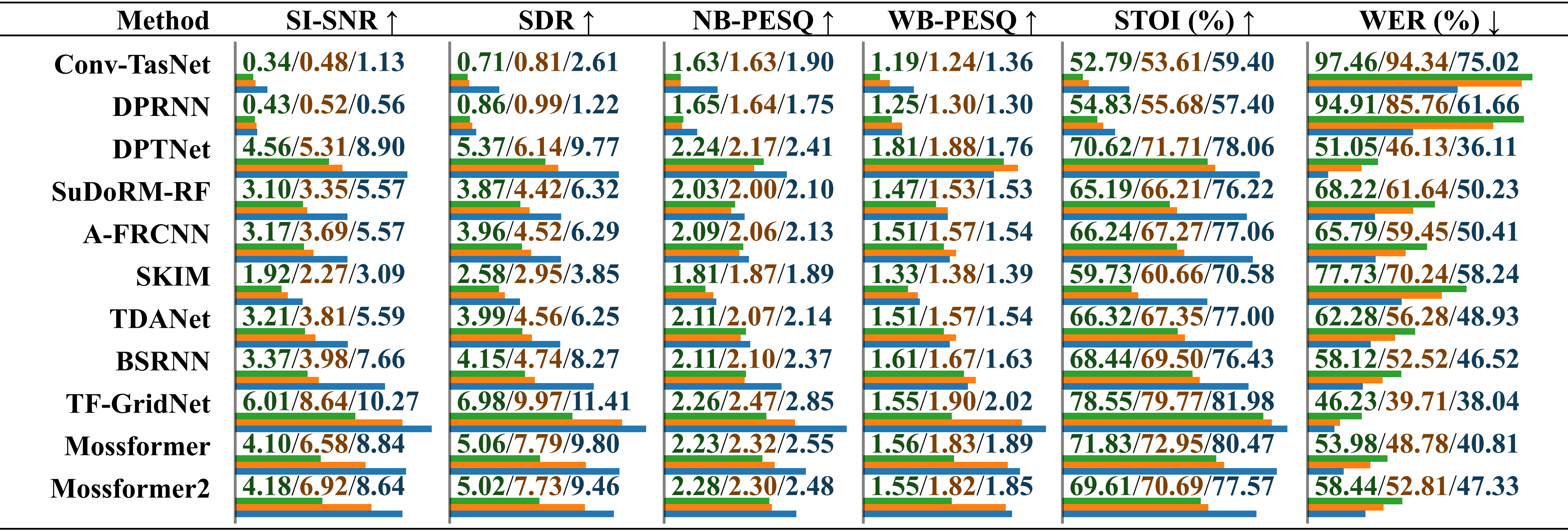

Evaluasi performa komparatif model yang dilatih pada kumpulan data berbeda menggunakan audio yang direkam secara nyata dengan kebisingan lingkungan . Hasilnya dilaporkan secara terpisah untuk "dilatih di LRS2-2Mix", "dilatih di Libri2Mix" dan "dilatih di SonicSet", dibedakan dengan garis miring. Panjang relatif ditunjukkan di bawah nilai dengan garis horizontal.

Evaluasi performa komparatif model yang dilatih pada kumpulan data berbeda menggunakan audio yang direkam secara nyata dengan gangguan musik . Hasilnya dilaporkan secara terpisah untuk "dilatih di LRS2-2Mix", "dilatih di Libri2Mix" dan "dilatih di SonicSet", dibedakan dengan garis miring.

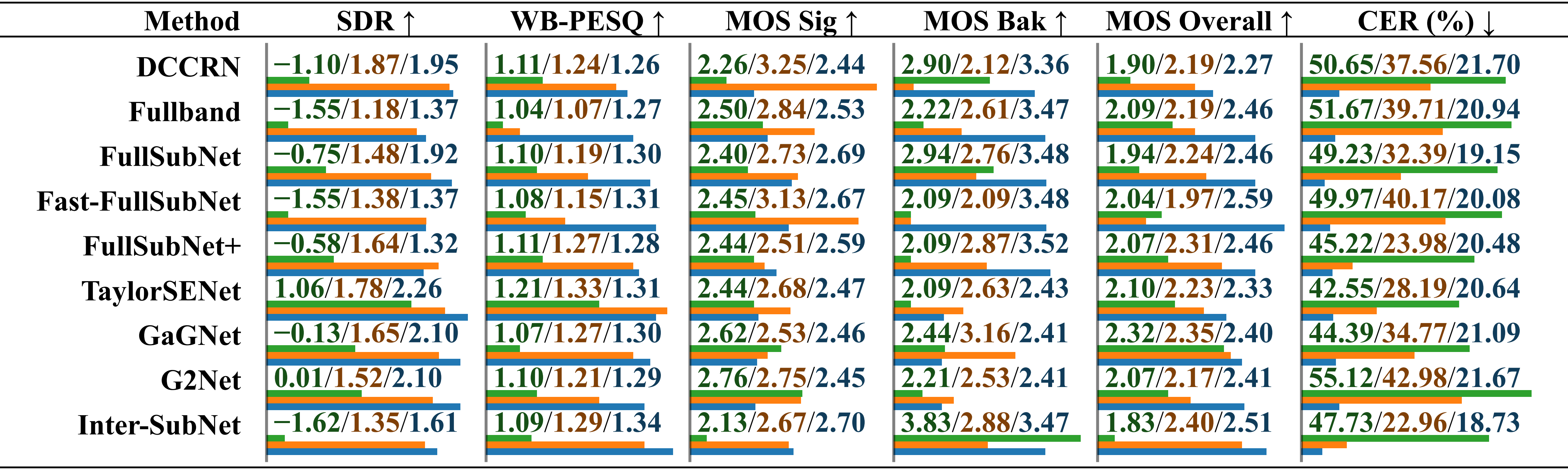

Evaluasi performa komparatif model yang dilatih pada kumpulan data berbeda menggunakan kumpulan data RealMAN. Hasilnya dilaporkan secara terpisah untuk “dilatih tentang VoiceBank+DEMAND”, “dilatih tentang DNS Challenge” dan “dilatih tentang SonicSet”, yang dibedakan dengan garis miring.

Kami telah melatih model pemisahan dan peningkatan pada kumpulan data SonicSet. Hasilnya adalah sebagai berikut:

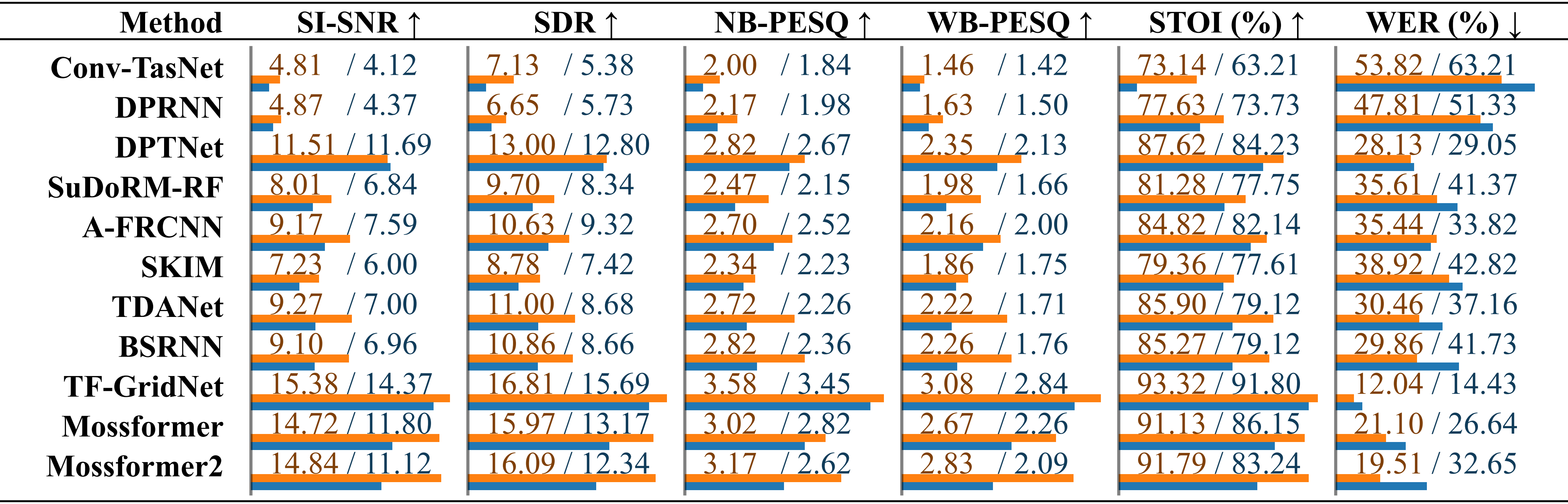

Perbandingan metode pemisahan ucapan yang ada pada dataset SonicSet. Performa masing-masing model dicantumkan secara terpisah untuk hasil di bawah “kebisingan lingkungan” dan “kebisingan musik”, yang dibedakan dengan garis miring.

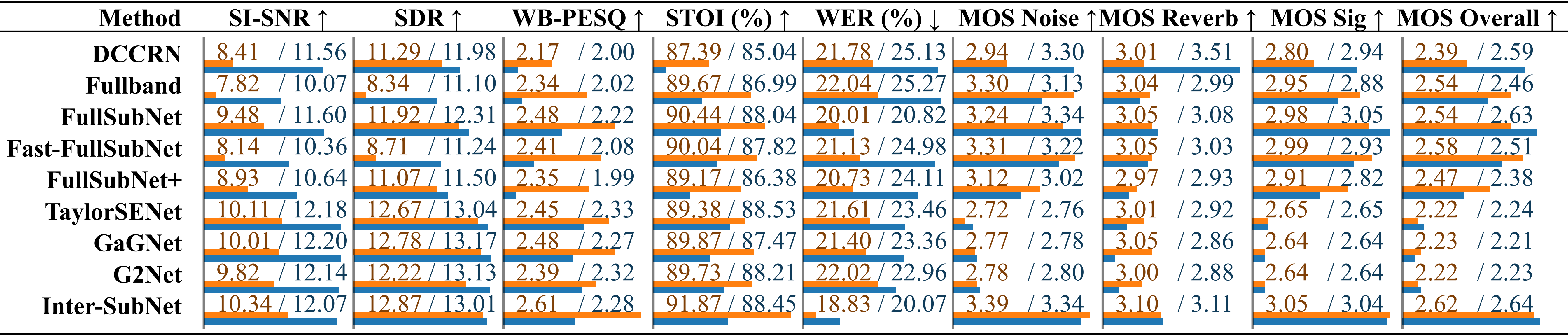

Perbandingan metode peningkatan bicara yang ada padaPerbandingan metode peningkatan bicara menggunakan set tes SonicSet. Metrik tersebut dicantumkan secara terpisah di bawah “kebisingan lingkungan” dan “kebisingan musik”, yang dibedakan dengan garis miring.

Kami ingin mengucapkan terima kasih kepada pihak-pihak berikut:

LibriSpeech untuk menyediakan data ucapan.

SoundSpaces untuk lingkungan simulasi.

Apple karena menyediakan skrip sintesis audio dinamis.

Karya ini dilisensikan di bawah Lisensi Internasional Creative Commons Attribution-ShareAlike 4.0.