· Makalah · Tolok Ukur · Beranda · Dokumen ·

✅ [25/07/2024] Benchmark PEFT Visual mulai merilis kumpulan data, kode, dll.

✅ [2024/06/20] Beranda Visual PEFT Benchmark telah dibuat.

✅ [2024/06/01] Repo Tolok Ukur PEFT Visual telah dibuat.

Perkenalan

Memulai

Struktur Kode

Mulai Cepat

Hasil dan Pos Pemeriksaan

Komunitas dan Kontak

Kutipan

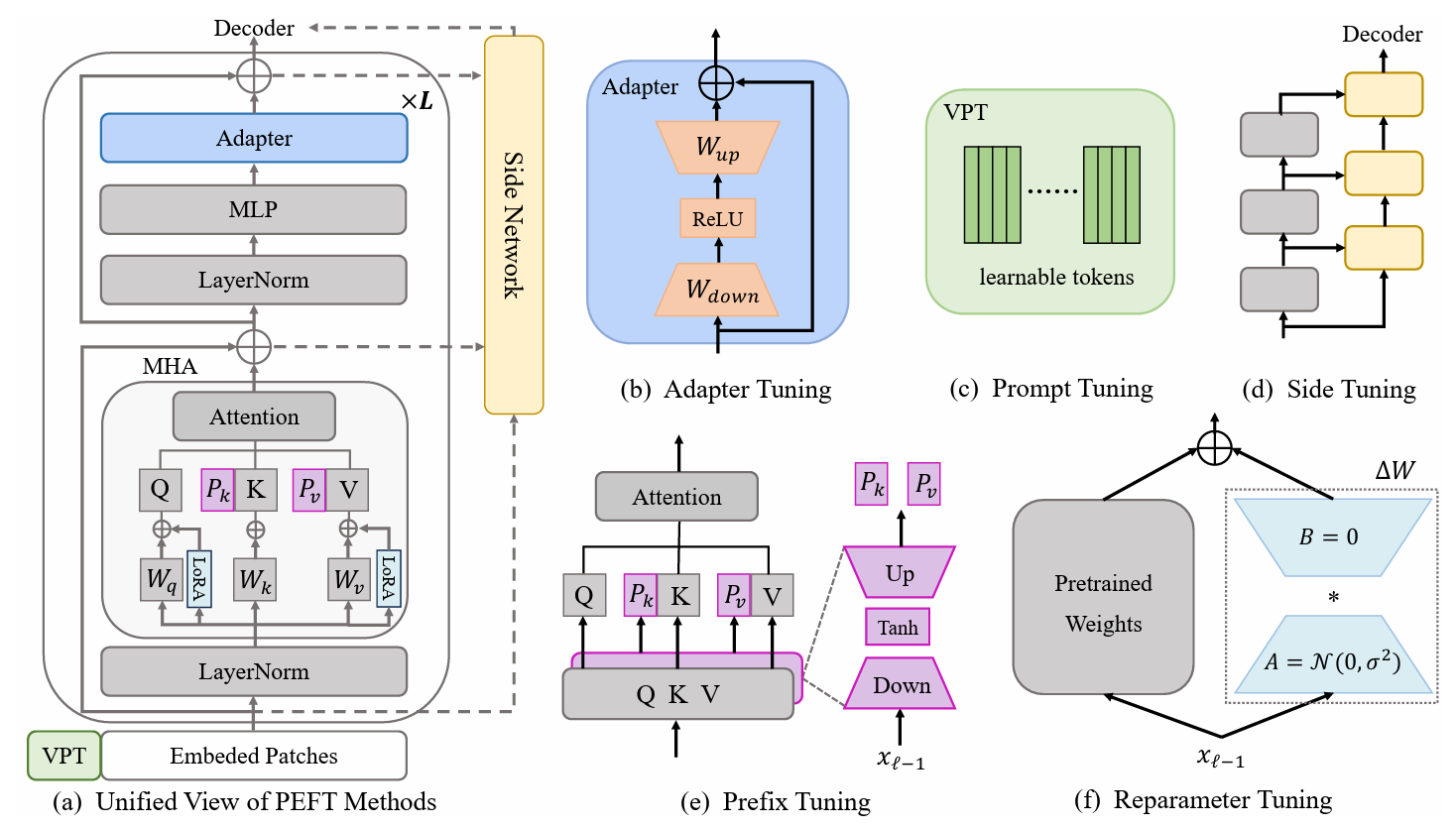

Metode pembelajaran transfer efisien parameter (PETL) menjanjikan dalam mengadaptasi model yang telah dilatih sebelumnya ke berbagai tugas hilir sambil hanya melatih beberapa parameter. Dalam domain computer vision (CV), banyak algoritma PETL telah diusulkan, namun penggunaan atau perbandingan langsungnya masih merepotkan. Untuk mengatasi tantangan ini, kami membuat Unified Visual PETL Benchmark (V-PETL Bench) untuk domain CV dengan memilih 30 kumpulan data yang beragam, menantang, dan komprehensif mulai dari pengenalan gambar, pengenalan tindakan video, dan tugas prediksi yang padat . Pada kumpulan data ini, kami secara sistematis mengevaluasi 25 algoritme PETL dominan dan membuat basis kode modular dan dapat diperluas menjadi sumber terbuka untuk evaluasi yang adil terhadap algoritme ini.

Tugas Klasifikasi Visual Berbutir Halus (FGVC)

FGVC terdiri dari 5 kumpulan data klasifikasi visual terperinci. Kumpulan data dapat diunduh mengikuti tautan resmi. Kami membagi data pelatihan jika set validasi publik tidak tersedia. Kumpulan data yang dipisahkan dapat ditemukan di sini: Tautan Unduhan.

CUB200 2011

Burung NA

Bunga Oxford

Anjing Stanford

Mobil Stanford

Tolok Ukur Adaptasi Tugas Visual (VTAB)

VTAB terdiri dari 19 kumpulan data klasifikasi visual yang beragam. Semua dataset sudah kami proses dan datanya dapat diunduh disini : Link Download. Untuk prosedur dan tip pemrosesan khusus, silakan lihat VTAB_SETUP.

Kinetika-400

Unduh kumpulan data dari Tautan Unduhan atau Tautan Unduhan.

Proses awal kumpulan data dengan mengubah ukuran tepi pendek video menjadi 320 piksel . Anda dapat merujuk ke Tolok Ukur Data MMAction2.

Hasilkan anotasi yang diperlukan untuk pemuat data ("<video_id> <video_class>" dalam anotasi). Anotasi biasanya mencakup train.csv , val.csv dan test.csv . Format file *.csv seperti:

video_1.mp4 label_1 video_2.mp4 label_2 video_3.mp4 label_3 ... video_N.mp4 label_N

Sesuatu-Sesuatu V2 (SSv2)

Unduh kumpulan data dari Tautan Unduhan.

Proses awal kumpulan data dengan mengubah ekstensi video dari webm menjadi .mp4 dengan tinggi asli 240px . Anda dapat merujuk ke Tolok Ukur Data MMAction2.

Hasilkan anotasi yang diperlukan untuk pemuat data ("<video_id> <video_class>" dalam anotasi). Anotasi biasanya mencakup train.csv , val.csv dan test.csv . Format file *.csv seperti:

video_1.mp4 label_1 video_2.mp4 label_2 video_3.mp4 label_3 ... video_N.mp4 label_N

MS-COCO

MS-COCO tersedia dari Tautan Unduhan ini.

ADE20K

Kumpulan pelatihan dan validasi ADE20K dapat diunduh dari Tautan Unduhan ini. Kami juga dapat mengunduh set tes dari Tautan Unduhan.

PASCAL VOC

Pascal VOC 2012 dapat diunduh dari Tautan Unduhan. Selain itu, karya terbaru pada dataset Pascal VOC biasanya mengeksploitasi data augmentasi tambahan, yang dapat ditemukan di Tautan Unduhan.

Unduh dan tempatkan model ViT-B/16 yang telah dilatih sebelumnya ke /path/to/pretrained_models .

mkdir pretrained_models dapatkan https://storage.googleapis.com/vit_models/imagenet21k/ViT-B_16.npz

atau Anda dapat mengunduh model terlatih Swin-B. Perhatikan bahwa Anda juga perlu mengganti nama ckpt Swin-B yang diunduh dari swin_base_patch4_window7_224_22k.pth menjadi Swin-B_16.pth .

mkdir pretrained_models dapatkan https://github.com/SwinTransformer/storage/releases/download/v1.0.0/swin_base_patch4_window7_224_22k.pth mv swin_base_patch4_window7_224_22k.pth Swin_B_16.pth

Cara lain adalah dengan mengunduh model terlatih dari tautan di bawah dan memasukkannya ke dalam /path/to/pretrained_models .

| Tulang Punggung yang telah dilatih sebelumnya | Tujuan yang telah dilatih sebelumnya | Kumpulan Data yang telah dilatih sebelumnya | Pos pemeriksaan |

|---|---|---|---|

| ViT-B/16 | Diawasi | GambarNet-21K | Tautan Unduh |

| ViT-L/16 | Diawasi | GambarNet-21K | Tautan Unduh |

| ViT-H/16 | Diawasi | GambarNet-21K | Tautan Unduh |

| Babi-B | Diawasi | GambarNet-22K | Tautan Unduh |

| Babi-L | Diawasi | GambarNet-22K | Tautan Unduh |

| ViT-B (VideoMAE) | Diawasi Sendiri | Kinetika-400 | Tautan Unduh |

| Video Swin-B | Diawasi | Kinetika-400 | Tautan Unduh |

ImageClassification/configs : menangani parameter konfigurasi untuk eksperimen.

ImageClassification/config/vtab/cifar100.yaml : pengaturan konfigurasi utama untuk eksperimen dan penjelasan untuk setiap dataset.

.....

ImageClassification/dataloader : memuat dan mengatur kumpulan data masukan.

ImageClassification/dataloader/transforms : Transformasi gambar.

ImageClassification/dataloader/loader : Membuat pemuat data untuk kumpulan data tertentu.

ImageClassification/models : menangani lengkungan tulang punggung dan kepala untuk berbagai protokol penyesuaian

ImageClassification/models/vision_transformer_adapter.py : folder berisi tulang punggung yang sama di folder vit_backbones , ditentukan untuk Adaptor.

ImageClassification/models/vision_transformer_sct.py : folder berisi tulang punggung yang sama di folder vit_backbones , ditentukan untuk SCT.

.....

ImageClassification/train : folder berisi folder training file ,

ImageClassification/train/train_model_adapter.py : panggil yang ini untuk pelatihan dan evaluasi model dengan tipe transfer tertentu, yang ditentukan untuk Adaptor.

ImageClassification/train/train_model_sct.py : panggil yang ini untuk pelatihan dan evaluasi model dengan tipe transfer tertentu, yang ditentukan untuk SCT.

.....

ImageClassification/scripts : folder berisi folder scripts file ,

ImageClassification/scripts/run_vit_adapter.sh : Anda dapat menjalankan metode Adaptor pada semua kumpulan data sekaligus.

ImageClassification/scripts/run_vit_sct.sh : Anda dapat menjalankan metode Adaptor pada semua kumpulan data sekaligus.

.....

ImageClassification/Visualize : Alat Visualisasi.

ImageClassification/Visualize/AttentionMap.py : Visualisasi peta perhatian.

ImageClassification/Visualize/TSNE.py : visualisasi T-SNE.

ImageClassification/utils : Buat logger, Setel benih, dll.

❗️Catatan❗️: Jika Anda ingin membuat algoritma PETL Anda sendiri, perhatikan `ImageClassification/models`.

Ini adalah contoh cara menyiapkan V-PETL Bench secara lokal.

Untuk mendapatkan salinan lokal, ikuti langkah-langkah contoh sederhana berikut.

git clone https://github.com/synbol/Parameter-Efficient-Transfer-Learning-Benchmark.git

V-PETL Bench dibangun di atas pytorch, dengan torchvision, torchaudio, dan timm, dll.

Untuk menginstal paket yang diperlukan, Anda dapat membuat lingkungan conda.

conda buat --nama v-petl-bench python=3.8

Aktifkan lingkungan conda.

conda aktifkan v-petl-bench

Gunakan pip untuk menginstal paket yang diperlukan.

cd Parameter-Efisien-Transfer-Pembelajaran-Benchmark instalasi pip -r persyaratan.txt

Kami menyediakan demo pelatihan dan evaluasi khusus, dengan mengambil LoRA di VTAB Cifar100 sebagai contoh.

sistem impor

sys.path.append("Parameter-Efisien-Transfer-Pembelajaran-Patokan")

impor obor

dari utilitas impor ImageClassification

dari ImageClassification.dataloader impor vtab

dari ImageClassification.train import train# dapatkan metode loradari timm.scheduler.cosine_lr import CosineLRScheduler

dari ImageClassification.models impor vision_transformer_lora

impor timm# jalur untuk menyimpan model dan logsexp_base_path = '../output'utils.mkdirss(exp_base_path)# buat loggerlogger = utils.create_logger(log_path=exp_base_path, log_name='training')# dataset config parameterconfig = utils.get_config(' model_lora', 'vtab', 'cifar100')# dapatkan vtab datasetdata_path = '/home/ma-user/work/haozhe/synbol/vtab-1k'train_dl, test_dl = vtab.get_data(data_path, 'cifar100', logger, evaluasi=False, train_aug=config['train_aug'], batch_size= config['batch_size'])# dapatkan model terlatihmodel = timm.models.create_model('vit_base_patch16_224_in21k_lora', checkpoint_path='./released_models/ViT-B_16.npz', drop_path_rate=0.1, tuning_mode='lora')

model.reset_classifier(config['class_num'])# parameter pelatihantrainable = []untuk n, p dalam model.named_parameters(): jika 'linear_a' di n atau 'linear_b' di n atau 'head' di n:

dapat dilatih.tambahkan(p)

logger.info(str(n))

kalau tidak:

p.requires_grad = Salah

opt = torch.optim.AdamW(dapat dilatih, lr=1e-4, Weight_decay=5e-2)

scheduler = CosineLRScheduler(opt, t_initial=config['epochs'],warmup_t=config['warmup_epochs'], lr_min=1e-5,warmup_lr_init=1e-6, cycle_decay = 0.1)# kriteria fungsi crossEntropyLoss = torch.nn.CrossEntropyLoss( )#model pelatihan = train.train(config, model, kriteria, train_dl, opt, penjadwal, logger, config['epochs'], 'vtab', 'cifar100')# evaluasieval_acc = train.test(model, test_dl, 'vtab')Anda dapat berlatih dengan algoritma PETL pada kumpulan data.

python python train/train_model_sct.py --dataset cifar100 --task vtab --lr 0,012 --wd 0,6 --eval True --dpr 0,1 --tuning_mode $tuning_mode --model_type $model_type --model $model --model_checkpoint $ model_pos pemeriksaan

atau Anda dapat berlatih dengan algoritma PETL di semua dataset

skrip bash/run_model_sct.sh

Kami mengevaluasi 13 algoritme PETL pada lima kumpulan data dengan model ViT-B/16 yang telah dilatih sebelumnya di ImageNet-21K.

Untuk mendapatkan checkpointnya silahkan download di Link Download.

| Metode | anak-200-2011 | Burung NA | Bunga Oxford | Anjing Stanford | Mobil Stanford | Berarti | Param. | PPT |

|---|---|---|---|---|---|---|---|---|

| Penyempurnaan penuh | 87.3 | 82.7 | 98.8 | 89.4 | 84.5 | 88.54 | 85,8 juta | - |

| Pemeriksaan linier | 85.3 | 75.9 | 97.9 | 86.2 | 51.3 | 79.32 | 0 M | 0,79 |

| Adaptor | 87.1 | 84.3 | 98,5 | 89.8 | 68.6 | 85.66 | 0,41 juta | 0,84 |

| AdaptMantan | 88.4 | 84.7 | 99.2 | 88.2 | 81.9 | 88.48 | 0,46 juta | 0,87 |

| Penyetelan Awalan | 87.5 | 82.0 | 98.0 | 74.2 | 90.2 | 86.38 | 0,36 juta | 0,85 |

| Penyetelan U | 89.2 | 85.4 | 99.2 | 84.1 | 92.1 | 90.00 | 0,36 juta | 0,89 |

| BitFit | 87.7 | 85.2 | 99.2 | 86.5 | 81.5 | 88.02 | 0,10 juta | 0,88 |

| VPT-Dangkal | 86.7 | 78.8 | 98.4 | 90.7 | 68.7 | 84.66 | 0,25 juta | 0,84 |

| VPT-Dalam | 88.5 | 84.2 | 99.0 | 90.2 | 83.6 | 89.10 | 0,85 juta | 0,86 |

| SSF | 89,5 | 85.7 | 99.6 | 89.6 | 89.2 | 90,72 | 0,39 juta | 0,89 |

| LoRA | 85.6 | 79.8 | 98.9 | 87.6 | 72.0 | 84,78 | 0,77 juta | 0,82 |

| GPS | 89.9 | 86.7 | 99,7 | 92.2 | 90.4 | 91,78 | 0,66 juta | 0,90 |

| HST | 89.2 | 85.8 | 99.6 | 89,5 | 88.2 | 90.46 | 0,78 juta | 0,88 |

| TERAKHIR | 88.5 | 84.4 | 99,7 | 86.0 | 88.9 | 89,50 | 0,66 juta | 0,87 |

| SNF | 90.2 | 87.4 | 99,7 | 89,5 | 86.9 | 90,74 | 0,25 juta | 0,90 |

Hasil benchmark pada VTAB. Kami mengevaluasi 18 algoritme PETL pada 19 kumpulan data dengan model ViT-B/16 yang telah dilatih sebelumnya di ImageNet-21K.

Untuk mendapatkan checkpointnya silahkan download di Link Download.

| Metode | CIFAR-100 | Caltech101 | DTD | Bunga102 | Hewan peliharaan | SVHN | Matahari397 | Tambalan Camelyon | EuroSAT | Resisc45 | Retinopati | Clevr/hitung | Clevr/jarak | Lab DM | KITTI/jarak | dSprite/loc | dSprite/ori | KecilNORB/azi | KecilNORB/ele | Berarti | Param. | PPT |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Penyempurnaan penuh | 68.9 | 87.7 | 64.3 | 97.2 | 86.9 | 87.4 | 38.8 | 79.7 | 95.7 | 84.2 | 73.9 | 56.3 | 58.6 | 41.7 | 65.5 | 57.5 | 46.7 | 25.7 | 29.1 | 65.57 | 85,8 juta | - |

| Pemeriksaan linier | 63.4 | 85.0 | 63.2 | 97.0 | 86.3 | 36.6 | 51.0 | 78.5 | 87.5 | 68.6 | 74.0 | 34.3 | 30.6 | 33.2 | 55.4 | 12.5 | 20.0 | 9.6 | 19.2 | 52.94 | 0M | 0,53 |

| Adaptor | 69.2 | 90.1 | 68.0 | 98.8 | 89.9 | 82.8 | 54.3 | 84.0 | 94.9 | 81.9 | 75.5 | 80.9 | 65.3 | 48.6 | 78.3 | 74.8 | 48.5 | 29.9 | 41.6 | 71.44 | 0,16 juta | 0,71 |

| VPT-Dangkal | 77.7 | 86.9 | 62.6 | 97,5 | 87.3 | 74.5 | 51.2 | 78.2 | 92.0 | 75.6 | 72.9 | 50.5 | 58.6 | 40.5 | 67.1 | 68.7 | 36.1 | 20.2 | 34.1 | 64,85 | 0,08 juta | 0,65 |

| VPT-Dalam | 78.8 | 90.8 | 65.8 | 98.0 | 88.3 | 78.1 | 49.6 | 81.8 | 96.1 | 83.4 | 68.4 | 68.5 | 60.0 | 46.5 | 72.8 | 73.6 | 47.9 | 32.9 | 37.8 | 69.43 | 0,56 juta | 0,68 |

| BitFit | 72.8 | 87.0 | 59.2 | 97,5 | 85.3 | 59.9 | 51.4 | 78.7 | 91.6 | 72.9 | 69.8 | 61.5 | 55.6 | 32.4 | 55.9 | 66.6 | 40.0 | 15.7 | 25.1 | 62.05 | 0,10 juta | 0,61 |

| LoRA | 67.1 | 91.4 | 69.4 | 98.8 | 90.4 | 85.3 | 54.0 | 84.9 | 95.3 | 84.4 | 73.6 | 82.9 | 69.2 | 49.8 | 78.5 | 75.7 | 47.1 | 31.0 | 44.0 | 72.25 | 0,29 juta | 0,71 |

| AdaptMantan | 70.8 | 91.2 | 70.5 | 99.1 | 90.9 | 86.6 | 54.8 | 83.0 | 95.8 | 84.4 | 76.3 | 81.9 | 64.3 | 49.3 | 80.3 | 76.3 | 45.7 | 31.7 | 41.1 | 72.32 | 0,16 juta | 0,72 |

| SSF | 69.0 | 92.6 | 75.1 | 99.4 | 91.8 | 90.2 | 52.9 | 87.4 | 95.9 | 87.4 | 75.5 | 75.9 | 62.3 | 53.3 | 80.6 | 77.3 | 54.9 | 29.5 | 37.9 | 73.10 | 0,21 juta | 0,72 |

| NUH | 69.6 | 92.7 | 70.2 | 99.1 | 90.4 | 86.1 | 53.7 | 84.4 | 95.4 | 83.9 | 75.8 | 82.8 | 68.9 | 49.9 | 81.7 | 81.8 | 48.3 | 32.8 | 44.2 | 73.25 | 0,43 juta | 0,72 |

| SCT | 75.3 | 91.6 | 72.2 | 99.2 | 91.1 | 91.2 | 55.0 | 85.0 | 96.1 | 86.3 | 76.2 | 81.5 | 65.1 | 51.7 | 80.2 | 75.4 | 46.2 | 33.2 | 45.7 | 73.59 | 0,11 juta | 0,73 |

| Fakta | 70.6 | 90.6 | 70.8 | 99.1 | 90.7 | 88.6 | 54.1 | 84.8 | 96.2 | 84.5 | 75.7 | 82.6 | 68.2 | 49.8 | 80.7 | 80.8 | 47.4 | 33.2 | 43.0 | 73.23 | 0,07 juta | 0,73 |

| Adaptor Rep | 72.4 | 91.6 | 71.0 | 99.2 | 91.4 | 90.7 | 55.1 | 85.3 | 95.9 | 84.6 | 75.9 | 82.3 | 68.0 | 50.4 | 79.9 | 80.4 | 49.2 | 38.6 | 41.0 | 73,84 | 0,22 juta | 0,72 |

| Ular naga | 72.7 | 91.3 | 72.0 | 99.2 | 91.4 | 90.7 | 55.5 | 85.8 | 96.0 | 86.1 | 75.9 | 83.2 | 68.2 | 50.9 | 82.3 | 80.3 | 50.8 | 34.5 | 43.1 | 74.21 | 0,28 juta | 0,73 |

| LST | 59.5 | 91.5 | 69.0 | 99.2 | 89.9 | 79.5 | 54.6 | 86.9 | 95.9 | 85.3 | 74.1 | 81.8 | 61.8 | 52.2 | 81.0 | 71.7 | 49.5 | 33.7 | 45.2 | 71.70 | 2,38 juta | 0,65 |

| DTL | 69.6 | 94.8 | 71.3 | 99.3 | 91.3 | 83.3 | 56.2 | 87.1 | 96.2 | 86.1 | 75.0 | 82.8 | 64.2 | 48.8 | 81.9 | 93.9 | 53.9 | 34.2 | 47.1 | 74.58 | 0,04 juta | 0,75 |

| HST | 76.7 | 94.1 | 74.8 | 99.6 | 91.1 | 91.2 | 52.3 | 87.1 | 96.3 | 88.6 | 76.5 | 85.4 | 63.7 | 52.9 | 81.7 | 87.2 | 56.8 | 35.8 | 52.1 | 75,99 | 0,78 juta | 0,74 |

| GPS | 81.1 | 94.2 | 75.8 | 99.4 | 91.7 | 91.6 | 52.4 | 87.9 | 96.2 | 86.5 | 76.5 | 79.9 | 62.6 | 55.0 | 82.4 | 84.0 | 55.4 | 29.7 | 46.1 | 75.18 | 0,22 juta | 0,74 |

| TERAKHIR | 66.7 | 93.4 | 76.1 | 99.6 | 89.8 | 86.1 | 54.3 | 86.2 | 96.3 | 86.8 | 75.4 | 81.9 | 65.9 | 49.4 | 82.6 | 87.9 | 46.7 | 32.3 | 51.5 | 74.15 | 0,66 juta | 0,72 |

| SNF | 84.0 | 94.0 | 72.7 | 99.3 | 91.3 | 90.3 | 54.9 | 87.2 | 97.3 | 85.5 | 74.5 | 82.3 | 63.8 | 49.8 | 82.5 | 75.8 | 49.2 | 31.4 | 42.1 | 74.10 | 0,25 juta | 0,73 |

Hasil benchmark pada SSv2 dan HMDB51. Kami mengevaluasi 5 algoritma PETL dengan ViT-B dari VideoMAE dan Video Swin Transformer.

Untuk mendapatkan checkpointnya silahkan download di Link Download.

| Metode | Model | Pra-pelatihan | Param. | SSv2 (Atas1) | SSv2 (PPT) | HMDB51 (Top1) | HMDB51 (PPT) |

|---|---|---|---|---|---|---|---|

| Penyempurnaan penuh | ViT-B | Kinetika 400 | 85,97 M | 53,97% | - | 46,41% | - |

| Beku | ViT-B | Kinetika 400 | 0 M | 29,23% | 0,29 | 49,84% | 0,50 |

| AdaptMantan | ViT-B | Kinetika 400 | 1,19M | 59,02% | 0,56 | 55,69% | 0,53 |

| BAPAT | ViT-B | Kinetika 400 | 2,06 M | 57,78% | 0,53 | 57,18% | 0,53 |

| Penyempurnaan penuh | Video Swin-B | Kinetika 400 | 87,64 M | 50,99% | - | 68,07% | - |

| Beku | Video Swin-B | Kinetika 400 | 0 M | 24,13% | 0,24 | 71,28% | 0,71 |

| LoRA | Video Swin-B | Kinetika 400 | 0,75M | 38,34% | 0,37 | 62,12% | 0,60 |

| BitFit | Video Swin-B | Kinetika 400 | 1,09 M | 45,94% | 0,44 | 68,26% | 0,65 |

| AdaptMantan | Video Swin-B | Kinetika 400 | 1,56 jt | 40,80% | 0,38 | 68,66% | 0,64 |

| Penyetelan awalan | Video Swin-B | Kinetika 400 | 6,37 M | 39,46% | 0,32 | 56,13% | 0,45 |

| BAPAT | Video Swin-B | Kinetika 400 | 6,18M | 53,36% | 0,43 | 71,93% | 0,58 |

Hasil benchmark pada COCO. Kami mengevaluasi 9 algoritma PETL dengan model Swin-B yang telah dilatih sebelumnya di ImageNet-22K.

Untuk mendapatkan checkpoint tersebut, silahkan download di Coming Soon.

| Babi-B | Param. | Ingatan | kelapa ( | kelapa (PPT) | kelapa ( | kelapa (PPT) |

|---|---|---|---|---|---|---|

| Penyempurnaan penuh | 86,75M | 17061 MB | 51,9% | - | 45,0% | - |

| Beku | 0,00 jt | 7137 MB | 43,5% | 0,44 | 38,6% | 0,39 |

| Bitfit | 0,20 jt | 13657 MB | 47,9% | 0,47 | 41,9% | 0,42 |

| LN TUNE | 0,06M | 12831 MB | 48,0% | 0,48 | 41,4% | 0,41 |

| Parsial-1 | 12,60 jt | 7301 MB | 49,2% | 0,35 | 42,8% | 0,30 |

| Adaptor | 3,11 M | 12557 MB | 50,9% | 0,45 | 43,8% | 0,39 |

| LoRA | 3,03 M | 11975 MB | 51,2% | 0,46 | 44,3% | 0,40 |

| AdaptMantan | 3,11 M | 13186 MB | 51,4% | 0,46 | 44,5% | 0,40 |

| LoRand | 1,20 jt | 13598 MB | 51,0% | 0,49 | 43,9% | 0,42 |

| E$^3$VA | 1,20 jt | 7639 MB | 50,5% | 0,48 | 43,8% | 0,42 |

| Mona | 4,16M | 13996 MB | 53,4% | 0,46 | 46,0% | 0,40 |

Hasil benchmark pada PASCAL VOC dan ADE20K. Kami mengevaluasi 9 algoritma PETL dengan model Swin-L yang telah dilatih sebelumnya di ImageNet-22K.

Untuk mendapatkan checkpoint tersebut, silahkan download di Coming Soon.

| Babi-L | Param. | Memori (VOC) | Pascal VOC ( | Pascal VOC (PPT) | ADE20K ( | ADE20K (PPT) |

|---|---|---|---|---|---|---|

| Penyempurnaan penuh | 198,58 M | 15679 MB | 83,5% | - | 52,10% | - |

| Beku | 0,00 jt | 3967 MB | 83,6% | 0,84 | 46,84% | 0,47 |

| Bitfit | 0,30 jt | 10861 MB | 85,7% | 0,85 | 48,37% | 0,48 |

| LN TUNE | 0,09 jt | 10123 MB | 85,8% | 0,86 | 47,98% | 0,48 |

| Parsial-1 | 28,34 M | 3943MB | 85,4% | 0,48 | 47,44% | 0,27 |

| Adaptor | 4,66 jt | 10793 MB | 87,1% | 0,74 | 50,78% | 0,43 |

| LoRA | 4,57M | 10127 MB | 87,5% | 0,74 | 50,34% | 0,43 |

| AdaptMantan | 4,66 jt | 11036MB | 87,3% | 0,74 | 50,83% | 0,43 |

| LoRand | 1,31 jt | 11572 MB | 86,8% | 0,82 | 50,76% | 0,48 |

| E$^3$VA | 1,79 jt | 4819 MB | 86,5% | 0,81 | 49,64% | 0,46 |

| Mona | 5,08M | 11958 MB | 87,3% | 0,73 | 51,36% | 0,43 |

Komunitas V-PETL Bench dikelola oleh:

Yi Xin ([email protected]), Universitas Nanjing.

Siqi Luo ([email protected]), Universitas Shanghai Jiao Tong.

Jika menurut Anda survei dan repositori kami berguna untuk penelitian Anda, harap kutip di bawah ini:

@article{xin2024bench, title={V-PETL Bench: Tolok Ukur Pembelajaran Transfer Efisien Parameter Visual Terpadu}, author={Yi Xin, Siqi Luo, Xuyang Liu, Haodi Zhou, Xinyu Cheng, Christina Luoluo Lee, Junlong Du, Yuntao Du., Haozhe Wang, MingCai Chen, Ting Liu, Guimin Hu, Zhongwei Wan, Rongchao Zhang, Aoxue Li, Mingyang Yi, Xiaohong Liu}, tahun={2024}}