reweight gpt

1.0.0

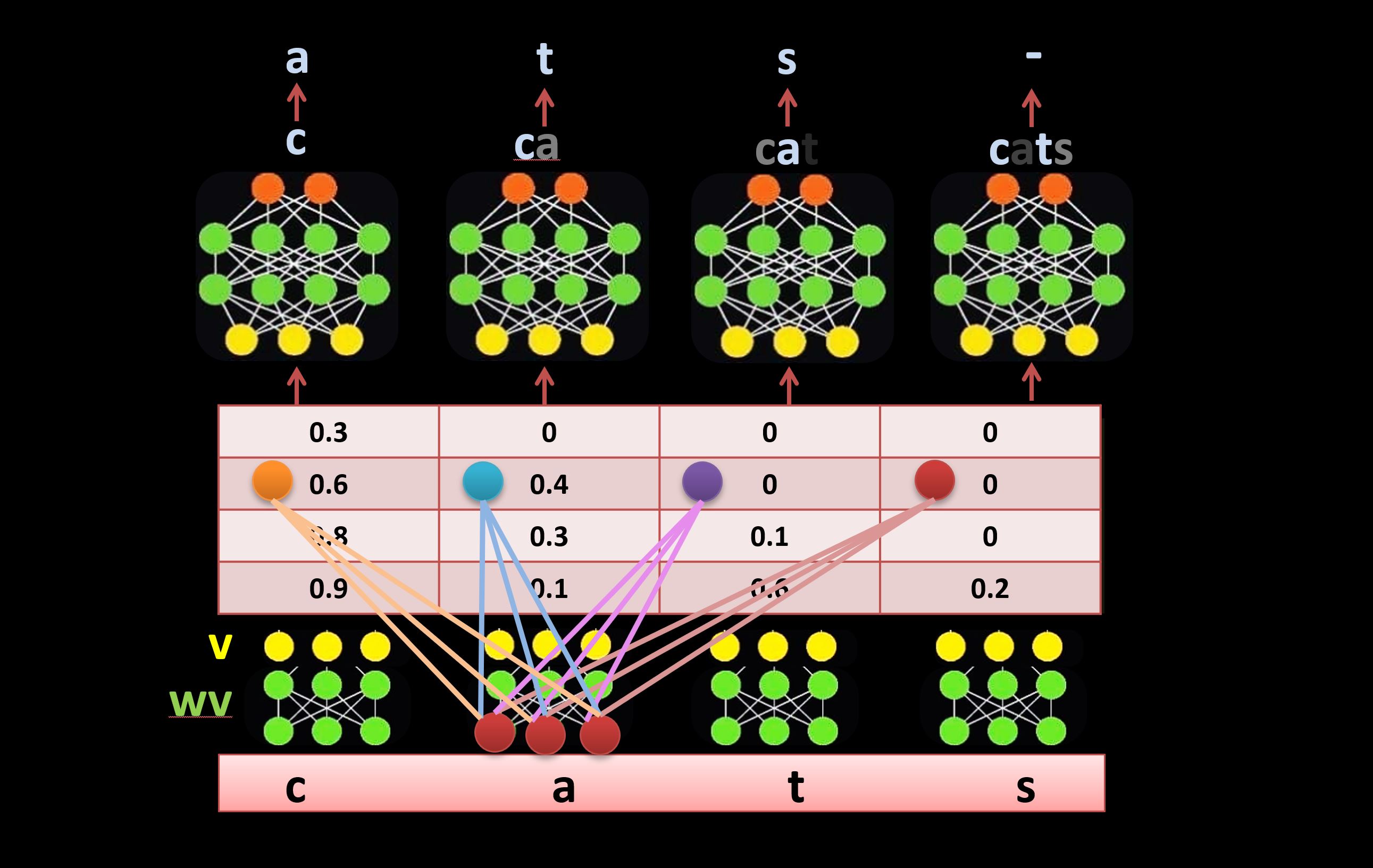

Sebuah alternatif terhadap mekanisme self-attetnion dalam arsitektur Tranformer. Ia menggunakan koneksi lateral yang dapat dipelajari untuk mempertimbangkan kembali masukan secara langsung, bukan mekanisme perhatian diri (seperti yang diilustrasikan di bawah). Untuk mempelajari lebih lanjut tentang metode ini, tonton video ini (mulai 41:26): https://youtu.be/l-CjXFmcVzY