[? Memeluk Wajah] [? OpenXLab] [? Makalah] [Halaman Proyek]

Model Bahasa Besar (LLM) bersumber terbuka telah mencapai kesuksesan besar dalam berbagai tugas NLP, namun masih kalah jauh dengan model berbasis API ketika bertindak sebagai agen. Bagaimana mengintegrasikan kemampuan agen ke dalam LLM umum menjadi masalah krusial dan mendesak. Makalah ini pertama-tama menyampaikan tiga pengamatan utama: (1) korpus pelatihan agen saat ini terjerat dengan format berikut dan alasan agen, yang secara signifikan bergeser dari distribusi data pra-pelatihannya; (2) LLM menunjukkan kecepatan pembelajaran yang berbeda pada kemampuan yang dibutuhkan oleh tugas agen; dan (3) pendekatan saat ini memiliki efek samping ketika meningkatkan kemampuan agen dengan menimbulkan halusinasi. Berdasarkan temuan di atas, kami mengusulkan Agen-FLAN untuk menyempurnakan model LANguage untuk Agen secara efektif. Melalui dekomposisi yang cermat dan desain ulang korpus pelatihan, Agen-FLAN memungkinkan Llama2-7B mengungguli karya terbaik sebelumnya sebesar 3,5% di berbagai kumpulan data evaluasi agen. Dengan sampel negatif yang dibangun secara komprehensif, Agen-FLAN sangat meringankan masalah halusinasi berdasarkan tolok ukur evaluasi kami yang telah ditetapkan. Selain itu, ini secara konsisten meningkatkan kemampuan agen LLM saat menskalakan ukuran model sekaligus sedikit meningkatkan kemampuan umum LLM.

Seri Agent-FLAN disempurnakan pada AgentInstruct dan Toolbench dengan menerapkan alur pembuatan data yang diusulkan dalam makalah Agent-FLAN, yang memiliki kemampuan kuat dalam berbagai tugas agen dan pemanfaatan alat~

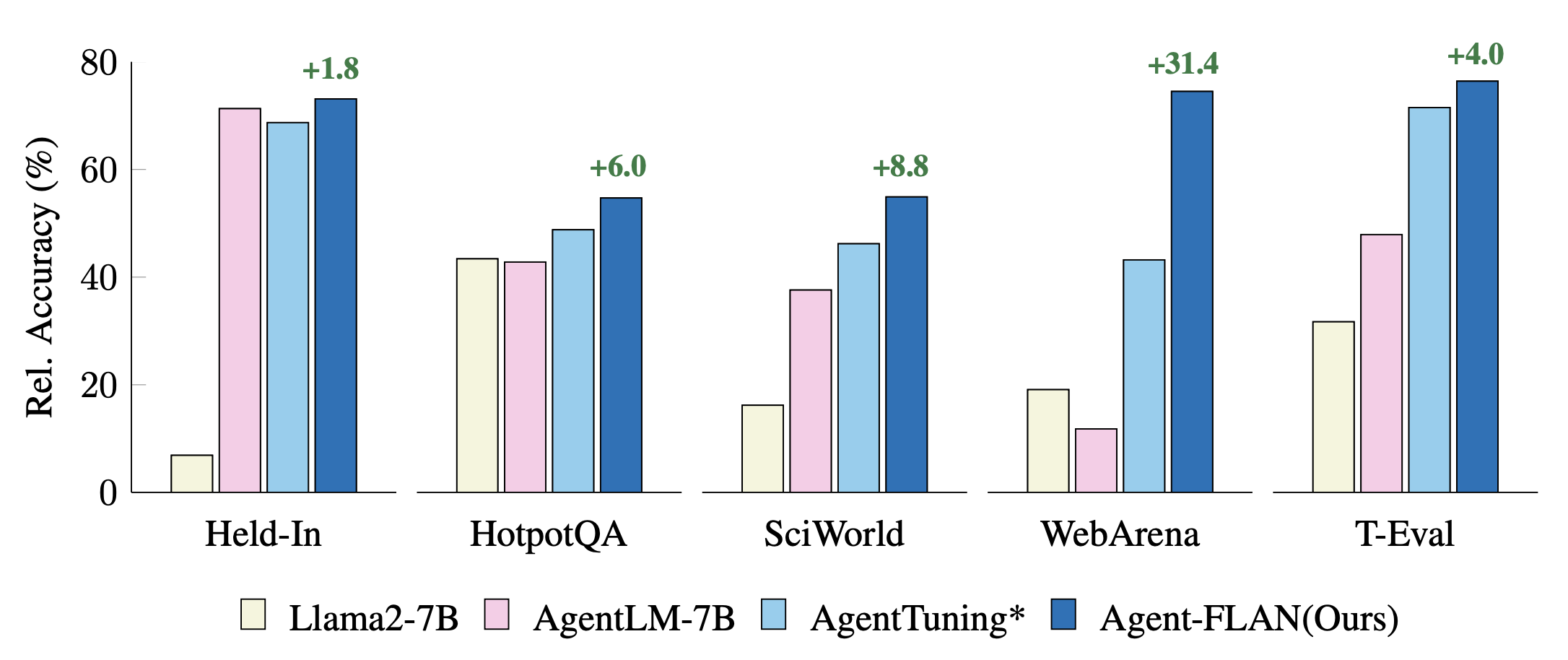

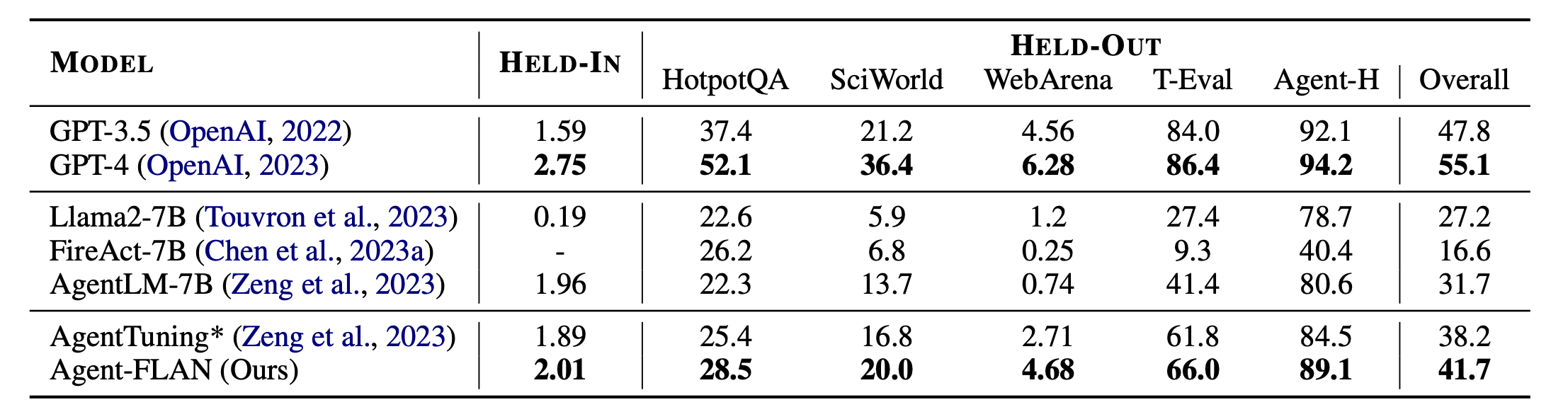

Perbandingan pendekatan penyetelan agen terkini pada tugas Held-In, Held-Out. Pertunjukan dinormalisasi dengan hasil GPT-4 untuk visualisasi yang lebih baik. * menunjukkan implementasi ulang kami untuk perbandingan yang adil.

Agent-FLAN dihasilkan oleh pelatihan campuran pada kumpulan data AgentInstruct, ToolBench, dan ShareGPT dari seri obrolan Llama2.

Modelnya mengikuti format percakapan Llama-2-chat, dengan protokol templat sebagai:

dict ( role = 'user' , begin = '<|Human|>െ' , end = ' n ' ),

dict ( role = 'system' , begin = '<|Human|>െ' , end = ' n ' ),

dict ( role = 'assistant' , begin = '<|Assistant|>െ' , end = 'ി n ' ),Model 7B tersedia di hub model Huggingface & OpenXLab.

| Model | Repo Wajah Memeluk | Repo OpenXLab |

|---|---|---|

| Agen-FLAN-7B | Tautan Model | Tautan Model |

Himpunan data Agent-FLAN juga tersedia di hub himpunan data Huggingface.

| Kumpulan data | Repo Wajah Memeluk |

|---|---|

| Agen-FLAN | Tautan Kumpulan Data |

Hasil utama Agen-FLAN. Agent-FLAN secara signifikan mengungguli pendekatan penyetelan agen sebelumnya dengan selisih yang besar baik pada tugas yang ditahan maupun yang ditunda. * menunjukkan implementasi ulang kami dengan jumlah data pelatihan yang sama untuk perbandingan yang adil. Karena FireAct tidak berlatih pada kumpulan data AgentInstruct, kami menghilangkan performanya pada kumpulan HELD-IN. Tebal: yang terbaik dalam model berbasis API dan sumber terbuka.

Agen-FLAN dibangun dengan Lagent dan T-Eval. Terima kasih atas kerja luar biasa mereka!

Jika Anda merasa proyek ini bermanfaat dalam penelitian Anda, mohon pertimbangkan untuk mengutip:

@article{chen2024agent,

title={Agent-FLAN: Designing Data and Methods of Effective Agent Tuning for Large Language Models},

author={Chen, Zehui and Liu, Kuikun and Wang, Qiuchen and Zhang, Wenwei and Liu, Jiangning and Lin, Dahua and Chen, Kai and Zhao, Feng},

journal={arXiv preprint arXiv:2403.12881},

year={2024}

}

Proyek ini dirilis di bawah lisensi Apache 2.0.