? Bangun API inferensi model dan sistem penyajian multi-model dengan model AI sumber terbuka atau khusus apa pun. Bergabunglah dengan komunitas Slack kami!

BentoML adalah pustaka Python untuk membangun sistem penyajian online yang dioptimalkan untuk aplikasi AI dan inferensi model.

Instal BentoML:

# Requires Python≥3.9

pip install -U bentoml

Tentukan API dalam file service.py .

from __future__ import annotations

import bentoml

@ bentoml . service (

resources = { "cpu" : "4" }

)

class Summarization :

def __init__ ( self ) -> None :

import torch

from transformers import pipeline

device = "cuda" if torch . cuda . is_available () else "cpu"

self . pipeline = pipeline ( 'summarization' , device = device )

@ bentoml . api ( batchable = True )

def summarize ( self , texts : list [ str ]) -> list [ str ]:

results = self . pipeline ( texts )

return [ item [ 'summary_text' ] for item in results ]Jalankan kode layanan secara lokal (disajikan di http://localhost:3000 secara default):

pip install torch transformers # additional dependencies for local run

bentoml serve service.py:SummarizationSekarang Anda dapat menjalankan inferensi dari browser Anda di http://localhost:3000 atau dengan skrip Python:

import bentoml

with bentoml . SyncHTTPClient ( 'http://localhost:3000' ) as client :

summarized_text : str = client . summarize ([ bentoml . __doc__ ])[ 0 ]

print ( f"Result: { summarized_text } " ) Untuk menyebarkan kode Layanan BentoML Anda, pertama-tama buat file bentofile.yaml untuk menentukan dependensi dan lingkungannya. Temukan daftar lengkap opsi bentofile di sini.

service : ' service:Summarization ' # Entry service import path

include :

- ' *.py ' # Include all .py files in current directory

python :

packages : # Python dependencies to include

- torch

- transformers

docker :

python_version : " 3.11 "Lalu, pilih salah satu cara penerapan berikut:

Jalankan bentoml build untuk mengemas kode, model, konfigurasi ketergantungan yang diperlukan ke dalam Bento - artefak standar yang dapat diterapkan di BentoML:

bentoml buildPastikan Docker berjalan. Hasilkan gambar kontainer Docker untuk penerapan:

bentoml containerize summarization:latestJalankan gambar yang dihasilkan:

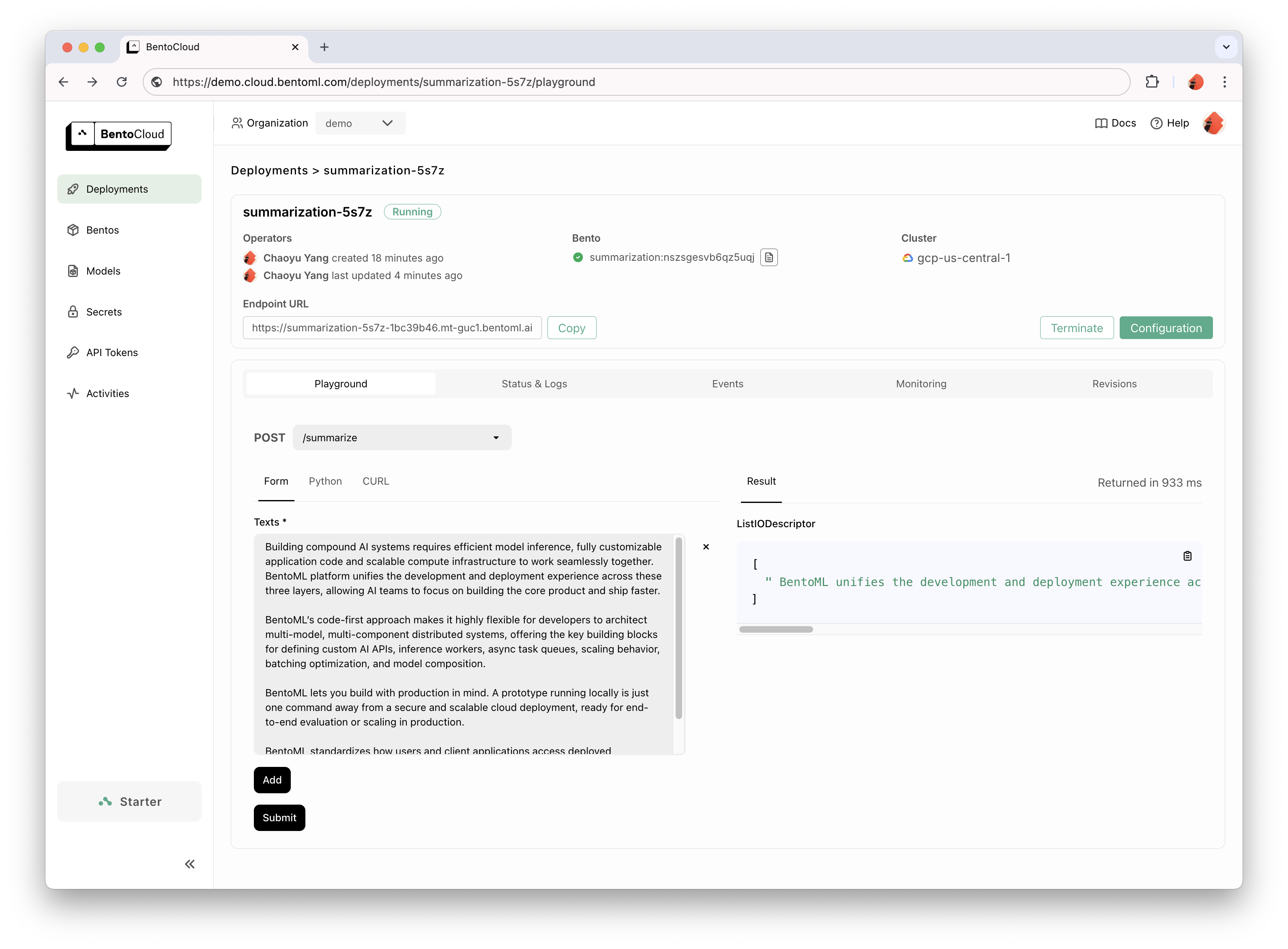

docker run --rm -p 3000:3000 summarization:latestBentoCloud menyediakan infrastruktur komputasi untuk adopsi GenAI yang cepat dan andal. Ini membantu mempercepat proses pengembangan BentoML Anda dengan memanfaatkan sumber daya komputasi awan, dan menyederhanakan cara Anda menerapkan, menskalakan, dan mengoperasikan BentoML dalam produksi.

Mendaftarlah ke BentoCloud untuk akses pribadi; untuk kasus penggunaan perusahaan, hubungi tim kami.

# After signup, run the following command to create an API token:

bentoml cloud login

# Deploy from current directory:

bentoml deploy .

Untuk penjelasan detailnya, baca contoh Hello World.

Lihat daftar lengkap untuk contoh kode dan penggunaan lebih lanjut.

Lihat Dokumentasi untuk tutorial dan panduan lebih lanjut.

Terlibatlah dan bergabunglah dengan Komunitas Slack kami, tempat ribuan insinyur AI/ML saling membantu, berkontribusi pada proyek, dan berdiskusi tentang pembuatan produk AI.

Untuk melaporkan bug atau menyarankan permintaan fitur, gunakan Masalah GitHub.

Ada banyak cara untuk berkontribusi pada proyek ini:

#bentoml-contributors di sini.Terima kasih kepada semua kontributor kami yang luar biasa!

Kerangka kerja BentoML mengumpulkan data penggunaan anonim yang membantu komunitas kami meningkatkan produk. Hanya panggilan API internal BentoML yang dilaporkan. Hal ini tidak termasuk informasi sensitif apa pun, seperti kode pengguna, data model, nama model, atau pelacakan tumpukan. Berikut kode yang digunakan untuk pelacakan penggunaan. Anda dapat memilih keluar dari pelacakan penggunaan dengan opsi CLI --do-not-track :

bentoml [command] --do-not-trackAtau dengan mengatur variabel lingkungan:

export BENTOML_DO_NOT_TRACK=TrueLisensi Apache 2.0