Reversal of Thought

1.0.0

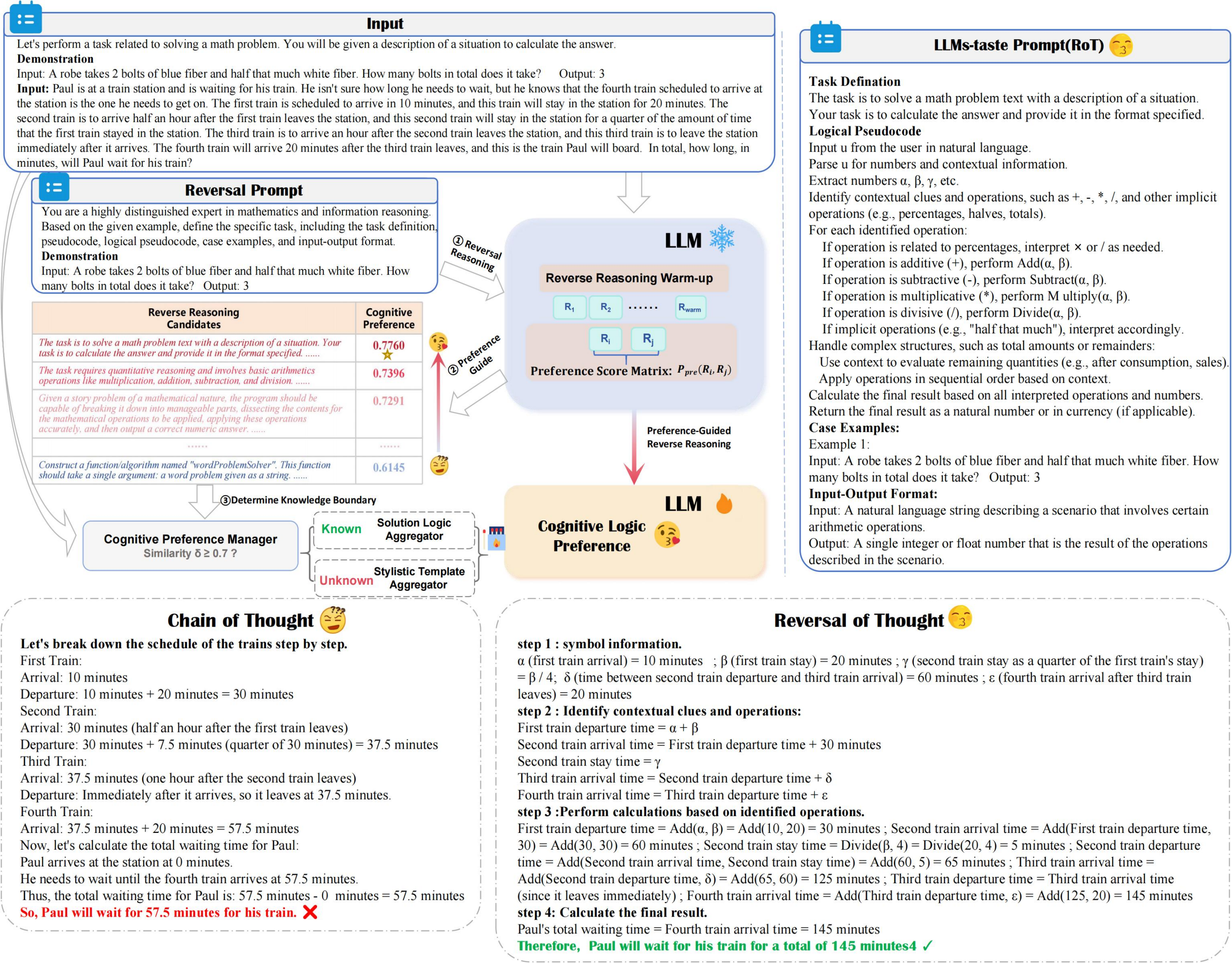

ROT meningkatkan akurasi dan efisiensi penalaran sambil meminimalkan biaya komputasi, memanfaatkan penalaran terbalik yang dipandu preferensi dan manajer preferensi kognitif untuk secara optimal mengeksplorasi penalaran LLM dengan preferensi kognitif.

??? reversal_demo.py

from utils . llm_utils import *

from utils . prompt import *

pipeline = Pipeline ( model_id = model_id , base_url = base_url , api_key = api_key , prob = True )

demos = "Input:... Output:..." #Suggest 2-shot Demos

llm_taste = rot_pipeline ( pipeline , reversal_of_thought , demos = demos , warmup = 5 ) Tingkatkan permintaan LLM yang disukai untuk solusi tugas

Menyempurnakan meminta untuk menyelaraskan dengan strategi yang disukai LLM, mengoptimalkan efisiensi pemecahan tugas.

Potensi untuk membuat beragam kumpulan data QA

Menghasilkan berbagai pasangan tanya jawab untuk meningkatkan keragaman dataset.

Jika Anda menemukan pekerjaan kami berguna untuk penelitian Anda, silakan kutip makalah kami sebagai berikut:

@article { yuan2024reversal ,

title = { Reversal of Thought: Enhancing Large Language Models with Preference-Guided Reverse Reasoning Warm-up } ,

author = { Yuan, Jiahao and Du, Dehui and Zhang, Hao and Di, Zixiang and Naseem, Usman } ,

journal = { arXiv preprint arXiv:2410.12323 } ,

year = { 2024 }

}