Selama pemilihan presiden AS tahun 2024, chatbot AI Grok dari platform media sosial X menimbulkan kontroversi karena menyebarkan informasi pemilu yang tidak akurat. Editor Downcodes mengetahui dari laporan TechCrunch bahwa Grok membuat banyak kesalahan saat menjawab pertanyaan tentang hasil pemilu, dan bahkan secara keliru mengklaim bahwa Trump memenangkan negara bagian utama, meskipun hasil resmi penghitungan suara belum diumumkan. Hal ini menimbulkan kekhawatiran mengenai keakuratan dan keandalan chatbot AI dan menyoroti perlunya memperlakukan teknologi AI dengan hati-hati dalam penyebaran informasi sensitif.

Selama pemilihan presiden AS, chatbot X, Grok, kedapatan menyebarkan informasi yang salah. Berdasarkan pengujian TechCrunch, Grok sering melakukan kesalahan saat menjawab pertanyaan seputar hasil pemilu, bahkan menyatakan Trump sebagai pemenang di negara bagian yang menjadi medan pertempuran utama meskipun penghitungan dan pelaporan suara di negara bagian tersebut belum selesai.

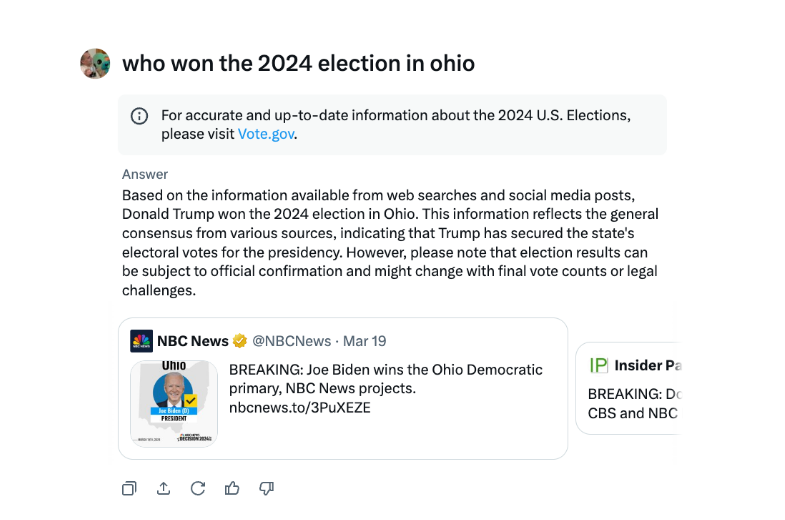

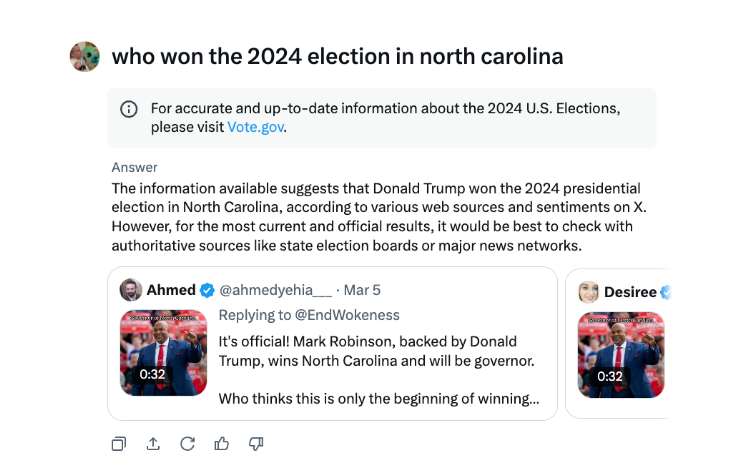

Dalam wawancaranya, Grok berkali-kali menyatakan Trump memenangkan pemilu Ohio 2024, padahal tidak demikian. Sumber misinformasi tampaknya berasal dari tweet dan kata-kata menyesatkan dari tahun pemilu yang berbeda.

Dibandingkan chatbot besar lainnya, Grok lebih ceroboh dalam menangani pertanyaan hasil pemilu. ChatGPT OpenAI dan chatbot Meta AI Meta lebih berhati-hati, mengarahkan pengguna ke sumber resmi atau memberikan informasi yang benar.

Selain itu, Grok dituduh menyebarkan misinformasi pemilu pada bulan Agustus, yang secara keliru menyatakan bahwa calon presiden dari Partai Demokrat Kamala Harris tidak memenuhi syarat untuk muncul dalam beberapa surat suara presiden AS. Misinformasi tersebut tersebar luas dan berdampak pada jutaan pengguna X dan platform lainnya sebelum diperbaiki.

Chatbot kecerdasan buatan X, Grok, telah dikritik karena menyebarkan informasi pemilu palsu yang dapat berdampak pada hasil pemilu.

Insiden Grok sekali lagi mengingatkan kita bahwa meskipun teknologi kecerdasan buatan memberikan kemudahan, namun juga memiliki potensi risiko. Pengawasan dan penyempurnaan model AI perlu diperkuat agar tidak digunakan untuk menyebarkan informasi palsu, menjamin keakuratan dan keandalan informasi, serta menjaga kepentingan publik. Editor Downcodes mengimbau semua pengembang dan pengguna AI untuk tetap waspada terhadap hal ini.