iFlytek telah merilis model interaktif multimodal besar dari iFlytek, menandai tonggak sejarah baru di bidang kecerdasan buatan. Model ini mendobrak keterbatasan interaksi suara tunggal di masa lalu dan mencapai integrasi sempurna antara interaksi suara, visual, dan digital manusia, memberikan pengalaman interaktif yang lebih jelas, nyata, dan nyaman bagi pengguna. Editor Downcodes akan memberi Anda pemahaman mendalam tentang fungsi dan keuntungan model interaksi multimodal yang menakjubkan ini, dan bagaimana model ini akan mengubah cara kita berinteraksi dengan kecerdasan buatan.

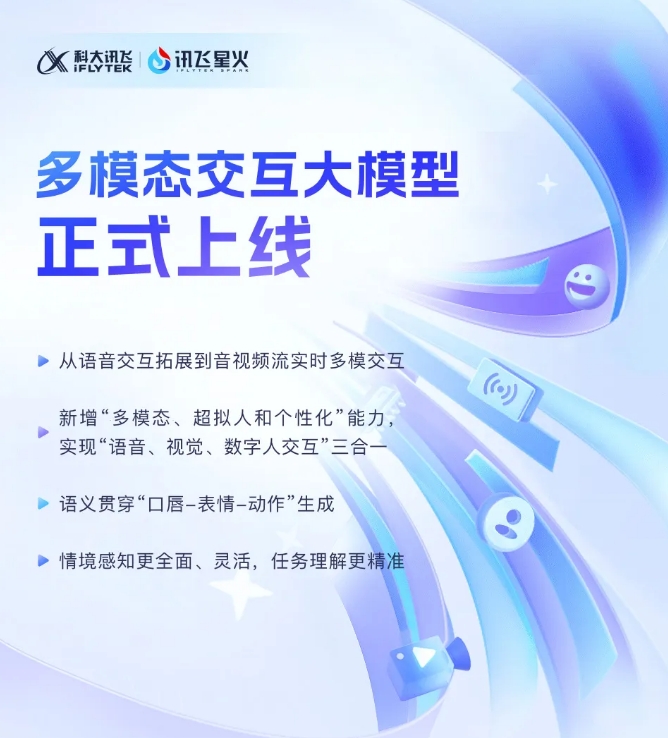

iFlytek baru-baru ini mengumumkan bahwa model besar interaktif multi-modal iFlytek Spark yang baru dikembangkan telah resmi dioperasikan. Terobosan teknologi ini menandai perluasan iFlytek dari teknologi interaksi suara tunggal ke tahap baru interaksi multi-modal streaming audio dan video secara real-time. Model baru ini mengintegrasikan fungsi interaksi suara, visual, dan digital manusia, dan pengguna dapat mencapai integrasi ketiganya dengan satu klik.

Peluncuran model interaktif multi-modal iFlytek memperkenalkan teknologi manusia digital super-antropomorfik untuk pertama kalinya. Teknologi ini dapat secara akurat mencocokkan gerakan batang tubuh dan anggota tubuh manusia digital dengan konten suara, dengan cepat menghasilkan ekspresi dan gerakan, dan sangat meningkatkan kualitas suara. kemampuan AI. Dengan mengintegrasikan teks, ucapan, dan ekspresi, model baru ini dapat mencapai konsistensi semantik lintas-modal, menjadikan ekspresi emosional lebih realistis dan koheren.

Selain itu, iFlytek Spark mendukung teknologi interaksi ultra-cepat super-antropomorfik dan menggunakan jaringan saraf terpadu untuk secara langsung mewujudkan pemodelan suara ke suara ujung ke ujung, menjadikan respons lebih cepat dan lancar. Teknologi ini dapat merasakan perubahan emosi dengan tajam dan dengan bebas menyesuaikan ritme, ukuran, dan kepribadian suara sesuai instruksi, sehingga memberikan pengalaman interaktif yang lebih personal.

Dalam hal interaksi visual multi-modal, iFlytek Spark dapat "memahami dunia" dan "mengenali segalanya", dan secara komprehensif memahami pemandangan latar belakang tertentu, status logistik, dan informasi lainnya, sehingga pemahaman tugas menjadi lebih akurat. Dengan mengintegrasikan berbagai informasi seperti suara, gerak tubuh, perilaku, dan emosi, model dapat membuat respons yang sesuai dan memberikan pengalaman interaktif yang lebih kaya dan akurat kepada pengguna.

SDK model besar interaktif multimodal: https://www.xfyun.cn/solutions/Multimodel

Munculnya model besar interaktif multi-modal iFlytek Spark menunjukkan bahwa teknologi kecerdasan buatan berkembang ke arah yang lebih cerdas dan manusiawi. Fungsinya yang kuat dan pengoperasian yang mudah pasti akan menghadirkan pengalaman interaktif baru bagi pengguna dan menghadirkan kemungkinan tak terbatas untuk semua lapisan masyarakat. Kami menantikan iFlytek Spark memberi kami lebih banyak kejutan di masa depan!