Meta AI secara mengejutkan telah merilis model bahasa multi-modal dasar yang disebut SPIRIT LM, yang merupakan pencapaian penting yang dapat dengan bebas menggabungkan teks dan ucapan! Hal ini didasarkan pada model bahasa teks terlatih dengan 7 miliar parameter, dan diperluas ke mode ucapan melalui pelatihan berkelanjutan, mewujudkan pemahaman dua modal dan pembuatan teks dan ucapan, dan bahkan dapat menggabungkan keduanya, menghadirkan efek aplikasi yang tidak terduga. Editor Downcodes akan membawa Anda untuk memiliki pemahaman mendalam tentang fungsi-fungsi hebat SPIRIT LM dan terobosan teknologi di baliknya.

Meta AI baru-baru ini membuka sumber model bahasa multi-modal dasar yang disebut SPIRIT LM, yang dapat dengan bebas mencampur teks dan ucapan, membuka kemungkinan baru untuk tugas multi-modal audio dan teks.

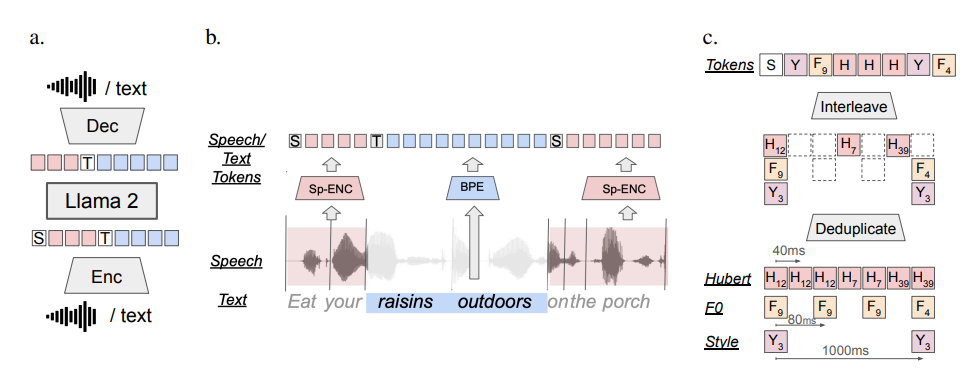

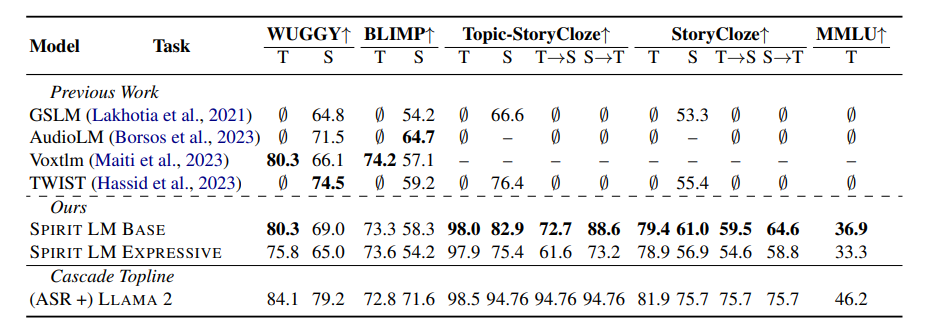

SPIRIT LM didasarkan pada model bahasa teks terlatih dengan 7 miliar parameter dan diperluas ke modalitas ucapan melalui pelatihan berkelanjutan pada teks dan unit ucapan. Ia dapat memahami dan menghasilkan teks seperti model teks besar, dan juga dapat memahami dan menghasilkan ucapan. Ia bahkan dapat menggabungkan teks dan ucapan untuk menciptakan berbagai efek ajaib! Misalnya, Anda dapat menggunakannya untuk pengenalan ucapan, dan Mengubah ucapan menjadi teks; Anda juga dapat menggunakannya untuk sintesis ucapan untuk mengubah teks menjadi ucapan; Anda juga dapat menggunakannya untuk klasifikasi ucapan guna menentukan emosi apa yang diungkapkan oleh sebuah ucapan.

Yang lebih hebatnya lagi adalah SPIRIT LM juga sangat ahli dalam "ekspresi emosional"! Ia dapat mengenali dan menghasilkan berbagai intonasi dan gaya suara yang berbeda, membuat suara AI terdengar lebih alami dan emosional. Bisa dibayangkan suara yang dihasilkan oleh SPIRIT LM bukan lagi suara mesin yang dingin, melainkan seperti suara orang sungguhan yang berbicara, penuh suka, marah, duka dan gembira!

Untuk menjadikan AI lebih "emosional", peneliti Meta juga secara khusus mengembangkan dua versi SPIRIT LM:

"Edisi Dasar" (BASE): Versi ini terutama berfokus pada informasi fonem ujaran, yang merupakan "komposisi dasar" ujaran.

"Versi Ekspresif" (EKSPRESIF): Selain informasi fonem, versi ini juga menambahkan informasi nada dan gaya, yang dapat membuat suara AI lebih jelas dan ekspresif.

Jadi, bagaimana SPIRIT LM melakukan semua ini?

Sederhananya, SPIRIT LM dilatih berdasarkan LLAMA2, model teks besar super kuat yang sebelumnya dirilis oleh Meta. Para peneliti "memasukkan" sejumlah besar data teks dan ucapan ke LLAMA2 dan mengadopsi metode "pelatihan interleaved" khusus sehingga LLAMA2 dapat mempelajari aturan teks dan ucapan pada saat yang bersamaan.

Untuk menguji kemampuan "ekspresi emosional" SPIRIT LM, peneliti Meta juga merancang tolok ukur pengujian baru - "Tolok Ukur Pelestarian Sentimen Teks-Ucapan" (STSP). Tolok ukur pengujian ini berisi berbagai perintah ucapan dan teks yang mengekspresikan emosi berbeda untuk menguji apakah model AI dapat secara akurat mengenali dan menghasilkan ucapan dan teks dengan emosi yang sesuai. Hasilnya menunjukkan bahwa "versi ekspresi" SPIRIT LM berkinerja baik dalam retensi emosi dan saat ini merupakan model AI pertama yang dapat menyimpan informasi emosional di seluruh modalitas!

Tentu saja para peneliti Meta juga mengakui bahwa SPIRIT LM masih memiliki banyak area yang perlu ditingkatkan. Misalnya, SPIRIT LM saat ini hanya mendukung bahasa Inggris dan perlu diperluas ke bahasa lain di masa mendatang; skala model SPIRIT LM tidak cukup besar, sehingga perlu terus memperluas skala model dan meningkatkan kinerja model dalam bahasa Inggris. masa depan.

SPIRIT LM adalah terobosan besar Meta di bidang AI. Ini membuka pintu bagi kita menuju dunia AI yang "terdengar dan emosional". Saya yakin dalam waktu dekat, kita akan melihat lebih banyak aplikasi menarik yang dikembangkan berdasarkan SPIRIT LM, sehingga AI tidak hanya dapat berbicara dengan fasih, tetapi juga mengekspresikan emosi seperti orang sungguhan, dan berkomunikasi dengan kita secara lebih alami dan ramah!

Alamat proyek: https://speechbot.github.io/spiritlm/

Alamat makalah: https://arxiv.org/pdf/2402.05755

Secara keseluruhan, open source SPIRIT LM telah membawa kemajuan menarik di bidang AI multi-modal. Kemunculannya menandakan bahwa AI akan mencapai terobosan yang lebih besar dalam interaksi suara dan ekspresi emosional di masa depan perhatian pada bidang ini. Berita terbaru, harap pantau terus!