Editor Downcodes mengetahui bahwa Allen Institute for Artificial Intelligence (Ai2) baru-baru ini merilis Molmo, rangkaian model AI multi-modal open source baru, yang kinerjanya luar biasa, bahkan melampaui GPT-4o dan Anthropic OpenAI dalam beberapa pengujian benchmark pihak ketiga. .Claude3.5Sonnet dan Google Gemini1.5. Molmo tidak hanya menganalisis gambar yang diunggah pengguna, Molmo juga menggunakan data 1.000 kali lebih sedikit selama pelatihan dibandingkan pesaingnya, berkat teknik pelatihannya yang unik. Terobosan ini menunjukkan komitmen Ai2 terhadap penelitian terbuka, membuat model berkinerja tinggi, bobot terbuka, dan data tersedia bagi komunitas dan perusahaan yang lebih luas.

Molmo tidak hanya menerima gambar yang diunggah pengguna untuk dianalisis, tetapi juga menggunakan “data 1.000 kali lebih sedikit dibandingkan pesaing” untuk pelatihan, berkat teknik pelatihannya yang unik.

Rilis ini menunjukkan komitmen Ai2 terhadap penelitian terbuka, menyediakan model berkinerja tinggi dengan bobot terbuka dan data untuk digunakan oleh komunitas dan perusahaan yang lebih luas. Keluarga Molmo mencakup empat model utama, yaitu Molmo-72B, Molmo-7B-D, Molmo-7B-O, dan MolmoE-1B adalah model andalan, yang berisi 7,2 miliar parameter, dan kinerjanya sangat luar biasa.

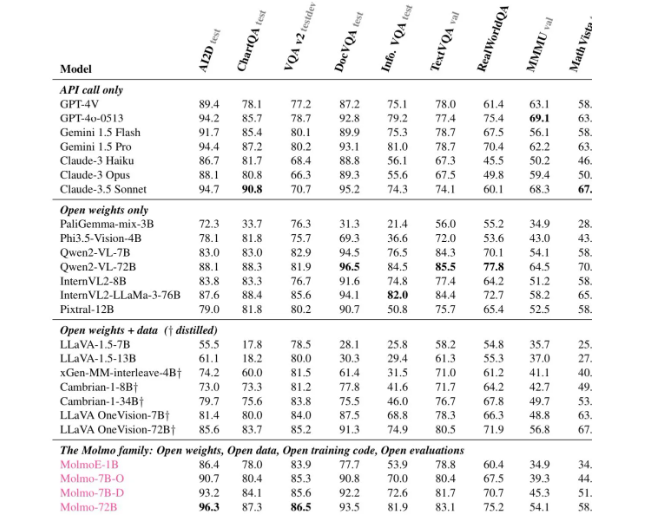

Menurut berbagai evaluasi, Molmo-72B menerima skor tertinggi pada 11 tolok ukur penting dan menduduki peringkat kedua setelah -4o dalam hal preferensi pengguna. Ai2 juga meluncurkan model OLMoE, menggunakan pendekatan "kombinasi model kecil" untuk meningkatkan efektivitas biaya.

Arsitektur Molmo telah dirancang dengan cermat untuk efisiensi dan kinerja yang unggul. Semua model menggunakan model CLIP ViT-L/14336px OpenAI sebagai encoder visual untuk memproses gambar multiskala menjadi perintah visual. Bagian model bahasanya adalah decoder Transformer yang memiliki kapasitas dan keterbukaan berbeda-beda.

Dalam hal pelatihan, Mol menjalani dua tahap pelatihan: pertama, pra-pelatihan multi-model, dan kedua, penyesuaian yang diawasi. Tidak seperti banyak model modern, Molmo tidak mengandalkan pembelajaran penguatan dengan umpan balik manusia, melainkan memperbarui parameter model melalui proses pelatihan yang disesuaikan dengan cermat.

Molmo berkinerja baik dalam berbagai tolok ukur, terutama dalam tugas-tugas kompleks seperti membaca dokumen dan penalaran visual, yang menunjukkan kemampuannya yang kuat. Ai2 telah merilis model dan kumpulan data ini di Hugging Face, dan akan meluncurkan lebih banyak model dan laporan teknis yang diperluas dalam beberapa bulan mendatang untuk menyediakan lebih banyak sumber daya bagi para peneliti.

Jika Anda ingin mengetahui kemampuan Molmo, demonstrasi publik kini tersedia melalui situs resmi Molmo (https://molmo.allenai.org/).

Menyorot:

Model AI modal sumber terbuka Ai2Molmo melampaui produk-produk unggulan industri.

? Mol-72B berkinerja baik di berbagai benchmark, nomor dua setelah GPT4o.

Ini sangat terbuka, dan model serta kumpulan data dapat digunakan secara bebas oleh para peneliti.

Secara keseluruhan, kemunculan Molmo menandai kemajuan besar di bidang AI multi-modal, dan sifat open source-nya juga menyediakan sumber daya berharga bagi para peneliti di seluruh dunia. Editor Downcodes berharap Molmo akan lebih banyak digunakan dan dikembangkan di masa depan serta mendorong kemajuan teknologi AI yang berkelanjutan.