Baru-baru ini, editor Downcodes memperhatikan berita yang mengkhawatirkan: alat transkripsi AI yang banyak digunakan di industri medis, berdasarkan teknologi Whisper OpenAI, ditemukan mengalami "halusinasi" dan mungkin menghasilkan konten palsu. Hal ini memicu kekhawatiran terhadap keamanan dan keandalan teknologi AI di bidang medis. Artikel ini akan menganalisis insiden ini secara mendetail, mengeksplorasi potensi risikonya, dan respons OpenAI.

Baru-baru ini, alat transkripsi AI yang didukung oleh teknologi Whisper OpenAI telah mendapatkan popularitas di industri medis. Banyak dokter dan organisasi layanan kesehatan menggunakan alat ini untuk mencatat dan merangkum pertemuan pasien.

Menurut laporan ABC News, para peneliti menemukan bahwa alat ini dapat menyebabkan "halusinasi" dalam beberapa kasus, dan terkadang bahkan sepenuhnya mengarang konten.

Alat transkripsi yang dikembangkan oleh perusahaan bernama Nabla ini telah berhasil mentranskripsikan lebih dari 7 juta percakapan medis dan saat ini digunakan oleh lebih dari 30.000 dokter dan 40 sistem kesehatan. Namun, Nabla menyadari potensi Whisper berhalusinasi dan mengatakan pihaknya berupaya mengatasi masalah tersebut.

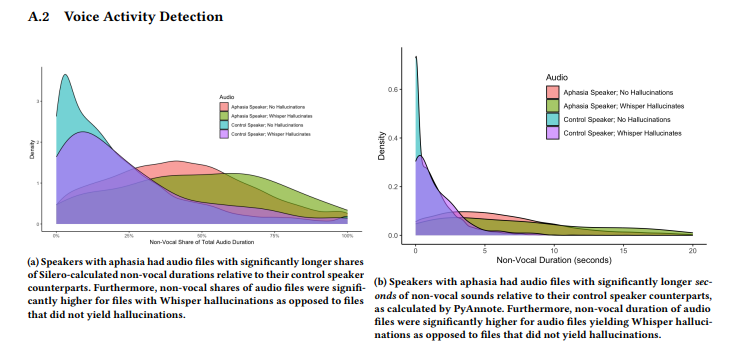

Sebuah studi yang dilakukan oleh tim peneliti dari Cornell University, University of Washington, dan lainnya menemukan bahwa Whisper berhalusinasi pada sekitar 1% transkripsinya. Dalam kasus ini, alat tersebut secara acak menghasilkan frasa yang tidak bermakna selama periode hening dalam rekaman, terkadang mengungkapkan emosi kekerasan. Para peneliti mengumpulkan sampel audio dari AphasiaBank TalkBank dan mencatat bahwa keheningan sangat umum terjadi ketika orang dengan gangguan bicara berbicara.

Peneliti Cornell University, Allison Koenecke, membagikan beberapa contoh di media sosial yang menunjukkan konten halusinasi yang dihasilkan oleh Whisper. Para peneliti menemukan bahwa konten yang dihasilkan oleh alat tersebut juga menyertakan istilah medis yang dibuat-buat dan bahkan frasa seperti "Terima kasih telah menonton!" yang terdengar seperti kata-kata dari video YouTube.

Penelitian ini dipresentasikan pada konferensi FAccT Asosiasi Mesin Komputasi di Brasil pada bulan Juni, namun tidak jelas apakah penelitian tersebut telah melalui tinjauan sejawat. Mengenai masalah ini, juru bicara OpenAI Taya Christianson mengatakan dalam wawancara dengan "The Verge" bahwa mereka menangani masalah ini dengan sangat serius dan akan terus bekerja keras untuk memperbaikinya, terutama dalam mengurangi halusinasi. Pada saat yang sama, dia menyebutkan bahwa saat menggunakan Whisper di platform API mereka, terdapat kebijakan penggunaan yang jelas yang melarang penggunaan alat tersebut di lingkungan pengambilan keputusan tertentu yang berisiko tinggi.

Menyorot:

Alat transkripsi bisikan banyak digunakan dalam industri medis dan telah mencatat 7 juta percakapan medis.

⚠️ Penelitian menemukan bahwa Whisper "berhalusinasi" di sekitar 1% transkripsi, terkadang menghasilkan konten yang tidak berarti.

OpenAI mengatakan pihaknya berupaya meningkatkan kinerja alat, khususnya dalam mengurangi halusinasi.

Secara keseluruhan, teknologi AI memiliki prospek yang luas untuk diterapkan di bidang medis, namun juga menghadapi banyak tantangan. Munculnya fenomena “halusinasi” Whisper mengingatkan kita bahwa kita perlu memperlakukan teknologi AI dengan hati-hati dan memperkuat pengawasan terhadap keamanan dan keandalannya untuk memastikan penerapannya yang aman dan efektif di bidang medis serta melindungi hak dan keselamatan pasien. Redaksi Downcodes akan terus memperhatikan perkembangan selanjutnya dari kejadian ini.